扇贝(Pectinidae)是一种软体动物,属于珍珠贝目海扇蛤科,其分布在世界各大洋,在中国南北沿海均有分布。目前,中国沿海已发现了50多种扇贝,包括巨扇贝、栉孔扇贝、海湾扇贝、虾夷扇贝和华贵栉孔扇贝等。扇贝肉味道鲜美,营养丰富,截至2022年,中国的扇贝养殖面积达到38.9万hm2,扇贝养殖产量为179.2万t[1-3]。随着海洋养殖业的快速发展,扇贝作为一种重要的经济海洋生物,其养殖和加工环节的效率与质量控制愈发受到重视。扇贝在上市过程中,尤其是在运输及存储阶段,容易受到各种外力和环境因素的影响,从而导致破损,这不仅影响了扇贝的市场价值,也造成了资源的浪费。因此,在其加工开始前利用深度学习算法对破损的扇贝进行检测识别可为智能化扇贝加工的开发提供一定技术支持[4]。

传统缺陷检测方法一般依赖于人工手动检测,检测速度慢、劳动强度大、成本高,且无法保证一致性。基于机器视觉的缺陷检测方法依靠机器视觉系统进行无接触式自动检测,能够克服绝大多数传统人工缺陷检测的弊端[5]。近年来,深度学习特别是目标检测技术的发展,为解决此类问题提供了新的思路,其中,YOLO(you only look once)系列模型因其高效的实时检测能力,已广泛应用于各种图像识别任务。梁晓婷[6]以YOLOv4模型为基础,提出一种模型剪枝方法和一种基于BiSeNet V2语义分割网络的苹果表面缺陷分割方法,实现了苹果表面缺陷实时检测分级。叶建华等[7]提出基于改进MobileNet的咖啡豆缺陷检测方法,解决了现有咖啡豆缺陷检测方法鲁棒性、实时性不高的问题。贾惠等[8]针对柑橘缺陷数据集较少的问题,提出了一种使用数据增强和迁移学习来对小样本柑橘的缺陷类型进行检测的方法,有效地提升了小样本柑橘缺陷检测模型的准确性。孙志坚等[9]针对机收甜菜破损率不精确的问题,提出一种基于YOLOv4的机收甜菜破损检测方法,精确率可达96.68%。而在海产品加工领域,目前对于深度学习目标检测方法的应用还较少。针对捕捞鲜对虾中存在破损虾及贝类等杂质的问题,付凯月等[10]将YOLO网络应用于自主研发的海产品智能分拣装备中,且起到了显著效果。越来越多的研究表明,生产中建立一种基于图像识别、人工智能等技术的海产品智能加工流水线已成为必然趋势[11-13]。

本研究中针对扇贝加工前的缺陷检测阶段,以海湾扇贝和栉孔扇贝为试验对象,构建了一个包含完好扇贝、破裂扇贝、壳体缺失扇贝的扇贝图像数据集,并在YOLOv8模型的基础上提出一种基于改进YOLOv8的扇贝破损检测模型,首先使用FasterNet网络替换主干网络,其次使用C2f_Faster模块替代neck部分的C2f模块,随后在网络关键部位引入BiFormer注意力机制,最后采用Inner-IoU损失函数替换原有损失函数。

1 数据集构建与模型基础

1.1 数据集来源

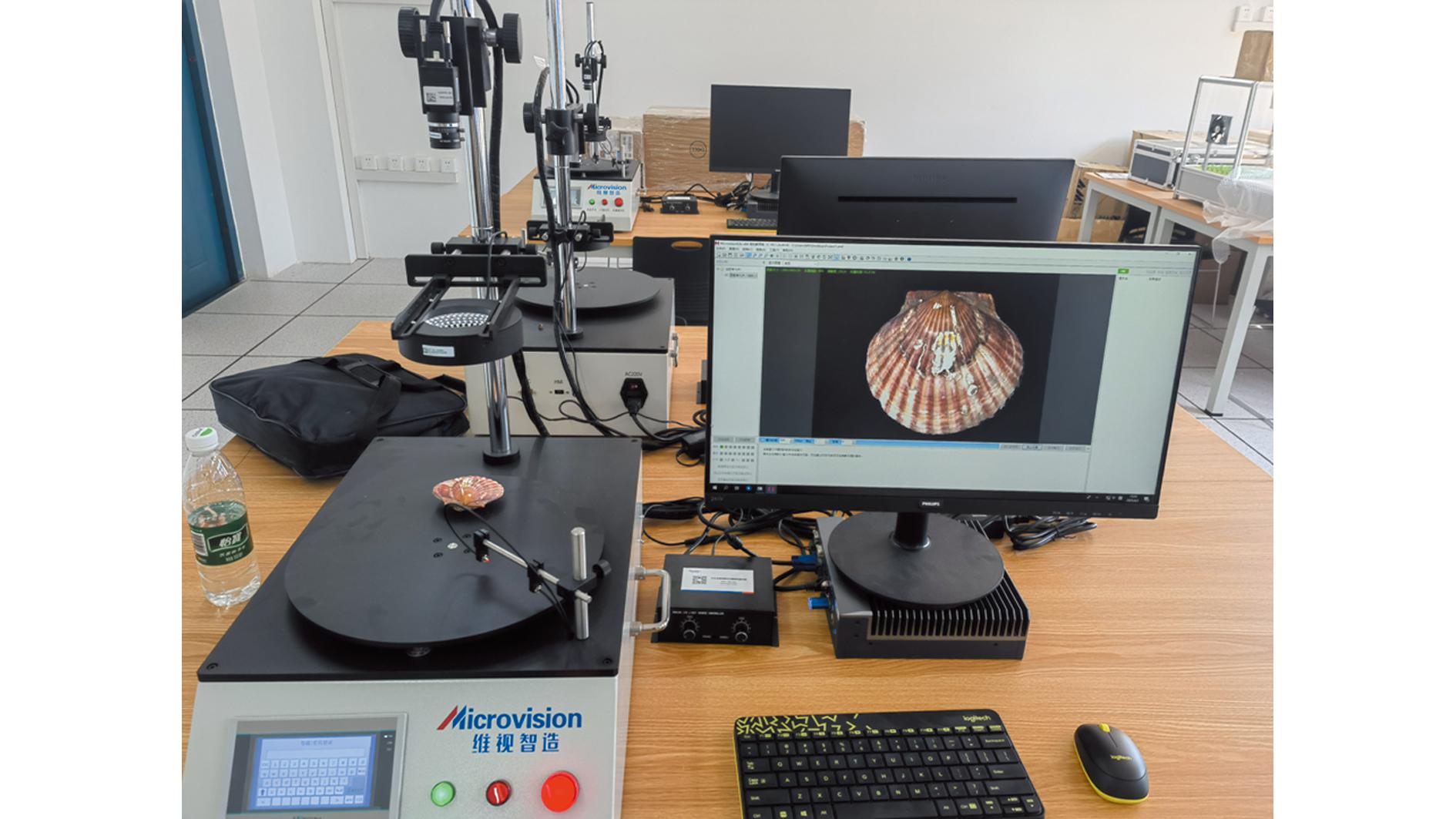

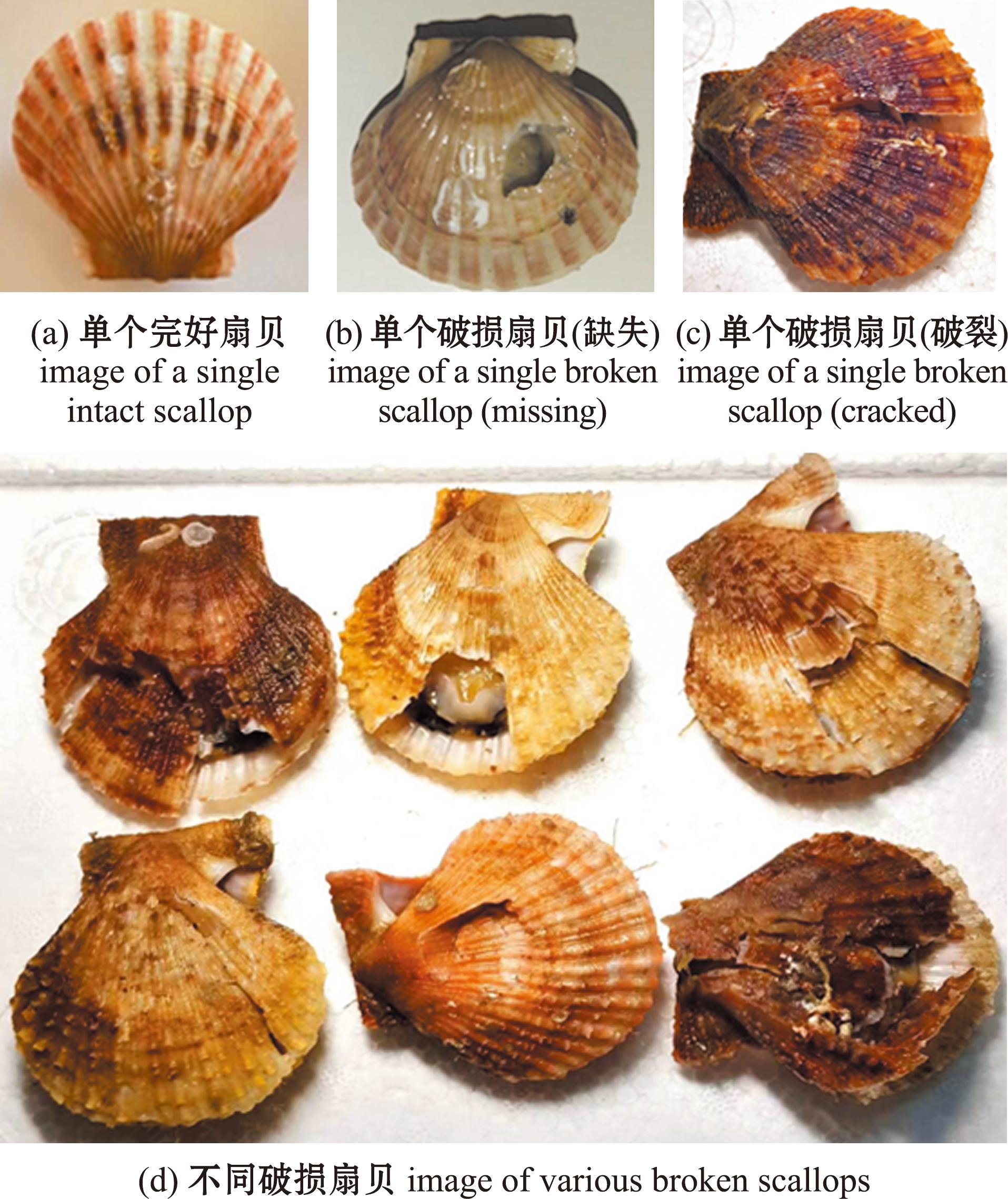

扇贝在进行加工前可能产生的破损情况主要为两种,分别为壳体缺失和壳体破裂,本研究中构建了一个包括完好扇贝、破裂扇贝、壳体缺失扇贝的扇贝图像数据集,数据集采集自本地市场所购买的扇贝,扇贝所有的破损由人为模拟试验取得。采集设备为维视智造机器视觉应用试验平台,工业相机型号为MV-HP120GC(图1)。共采集524张原始图片,均为JPG格式。在所采集的扇贝图片中,包括不同背景、不同角度、不同光照、多个目标情况的图片(图2)。

图1 维视智造机器视觉应用试验平台

Fig.1 The experimental platform with Weishi intelligent manufacturing machine vision application

图2 扇贝数据集示例

Fig.2 Examples of scallop dataset

1.2 数据预处理

在采集扇贝图像时,图像质量会受到光照、对焦等影响,为使模型在训练过程中能够减少此类影响,本研究中采用数据增强方式,以增强模型的泛化能力,防止过拟合。在对图片进行随机平移、等比缩放、水平垂直翻转、增加噪声、随机对比度增强、随机高斯模糊、随机颜色增强等数据增强手段后得到2 096张图片,使用Labelimg工具进行标注,每幅图像会生成一个txt文件,其中包含目标类别信息和位置信息。扩充好的数据集按照7∶2∶1的比例划分,得到训练集1 469张图片、验证集418张图片、测试集209张图片。

1.3 YOLOv8模型

YOLOv8算法由Glenn-Jocher提出,其主要网络结构由输入端(input)、主干网络(backbone)、颈部网络(neck)和检测(head)部分构成[14]。主干网络主要由C2f和SPPF两个模块组成,C2f模块是将YOLOv5[15]的C3结构与YOLOv7[16]的ELAN架构结合起来,这样既能得到更多的梯度流动信息,又能实现更高的测量精度,同时还兼具轻量化的特点。SPPF模块被放置在主干网络的最末端,它依次传递3个大小为5×5的maxpool,然后将每一层进行串联,这样不仅能保证这一层的轻量化,又能在检测不同尺度的物体时保证精度。在neck部分,YOLOv8依然是基于FPN-PAN的结构来实现特征的融合,能够在多个尺度上实现特征信息的融合与利用。在head部分使用解耦头结构(decoupled-head),它能将分类任务与检测任务区分开来;同时舍弃了锚框这一结构,替换为Anchor-Free结构,无需再考虑对锚框超参数的调整,有效降低了算法的复杂程度。最后,模型损失(loss)的计算分成了两个部分,分别为分类和回归,其中分类部分使用BCE Loss,回归部分使用Distribution Focal Loss和CIOU损失函数。

2 YOLOv8-FFB模型

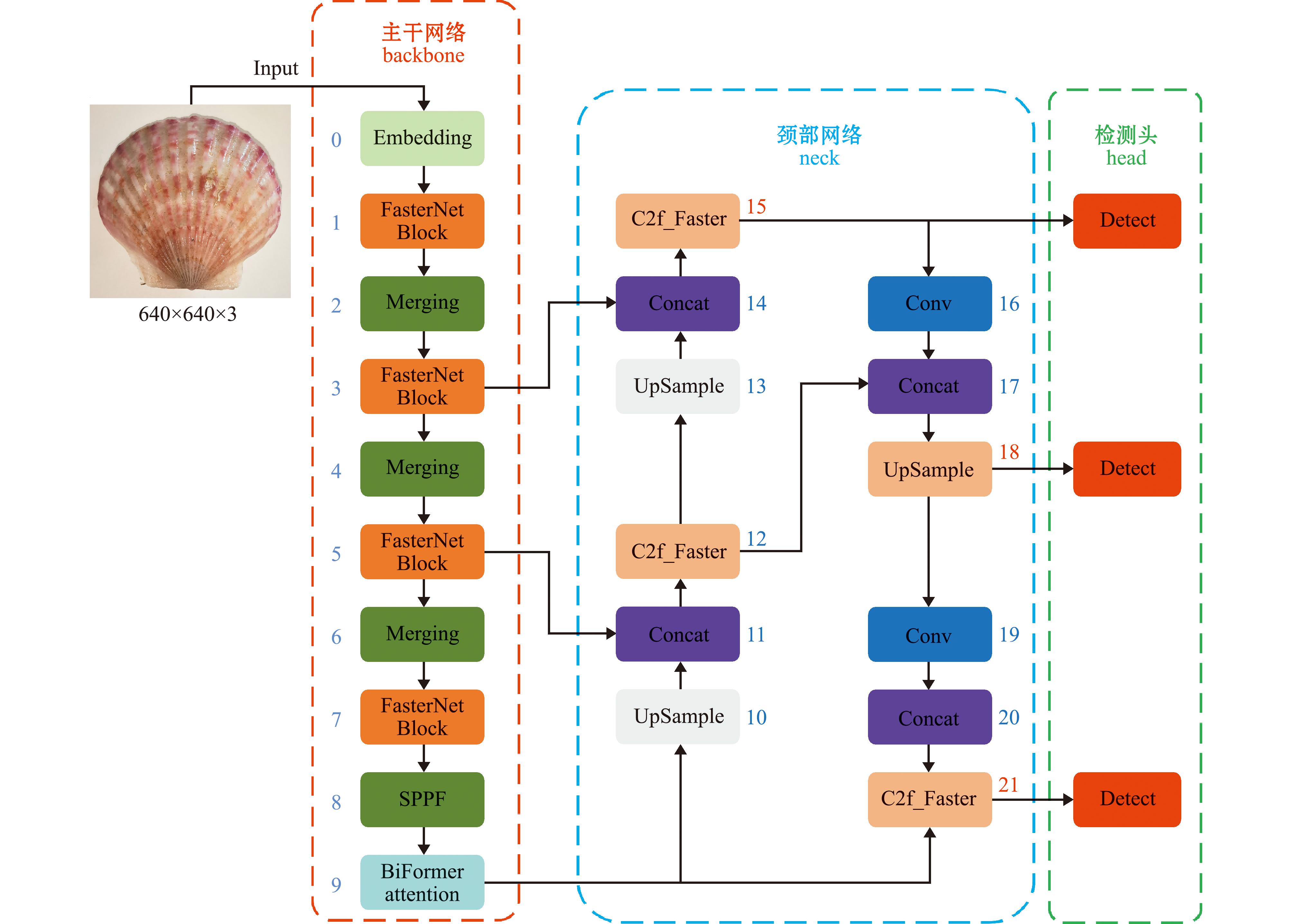

现有的基于深度学习的卷积神经网络虽然具有较高的检测精度,但其计算复杂度较高、模型体积较大,且检测速度较慢。为了提升模型检测速度、降低模型体积、减少参数量,本研究在YOLOv8主干网络中引入了FasterNet轻量化网络结构,同时使用FasterNet中的FasterNet Block替换了C2f中的Bottleneck结构,得到C2f_Faster模块,进一步减少了模型的参数量,提升了检测速度。其次在主干网络末端引入BiFormer注意力机制,有效减少了计算量和内存占用量,并将CIoU损失函数替换为Inner-IoU损失函数,用于提高模型的检测精度。改进后的YOLOv8模型命名为YOLOv8-FFB,模型结构如图3所示。

图3 YOLOv8-FFB网络结构图

Fig.3 Structural diagram of YOLOv8-FFB network

2.1 FasterNet网络

针对在扇贝破损检测任务中因参数量较大导致的速度低下问题,本研究中引入FasterNet网络替换原网络的主干结构,较好地解决了早期推出的主干网络MobileNet[17]、ShuffleNet[18]和GhostNet[19]等利用深度卷积(DWConv)和组卷积(GConv)提取空间特征时算子受到内存访问增加的副作用影响。

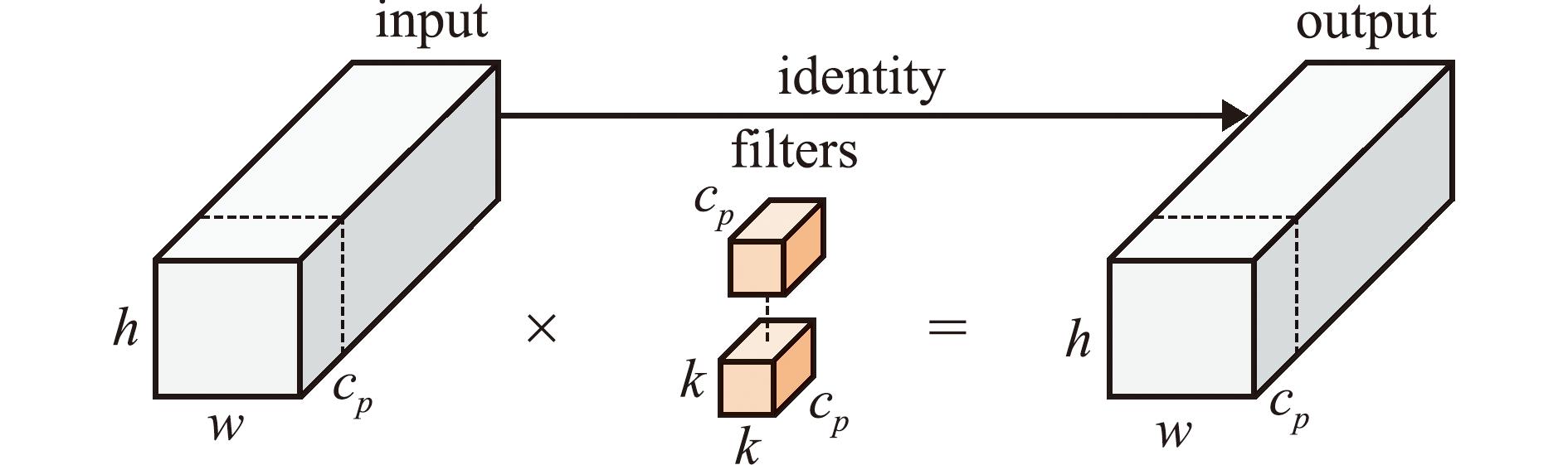

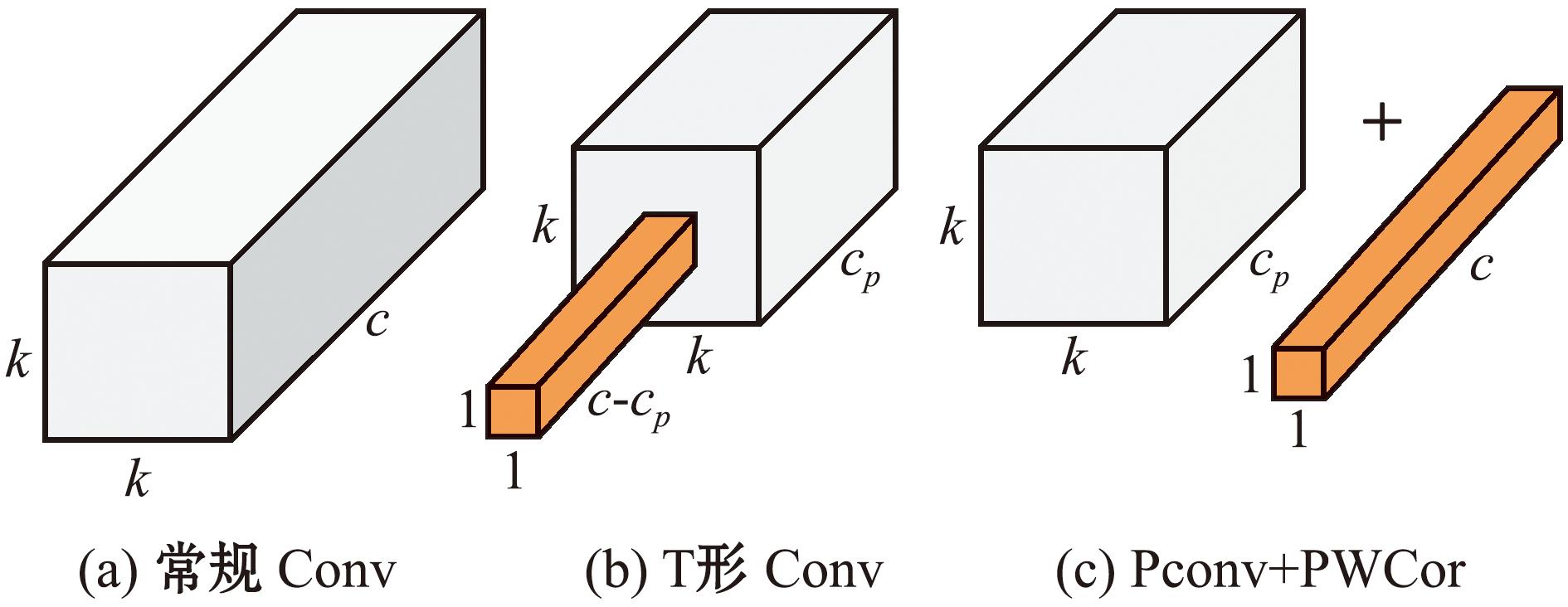

在FasterNet网络中,提出了一种新型的轻便部分卷积PConv(partial convolution)[20],可以有效地降低计算冗余和内存访问,其结构如图4所示。

图4 PConv结构图

Fig.4 Structural diagram of PConv

PConv只需在输入通道的一部分上应用常规卷积进行空间特征提取,并保持其余通道大小不变。对于连续后者规则的内存访问,将第一个或最后一个连续的通道视为整个特征图的代表进行计算,在不丧失一般性的情况下认为输入和输出特征图具有相同数量的通道。其计算量为

式中:h表示通道的高度;w表示通道的宽度;cp表示连续的网络通道数量;k表示卷积核尺度。

当进行卷积操作的通道数为1/4时,PConv的计算量只有常规卷积的1/16。此外Pconv的内存访问量较小,即

当进行卷积操作的通道数为1/4时,其内存访问仅为常规卷积的1/4。

FasterNet模型以部分卷积(PConv)和逐点卷积(PWConv)作为主要算子。将PWConv与PConv组合在一起,使得输入特征图上的有效感受野看起来像一个更专注于中心位置的T形Conv,T形Conv的FLOPs可以计算为

FOLPs=h×w×[k2×cp×c+c×(c-cp)]。

(3)

与PConv和PWConv相比,T形Conv多出的FLOPs可以计算为

式中:c表示通道的长度。

若将T形Conv拆分为PConv和PWConv,那么,就可以利用滤波器的冗余,从而更好地节省FLOPS。常规Conv、T形Conv和PConv+PWConv间的结构对比,如图5所示。

图5 Conv、T形Conv和PConv+PWConv结构对比

Fig.5 Structural comparison among Conv,T-shaped Conv and PConv+PWConv

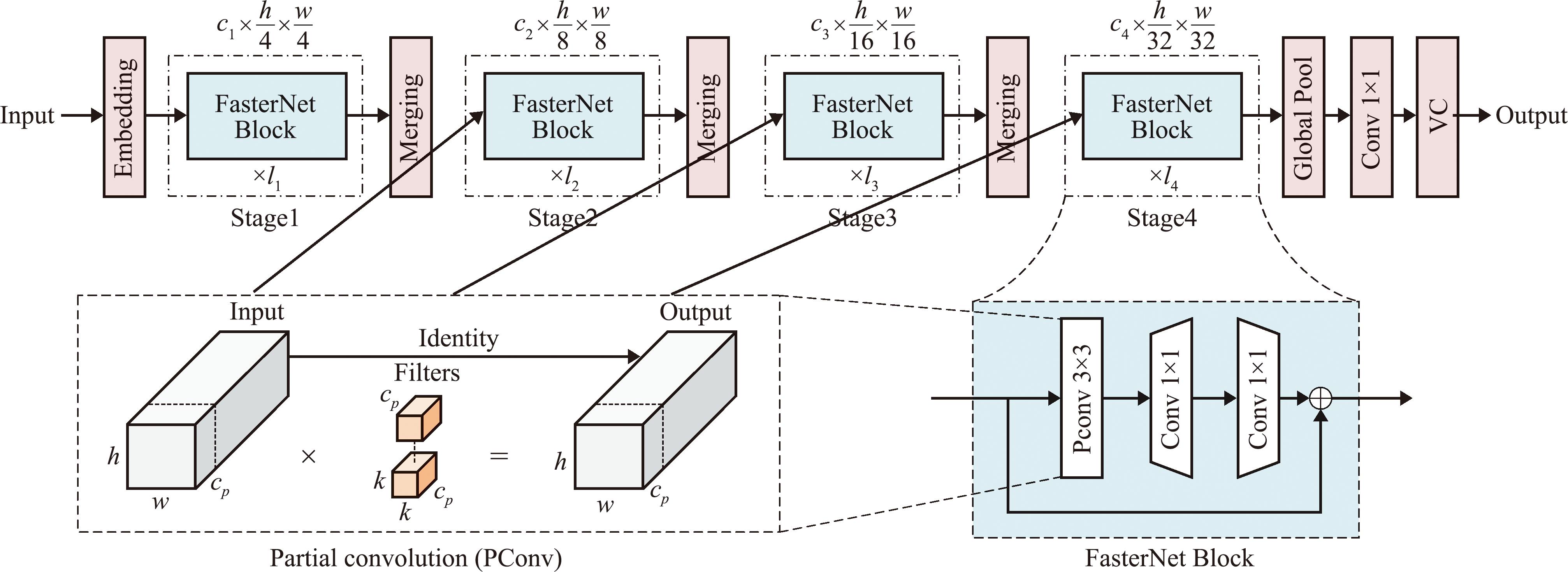

FasterNet模型架构主要由4个层次的阶段组成(图6)。每个阶段前面都有一组FasterNet模块,在第一个FasterNet模块前有一个步长为4、卷积为4×4的嵌入层,在第二、三、四个FasterNet模块前均有一个步长为2、卷积为2×2的合并层。每个FasterNet模块结构内部设计为一个PConv层后面跟两个尺寸为1×1的逐点卷积层(PWConv)或1×1的Conv,因此PConv+PWConv×2显示为倒置残差块,如图6中FasterNet Block部分所示。为了实现更低延迟的同时保留更多的特征多样性,在中间层具有扩展的通道嵌入标准化和激活层。

图6 FasterNet模型结构

Fig.6 Structural diagram of FasterNet model

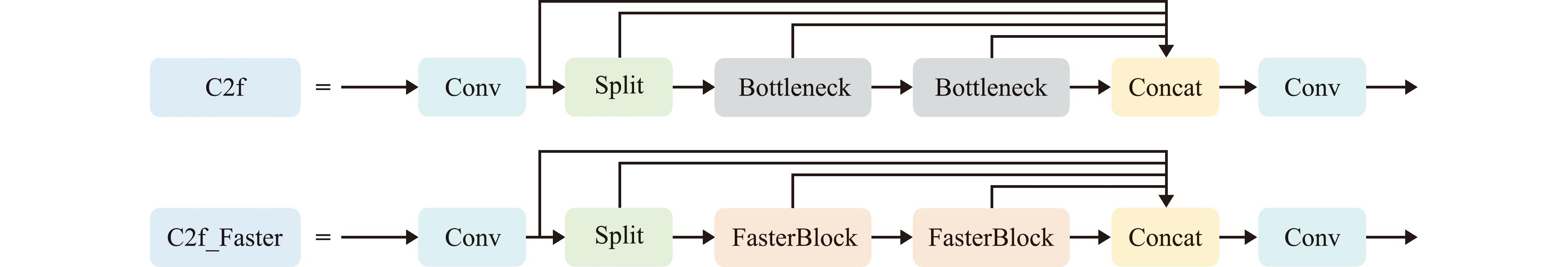

同时使用FasterNet中的FasterNet Block[21]替换了C2f中的Bottleneck结构,得到C2f_Faster模块,进一步减少了模型的参数量,提升了计算速度。C2f_Faster和C2f的结构对比,如图7所示。

图7 C2f_Faster和C2f的结构对比

Fig.7 Structural comparison between C2f_faster and C2f

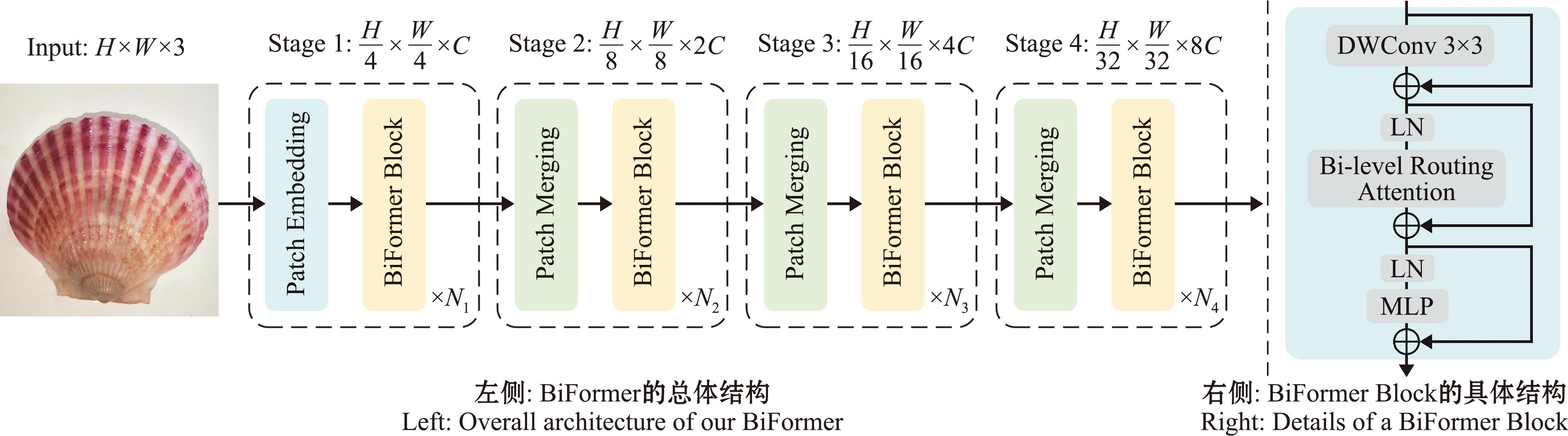

2.2 BiFormer注意力机制

视觉转换器(Transformer)[22]通过引入自注意力机制和位置编码层,有效解决了传统顺序模型如循环神经网络(recurrent neural network,RNN)等在捕获远程依赖性和实现并行计算方面存在的局限性,且在处理长序列时表现出色,提高了模型的训练和推理效率,但该模型也存在计算量大和内存占用量大的问题。

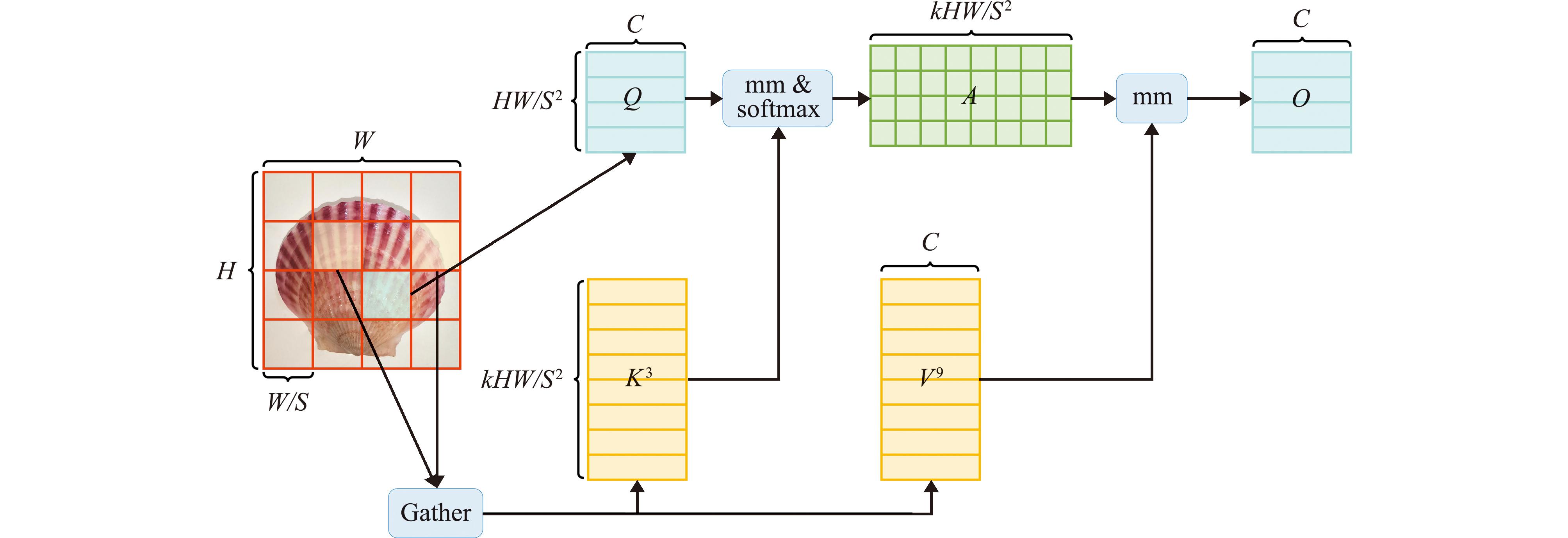

双层路由注意力(Bi-level routing attention,BRA)通过双层路提出了一种新颖的动态稀疏注意力(dynamic sparse attention),以实现更灵活的计算分配和内容感知,使其具备动态的查询感知稀疏性,如图8所示。

图8 双层路由注意力示意图

Fig.8 Bi-Level routing attention diagram

基于BRA模块,本研究提出一种新颖的视觉转换器(Transformer)BiFormer[23],如图9所示,该模块采用常规的四级金字塔结构,BiFormer在第一阶段使用重叠块嵌入,在第二到第四阶段使用patch合并模块降低输入空间分辨率,同时增加通道数,然后采用连续的BiFormer块进行特征变换。需要注意的是,在每个区块的开始均使用深度卷积来隐式编码相对位置信息。随后依次应用BRA模块和多层感知机(multi-layer perceptron,MLP)模块,分别用于交叉位置关系建模和每个位置嵌入。

图9 BiFormer示意图

Fig.9 BiFormer diagram

2.3 Inner-IoU损失函数

IoU损失函数在计算机视觉任务中有广泛的应用。在边界框回归过程中,不仅可以评估回归状态,还可以通过计算回归损失来加速收敛。但它无法根据当前的检测器与检测任务进行自我调整,不具有很强的泛化性。所以,在此扇贝破损检测任务中,引入了Inner-IoU Loss[24]来替换CIoU,其通过辅助边框计算IoU损失。针对不同的数据集与检测器,引入尺度因子ratio控制辅助边框的尺度大小用于计算损失,较好地克服了现有方法在泛化能力方面的局限。计算公式为

inter=![]()

![]()

(9)

union=(wgt×hgt)×(ration)2+(w×h)×(ration)2-inter,

(10)

IoUinner=inter/union。

(11)

式中:![]() 表示真实(GT)框和Inner真实(GT)框的中心点;(xc,yc)表示辅助边界框和Inner辅助边界框的中心点;(wgt,hgt)表示真实(GT)框宽度和高度;(w,h)表示辅助边界框的宽度和高度;ratio表示尺度因子,其取值范围一般在[0.5,1.5]内。

表示真实(GT)框和Inner真实(GT)框的中心点;(xc,yc)表示辅助边界框和Inner辅助边界框的中心点;(wgt,hgt)表示真实(GT)框宽度和高度;(w,h)表示辅助边界框的宽度和高度;ratio表示尺度因子,其取值范围一般在[0.5,1.5]内。

3 结果与分析

3.1 模型训练与测试

3.1.1 试验平台 本试验平台所用操作系统为64位Windows 11,CPU型号为12th Gen Intel(R) Core(TM) i7-12650H 2.30 GHz,GPU型号为NVIDIA GeForce RTX 4060 Laptop GPU。编程语言为Python3.8,深度学习框架为Pytorch 2.1.0及CUDA 11.8。本研究中使用YOLOv8作为基准模型,并在该模型基础上进行改进。

3.1.2 模型训练 在本研究中,在模型训练时,图像分辨率统一转换成640×640。优化器(Optimizer)为SGD,批量(Batch-Size)设置为16。训练轮次epoch为100轮,神经网络的初始学习率为0.01。

3.1.3 模型评估指标 本次试验的模型评估指标采用精确度(precision,P)、召回率(recall,R)、平均准确率(mean average precision,mAP)和速度(FPS)。模型指标采用模型参数量(params),模型推理浮点数(GFLOPs)。相关公式为

P=TP/(TP+FP),

(12)

R=TP/(TP+FN),

(13)

FPS=1 000/t。

(15)

式中:TP表示预测为目标实际上也是正确目标的个数;FP表示预测为目标实际上不是正确目标的个数;FN表示预测不是目标实际上是目标的个数;AP表示每种检测类型的准确性;mAP表示所有类别中AP指的均值;n表示类别数。

3.2 模型可行性试验结果

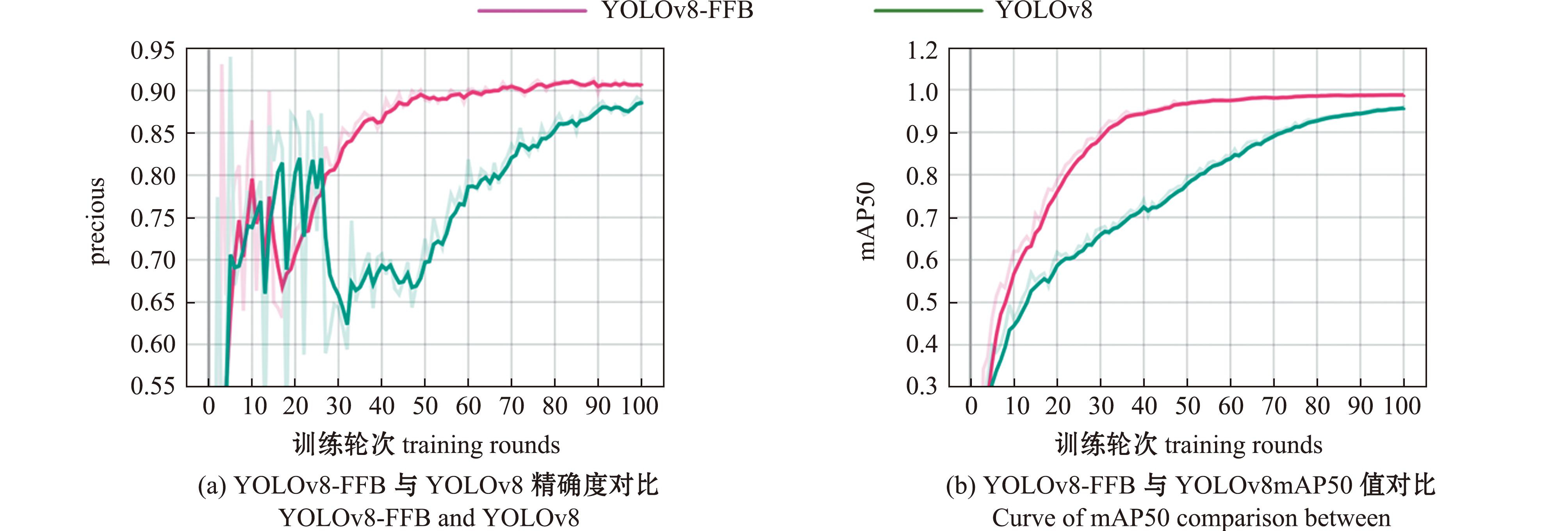

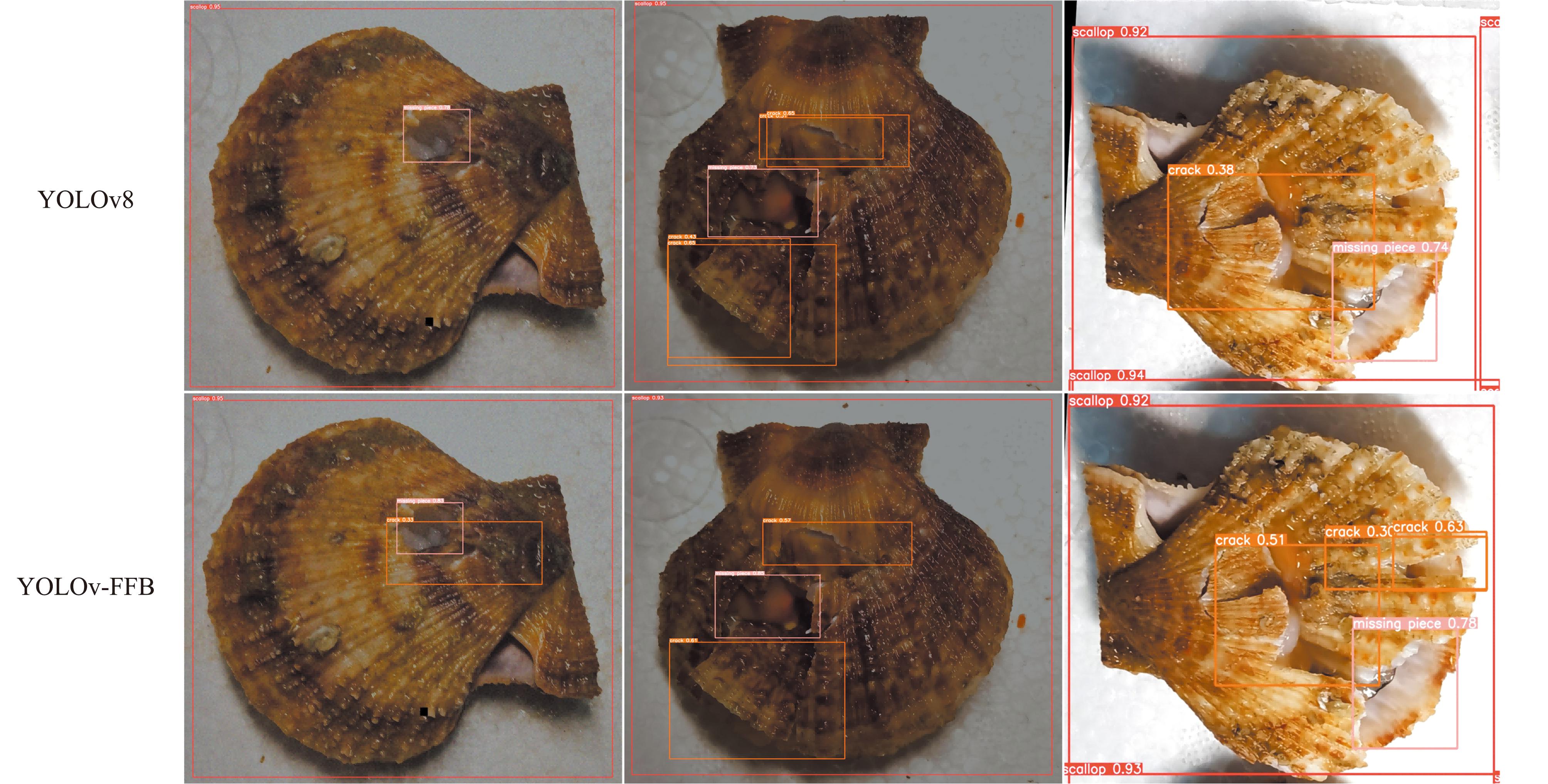

改进后的模型与原YOLOv8模型的精确度和mAP50值对比如图10所示,在针对扇贝破损检测任务中,改进后的模型有效地缓解了漏检、重复标注的问题(图11),可见改进后的模型比原模型性能更加优越。

图10 精确度对比图

Fig.10 Accuracy comparison chart

图11 YOLOv8与YOLOv8-FFB检测效果比较

Fig.11 Comparison of detection effect of YOLOv8 and YOLOV8-FFB

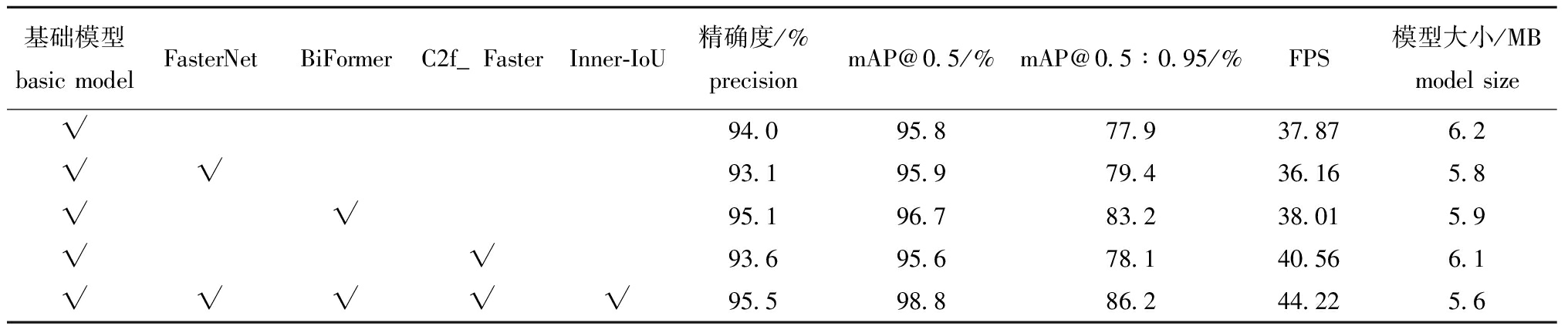

3.3 消融试验

为了更直观地显示FasterNet主干网络、C2f_Faster模块、BiFormer注意力机制、Inner-IoU损失函数对YOLOv8模型的不同影响,进行消融试验来分析对比,在相同的试验环境下进行训练,消融试验结果见表1。从表1可见,将主干网络替换为FasterNet之后,精确度和FPS相较于原模型分别下降了0.9%和1.71 帧/s,只有平均准确率有所提升。只加入注意力机制对扇贝破损检测的精确度和平均准确率增加了1.1%和0.9%,而FPS几乎无变化。将C2f模块替换为C2f_Faster模块后精确度和平均准确率均有所下降,FPS提升了2.69 帧/s。改进后的YOLOv8-FFB网络模型在精确度、平均准确率和FPS上均有显著提升,分别增加了1.1%、3%和6.35 帧/s。基本满足了目标检测算法准确快速识别扇贝破损的需求。

表1 YOLOv8模型消融试验结果

Tab.1 Results of the ablation test in YOLOv8

基础模型basic modelFasterNetBiFormerC2f_FasterInner-IoU精确度/%precisionmAP@0.5/%mAP@0.5∶0.95/%FPS模型大小/MBmodel size√94.095.877.937.876.2√√93.195.979.436.165.8√√95.196.783.238.015.9√√93.695.678.140.566.1√√√√√95.598.886.244.225.6

3.4 改进模型与其他模型性能对比试验

为验证改进算法YOLOv8-FFB在扇贝破损检测中的优势,在相同试验环境下将其与YOLOv3-tiny[25]、YOLOv5n、YOLOv6n[26]、YOLOv8n、YOLOv8s等检测模型进行评估,试验结果见表2。

表2 本文提出模型与其他模型对比

Tab.2 Comparison between the proposed model and other models

模型model精确度/%precision召回率/%recallmAP@0.5/%mAP@0.5∶0.95/%参数量parametersFPS(帧/s)模型大小/MBmodel sizeYOLOv8n94.093.195.877.93 006 23337.876.2YOLOv8s94.297.297.983.411 126 74518.1821.9YOLOv3-tiny90.888.391.568.212 133 67029.6720.1YOLOv5n93.993.896.379.22 503 52938.465.3YOLOv6n92.592.094.575.64 234 04134.608.7YOLOv8-FFB95.597.798.886.22 503 27544.225.6

从表2可见,改进算法YOLOv8-FFB的精确度、召回率、mAP@0.5、mAP@0.5∶0.95在扇贝破损检测任务中分别为95.5%、97.7%、98.8%、86.2%,显著优于YOLOv3-tiny、YOLOv5n、YOLOv6n、YOLOv8n和YOLOv8s等目标检测算法,只在模型大小方面略差于YOLOv5n模型。YOLOv8-FFB训练过程中的参数量为2 503 275个,与YOLOv3-tiny、YOLOv5n、YOLOv6n、YOLOv8s、YOLOv8n相比,在拥有更快训练速度同时减少了计算资源和内存占用。与以上模型相比,改进算法模型大小为5.6 MB,FPS为44.22 帧/s,拥有更高的推理速度,能在更短时间内完成检测任务,运行更加高效。

4 讨论

4.1 网络轻量化对模型检测性能的影响

网络轻量化是当今研究热点之一,其目的是减少模型的参数量和计算复杂度,同时尽可能保持或提升模型的检测性能。王卓等[27]针对苹果的实时监测任务,在YOLOv4模型基础上,将MobileNet v3作为主干网络,提出了一种轻量级苹果实时检测模型YOLOv4-CA,YOLO v4-CA模型的平均精度均值达到了92.23%,且在嵌入式平台上的检测速度为15.11 帧/s,约为YOLO v4模型的3倍。曹宇等[28]针对复杂水下环境的鱼类识别问题,在YOLOv8n模型基础上,采用轻量级双卷积模块 C2f-DualConv替换YOLOv8n 中 C2f 模块,提出了一种水下鱼类目标识别轻量化模型YOLOv8n-C2f-Dual,其在模型平均精度有所上升的同时,模型的参数量、浮点运算量和模型内存占用量大幅下降。本研究中,以YOLOv8为基础框架,采用FasterNet网络替代YOLOv8的主干网络。结果表明,采用FasterNet网络后的模型,在少量损失模型检测精度的情况下,模型参数量和计算复杂度均有所下降,检测速度有所提升。

4.2 引入注意力机制对模型检测性能的影响

引入注意力机制显著提升了深度学习模型的特征表达能力,从而增强了其在目标检测任务中的性能。通过对关键信息的有效关注,注意力机制不仅提高了模型对复杂场景的理解力,还增强了其抗干扰能力,常用的注意力机制有SE、CA、CBAM等。王德雨等[29]针对经济鱼类的识别任务,在ResNet50模型基础上,引入CBAM注意力机制,提出一种经济鱼类识别模型ResNet50-CBAM,模型在鱼类验证集对比目鱼、鲻、海鲈和金枪鱼的分类精准率均达到了100%,对马鲛的精准率为98.4%,对黑鲷的精准率为98.3%。韦洁瑶等[30]针对路面裂缝图像识别任务,在ResNet的基础上,将Extemal Attention、SE Attention、CBAM 3种注意力机制集成到网络中,通过训练比对,选定SE模块引入ResNet模型得到改进后的模型RSE,结果表明,模型准确率为94.30%,召回率为94.33%,F1值为94.30%,相较于原模型均有较大提升,能够更准确、更全面地识别路面裂缝及其周边区域,更有效地消了除路面纹理对分类结果的影响。本研究中,以YOLOv8为基础框架,在模型关键部位引入BiFormer注意力机制,结果表明,精确度较原模型提升了1.1%,有效提升了模型精确度。

5 结论

1)本文提出了一种基于YOLOv8模型的改进算法YOLOv8-FFB,该模型在破损扇贝数据集上的mAP@0.5达到98.8%,mAP@0.5∶0.95为86.2%,FPS为44.22帧,准确率为95.5%,该模型能够满足对破损扇贝快速、准确的智能化检测。

2)该算法采用FasterNet网络替代YOLOv8主干网络,从而有效降低了模型的参数量和计算复杂度;同时,C2f_Faster模块被引入以替换neck部分的C2f模块,进一步减少参数量并提升检测速度。此外,在网络的关键区域中引入BiFormer注意力机制,以增强特征提取能力,从而提高检测精度。最后,采用Inner-IoU损失函数以加速预测框的收敛,进而提高回归精度。

3)本改进模型YOLOv8-FFB的精确度、召回率、mAP@0.5、mAP@0.5∶0.95在扇贝破损检测任务中显著优于YOLOv3-tiny、YOLOv5n、YOLOv6n、YOLOv8n和YOLOv8s等目标检测算法,只在模型大小方面略差于YOLOv5n模型。YOLOv8-FFB训练过程中的参数量为2 503 275个,与YOLOv3-tiny、YOLOv5n、YOLOv6n、YOLOv8s、YOLOv8n相比,在拥有更快训练速度同时减少了计算资源和内存占用,显示出YOLOv8-FFB在扇贝破损检测任务中的优越性。

[1] 马丽艳,汪一红,刘志东,等.扇贝加工副产物资源利用进展[J].渔业信息与战略,2017,32(3):204-210. MA L Y,WANG Y H,LIU Z D,et al.Advances in utilization of by-products from scallop processing[J].Fishery Information &Strategy,2017,32(3):204-210.(in Chinese)

[2] 朱丹妮,徐昙烨,刘峰,等.海水贝类风味品质研究进展[J].食品安全质量检测学报,2024,15(5):1-11. ZHU D N,XU T Y,LIU F,et al.Research progress on flavor quality of marine shellfish[J].Journal of Food Safety &Quality,2024,15(5):1-11.(in Chinese)

[3] 于道德,刘凯凯,张少春,等.中国栉孔扇贝养殖和育种的回顾与展望[J].海洋科学,2023,47(8):112-119. YU D D,LIU K K,ZHANG S C,et al.Culture and breeding ofChlamys farreri in China:reviews and prospects[J].Marine Sciences,2023,47(8):112-119.(in Chinese)

[4] 邓越新,郑龙,刘祥鹏,等.扇贝初加工技术研究现状及发展趋势[J].中国食品工业,2023(5):80-83. DENG Y X,ZHENG L,LIU X P,et al.Research status and development trend of scallop primary processing technology[J].China Food Industry,2023(5):80-83.(in Chinese)

[5] 李福东,黄强,李威,等.表面缺陷检测研究进展与挑战[C]//中国自动化学会过程控制专业委员会,中国自动化学会.第34届中国过程控制会议论文集.扬州大学信息工程学院(人工智能学院),2023:210. LI F D,HUANG Q,WEI L,et al.Research progress and challenges of surface defect detection [C]//Process Control Professional Committee of China Automation Society,Proceedings of the 34th China Process Control Conference.School of Information Engineering,Yangzhou University (School of Artificial Intelligence),2023:210.(in Chinese)

[6] 梁晓婷.基于深度学习的水果表面缺陷实时检测方法研究[D].上海:上海海洋大学,2023. LIANG X T.Research on real-time detection method of fruit surface defects based on deep learning[D].Shanghai:Shanghai Ocean University,2023.(in Chinese)

[7] 叶建华,唐辉,罗奋翔,等.基于改进MobileNet的咖啡豆缺陷检测[J].福建工程学院学报,2023,21(3):257-263. YE J H,TANG H,LUO F X,et al.Coffee bean defect detection based on improved MobileNet[J].Journal of Fujian University of Technology,2023,21(3):257-263.(in Chinese)

[8] 贾惠,伍希志,薛洋,等.基于迁移学习和数据增强的小样本柑橘缺陷检测研究[J].农业与技术,2024,44(2):23-27. JIA H,WU X Z,XUE Y,et al.Research on defect detection of small sample Citrus based on transfer learning and data enhancement[J].Agriculture and Technology,2024,44(2):23-27.(in Chinese)

[9] 孙志坚,王健,时佳,等.基于YOLOv 4的机收甜菜破损检测方法研究[J].农机化研究,2023,45(5):6-12. SUN Z J,WANG J,SHI J,et al.Breakage detection method of mechanized harvesting beets based on YOLOv4[J].Journal of Agricultural Mechanization Research,2023,45(5):6-12.(in Chinese)

[10] 付凯月,冯怡然,陶学恒.基于YOLO网络的对虾分拣装备设计[J].大连工业大学学报,2022,41(5):379-385. FU K Y,FENG Y R,TAO X H.Design of prawn sorting equipment based on YOLO networks[J].Journal of Dalian Polytechnic University,2022,41(5):379-385.(in Chinese)

[11] 吴远红,崔振东,候志凌.精细海产智能化生产和安全流通关键技术研究[J].浙江海洋大学学报(自然科学版),2017,36(5):447-450. WU Y H,CUI Z D,HOU Z L.Research on key technology of intelligent production and safe circulation technology of fine seafood[J].Journal of Zhejiang Ocean University (Natural Science Edition),2017,36(5):447-450.(in Chinese)

[12] 杨眉,魏鸿磊,华顺刚.一种基于神经网络的扇贝图像识别方法[J].大连海洋大学学报,2014,29(1):70-74. YANG M,WEI H L,HUA S G.A scallop image recognition method based on a neural network[J].Journal of Dalian Ocean University,2014,29(1):70-74.(in Chinese)

[13] 王艾泉,李府谦,张建华,等.贝壳类养殖加工关键工艺探究[J].现代制造技术与装备,2020,56(11):127-128. WANG A Q,LI F Q,ZHANG J H,et al.Study on the key technology of shellfish culture and processing[J].Modern Manufacturing Technology and Equipment,2020,56(11):127-128.(in Chinese)

[14] 涂万,于红,张鹏,等.基于通道非降维与空间协调注意力的改进YOLOv8养殖鱼群检测[J].大连海洋大学学报,2023,38(4):717-725. TU W,YU H,ZHANG P,et al.Farmed fish detection by improved YOLOv8 based on channel non-degradation with spatially coordinated attention[J].Journal of Dalian Ocean University,2023,38(04):717-725. (in Chinese)

[15] BOCHKOVSKIY A,WANG C Y,LIAO H M.YOLOv4:optimal speed and accuracy of object detection[EB/OL].2020:2004.10934. https://arxiv.org/abs/2004.10934v1.

[16] WANG C Y,BOCHKOVSKIY A,LIAO H M.YOLOv7:trainable bag-of-freebies sets new state-of-the-art for real-time object detectors[C]//2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).June 17-24,2023,Vancouver,BC,Canada.IEEE,2023:7464-7475.

[17] HOWARD A G,ZHU M L,CHEN B,et al.MobileNets:efficient convolutional neural networks for mobile vision applications[J].arXiv preprint arXiv:1704.04861, 2017.

[18] MA N N,ZHANG X Y,ZHENG H T,et al.ShuffleNet V2:practical guidelines for efficient CNN architecture design[C]// Computer Vision-ECCV 2018.Cham:Springer International Publishing,2018:122-138.

[19] HAN K,WANG Y H,TIAN Q,et al.GhostNet:more features from cheap operations[C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).June 13-19,2020.Seattle,WA,USA.IEEE,2020:1577-1586.

[20] CHEN J R,KAO S H,HE H,et al.Run,don’t walk:chasing higher FLOPS for faster neural networks[C]//2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition(CVPR).June 17-24,2023,Vancouver,BC,Canada.IEEE,2023:12021-12031.

[21] WANG J Y,LI Y J,WANG J K,et al.An underwater dense small object detection model based on YOLOv5-CFDSDSE[J].Electronics,2023,12(15):3231.

[22] VASWANI A,SHAZEER N M,PARMAR N,et al.Attention is all you need[C].//Neural Information Processing Systems,2017.

[23] ZHU L,WANG X J,KE Z H,et al.BiFormer:vision transformer with bi-level routing attention[C]//2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).June 17-24,2023,Vancouver,BC,Canada.IEEE,2023:10323-10333.

[24] ZHANG H,XU C,ZHANG S J.Inner-IoU:more effective intersection over union loss with auxiliary bounding box[EB/OL].2023:2311.02877. https://arxiv.org/abs/2311.02877v4.

[25] REDMON J,FARHADI A.YOLOv3:An incremental improvement[J].arXiv preprint arXiv:1804.02767,2018.

[26] LI C Y,LI L,JIANG H L,et al.YOLOv6n:a single-stage object detection framework for industrial applications[J].arXiv preprint arXiv:2209.02976,2022.

[27] 王卓,王健,王枭雄,等.基于改进YOLO v4的自然环境苹果轻量级检测方法[J].农业机械学报,2022,53(8):294-302. WANG Z,WANG J,WANG X X,et al.Lightweight real-time apple detection method based on improved YOLO v4[J].Transactions of the Chinese Society for Agricultural Machinery,2022,53(8):294-302.(in Chinese)

[28] 曹宇,李佳阳,王芳.基于改进YOLOv8n的水下鱼类目标识别轻量化模型[J].上海海洋大学学报,2025,34(1):188-200. CAO Y,LI J Y,WANG F.An improved YOLOv8n based on lightweight model for underwater fish target detection[J].Journal of Shanghai Ocean University,2025,34(1):188-200.(in Chinese)

[29] 王德雨,石伟,张元良.一种融合CBAM注意力机制和金字塔卷积的经济鱼类识别方法[J].江苏海洋大学学报(自然科学版),2023,32(1):73-80. WANG D Y,SHI W,ZHANG Y L.A method for economic fish identification that integrates CBAM attention mechanism and pyramid convolution[J].Journal of Jiangsu Ocean University (Natural Science Edition),2023,32(1):73-80.(in Chinese)

[30] 韦洁瑶,韩梦丹,蒲秋梅.基于ResNet和注意力机制的路面裂缝识别[J].中央民族大学学报(自然科学版),2024,33(4):57-62. WEI J Y,HAN M D,PU Q M.Pavement crack recognition based on ResNet and attention mechanism[J].Journal of Minzu University of China (Natural Sciences Edition),2024,33(4):57-62.(in Chinese)