近年来,由于水产养殖产品需求量的日益增长,渔业养殖技术受到了越来越多的关注[1]。中国作为水产养殖大国,渔业养殖技术还有待提高,尤其在鱼类投饵方面仍存在一些问题。主要体现在投喂自动化水平较低,生产中主要依靠人工投喂,但人工投喂严重依赖养殖人员的经验,使得投喂饲料量难以控制[2]。若投喂过多会造成饲料浪费,污染水体环境且大幅提高养殖成本[3],投喂过少又会导致鱼类摄食不足,影响鱼类生长。因此,量化鱼类摄食行为,实现智能化投饵是迈向智慧养殖的必经之路[4-5]。

目前,在鱼类摄食检测和分析领域主要以图像信息、声学信息和少量针对水质参数的研究为主。在图像信息方面,唐宸等[6]通过光流法提取视频内鱼群的帧间运动特征,构建分类网络进行细粒度分类,最后基于投票策略对鱼群摄食视频进行分类。Ubina等[7]将光流和RGB特征融合到三维卷积神经网络(3D-CNN)中,以此对鱼类摄食强度进行预测,准确率达到了90%以上。冯双星等[8]提出一种基于机器视觉和轻量型S3D算法的鱼群摄食强度实时识别算法,可精确定位视频流中“强、中、弱、无”4种鱼群摄食强度状态。Yang等[9]提出了一种基于高效网络的双注意力网络,研究摄食图像中兴趣区域之间的空间关系,分析鱼群短时摄食行为。陈明等[10]为了提升养殖过程中的投喂精确度,研究开发了一种新颖的评估方法,专注于量化鱼群的摄食活动强度,该方法通过图像预处理提取鱼群数据集,利用质心追踪绘制鱼群轨迹,并综合颜色征,结合Relief特征选择技术和XGBoost算法,筛选并加权融合关键评价因子,建立评估模型,有效提高了评估的准确性和效率,为智能化水产养殖提供了技术支持。在声学方面,陈雨琦等[11]将工厂化循环水养殖池中的鱼群摄食视频作为前景并提取傅里叶频谱特征,使用支持向量机训练得到特征信息以判断摄食状态。曹晓慧等[12]采用被动声学技术获取单体大口黑鲈(Micropterus salmoides)摄食声音信号,并从混合信号中提取完整的摄食信号,成功筛选出衡量大口黑鲈摄食活跃度的声学特征参数。

然而,只基于单模态信息,常用的鱼群摄食行为量化方法存在一定的局限性。在机器视觉方面,图像信息是最直观且实时地评估鱼类摄食行为的方式,但图像的成像质量易受水质、光线、相机拍摄角度等因素的影响,此外,鱼类的摄食行为特殊且复杂,如果鱼类摄食图像质量不高,则较难提取到有效的图像信息特征。声学方面,在鱼类摄食过程中,快速的拍尾、吞咽和碰撞等动作可以使得声学信号发生变化,但也会因为存在环境噪声而影响判别的准确度。水质监测方面,水质参数的变化可以直接影响鱼的食欲[13],但水质信息的时效性较低且通过水下传感器采集到的水质参数信息难以覆盖整个鱼池,使得难以把控最佳的投饵时机。若可结合多个模态的鱼类摄食信息进行分析,提取不同模态中的有效信息,就可以有效提高模型在复杂环境下的鲁棒性[14]。

在多模态鱼群摄食分类领域,胡学龙等[15]从输入的水质、声音和图像数据中提取特征向量并进行融合,得到3类融合向量;然后对融合向量添加自适应权重并相加,得到融合模态。最后,利用融合模态将多模态Transformer中各模态分支的跨模态从2个优化为1个。陈璐[16]构建了多模态卷积神经网络,实现对鱼群摄食活跃程度的识别,对比了单模态和多模态网络的分类性能,多模态网络具有更高的准确率及更强的抗噪声能力。胥婧雯等[17]采用残差网络模型提取视觉模态特征,通过MFCC+RestNet50模型提取声音模态特征,并在此基础上设计一种U型融合架构,使不同维度的鱼类视觉和声音特征充分交互。朱文韬[18]以金鳟作为研究对象,利用深度学习算法,融合水质、图像和声音3种模态的信息,提出一种高精度的鱼类多模态Transformer鱼群摄食强度识别方法,并基于该方法研究开发了鱼类摄食强度检测系统和智能投喂系统。曾昱皓[19]提出基于声音信息和改进Swin Transformer网络的鱼群摄食行为量化方法,设计出了基于轻量化图像识别算法的鱼群空间分布识别方法。郑金存等[20]提出了一种创新的量化鱼类摄食强度的方法,该方法通过整合多种声像特征来实现。通过加权融合技术,综合考虑摄食动态、水体流场变化和摄食音频这3种不同物理属性的特征信息,实现了对鱼群摄食强度的精确量化。但是上述研究中提到的多模态方法多是在独立处理单独模态后[21-22],简单地融合多个模态的信息,然后通过交叉注意力机制融合特征信息[23-25]。然而,单模态中存在的突发性噪音及视听信息不同步问题,仍然会导致识别不够精确[26]。

本文提出了一种基于多模态背景抑制网络的鱼类摄食强度识别方法[27],旨在精准量化鱼群摄食行为。该方法首先利用全局视觉信息和音频信息,通过多模态协同注意力模块提取与事件相关的视觉区域;同时,利用时间级背景抑制模块将音频和视觉模态的信息同时作为监督信号,用以区分彼此的模糊背景,增强视频片段重要部分的信息,从而间接抑制背景部分的信息;最后,通过事件级背景抑制方案,借助音频和视觉信息抑制单一模态中低概率出现的噪声事件,从而进一步提高预测的鲁棒性。该方法能够准确捕捉鱼群的摄食行为,并在一定程度上缓解了单模态中存在的突发性噪音及视听信息不同步问题对最终预测的影响。

1 材料与方法

1.1 数据集获取

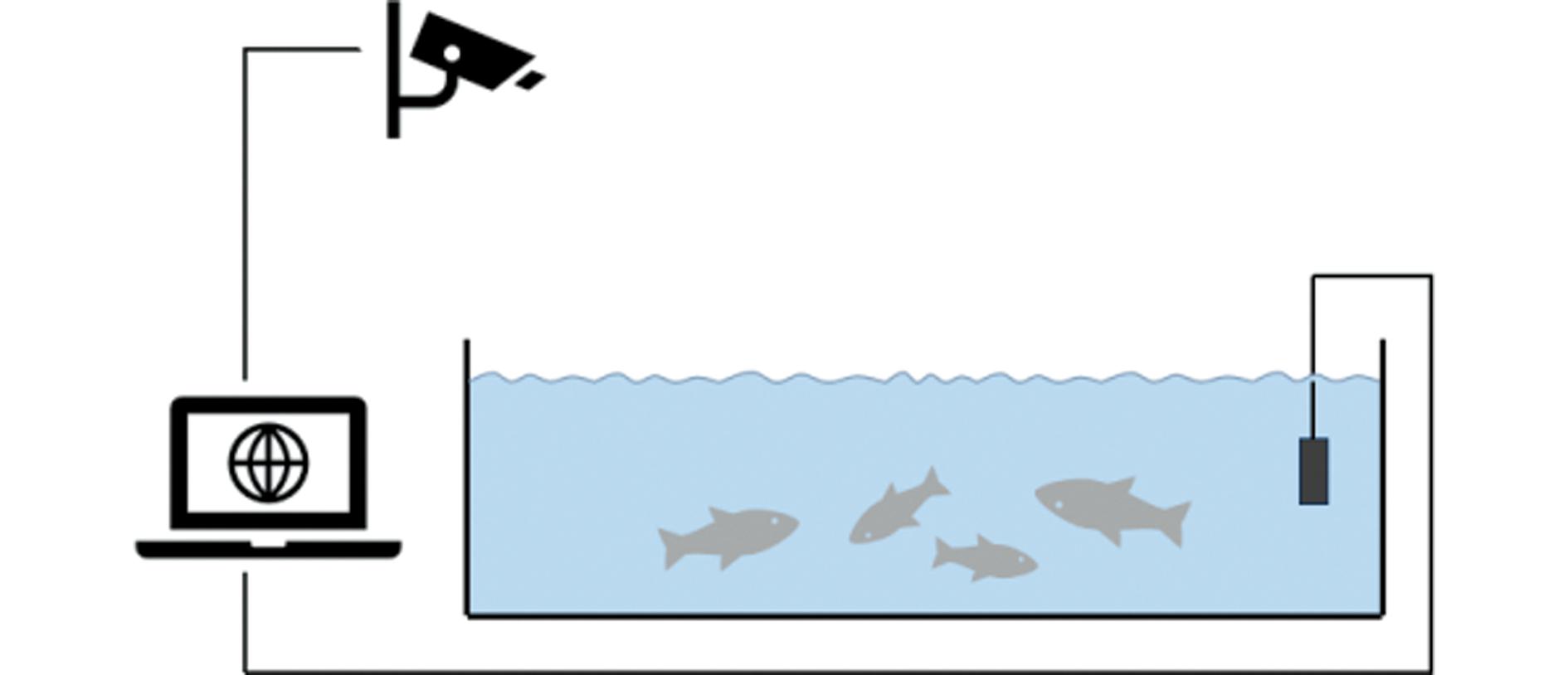

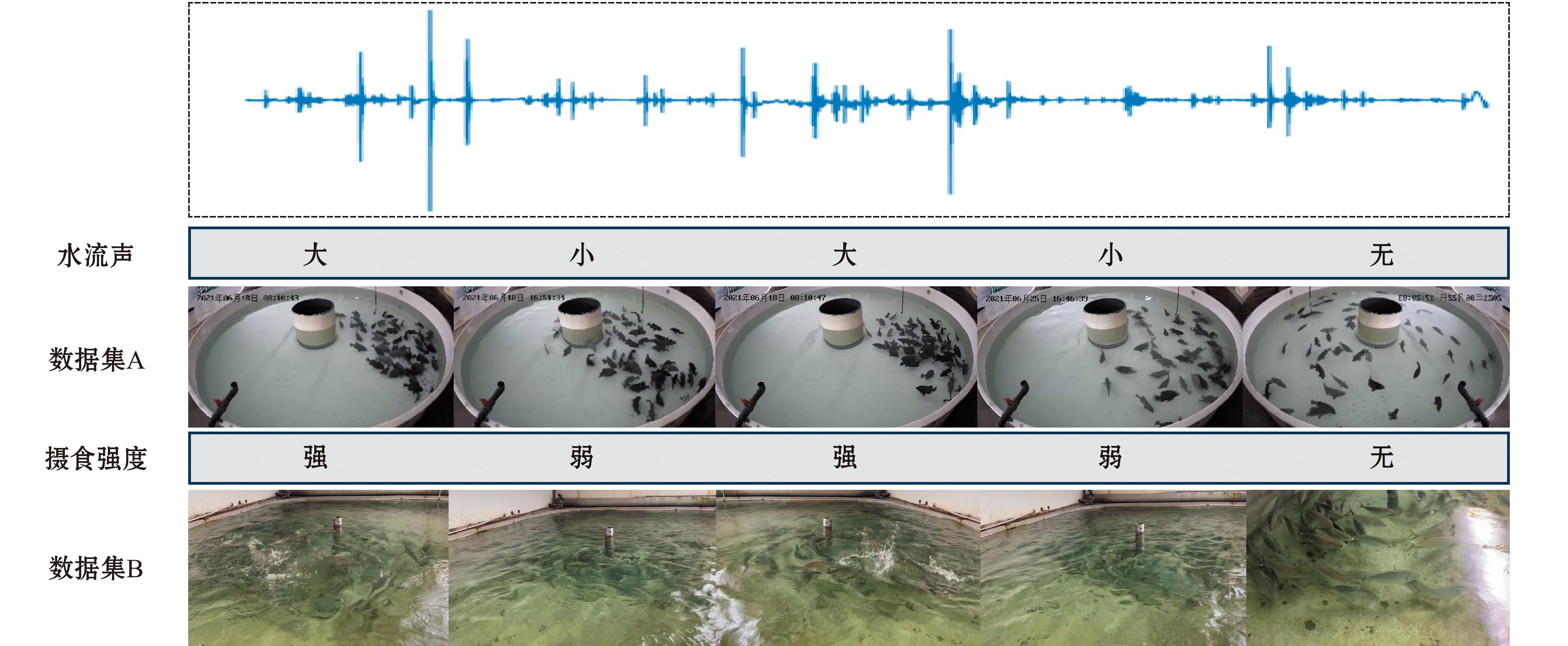

1.1.1 数据集A:试验环境数据集 本试验数据集A采用公开数据集AAFIA3K[28],数据包含斑石鲷(Spotted Knifejaw)50尾,月龄4个月。斑石鲷数据集为视听双模态数据集,视频采集系统主要由计算机、摄像头和传感器等组成。数据采集如图1所示。

图1 斑石鲷数据采集

Fig.1 Schematic diagram of data collection for the Spotted Knifejaw

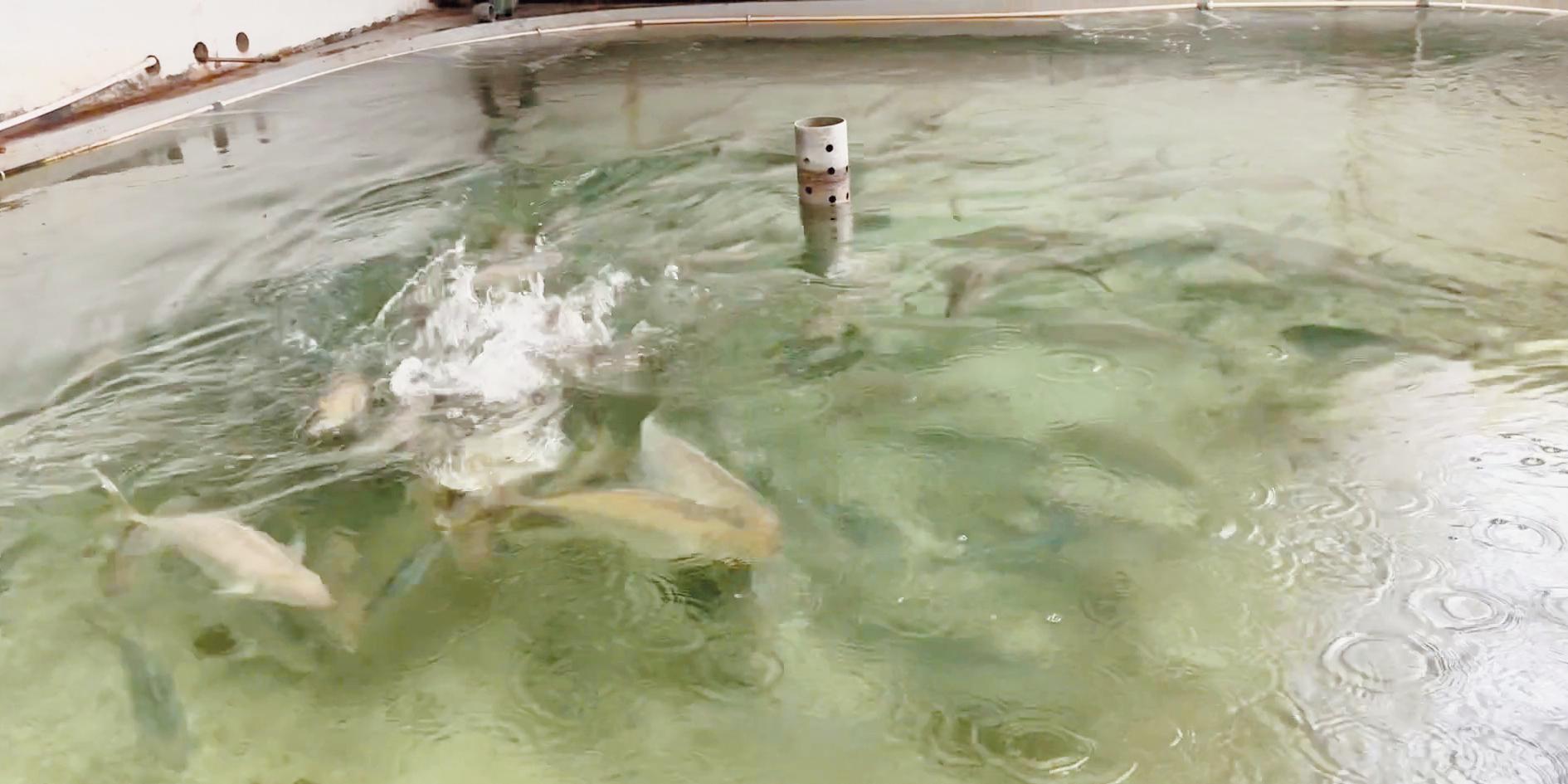

1.1.2 数据集B:真实养殖环境数据集 真实养殖环境数据集B于大连天正养殖公司的循环水养殖车间拍摄,拍摄鱼种为黄带拟鲹(Pseudocaranx dentex)。黄带拟鲹在摄食过程中会激烈地争抢饵料,并带动起大片的水花。黄带拟鲹养殖池如图2所示。

图2 黄带拟鲹养殖池

Fig.2 Culture pond for Pseudocaranx dentex

1.2 数据预处理

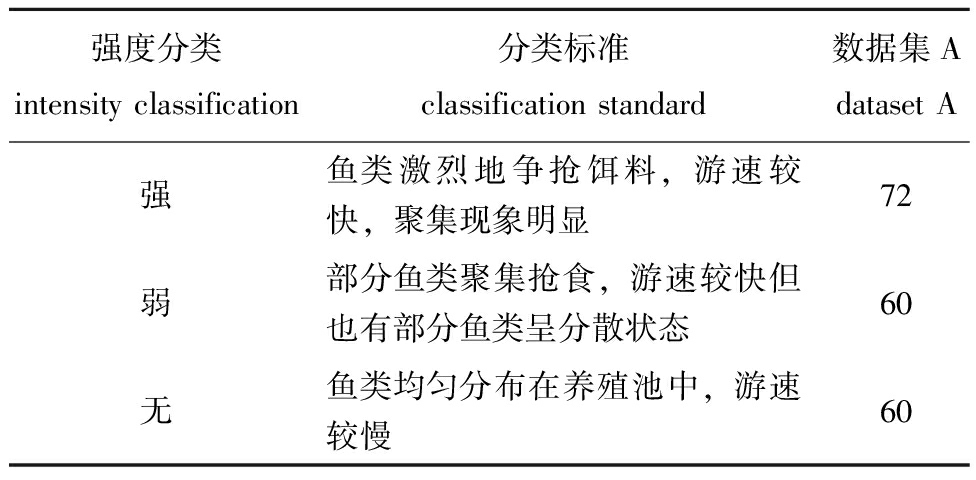

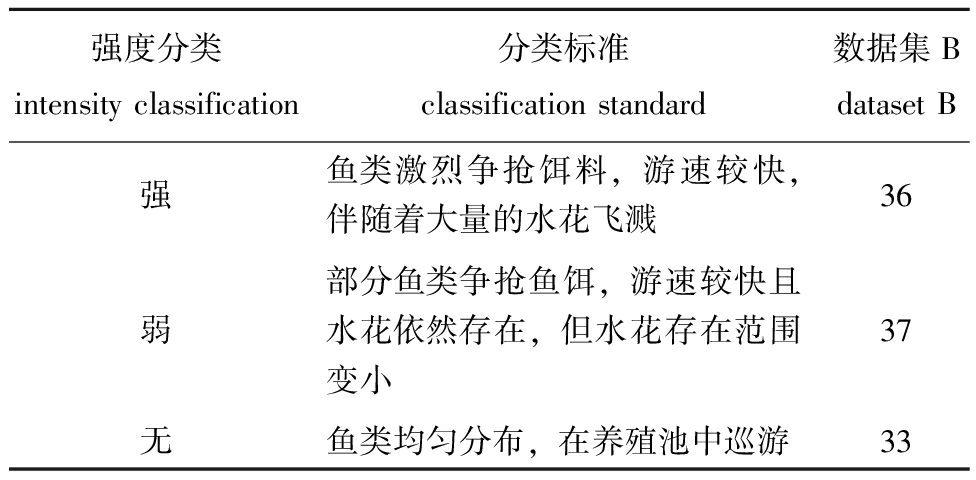

首先对数据集A斑石鲷、数据集B黄带拟鲹摄食视频进行摄食强度三分类:强、弱、无[29]。将分类得到的视频通过裁剪、组合等形式,将视频时长统一设定为每段10 s,再通过水平翻转、垂直翻转、添加噪音等形式对分类后的视频进行数据扩增;然后将斑石鲷和黄带拟鲹视频的音频与图像进行分离,得到单独的图像信息和音频信息;最后,对真实养殖场的鱼类数据集B黄带拟鲹摄食音频进行低通滤波去噪。试验中依据养殖场养殖户的描述,将鱼群摄食强度划分为3个等级,斑石鲷的摄食强度分类见表1,黄带拟鲹的摄食强度分类见表2。

表1 斑石鲷摄食强度分类

Tab.1 Classification of the feeding intensity of dataset A

强度分类intensity classification分类标准classification standard数据集Adataset A强鱼类激烈地争抢饵料,游速较快,聚集现象明显72弱部分鱼类聚集抢食,游速较快但也有部分鱼类呈分散状态60无鱼类均匀分布在养殖池中,游速较慢60

表2 黄带拟鲹摄食强度分类

Tab.2 Classification of the feeding intensity of dataset B

强度分类intensity classification分类标准classification standard数据集Bdataset B强鱼类激烈争抢饵料,游速较快,伴随着大量的水花飞溅36弱部分鱼类争抢鱼饵,游速较快且水花依然存在,但水花存在范围变小37无鱼类均匀分布,在养殖池中巡游33

基于鱼群摄食强度分类表划分为不同摄食强度形态的真实流程图,如图3所示。

图3 鱼群不同摄食强度形态

Fig.3 Diagram of different feeding intensity forms in fish schools

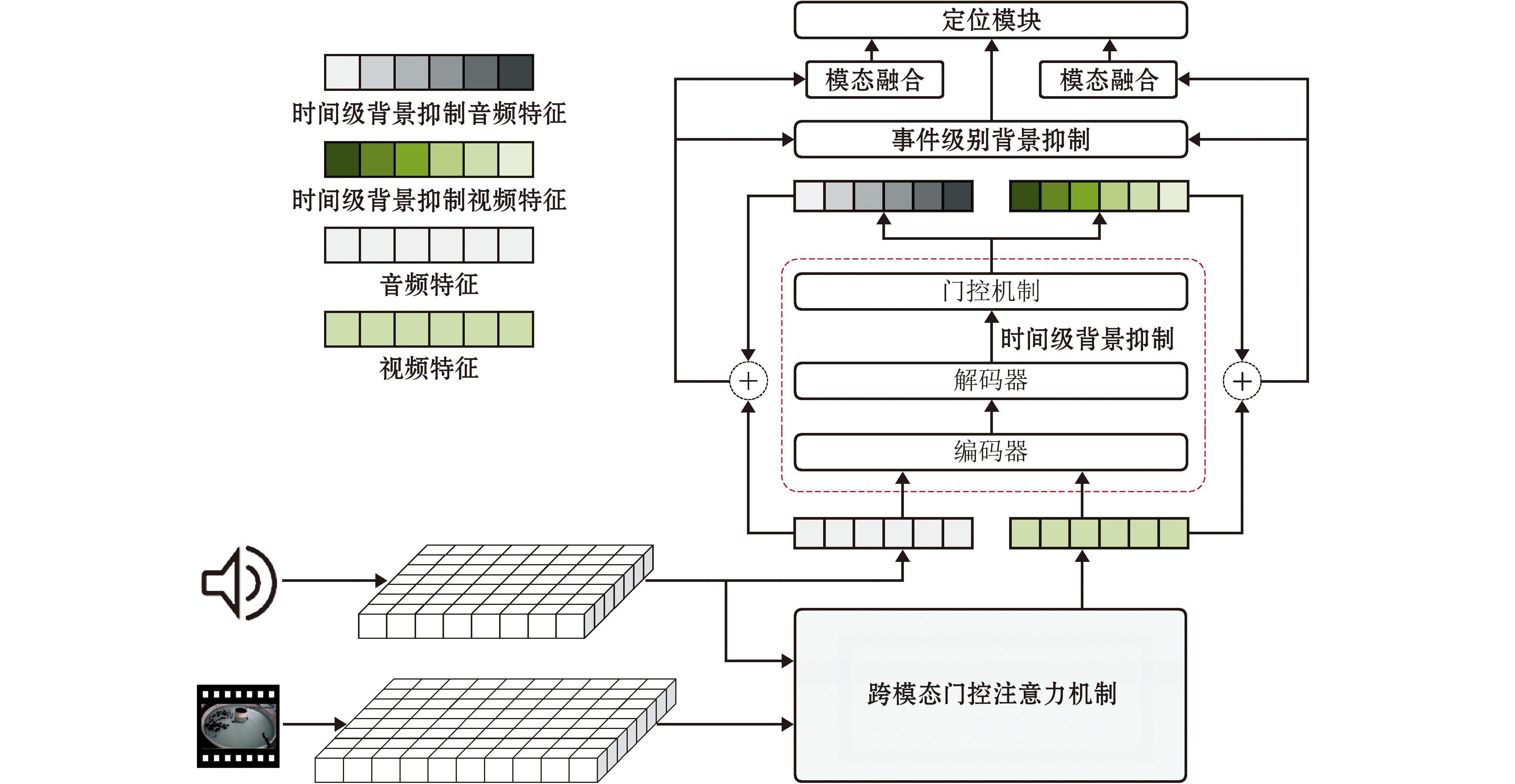

1.3 特征提取

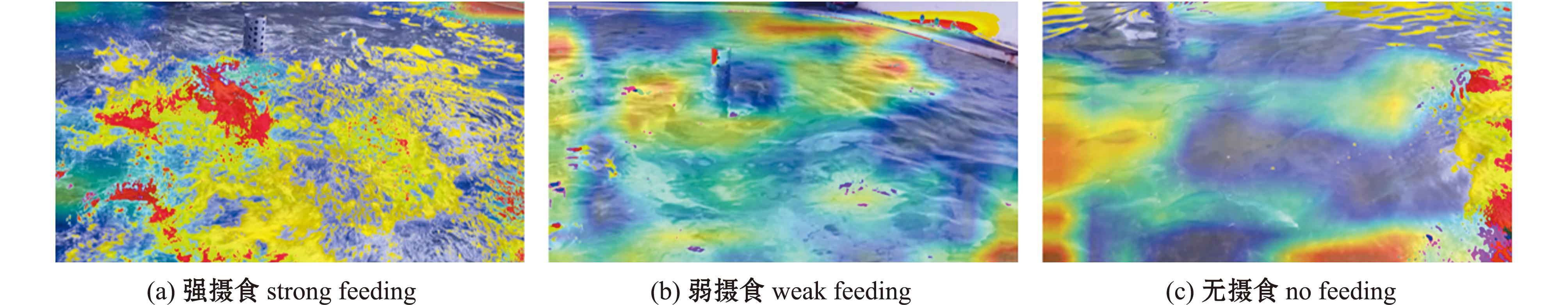

为高效地处理多模态数据,本文对多模态数据进行了特征提取操作。其中,有关视频特征的提取,本文采用的是VGG19模型,如图4所示,该模型针对鱼群不同摄食强度的图片能够提取出丰富且具有判别性的视频特征。有关音频特征的提取,本文选用VGGish模型,该模型专为音频设计,在处理音频数据时计算效率较高,能够有效提取音频的关键特征。

图4 VGG19不同摄食强度权重注意力

Fig.4 VGG19 attention map with different feeding intensity weights

在试验时,将视频数据输入到VGG19模型中[30],提取视频片段的7×7×512视频特征。同理,将视频分离出的音频数据输入到VGGish模型中,提取音频片段的128维音频特征。特征提取流程图如图5所示。

图5 特征提取流程

Fig.5 Flow chart of feature extraction

2 模型设计

2.1 跨模态背景抑制网络模型

为完成多模态鱼类摄食行为分类任务,解决单一模态中存在的突发性噪音和视听不同步等问题对分类准确率的影响,本文应用跨模态背景抑制网络(cross-modal background suppression network,CMBS)来进行鱼类摄食分类任务。CMBS网络可以通过在时间级和事件级的操作,抑制不同步的视频、音频背景帧,处理单一模态中突然出现的噪音事件,以提高模型的鲁棒性和分类精准度。

在大多数情况下,鱼类摄食行为中的视听分类任务定义如下:

给定一个有T个不重叠的片段的视频序列

(1)

式中:At和Vt表示音频特征和视频特征,每个片段为1 s,要求模型推理出每个片段的事件标签(包括背景)。

(2)

式中:![]() 为[t,th]中时间为1的视频段,其中时间[t,th]段的事件是可听、可见的。C为类别数(包括背景)。

为[t,th]中时间为1的视频段,其中时间[t,th]段的事件是可听、可见的。C为类别数(包括背景)。

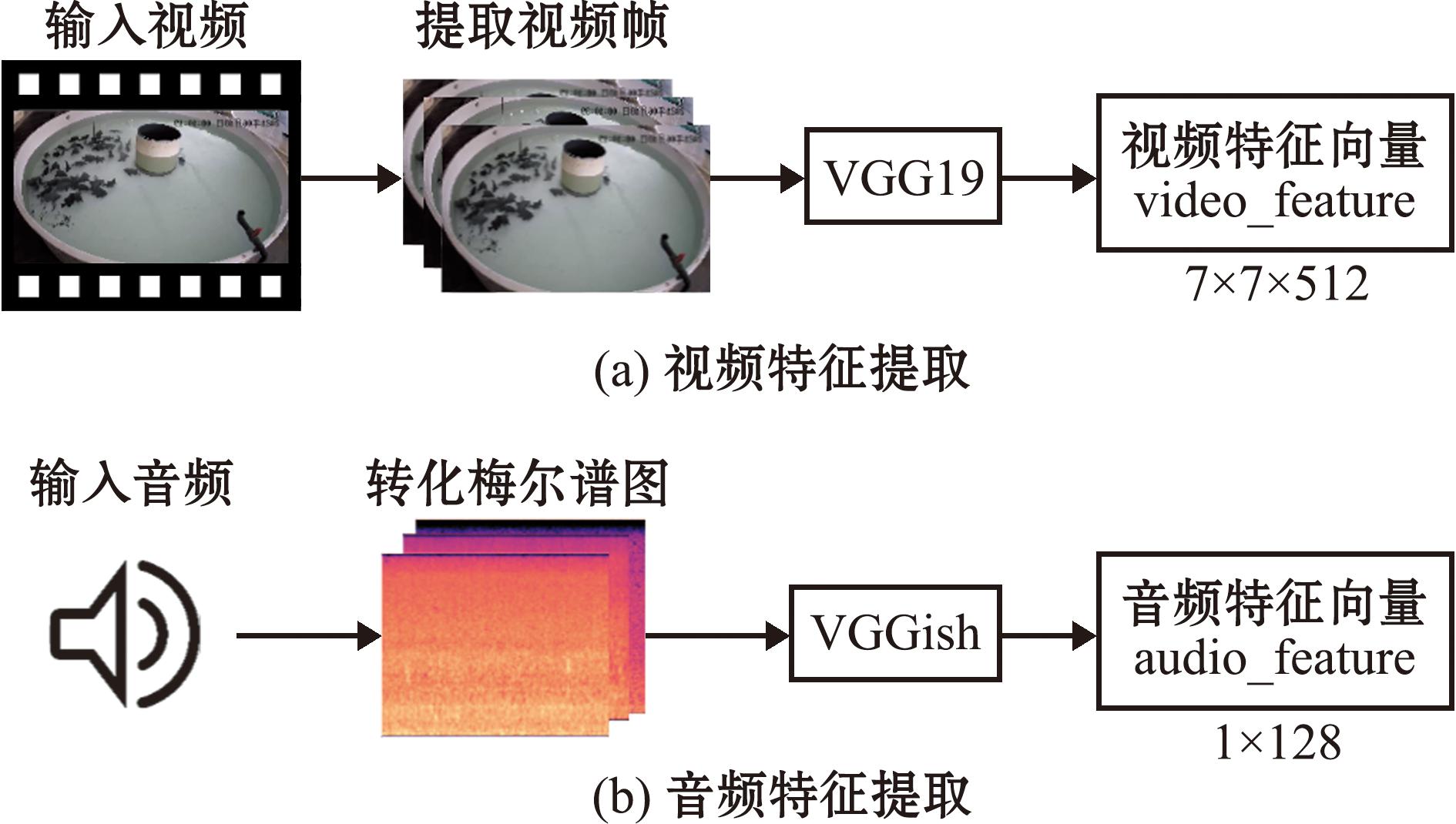

2.2 模型结构

在特征信息输入到CMBS网络后,首先通过多模态协同注意力模块以融合音频和视频特征,并突出与音频相关的重要视频特征信息。接下来设计了一个跨模态的时间级背景抑制模块以控制音频和视觉模态应该关注的视频片段。随后,本文使用事件级背景抑制模块对处理后的音频和视频特征进行分类得分计算,选择得分较高的部分,抑制事件级的背景信息,突出与事件相关的特征。最后,通过多头注意力融合模块进一步促进音频和视频特征间的交互和融合并输入到定位模块中以得到最终的分类结果。CMBS模块如图6所示。

图6 CMBS模块示意图

Fig.6 Schematic map for CMBS module

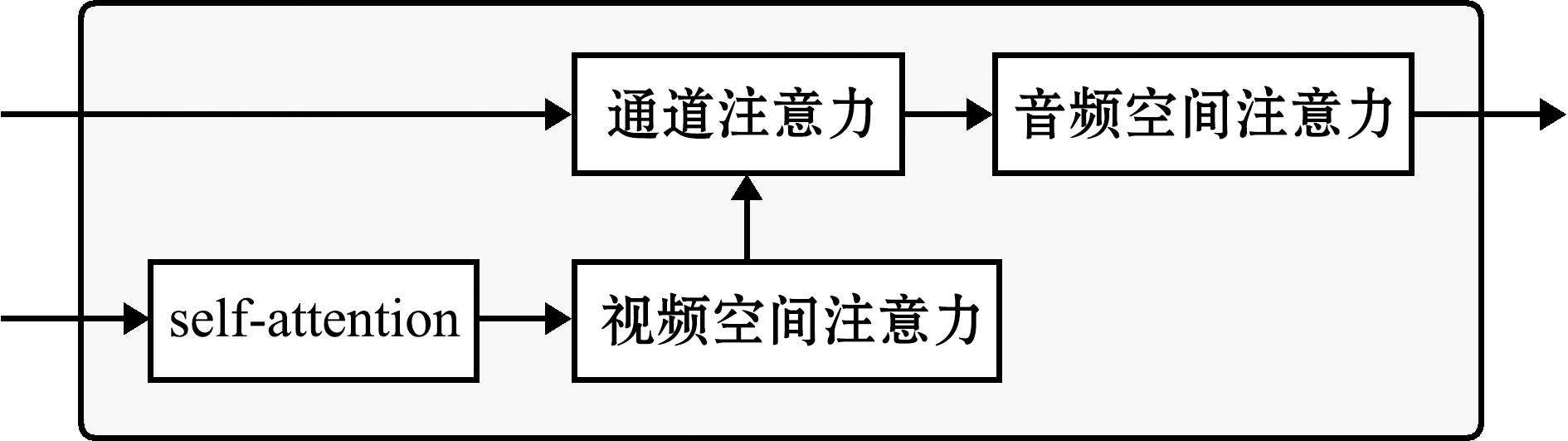

2.2.1 多模态协同注意力模块 在视听结合的模型中,音频特征常用来指导视觉特征的提取,为了更好地捕捉音频和视频间的联系,使视频特征能够尽量多地融合音频信息,CMBS模型采用了多模态协同注意力模块。该模块包括自注意力机制、视频空间注意力机制、通道注意力机制和音频空间注意力机制,以达到利用音频特征信息来引导视频特征提取,减少噪声和不相关信息干扰的效果。

在视频特征输入到多模态协同注意力模块时,首先会通过自注意力机制模块,使模型能自适应地从视频特征中提取有意义信息,提高模型对视频内容的理解能力。随后经过自注意力机制计算和处理后的视频特征会通过视频空间注意力机制模块,以聚焦视频特征在空间维度上的重要区域,突出视频中在空间分布上具有重要信息的部分,使模型能够根据视频的空间特征分布自适应地分配注意力权重,以提取更具判别性的空间特征信息。视频特征在得到通道注意力权重后,会通过通道注意力机制和音频空间注意力机制同音频特征进行交互。

在音频特征和视觉特征交互方面,模块先用音频特征at和全局视觉特征![]() 来对视觉特征进行通道级注意[31],在获得通道级注意力视觉特征

来对视觉特征进行通道级注意[31],在获得通道级注意力视觉特征![]() 和

和![]() 后,进行下一步的音频空间级注意力操作,通过音频信息引导视觉信息的方式,从

后,进行下一步的音频空间级注意力操作,通过音频信息引导视觉信息的方式,从![]() 和

和![]() 中提取重要的视觉空间信息。

中提取重要的视觉空间信息。![]() 和at的空间水平注意力得分用

和at的空间水平注意力得分用![]() 和

和![]() 表示,

表示,![]() 的公式表示为

的公式表示为

![]()

(3)

(4)

(5)

式中:Wa、Wv和W1是3个学习参数,用于将输入的特征进行线性变换,输出一个新的、维度变换后的特征,用于进行下一步的特征融合,![]() 和

和![]() 分别代表视觉特征和音频特征经过线性变换和激活后的高阶表示,

分别代表视觉特征和音频特征经过线性变换和激活后的高阶表示,![]() 代表音频引导的空间注意力权重,⊙是哈达玛乘积,∂是Relu激活函数。然后将

代表音频引导的空间注意力权重,⊙是哈达玛乘积,∂是Relu激活函数。然后将![]()

和![]() 分别与

分别与![]() 和

和![]() 相乘,得到空间级注意力视觉特征

相乘,得到空间级注意力视觉特征![]() 和

和![]() 最后,通过

最后,通过![]() 和

和![]() 产生的两个残差门σa和σg,设计了一个交叉门控机制Vt来选择t-th段的重要视觉区域:

产生的两个残差门σa和σg,设计了一个交叉门控机制Vt来选择t-th段的重要视觉区域:

(6)

式中:β1和β2为超参数,用于控制自注意力特征在最终输出中的影响程度。σa和σg可以用来选择音频信号和全局视觉信号注意的事件相关区域,对特征的权重进行调节,以补充空间级注意力视觉特征。得到的最终视觉特征向量V∈RT×dv包含了来自音频和全局视觉记忆特征的通道及空间注意信息,可以减少不相关的背景特征,在一定程度上减少噪音对视觉特征的影响,提高视觉表示的质量。跨模态门控注意力模块如图7所示。

图7 多模态协同注意力模块

Fig.7 Cross-modal gated attention module

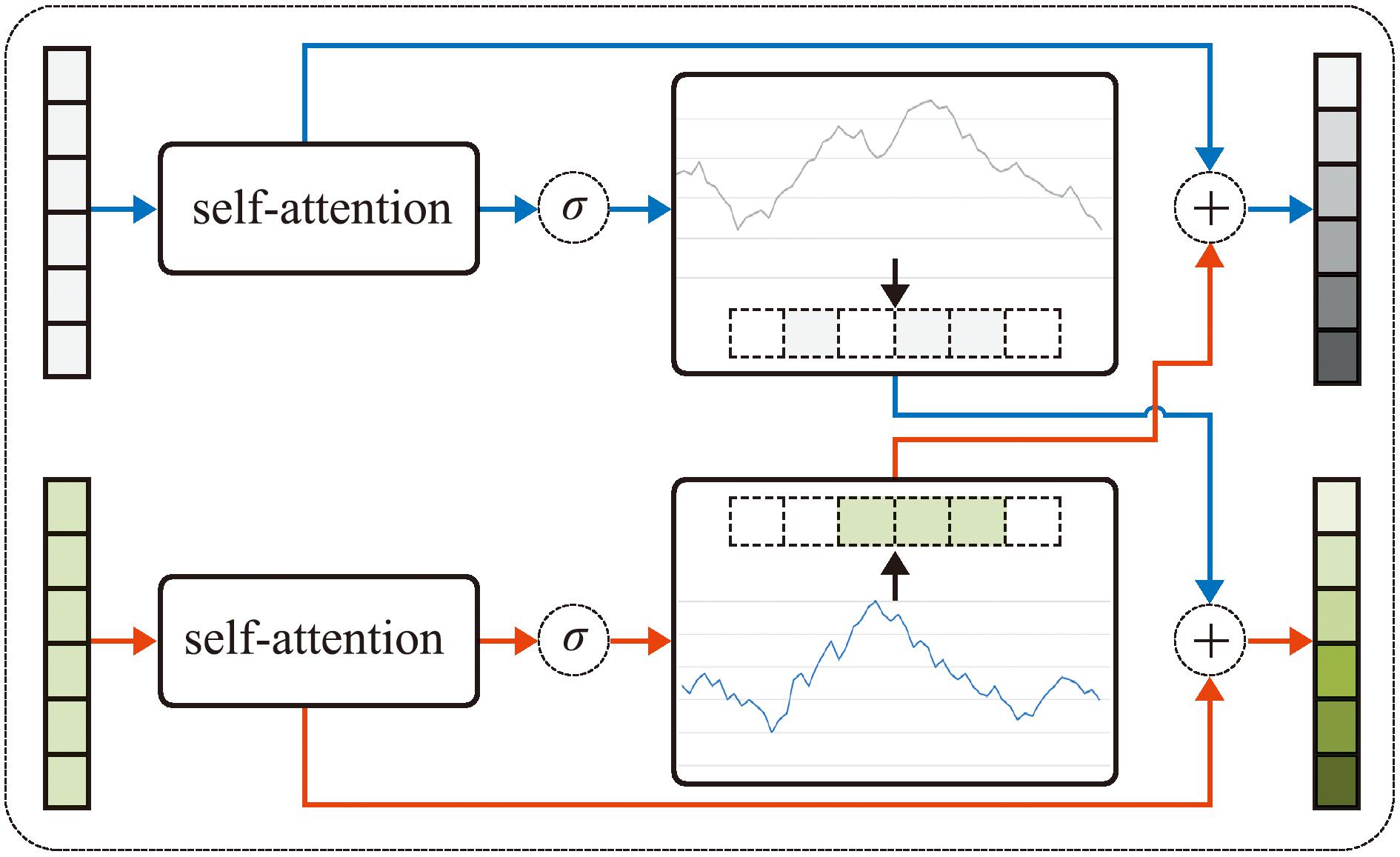

2.2.2 时间级背景抑制 在获得音频和视觉模态的特征后,CMBS把来自这两种模态的信息当作监督信号,以区分并抑制彼此的模糊背景。具体来说,模型首先通过RNN层处理输入的音频和视觉特征,捕捉在时间维度上的特征的变化,获得Vs,As∈RT×dh,其中dh为隐藏维度。Vs和As的每一段都包含整个视频的音频或视觉相关信息,有助于模型理解时间层面上的整体内容。然后通过模态查询机制,使得音频和视频特征能够互相交互、共享信息,增强多模态数据的表示能力,以便于模型抓取关键信息。最后,为了确定每个模态的重要片段,本文为Vs和As添加了两个门,分别为![]() 和

和![]() 其中,

其中,![]() 两个门中的值代表每个段被音频和视觉模态考虑的重要程度。如若视觉模态考虑某个包含主事件的片段,则

两个门中的值代表每个段被音频和视觉模态考虑的重要程度。如若视觉模态考虑某个包含主事件的片段,则![]() 对应位置的值会更大。然后,本文将视觉门

对应位置的值会更大。然后,本文将视觉门![]() 与音频特征As相乘,将音频门

与音频特征As相乘,将音频门![]() 与视觉特征Vs相乘,从相反的模态中选择这两个门认为重要的片段。最后,利用残差连接思想,将两个模态特征与α相乘,分别获得时间级抑制的视觉和音频特征

与视觉特征Vs相乘,从相反的模态中选择这两个门认为重要的片段。最后,利用残差连接思想,将两个模态特征与α相乘,分别获得时间级抑制的视觉和音频特征![]() 和

和![]() 和

和![]() 的表述为

的表述为

(7)

(8)

式中:α是一个超参数。通过增强视频片段重要部分的信息,会间接抑制背景部分的信息。时间级背景抑制模块如图8所示。

图8 时间级背景抑制模块

Fig.8 Time-level background suppression module

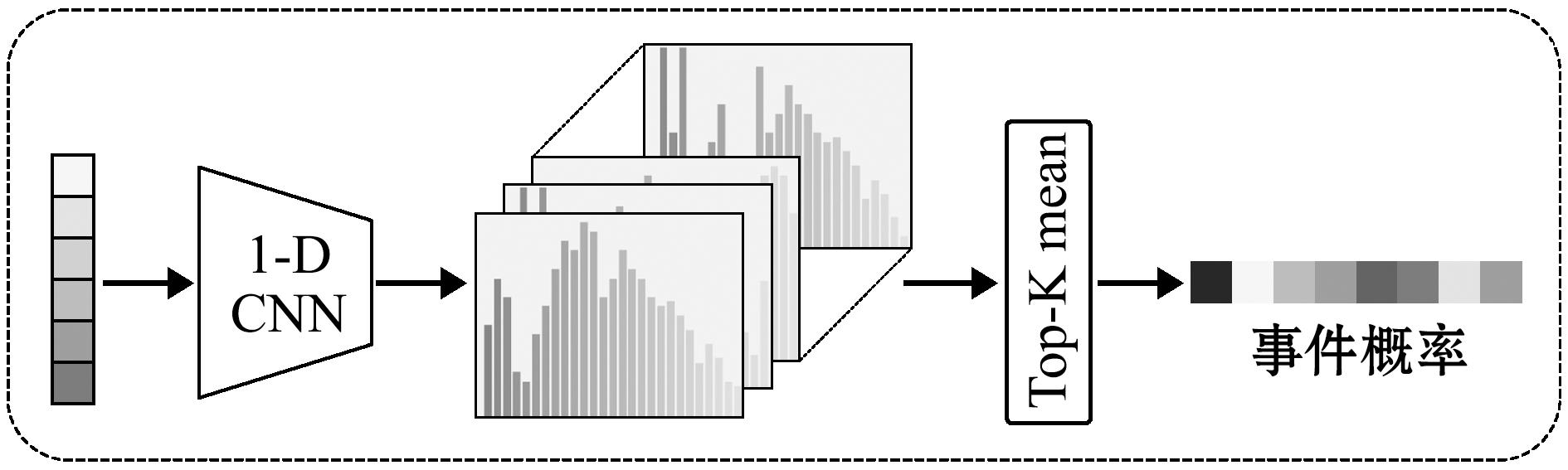

2.2.3 事件级背景抑制 当采用单一模态时,即使得到在时域上抑制背景的音频和视觉特征,大多数模型还是无法较好地区分一些具有混合声音的音频或较为复杂的视觉场景[32],这影响了模型对事件类别的预测。为了缓解这个问题造成的影响,本文使用了基于CMBS模型的事件级背景抑制方案。

该方案同时利用音频和视觉信息来抑制彼此存在的低概率噪声,提高模型的鲁棒性。本文首先将时间级抑制的视觉和音频特征![]() 和

和![]() 加载到时间级的一维(1D)卷积层中,并使用类激活序列(class activation sequences,CAS)预测片段级分类分数Sv和SA。

加载到时间级的一维(1D)卷积层中,并使用类激活序列(class activation sequences,CAS)预测片段级分类分数Sv和SA。

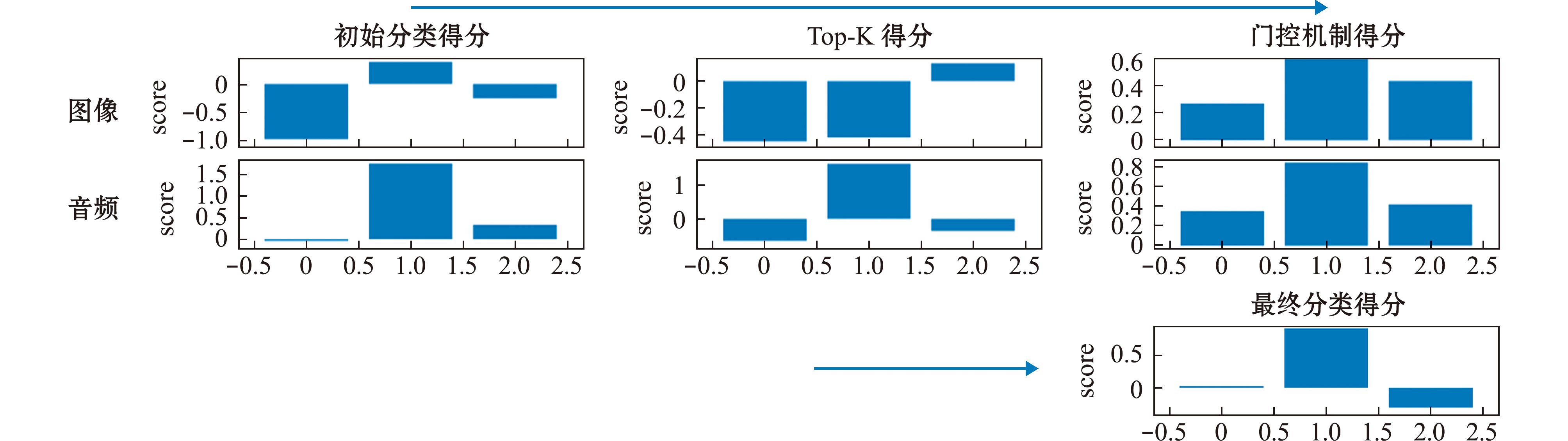

对于完全监督任务,本研究对Sv,SA∈RT×C进行了设置。然后,使用Top-K-means均值技术汇总分段事件得分,得到Sv和SA:

(9)

式中:m∈{A,V},Sn;c为包含第c类的top-K-means汇总的事件得分的子集,K为控制视频中所选片段数量的超参数,设为4。最后,在Sv和SA上应用sigmoid激活函数来获得视觉和音频事件级背景门:![]() 和

和![]() 和

和![]() 包含了每个事件在音频和视觉模态中发生的概率,并将在后续过程中与最终预测结果相乘。这两个门的主要功能是用来抑制只在某一种模态中发生但在另一种模态中发生概率较低的事件,可以解耦在单一模态中无法区分的混合噪声,提高模型的鲁棒性。事件级背景抑制模块如图9所示。

包含了每个事件在音频和视觉模态中发生的概率,并将在后续过程中与最终预测结果相乘。这两个门的主要功能是用来抑制只在某一种模态中发生但在另一种模态中发生概率较低的事件,可以解耦在单一模态中无法区分的混合噪声,提高模型的鲁棒性。事件级背景抑制模块如图9所示。

图9 事件级背景抑制模块

Fig.9 Event-level background suppression module

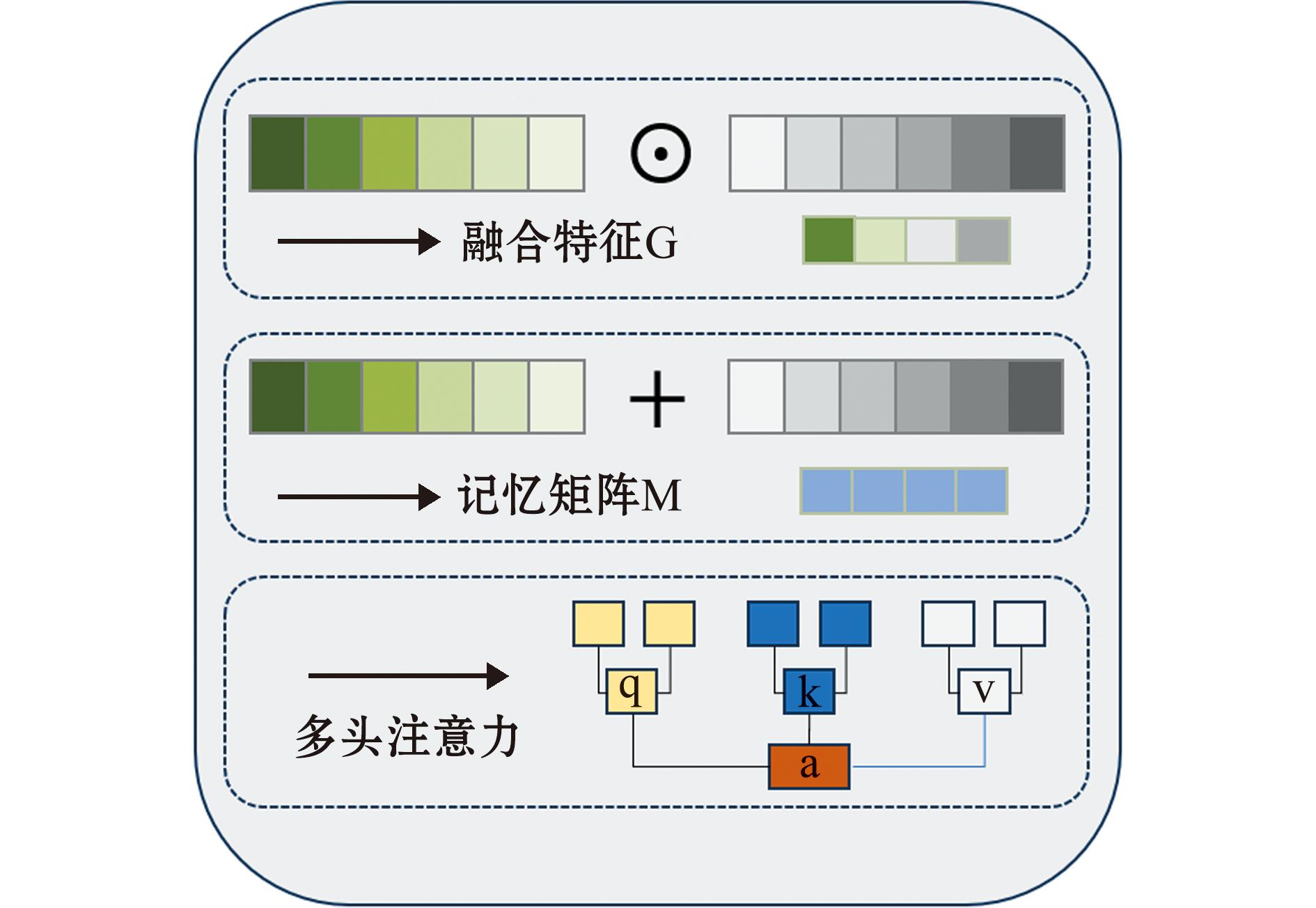

2.2.4 多头注意力融合模块 在进行最终的分类之前,模型会通过多头注意力融合模块来获得每个模态所需要的其他模态的相关信息,以有效捕捉音频和视频特征之间的复杂依赖关系。

首先,多头注意力融合模块对经过时间级背景抑制后的视觉和音频特征![]() 和

和![]() 进行元素级的相乘操作,得到初步的融合特征G,使得音频和视频特征在各个时间步的元素相互关联。然后,将音频和视频特征沿着时间维度进行拼接,形成记忆矩阵 M。M中包含了视、听两种模态的完整信息,为后续的多头注意力机制[33]实施提供了载体。最后,在融合特征G和记忆矩阵G之间应用多头注意力机制,通过查询矩阵Q、键矩阵K和值矩阵V的交互,提取音频和视频特征之间的深层次关系。

进行元素级的相乘操作,得到初步的融合特征G,使得音频和视频特征在各个时间步的元素相互关联。然后,将音频和视频特征沿着时间维度进行拼接,形成记忆矩阵 M。M中包含了视、听两种模态的完整信息,为后续的多头注意力机制[33]实施提供了载体。最后,在融合特征G和记忆矩阵G之间应用多头注意力机制,通过查询矩阵Q、键矩阵K和值矩阵V的交互,提取音频和视频特征之间的深层次关系。

(10)

式中:查询特征Q∈RT×dm为初步融合后的音频或图像融合特征G,而键值特征K,V∈R2×T×dm为在时间维度上音频和图像键值矩阵拼接后的记忆矩阵M,T 代表输入序列这个过程提供了图像和音频模态矩阵,dk 表示键值矩阵的维度。多头注意力融合模块如图10所示。

图10 多头注意力融合模块

Fig.10 Multi-head attention fusion module

2.2.5 分类和目标函数 CMBS模型将有监督的视听分类任务定义为两个子任务:一个涉及预测一个事件的类别标签![]() 而另一个涉及预测一个事件相关的分数

而另一个涉及预测一个事件相关的分数![]() 该分数用来判断t-th视频段中的视听事件是否一致。本文还应用了音频和视觉事件级背景门

该分数用来判断t-th视频段中的视听事件是否一致。本文还应用了音频和视觉事件级背景门![]() 和

和![]() 来抑制

来抑制![]() 中存在的噪声事件。

中存在的噪声事件。![]() 和

和![]() 可以计算为

可以计算为

(11)

(12)

(13)

式中:![]() 为来自Fo的最大池化结果,γ为超参数。CMBS模型需根据

为来自Fo的最大池化结果,γ为超参数。CMBS模型需根据![]() 值判断t-th视频段属于事件还是背景,因此需要将事件类别编号预测为C。此外,为了对时间级背景抑制门进行相应优化,CMBS模型将音频事件级背景门

值判断t-th视频段属于事件还是背景,因此需要将事件类别编号预测为C。此外,为了对时间级背景抑制门进行相应优化,CMBS模型将音频事件级背景门![]() 与视觉事件级背景门

与视觉事件级背景门![]() 相乘,得到视听事件级背景门

相乘,得到视听事件级背景门![]() 该门通过基于真实标签(ground truth,GT)的事件相关标签计算损耗并进行优化。最终,在训练过程中获得相应的GT事件类别和全监督设置下的相关标签。因此整体目标函数为

该门通过基于真实标签(ground truth,GT)的事件相关标签计算损耗并进行优化。最终,在训练过程中获得相应的GT事件类别和全监督设置下的相关标签。因此整体目标函数为

(14)

式中:Lc为预测![]() 与GT标签之间的事件类别交叉熵时的损失,

与GT标签之间的事件类别交叉熵时的损失,![]() 为预测

为预测![]() 与第t-th段GT标签之间的事件关联的二值交叉熵时的损失,

与第t-th段GT标签之间的事件关联的二值交叉熵时的损失,![]() 为gs门与第t-th段GT事件关联标签之间的二值交叉熵时的损失。在推理阶段,如果

为gs门与第t-th段GT事件关联标签之间的二值交叉熵时的损失。在推理阶段,如果![]() 那么第t-th个视频段被预测为

那么第t-th个视频段被预测为![]() 类;否则,第t-th个视频段被分类为背景。

类;否则,第t-th个视频段被分类为背景。

3 试验与结果分析

3.1 试验环境

所有试验均在Windows 11、64位系统环境下运行。Pytorch 版本为1.9.0、CUDA版本为10.2、计算机搭载的处理器为第九代IntelCorei5、显卡为GTX1660ti。

3.2 参数设置

试验过程中将斑石鲷、黄带拟鲹数据集按照6∶4划分为训练集和测试集,分别用于模型的训练和测试。模型的学习率设置为0.000 1,训练周期为100,训练批次设置为64,优化器为Adam,测试批次设置为16,其他参数设置为默认。

3.3 试验结果分析

经过200轮训练,最终模型测试输出的数据集A斑石鲷准确率为98.70%。数据集B黄带拟鲹音频去噪前准确率为84.20%,去噪后准确率为92.20%。

3.4 对比试验

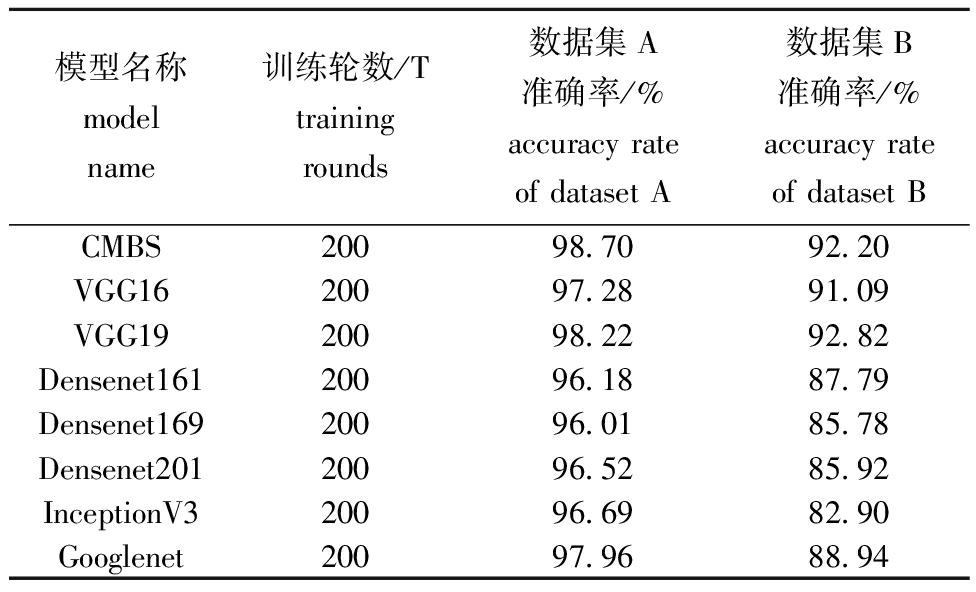

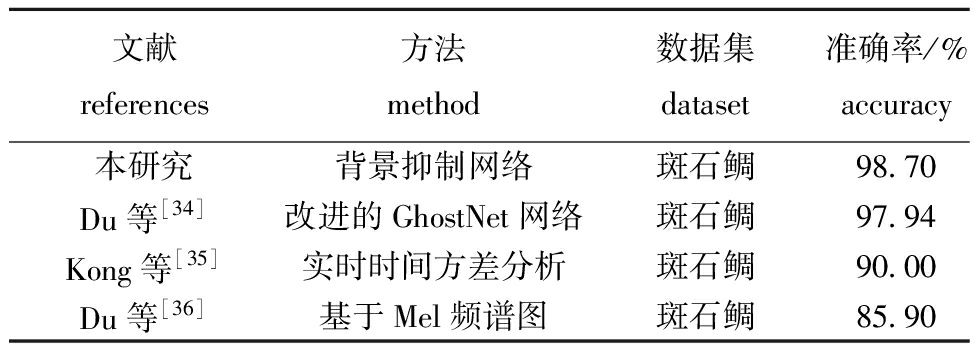

本文将数据集A在CMBS模型中预测的结果,分别与以下7种模型的测试结果进行了对比:VGG16、VGG19、Densenet161、Densenet169、Densenet201、Googlenet、inceptionV3,对比结果见表3。

表3 不同模型数据集鱼类摄食强度分类准确率

Tab.3 Classification accuracy of fish feeding intensity with different models of dataset

模型名称model name训练轮数/Ttraining rounds数据集A准确率/%accuracy rate of dataset A数据集B准确率/%accuracy rate of dataset BCMBS20098.7092.20VGG1620097.2891.09VGG1920098.2292.82Densenet16120096.1887.79Densenet16920096.0185.78Densenet20120096.5285.92InceptionV320096.6982.90Googlenet20097.9688.94

从表3可见,对于数据集A来说,基于多模态背景抑制机制的CMBS网络准确率达到了最优水平,VGG19网络的结果稍逊于CMBS网络,准确率只比CMBS低0.5个百分点。对于数据集B来说,因为真实环境下采集到的数据集B音频中含有大量的水流、机械等杂音,即使是去噪后的音频也会对分类结果造成一定影响,干扰CMBS模型的识别,导致CMBS模型的准确率略低于基于机器视觉的VGG19模型,但仍然高于其他的机器视觉模型。

本文所提出的方法与现有利用斑石鲷数据集进行摄食强度识别的其他技术进行了对比,见表4。从表4可见,背景抑制网络在识别准确率方面表现较为突出,达到了98.70%。

表4 基于斑石鲷数据集不同研究方法准确率对比

Tab.4 Comparison of accuracies of different research methods based on the Spotted Knifejaw dataset

文献references方法method数据集dataset准确率/%accuracy 本研究背景抑制网络斑石鲷98.70Du等[34]改进的GhostNet网络斑石鲷97.94Kong等[35]实时时间方差分析斑石鲷90.00Du等[36]基于Mel频谱图斑石鲷85.90

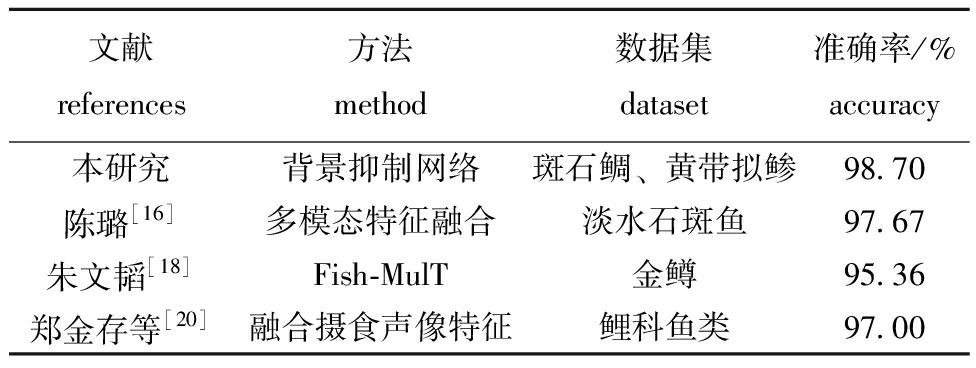

本文还同其他多模态鱼类摄食强度识别方法进行对比,对比结果见表5。

表5 多模态数据不同研究方法准确率对比

Tab.5 Comparison of accuracies of different research methods for multimodal data

文献references方法method数据集dataset准确率/%accuracy 本研究背景抑制网络斑石鲷、黄带拟鲹98.70陈璐[16]多模态特征融合淡水石斑鱼97.67朱文韬[18]Fish-MulT金鳟95.36郑金存等[20]融合摄食声像特征鲤科鱼类97.00

通过对比分析,可以发现背景抑制网络在鱼类摄食强度识别过程中展现出较高的准确性和鲁棒性。说明该网络能够有效地从复杂的背景中识别出鱼类摄食行为,为鱼类行为研究提供了一种新的技术手段。

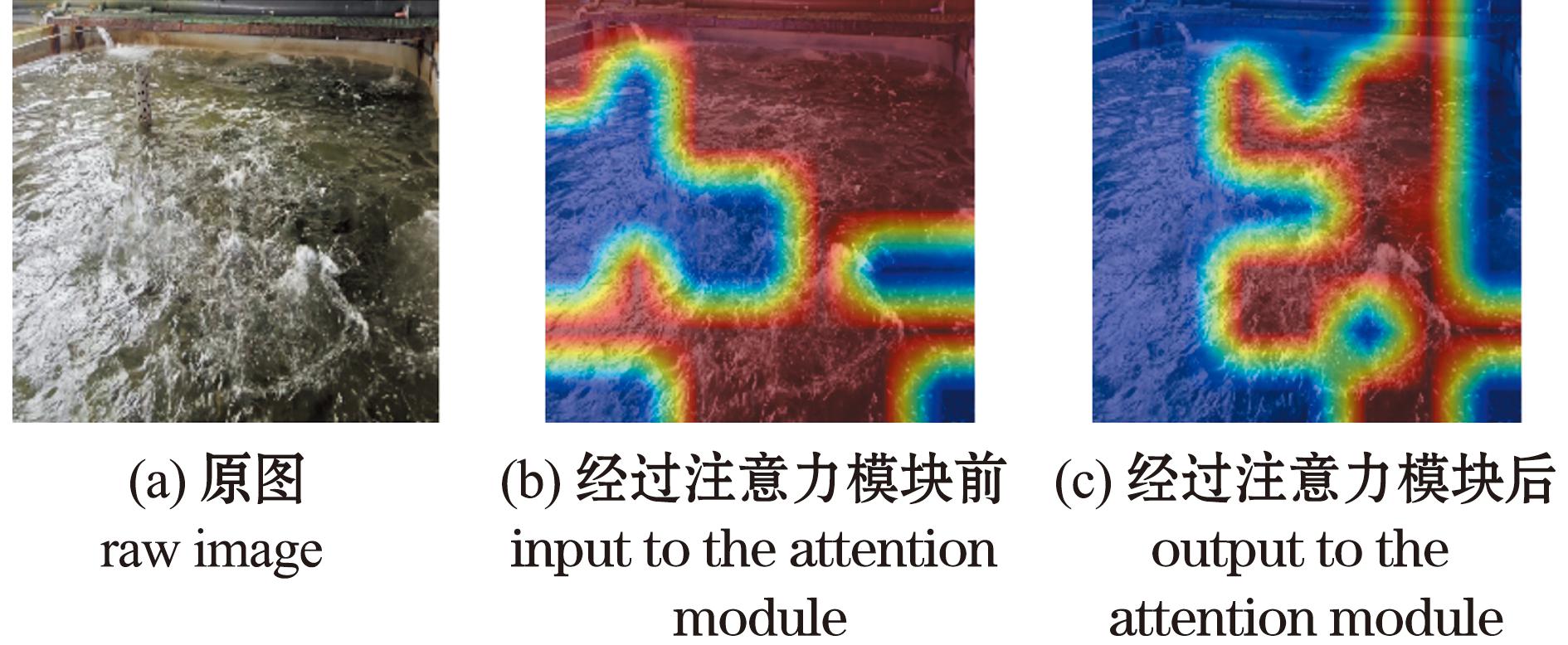

3.5 可视化分析

3.5.1 多模态协同注意力模块可视化分析 为展示多模态协同注意力模块减少噪声和不相关信息干扰的效果,本文通过梯度加权类激活映射(Gard-CAM)模块,将图像经过多模态协同注意力模块之前和之后的模型注意力权重图进行对比。从图11可见,在经过多模态协同注意力模块之前的模型注意力权重图包含了大量的边缘信息,包括石壁、出水口等,这些不相关的图像信息会对模型的分类造成一定干扰。而在经过多模态协同注意力模块之后,模型关注的重点转变为水面之上,可以提取到较多的鱼群、水花等作为摄食强度判别标准的特征。

图11 多模态协同注意力权重热力图

Fig.11 Multi modal collaborative attention weight heatmap

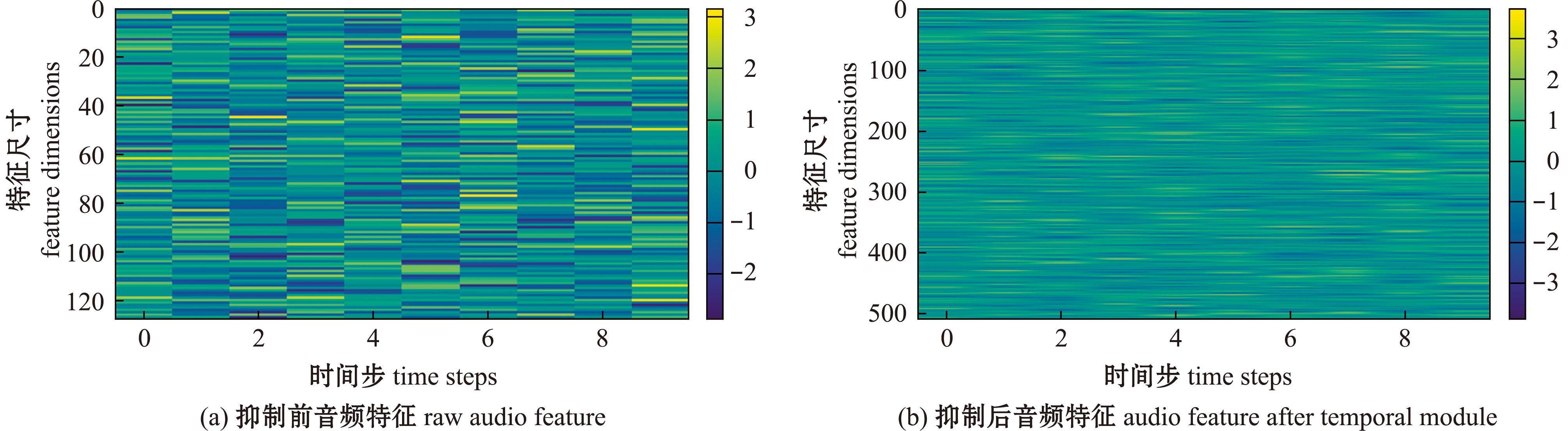

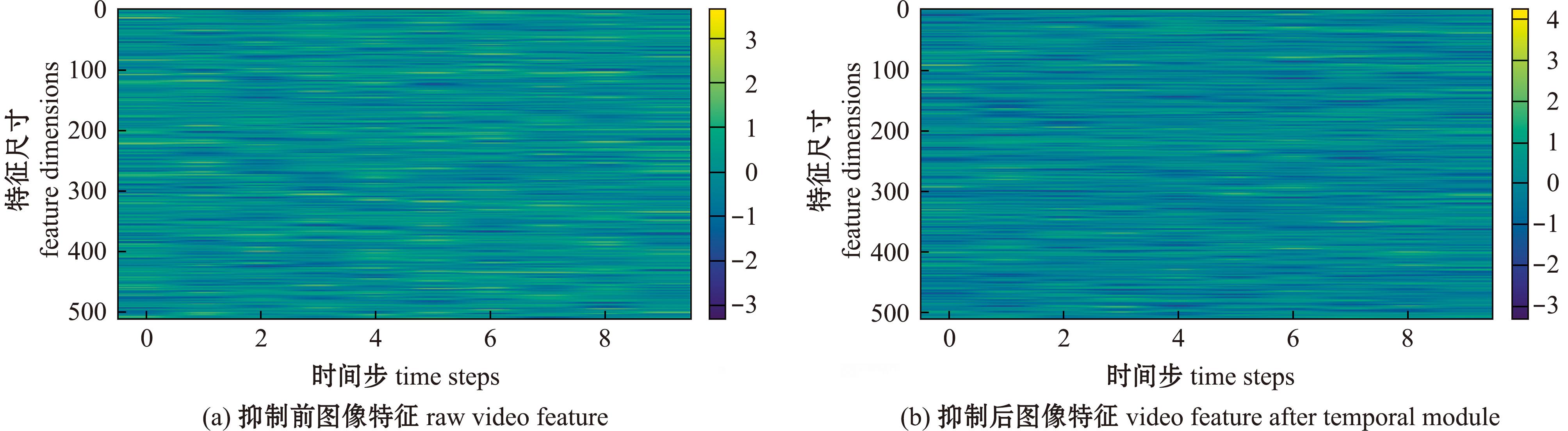

3.5.2 时间级背景抑制模块可视化分析 在时间级背景抑制模块特征图可视化过程中,本文采用了从黄色到紫色的渐变颜色映射表(viridis colormap)。在特征图中,颜色变化反映了模型在不同时间步之间分配的注意力权重的变化,其中,黄色表示较低关注程度,紫色表示较高关注程度。音频特征抑制前后对比如图12所示,在经过时间级背景抑制模块后,音频特征从128维映射成512维,提高了特征的表示能力,使得模型可以捕捉到更细微的特征差异,提高了数据的区分度。图13则展示了图像特征抑制前后的对比情况,抑制后的图像特征整体颜色变深,表明模型成功通过注意力机制和前馈网络增强了对重要信息的关注程度,达到了突出重要特征的效果。

图12 音频特征抑制前后对比

Fig.12 Comparison chart of audio features before and after suppression

图13 图像特征抑制前后对比

Fig.13 Comparison chart of image features before and after suppression

3.5.3 事件级背景抑制模块得分流程分析 在得到从时间级背景抑制模块传递过来的视觉和音频特征后,事件级背景抑制模块首先会通过一维卷积层来输出每个片段的分类分数。在得到每个片段的分类分数后,模型会通过Top-K分数汇总,从模型输出的分类分数中选择最有可能的类别。然后模型会将Top-K分数的均值相加并应用sigmoid激活函数以得到事件级门控。最后,将事件级背景门与最终预测结果相乘,抑制那些只在某一种模态中发生概率较高的事件,从而提高模型对于复杂场景和混合声音的区分能力。具体类别分数变化流程如图14所示。

图14 类别分数变化流程

Fig.14 Flowchart of category score changes

4 结论

1)多模态背景抑制网络(CMBS)利用跨模态门控注意力引导聚焦视觉特征,通过时间级背景抑制实现模态间时间维度互关注,并借助事件级背景抑制单模态突发噪音,提升分类性能。

2)多模态背景抑制网络(CMBS)在鱼类摄食行为分类任务上表现优异,试验环境准确率达98.7%,显著优于主流单模态模型;在复杂真实环境(背景杂音、昏暗光线)下准确率也达92.2%。

3)相对于其他的多模态模型,CMBS网络的双模态的背景抑制模块,提高了模型在复杂环境下的鲁棒性,但过大的单一模块突发性噪音还是会对最终的分类结果产生影响,下一步的研究中需要进一步优化模型的结构,抑制背景噪音,向实时监测鱼类摄食行为方向发展。

[1] 张宇雷,倪琦,刘晃,等.挪威大西洋鲑鱼工业化养殖现状及对中国的启示[J].农业工程学报,2020,36(8):310-315.

ZHANG Y L,NI Q,LIU H,et al.Status quo of industrialized aquaculture of Atlantic salmon in Norway and its implications for China[J].Transactions of the Chinese Society of Agricultural Engineering,2020,36(8):310-315.(in Chinese)

[2] 乔峰,郑堤,胡利永,等.基于机器视觉实时决策的智能投饵系统研究[J].工程设计学报,2015,22(6):528-533.

QIAO F,ZHENG D,HU L Y,et al.Research on smart bait casting machine based on machine vision technology[J].Chinese Journal of Engineering Design,2015,22(6):528-533.(in Chinese)

[3] LI D L,WANG Z H,WU S Y,et al.Automatic recognition methods of fish feeding behavior in aquaculture:a review[J].Aquaculture,2020,528:735508.

[4] BARRAZA-GUARDADO R H,MART NEZ-C

NEZ-C RDOVA L R,ENR

RDOVA L R,ENR QUEZ-OCA

QUEZ-OCA A L F,et al.Effect of shrimp farm effluent on water and sediment quality parameters off the coast of Sonora,Mexico[J].Ciencias Marinas,2014,40(4):221-235.

A L F,et al.Effect of shrimp farm effluent on water and sediment quality parameters off the coast of Sonora,Mexico[J].Ciencias Marinas,2014,40(4):221-235.

[5] SAIZ N,G MEZ-BORONAT M,DE PEDRO N,et al.The lack of light-dark and feeding-fasting cycles alters temporal events in the goldfish (Carassius auratus) stress axis[J].Animals,2021,11(3):669.

MEZ-BORONAT M,DE PEDRO N,et al.The lack of light-dark and feeding-fasting cycles alters temporal events in the goldfish (Carassius auratus) stress axis[J].Animals,2021,11(3):669.

[6] 唐宸,徐立鸿,刘世晶.基于光流法的鱼群摄食状态细粒度分类算法[J].农业工程学报,2021,37(9):238-244.

TANG C,XU L H,LIU S J.Fine-grained classification algorithm of fish feeding state based on optical flow method[J].Transactions of the Chinese Society of Agricultural Engineering,2021,37(9):238-244.(in Chinese)

[7] UBINA N,CHENG S C,CHANG C C,et al.Evaluating fish feeding intensity in aquaculture with convolutional neural networks[J].Aquacultural Engineering,2021,94:102178.

[8] 冯双星,王丁弘,潘良,等.基于轻量型 S3D 算法的鱼类摄食强度识别系统设计与试验[J].渔业现代化,2023,50(3):79-86.

FENG S X,WANG D H,PAN L,et al.Implementation of fish feeding intensity identification system using light- weight S3D algorithm[J].Fishery Modernization,2023,50(3):79-86.(in Chinese)

[9] YANG L,YU HH,CHENG Y L,et al.A dual attention network based on efficientNet-B2 for short-term fish school feeding behavior analysis in aquaculture[J].Computers and Electronics in Agriculture,2021,187:106316.

[10] 陈明,张重阳,冯国富,等.基于特征加权融合的鱼类摄食活动强度评估方法[J].农业机械学报,20 20,51(2):245-253.

CHEN M,ZHANG C Y,FENG G F,et al.Intensity assessment method of fish feeding activities based on feature weighted fusion[J].Transactions of the Chinese Society for Agricultural Machinery,2020,51(2):245-253.(in Chinese)

[11] 陈雨琦,冯德军,桂福坤,等.采用机器视觉和傅里叶频谱特征的循环水养殖鱼类摄食状态判别[J].农业工程学报,2021,37(14):155-162.

CHEN Y Q,FENG D J,GUI F K,et al.Discrimination of the feeding status of recirculating aquaculture fish via machine vision and reflective corrugated Fourier spectrum[J].Transactions of the Chinese Society of Agricultural Engineering,2021,37(14):155-162.(in Chinese)

[12] 曹晓慧,刘晃,戚仁宇,等.循环水养殖大口黑鲈摄食颗粒饲料的声学特征[J].农业工程学报,2021,37(20):219-225.

CAO X H,LIU H,QI R Y,et al.Acoustic characteristics of the feeding pellets for Micropterus salmoides in circulating aquaculture[J].Transactions of the Chinese Society of Agricultural Engineering,2021,37(20):219-225.(in Chinese)

[13] WU T H,HUANG Y I,CHEN J M.Development of an adaptive neural-based fuzzy inference system for feeding decision-making assessment in silver perch (Bidyanus bidyanus) culture[J].Aquacultural Engineering,2015,66:41-51.

[14] ZENG Y H,YANG X T,PAN L,et al.Fish school feeding behavior quantification using acoustic signal and improved Swin Transformer[J].Computers and Electronics in Agriculture,2023,204:107580.

[15] 胡学龙,朱文韬,杨信廷,等.基于水质-声音-视觉融合的循环水养殖鱼类摄食强度识别[J].农业工程学报,2023,39(10):141-150.

HU X L,ZHU W T,YANG X T,et al.Identification of feeding intensity in recirculating aquaculture fish using water quality-sound-vision fusion[J].Transactions of the Chinese Society of Agricultural Engineering,2023,39(10):141-150.(in Chinese)

[16] 陈璐.基于多模态融合的鱼群摄食活跃度检测与识别方法研究[D].厦门:厦门大学,2022.

CHEN L.Research on the detection and recognition methods of fish feeding activity based on multimodal fusion[D].Xiamen:Xiamen University,2022.(in Chinese)

[17] 胥婧雯,于红,张鹏,等.基于声音与视觉特征多级融合的鱼类行为识别模型U-FusionNet-ResNet50+SENet[J].大连海洋大学学报,2023,38(2):348-356.

XU J W,YU H,ZHANG P,et al.A fish behavior recognition model based on multi-level fusion of sound and vision U-fusionNet-ResNet50+SENet[J].Journal of Dalian Ocean University,2023,38(2):348-356.(in Chinese)

[18] 朱文韬.基于多模态融合的鱼类摄食强度分类研究与实现[D].扬州:扬州大学,2023.

ZHU W T.Research and implementation of fish feeding intensity classification based on multimodal fusion[D].Yangzhou:Yangzhou University,2023.(in Chinese)

[19] 曾昱皓.基于声音和图像分析的鱼群智能投喂控制装置研究与开发[D].镇江:江苏大学,2023.

ZENG Y H.Research and development of intelligent feeding control device for fish swarm based on sound and image analysis[D].Zhenjiang:Jiangsu University,2023.(in Chinese)

[20] 郑金存,叶章颖,赵建,等.融合摄食过程声像特征的鱼类摄食强度量化方法研究[J].海洋与湖沼,2024,55(3):577-588.

ZHENG J C,YE Z Y,ZHAO J,et al.Sensitive detection of fish feeding intensitu by using sound and image features of feeding process[J].Oceanologia Et Limnologia Sinica,2024,55(3):577-588.(in Chinese)

[21] LIN Y-B,LI Y J,WANG Y F.Dual-modality Seq2Seq network for audio-visual event localization[C]//ICASSP 2019-2019 IEEE International Conference on Acoustics,Speech and Signal Processing (ICASSP).May 12-17,2019.Brighton,United Kingdom.IEEE,2019:2002-2006.

[22] TIAN Y P,SHI J,LI B C,et al.Audio-visual event localization in unconstrained videos[M]//Computer Vision-ECCV 2018.Cham:Springer International Publishing,2018:252-268.

[23] DUAN B,TANG H,WANG W,et al.Audio-visual event localization via recursive fusion by joint co-attention[C]//2021 IEEE Winter Conference on Applications of Computer Vision (WACV).January 3-8,2021.Waikoloa,HI,USA.IEEE,2021:4013-4022.

[24] WU Y,ZHU L C,YAN Y,et al.Dual attention matching for audio-visual event localization[C]//2019 IEEE/CVF International Conference on Computer Vision (ICCV).October 27-November 2,2019.Seoul,Korea (South).IEEE,2019:6292-6300.

[25] XUAN H Y,ZHANG Z Y,CHEN S,et al.Cross-modal attention network for temporal inconsistent audio-visual event localization[J].Proceedings of the AAAI Conference on Artificial Intelligence,2020,34(1):279-286.

[26] 陈涛涛.基于深度学习的生猪价格与产量预测模型研究[D].武汉:华中农业大学,2020.

CHEN T T.Study on the forecast model of pig price and yield based on deep learning[D].Wuhan:Huazhong Agricultural University,2020.(in Chinese)

[27] XIA Y,ZHAO Z.Cross-modal background suppression for audio-visual event localization[C]//2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).June 18-24,2022,New Orleans,LA,USA.IEEE,2022:19957-19966.

[28] CUI M,LIU X B,ZHAO J Z,et al.Fish feeding intensity assessment in aquaculture:a new audio dataset AFFIA3K and a deep learning algorithm[C]//2022 IEEE 32nd International Workshop on Machine Learning for Signal Processing (MLSP).August 22-25,2022,Xi’an,China.IEEE,2022:1-6.

[29] 李道亮,杜壮壮,王聪,等.多模态融合的鱼群摄食强度分类方法、系统、设备及介质:CN118097391A[P].2024-05-28.

LI D L,DU Z Z,WANG C,et al.A multimodal fusion-based method, system, device and medium for classifying fish feeding intensity:CN118097391A[P].2024-05-28.(in Chinese)

[30] HERSHEY S,CHAUDHURI S,ELLIS D P W,et al.CNN architectures for large-scale audio classification[C]//2017 IEEE International Conference on Acoustics,Speech and Signal Processing (ICASSP).March 5-9,2017,New Orleans,LA,USA.IEEE,2017:131-135.

[31] HU J,SHEN L,SUN G.Squeeze-and-excitation networks[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition.June 18-23,2018,Salt Lake City,UT,USA.IEEE,2018:7132-7141.

[32] XU H M,ZENG R H,WU Q Y,et al.Cross-modal relation-aware networks for audio-visual event localization[C]//Proceedings of the 28th ACM International Conference on Multimedia.Seattle WA USA.ACM,2020:3893-3901.

[33] CORDONNIER J B,LOUKAS A,JAGGI M.Multi-head attention:collaborate instead of concatenate[EB/OL].2020:2006.16362.https://arxiv.org/abs/2006.16362v2.

[34] DU Z Z,XU X B,BAI Z Z,et al.Feature fusion strategy and improved Ghost Net for accurate recognition of fish feeding behavior[J].Computers and Electronics in Agriculture,2023,214:108310.

[35] KONG H,WU J F,LIANG X L,et al.Conceptual validation of high-precision fish feeding behavior recognition using semantic segmentation and real-time temporal variance analysis for aquaculture[J].Biomimetics,2024,9(12):730.

[36] DU Z Z,CUI M,WANG Q,et al.Feeding intensity assessment of aquaculture fish using Mel Spectrogram and deep learning algorithms[J].Aquacultural Engineering,2023,102:102345.