鱼类作为海洋生态系统不可或缺的组成部分,对其精准识别可以帮助人类探究海洋生物多样性和评估海域环境健康程度。然而水下环境存在光照条件不佳、复杂背景干扰等众多不利因素[1-2]。鱼类在水下活动,不同种类之间又具有相似性和相互遮挡等问题[3]。利用传统机器学习算法检测鱼类目标,在一定程度上摆脱了对人类肉眼判别的依赖,可通过人工设计的定向梯度直方图(histogram of oriented gradients,HOG)、尺度不变特征变换(scale-Invariant feature transform,SIFT)等算法进行图像特征提取,并结合支持定量机(support vector machine,SVM)、K最临近算法(K-nearest neighbors,KNN)等分类器进行分类。但这些传统机器学习方法仅适用于特定场景,且泛化能力较差,冗余计算较多,不能满足多场景复杂识别的需求[4-7]。

近年来,随着深度学习与卷积神经网络的不断优化,鱼类识别相关研究也得到了极大的发展,其中,Ben等[8]提出将相同的分类器与多个Faster R-CNN相结合,构建了多渠道融合结构,该改进方法能够将不同渠道的特征信息与运动信息融合,以达到提升鱼类检测精度的目的,最终识别准确率达到了73.69%。Li等[9]构建了一个用于识别水下鱼群的CME-YOLO v5模型,该模型在YOLO v5的基础上将协调注意力机制和跨阶段模块结合作为新的主干,同时,通过增加检测头的数量并优化损失函数实现对鱼类识别性能的提升。Knausgård等[10]通过将Squeeze-and-Excitation模块及迁移学习应用于YOLOv3模型,提出了一种能够准确识别温带鱼类个体目标的改进方法。闫党康[11]提出在Mask R-CNN的基础上引入改进的Soft NMS、级联结构和残差网络,以提升模型对鱼类特征的学习能力和判别能力,相关对比试验表明,该方法识别准确率提升了3.6%。Yu等[12]提出了在YOLOv7模型基础上引入双层注意力和协调注意力模块,侧重对多尺度目标特征和空间特征的学习,最终实现了特定场景下水下鱼类目标检测的目的。王伟芳等[13]提出在YOLOv5模型的基础上采用MobileNet-v1与Leaky ReLU作为主干和激活函数用于提取鱼类特征,试验数据表明,该改进模型在鱼类个体识别中能够提升准确率。王海燕等[14]提出了一种基于ResNet-50的鱼类识别方法,该方法联合多种损失函数构建了全局损失函数,再结合迁移学习训练模型,最后通过对比试验验证了该模型在简单环境下鱼类识别中的有效性。

通过上述研究现状可知,目前的改进模型在处理简单环境下的单一鱼类个体或非密集鱼群时能够取得较好的识别效果。但当面临复杂环境中水下鱼类识别时,上述检测模型会出现较多的漏识别和错误识别。与地面识别相比,水下环境通常光照条件较差,导致图像中对比度低、颜色失真,甚至出现模糊。现有的识别网络往往依赖于清晰的图像提取和识别,在水下场景中,这些模型大多由于光照不足或模糊影响而无法提取到足够的鱼类特征,从而降低识别精度。此外,水下环境中的鱼类往往具有与背景(如珊瑚、岩石等)相似的颜色或纹理,尤其是在复杂的背景下,鱼类容易与背景融合,导致现有模型难以准确区分鱼类和背景目标。

因此,本文提出了基于深度细微特征提取的识别模型。该模型在YOLOv8的基础上,采用可变形卷积DCN(deformable convolutional networks)v4替换传统卷积,构建增强型模块E-DCN(enhanced deformable convolutional networks)进行深度细微特征提取,同时将CIoU(complete intersection over union)替换为Shape-IoU(shape intersection over union)用于鱼类目标位置判定。针对水下鱼类识别中鱼类姿态多样性和视觉模糊等问题,E-DCN模块通过可变形卷积运算动态调整卷积核的位置和形状,可更有效地适应鱼类姿态变化,从而精确捕捉鱼类的细节特征。此外,可变形卷积能够根据输入特征图的不同局部区域自适应地调整卷积核的位置和形态,以增强对鱼类目标空间变化的适应能力。Shape-IoU算法通过引入鱼类目标的形状特征,能更准确地描述鱼类的轮廓和细节,显著提升了水下目标检测的性能。该算法不仅关注鱼类定位,还充分利用形状特征进行识别。通过优化目标的几何结构与检测框拟合度,提高鱼类识别的准确性,最终实现水下复杂环境中不同鱼类的精准识别。

1 YOLOv8识别网络

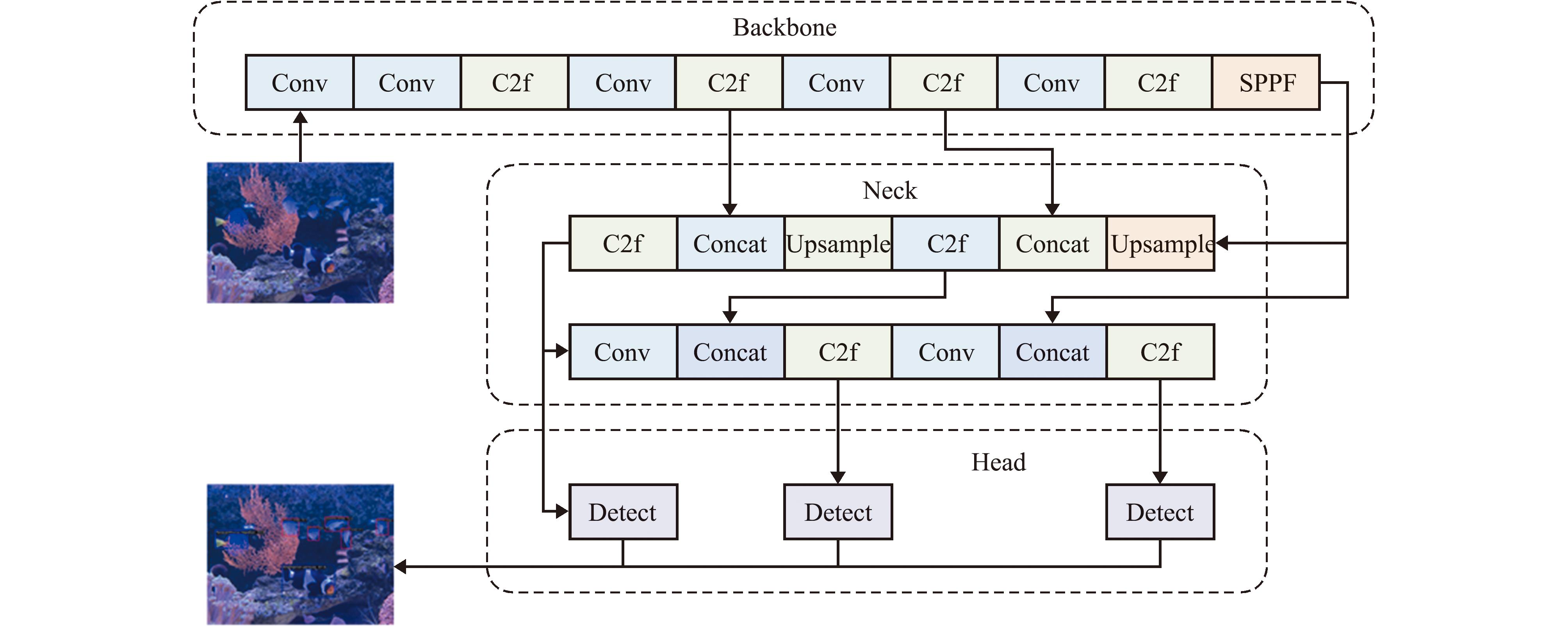

YOLOv8的结构框架如图1所示,该模型由3个主要部分构成:主干(backbone)、颈部(neck)和头部(head)[15-16],每张鱼类图像均依次经过主干、颈部和头部进行训练。主干由Conv、C2f和SPFF(spatial pyramid pooling fast)模块构成,负责从输入图像中提取特征,包括鱼类目标的边缘、纹理和形状信息。其中,Conv模块包含普通卷积操作(conv2d)、批量归一化(batch normalization,BN)和SiLu激活函数。C2f模块采用梯度并联连接形式,加强特征提取能力及特征图间的融合。SPPF模块通过3个最大池化操作生成不同尺寸的特征图,并以残差方式融合这些特征图。

Conv为卷积模块;C2f为梯度并联连接模块;SPPF为空间金字塔池化模块;Concat为连接模块;Upsample为上采样模块;Detect为检测模块。下同。

Conv,convolution block;C2f,gradient-parallel connection block;SPPF,spatial pyramid pooling block;Concat,concatenation block;Upsample,upsampling block;Detect,detection block,et sequential.

图1 YOLOv8的结构框架

Fig.1 Structural framework of YOLOv8

颈部采用多个C2f模块对主干输出的鱼类特征进行上、下采样融合,进而提升特征表征能力。具体而言,该部分从输入特征图中提取关键特征,并构建特征金字塔,以强化目标特征的学习能力。通过自顶向下和自底向上的特征融合,模型能够更有效地检测不同尺寸的鱼类目标。头部设计为解耦结构,解耦设计为不同的检测尺度提供独立的检测器,每个检测器利用一组卷积运算和全连接的结构预测该尺度上的鱼类边界框。

2 改进的识别方法

2.1 改进的细微特征提取算法

为满足在水下复杂环境中对不同鱼类的精准识别,需要识别模型对鱼类细微特征进行有效学习。这就要求模型能够尽可能提取鱼类细小、模糊且不规则的特征。因此,所提出在模型主干中采用可变形卷积运算动态调整感受野形状,从而提高处理细微且不规则鱼类特征的准确性。

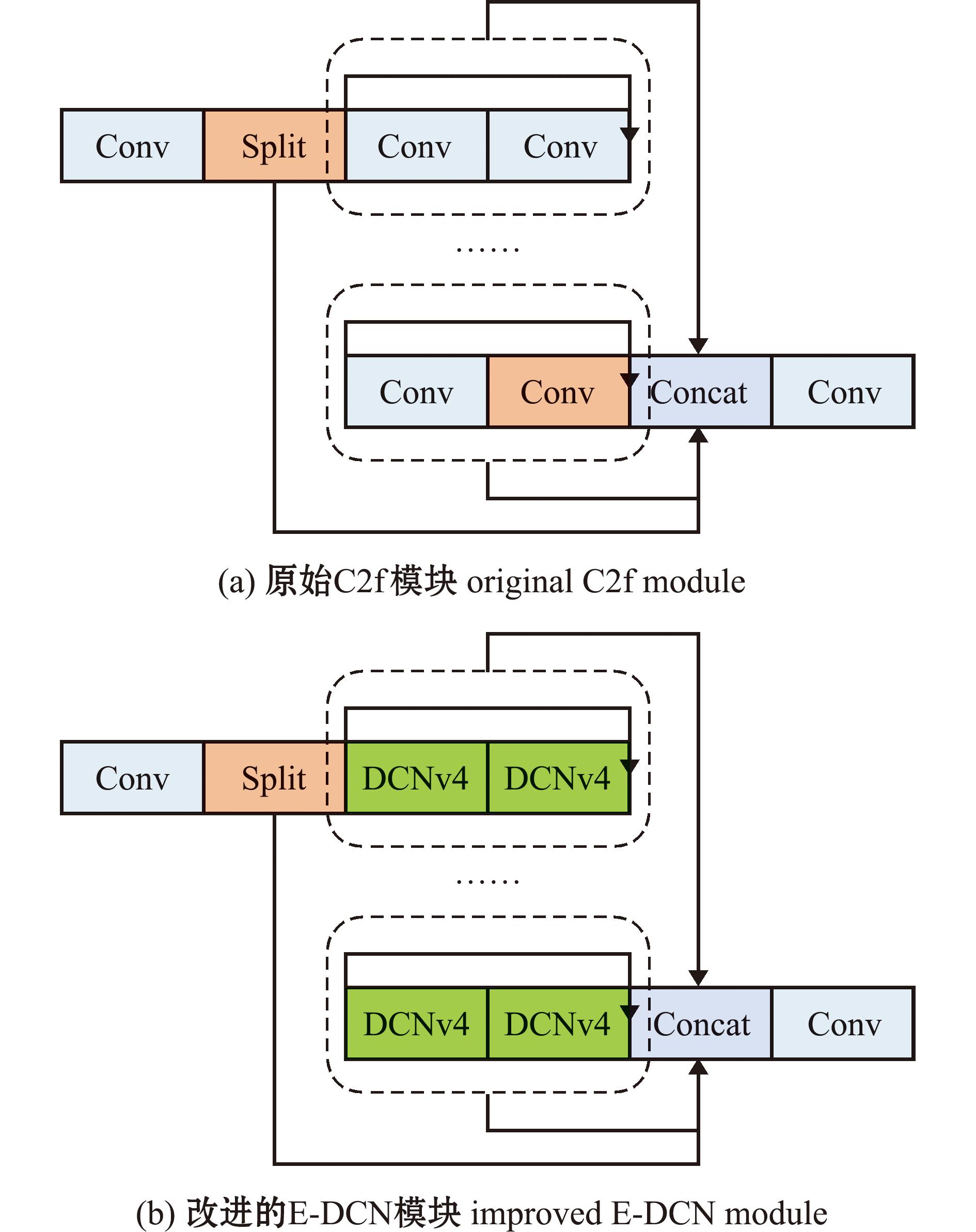

从图2可见,本文将C2f模块中负责深度特征提取的卷积模块Conv替换为DCNv4,同时保留残差连接形式,构成改进的E-DCN模块用于细微特征提取。DCNv4不仅可以增强动态变换和表达能力,还通过共享偏移和权重加快模型的收敛速度[17]。改进算法首先将输入的特征图划分为多个分组,每个分组的特征图经过卷操作提取特征,以获得相应的调整因子和卷积核偏移。DCNv4通过学习每个卷积核位置的偏移量,实现自适应形状调整。偏移量在训练过程中自动学习,允许识别网络根据目标和输入特征动态调整卷积核的布局。通过适应输入特征中的形变,DCNv4可以更准确地捕捉细微且不规则的特征。最终,经过计算的特征图叠加形成输出特征。

图2 原始C2f模块与改进的E-DCN模块结构

Fig.2 Structure diagram of the original C2f module and the improved E-DCN module

假设输入的特征图为(H,W,C),其中H、W、C分别代表特征图的高度、宽度、通道数,S、Q分别表示采样点总数、分组个数,则DCNv4的计算公式表示为

(1)

output=concat(|y1,y2,…,yQ|,axis=-1)。

(2)

式中:xq和yq分别代表以(H,W,C/Q)进行分组后的输入和输出特征;P0表示当前像素点,Ps表示第s个预定义采样点的位置;Δpqs表示根据ps在第q个分组中的位置偏移;mqs表示第q个分组中的第s个采样点的调整标量。

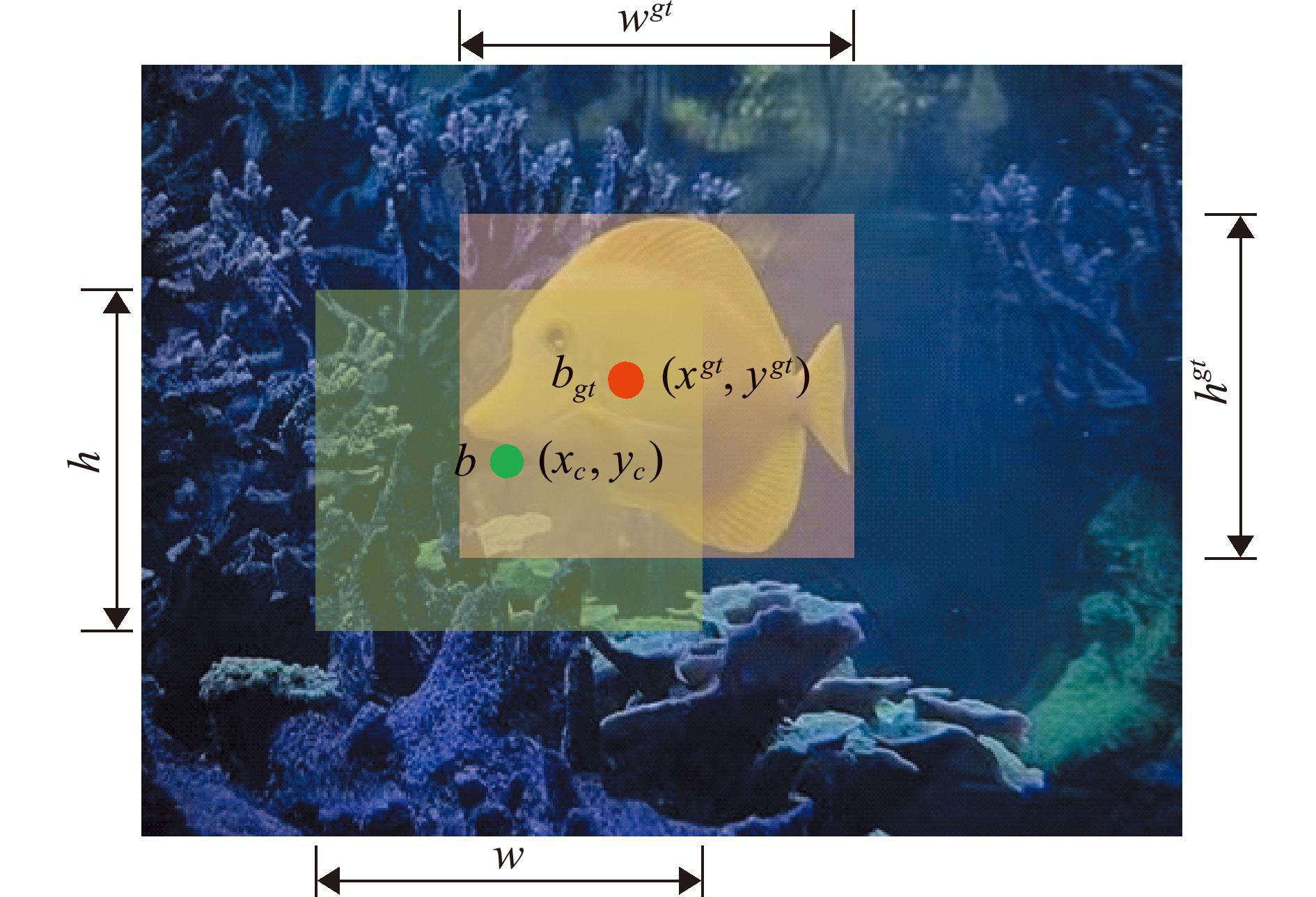

2.2 改进的边界框回归算法

边界框回归在水下鱼类识别中同样起着重要作用。通过优化回归算法,识别模型可以学习预测边界框的位置和大小,从而更准确地定位鱼类目标在图像中的位置。与原模型的CIoU相比,Shape-IoU在计算重叠度时不仅考虑边界框的交并比,还可结合边界框的形状特征,更好地反映边界框之间的实际相似度[18]。同时,该改进算法在处理不同大小和长宽比的鱼类边界框时,能够有效减少因鱼类规格变化带来的误差。Shape-IoU原理如图3所示。

图3 Shape-IoU原理

Fig.3 Schematic diagram of Shape IoU

假设水下鱼类目标的真实边界框的中心为bgt (xgt,ygt),预测边界框的中心为b(xc,yc),则用于衡量预测边界框和真实边界框之间的形状差异dshape可以表示为

IoU=|B∩Bgt|/|B∪Bgt|,

(3)

ww=2(wgt)scale/[(wgt)scale+(hgt)scale],

(4)

hh=2(hgt)scale/[(wgt)scale+(hgt)scale],

(5)

dshape=hh(xc-xgt)2/c2+ww(yc-ygt)2/c2。

(6)

式中:B和Bgt分别代表预测边界框和真实边界框;wgt和hgt分别表示真实边界框的宽度和高度;c表示用于规范化的常数。最终边界框回归算法Lshape-IoU的计算公式可以表示为

ww=hh|w-wgt|/max(w,wgt),

(7)

wh=ww|h-hgt|/max(h,hgt),

(8)

(9)

Lshape-IoU=1-IoU+dshape+0.5Ωshape。

(10)

式中:w和h分别表示预测边界框的宽度和高度;hh和ww分别表示真实边界框的高度和宽度的权重系数;wt为计算中宽度和高度差异度的权重。该改进算法能够更精确地处理边界框的形状差异,特别是在鱼类目标具有显著形状特征的情况下,能够提高检测精度,从而更好地适应水下复杂场景中鱼类目标的位置判断。

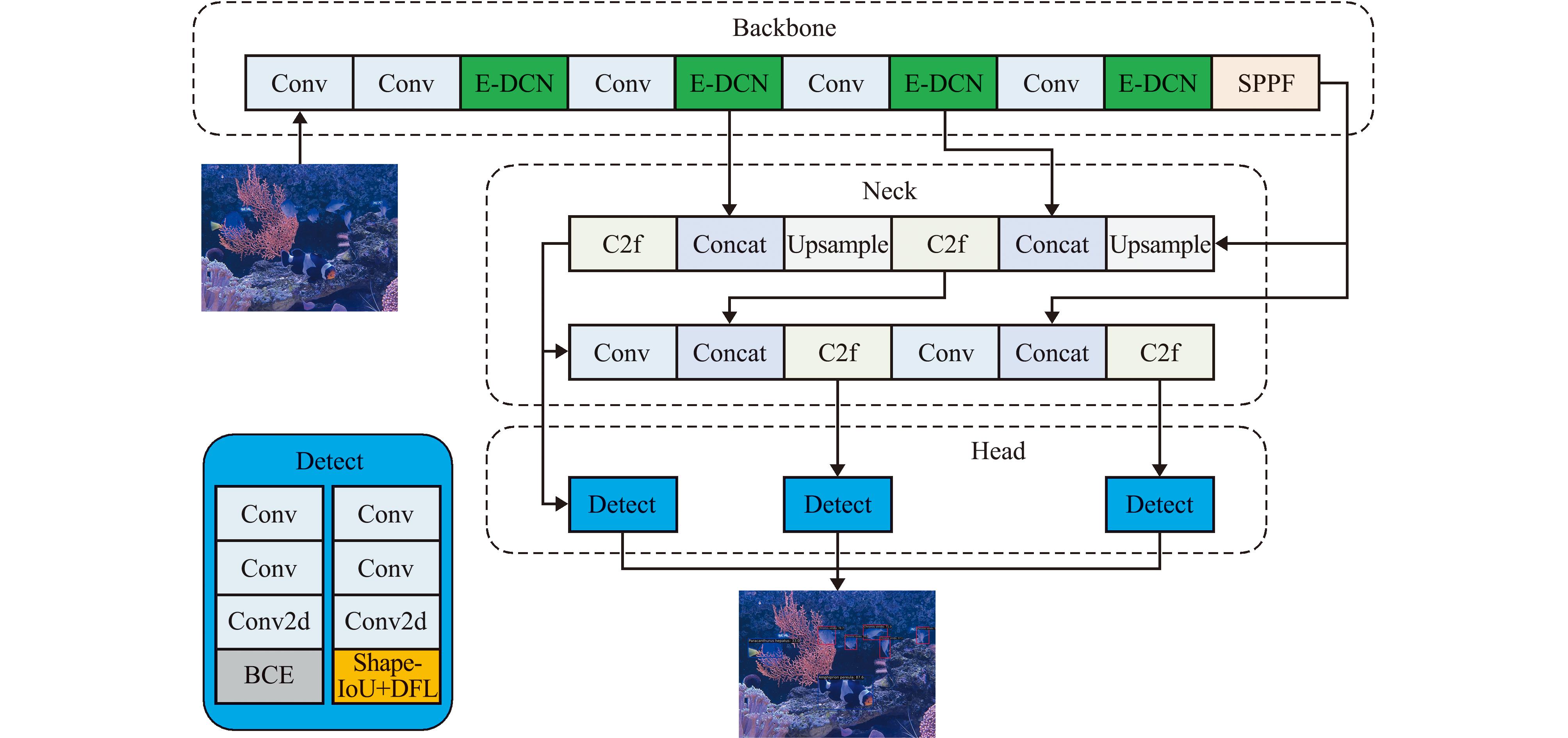

2.3 基于深度细微特征提取的模型

本文提出的该识别模型DFFE-Net如图4所示。主干部分针对细微特征提取采用改进的E-DCN模块,用于粗特征提取及连接多个E-DCN模块的部分仍采用Conv模块。E-DCN模块通过学习偏移量,使卷积核的采样位置和形状能够根据不同鱼类目标特征动态调整,从而更有效地捕捉鱼类的形变特征,增强DFFE-Net的特征表达能力,并提升其在水下复杂场景中对鱼类的识别性能。

Conv2d为普通卷积操作;E-DCN为改进的细微特征提取模块;BCE为二元交叉熵函数;Shape-IoU+DFL为Shape-IoU与分布焦点损失函数。

Conv2d,the standard convolution operation;E-DCN,the improved fine feature extraction module;BCE,the binary cross-entropy function;Shape-IoU+DFL,Shape-IoU and focal loss function.

图4 基于深度细微特征提取的模型

Fig.4 Model based on deep subtle feature extraction

在头部部分,选取Shape-IoU替代CIoU作为边界框回归算法,同时保留分布焦点损失(distribution focal loss,DFL)实现边界框回归,并利用二元交叉熵(binary cross entropy,BCE)完成目标分类任务。相比CIoU,Shape-IoU在评估边界框形状相似性方面表现更优,在处理具有复杂和多变外形的水下鱼类时,能够实现更加精准的识别与定位。

3 试验与结果分析

3.1 数据集与试验环境

本文的图像数据采集于海南省三亚市鹿回头半岛的南边海实验场,利用1 200万像素的图像采集设备在天气晴朗和多云的条件下对试验区域水下4 m内的场景进行多角度拍摄。采集的目标鱼类包括:黑鳃刺尾鱼(Acanthurus pyroferus)、公子小丑鱼(Amphiprion ocellaris)、黑豹小丑鱼(Amphiprion pereula)、蓝绿光鳃鱼(Chromis viridis)、陶波金翅雀鲷(Chrysiptera taupou)、宅泥鱼(Dascyllus aruanus)、多鳞霞蝶鱼(Hemitaurichthys polylepis)、黄尾副刺尾鱼(Paracanthurus hepatus)、透红小丑鱼(Premnas biaculeatus)和黄高鳍刺尾鱼(Zebrasoma flavescens)10种鱼类。同时,为了确保创建的数据集中包含不同尺寸且丰富的鱼类目标,采用剪切、缩放和旋转等图像增强技术扩展数据集。最终,自建数据集包含4 270张水下图像,并且随机选取数据集中80%的图像用于训练,剩余20%的图像用于测试,水下鱼类数据集样本示例如图5所示。

图5 水下鱼类数据集样本示例

Fig.5 Samples in the underwater fish dataset

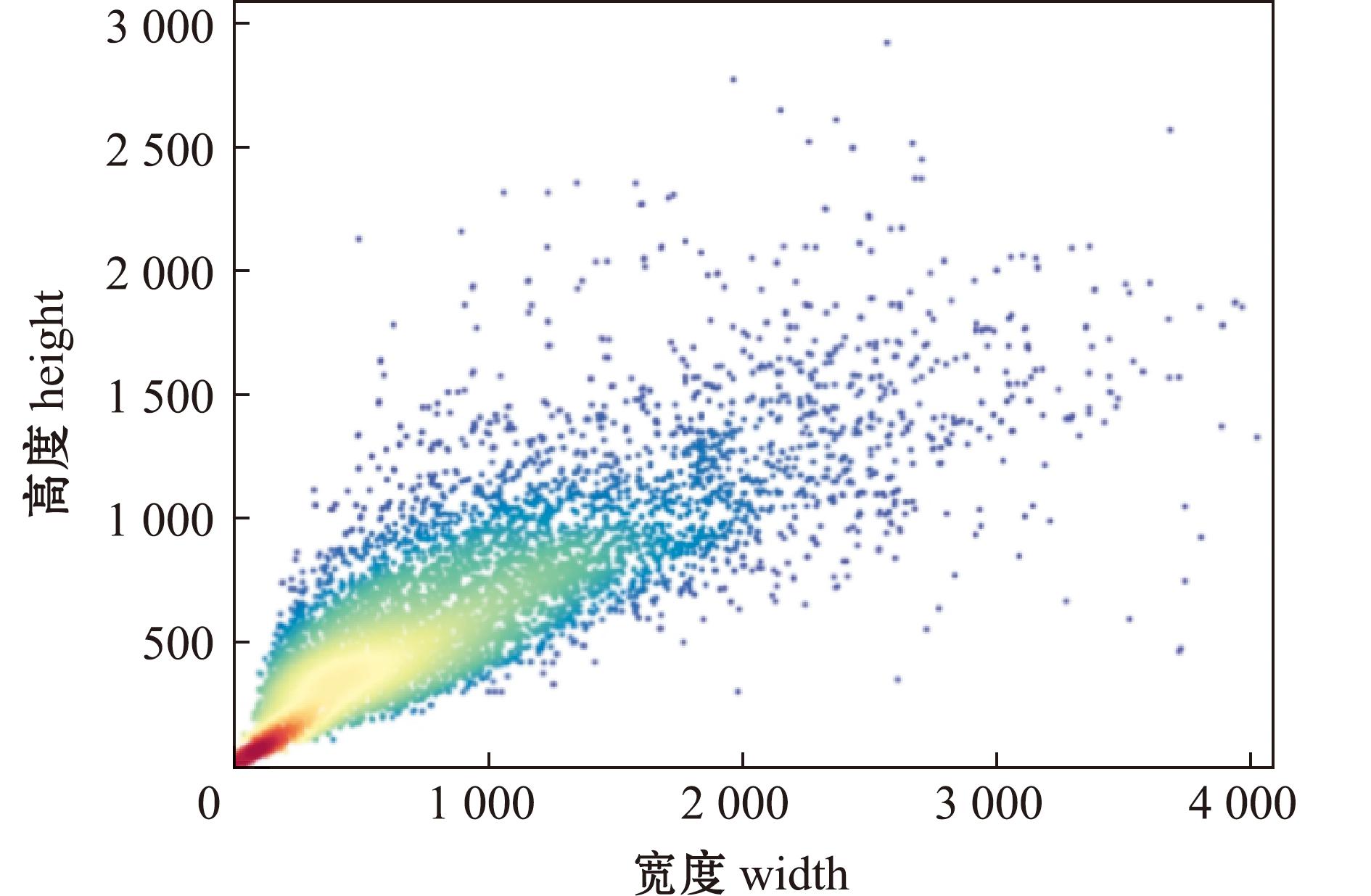

数据集中水下鱼类图像的宽度和高度散点如图6所示,图中每个点代表一个图像样本。从图6可见,样本点的散布范围较广,表明数据集中的图像样本在尺寸上有较大的变化。样本点主要集中在图的左下角区域,即主要分布在宽度为0~1 000像素,高度为0~500像素,并且随着宽度和高度的增加,数据点逐渐稀疏。此外,图中使用颜色渐变来表示样本点的密集程度,从密集的红色逐渐过渡到黄色、绿色,最后到稀疏的蓝色。这种分布表明,数据集中的大多数水下样本鱼类图像规格较小,只有少量样本规格较大。

图6 鱼类图像的宽度和高度散点图

Fig.6 Scatter plot of width and height of fish images

本研究的试验环境采用12 GB RTX3060 GPU、PyTorch v1.10框架、Python 3.7解释器和PyCharm开发环境。为了确保试验的科学性和稳定性,依据YOLOv8基础架构参数设置和数据样本特点,在训练阶段BN设置为4,epoch设置为100。选择YOLOv8默认初始学习率0.01,通过将权重衰减设置为0.000 5以防止模型训练初期出现震荡,并将动量设置为0.937以加快模型收敛。

3.2 改进算法的对比试验

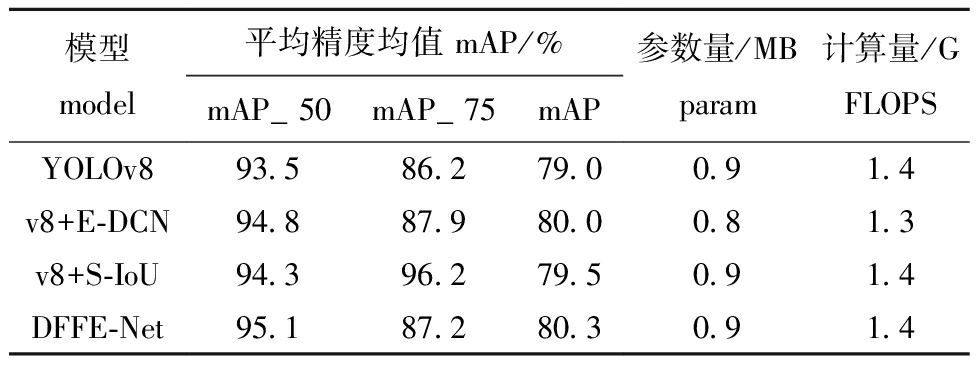

为了验证提出的改进算法在水下鱼类识别中的有效性,分别选取原始YOLOv8、改进的细微特征提取算法、改进的边界框回归算法和提出的最终识别模型在coco数据集标准下进行对比试验,并将模型分别命名为YOLOv8、v8+E-DCN、v8+S-IoU和DFFE-Net。表1为上述模型在水下鱼类识别的性能指标。mAP(Mean Average Precision)表示平均精度均值,mAP_50和mAP_75分别表示交并比IoU大于50%和75%阈值下计算的平均精度均值。参数量表示模型需要训练的权重参数的总数量,计算量(floating point operations per second,FLOPS)表示模型在一次前向传播时执行的浮点运算次数,即模型的计算开销。

表1 改进算法的性能指标

Tab.1 Performance indicators of improved algorithms

模型model平均精度均值 mAP/%mAP_50mAP_75mAP参数量/MBparam计算量/GFLOPSYOLOv893.586.279.00.91.4v8+E-DCN94.887.980.00.81.3v8+S-IoU94.396.279.50.91.4DFFE-Net95.187.280.30.91.4

从表1可见,YOLOv8在mAP_50和mAP_75标准下的数值分别为93.5%和86.2%。v8+E-DCN和v8+S-IoU在相同的标准下均表现出更好的识别性能。与YOLOv8相比,本文提出的方法DFFE-Net在mAP_50和mAP_75分别提升了1.6%和1.0%。在mAP下,YOLOv8最终达到了79.0%,而v8+E-DCN和v8+S-IoU均表现出略高的数值,分别为80.0%和79.5%。DFFE-Net则取得了最高的mAP,比YOLOv8提升了1.3%。至于Param和FLOPS,所有的模型都呈现出相近的数值,除了v8+E-DCN为0.8 MB和1.3 G,其余均为0.9 MB和1.4 G。

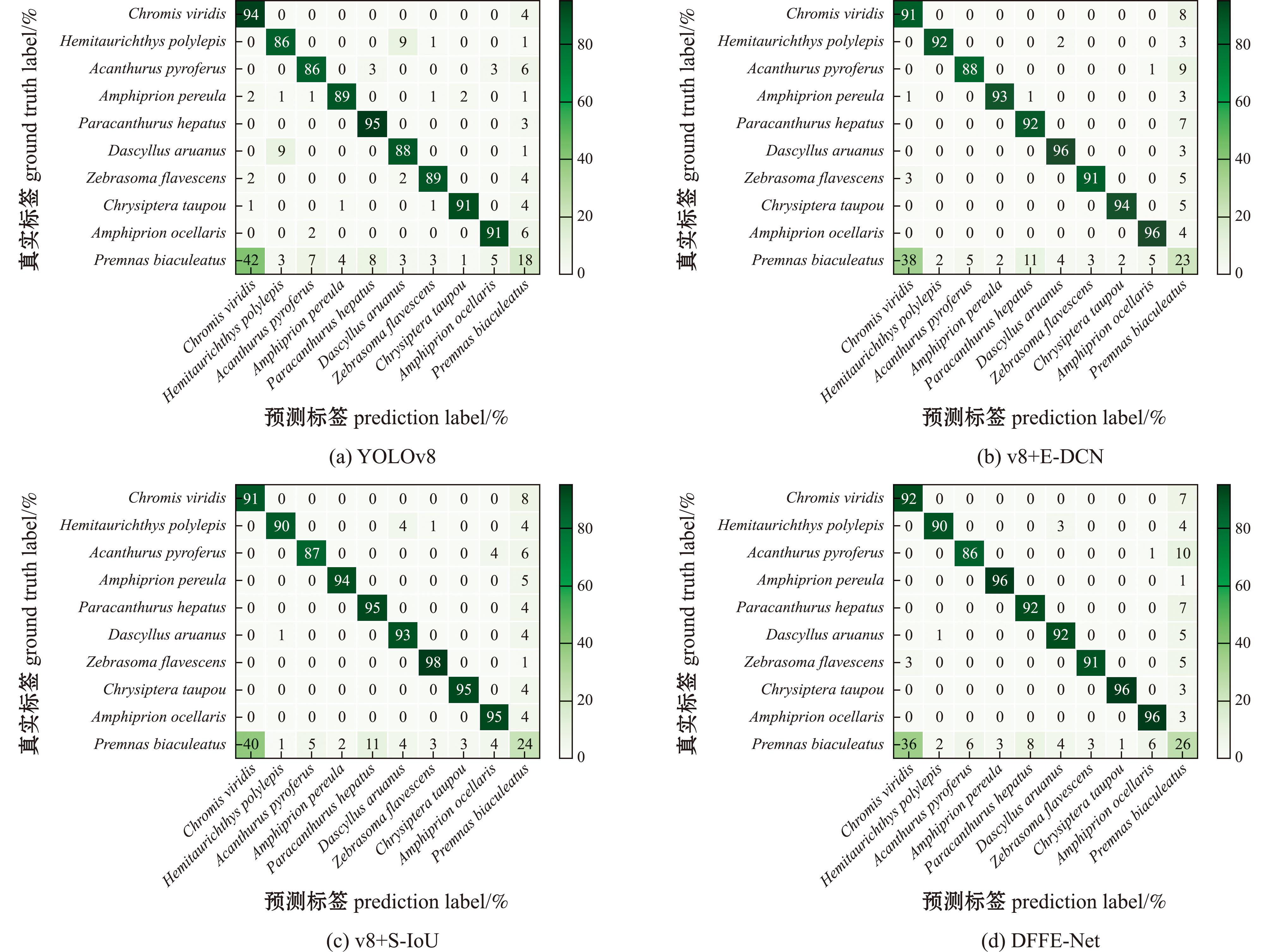

图7为改进算法与YOLOv8的归一化混淆矩阵。除透红小丑鱼仅有18%,YOLOv8能够较为准确地标识出其他种类的鱼,准确率在86%以上。相比于YOLOv8,v8+E-DCN和v8+S-IoU能够显著提升准确性,透红小丑鱼的数值分别达到了23%和24%。本文提出的DFFE-Net从整体上表现最佳,准确率为20%,比YOLOv8提高了8%。尽管改进算法后的模型在某些类别上的准确度偏低,但在大多数鱼类上均获得较高的数值。由于YOLOv8缺少E-DCN和Shape-IoU,在鱼类深度细微特征的学习能力较弱,导致性能指标数据偏低。总体上,本研究中提出的改进算法均能在水下鱼类识别准确性上获得提升。提出的DFFE-Net在不增加模型参数和计算量的前提下,可以有效改善对鱼类的识别性能。

图7 改进算法的归一化混淆矩阵

Fig.7 Normalized confusion matrix of improved algorithm

3.3 与其他识别网络的对比试验

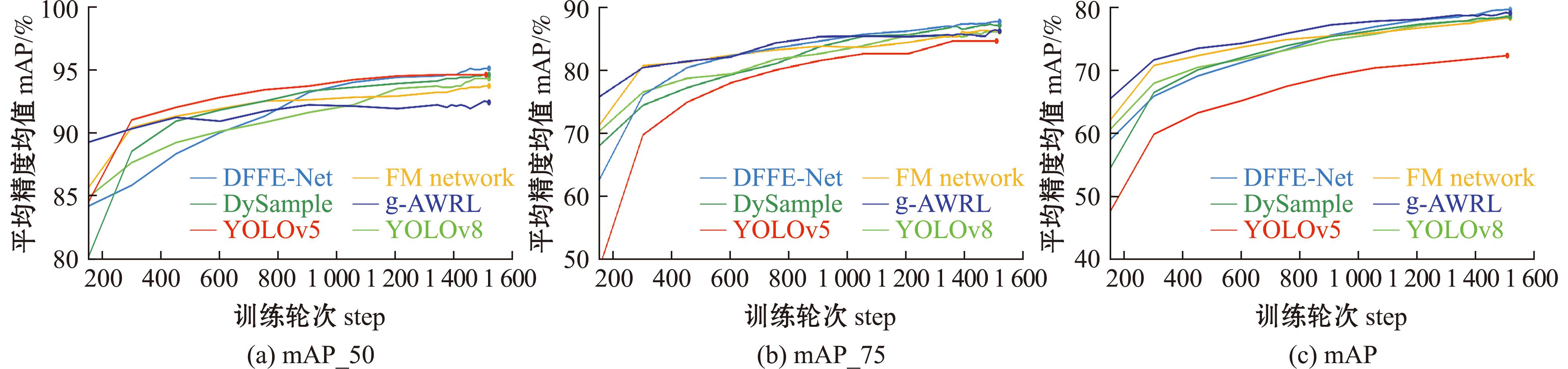

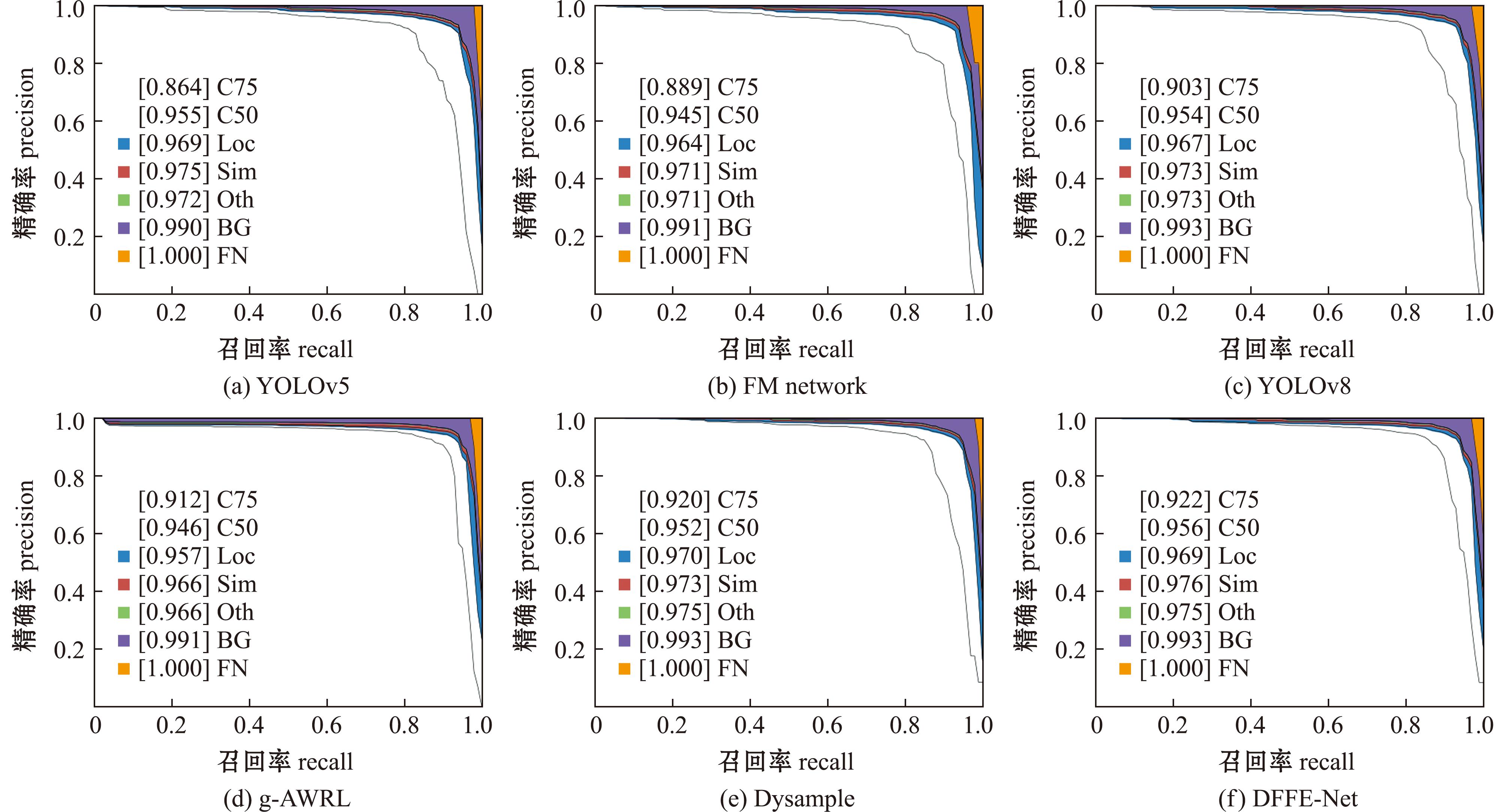

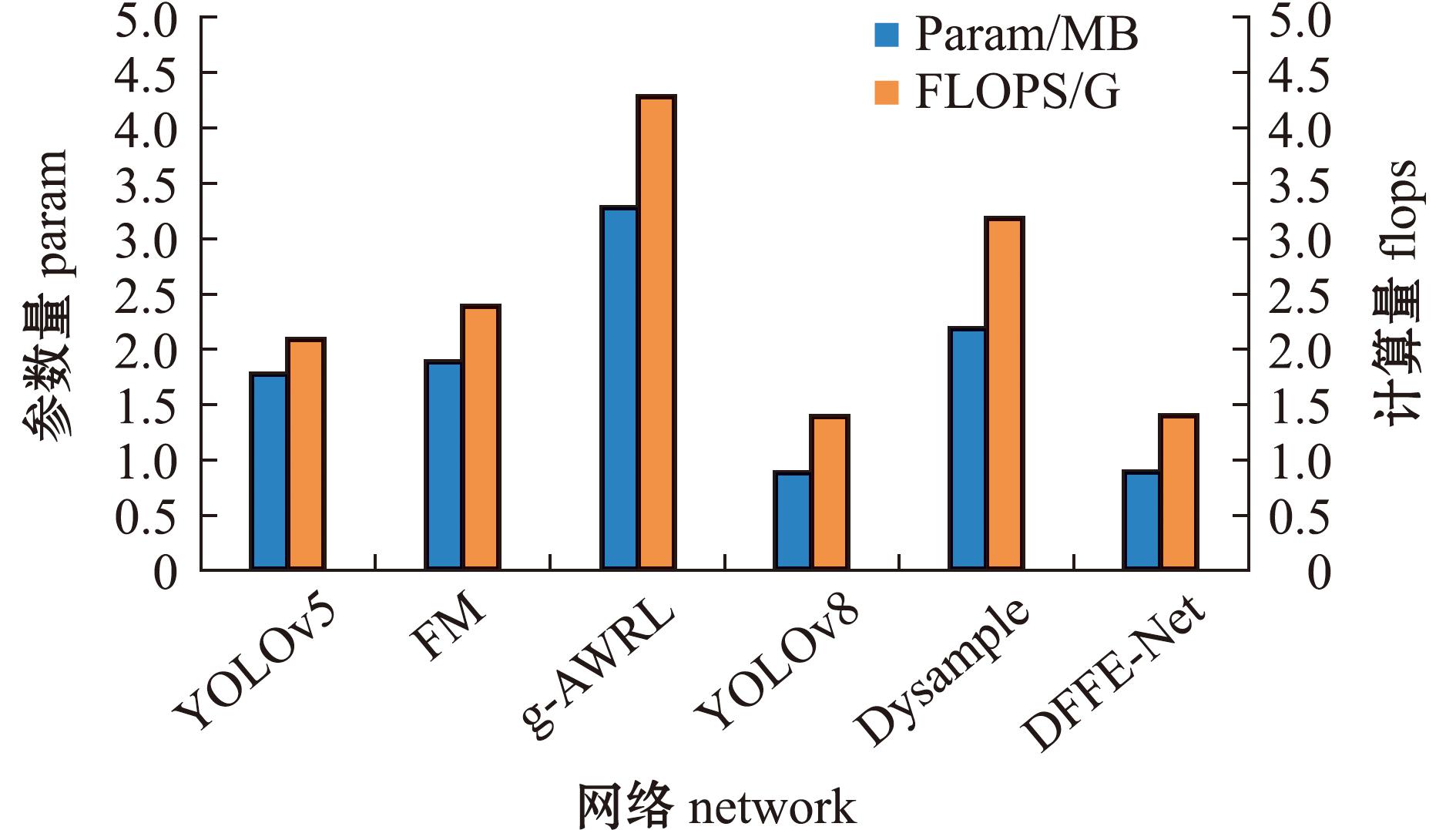

本文提出的DFFE-Net和其他识别网络进行了对比试验,包括YOLOv5、FM(focal modulation)network[19]、Dysample(dynamic sampling upsampler)[20]、YOLOv8和g-AWRL(generalized attention weighted reinforcement learning)[21]。图8对比了不同识别网络的mAP_50、mAP_75和mAP曲线,图9和图10分别展示了不同识别网络的精确率-召回率曲线、参数量和计算复量。

图8 mAP_50、mAP_75和mAP曲线

Fig.8 The curves for mAP_50,mAP_75 and mAP curves

图9 精确率-召回率曲线

Fig.9 Precision-recall curves

图10 不同识别网络的参数量和计算量

Fig.10 Parameters and FLOPS of different recognition networks

从图8~图10可见,DFFE-Net的综合性能指标表现最佳,在mAP_50、mAP_75和mAP中均位于较高的位置,同时具有最佳的精确率-召回率曲线和相对较低的参数量和计算量,这表明它既能保持高效又能实现较高的精度。相反,g-AWRL对参数量和FLOPS的需求均最高,但mAP仍然低于DFFE-Net。YOLOv5和Dysample在mAP_50上表现相似,但在mAP和计算资源需求上差异较大,即Dysample在维持相近识别精度的时,参数量和FLOPS使用量更大。综上所示,DFFE-Net在水下鱼类识别性能上的提升原因是:由于提出的E-DCN模块具有可变形卷积,能够提取到更深层细微的鱼类特征,Shape-IoU考虑边界框的几何因子促使鱼类目标回归更加精准。

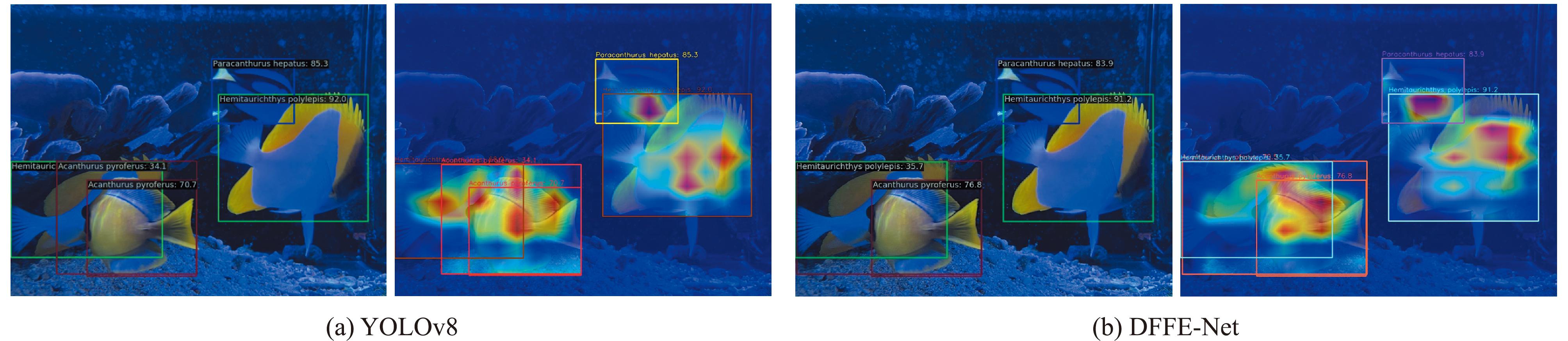

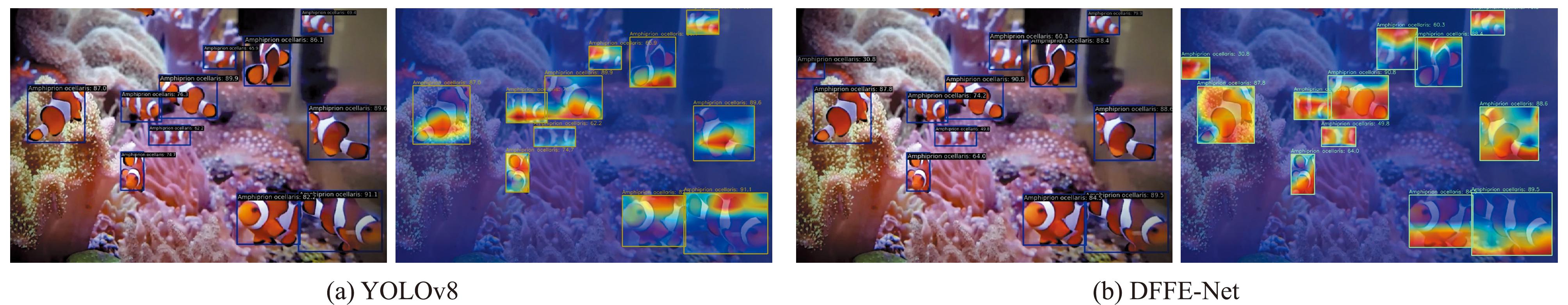

3.4 识别与可视化结果分析

为了更加直观的体现所提出的DFFE-Net在水下鱼类识别的优势,图11和图12对比展示了YOLOv8与DFFE-Net的可视化结果,包括识别结果与热力图。图11为包含不同种类鱼个体的图像,其中,鱼类运动姿势和角度各异,且存在相互遮挡的问题。水下光线较暗导致部分鱼类的纹理和边缘不清晰,易与背景区域混淆。图12为包含单种鱼群的图像,鱼体尺寸相对较小且分布密集,个体距离远近差异较大且存在遮挡情况,部分鱼因为运动而出现模糊。背景中多种颜色和纹理复杂的珊瑚和海葵与鱼类目标较为相似,周围环境光线由于散射效应造成鱼体的亮度不均匀。在可视化结果中,识别结果是将每种鱼类通过不同矩形框标注并附有鱼类名称和判别概率值。热力图为叠加展示鱼类目标位置和种类信息,直观地呈现鱼类特征信息的密集程度。可视化结果中,每个被识别出来的鱼都被矩形框标识出,并在其上方覆盖对应的热力图。

图11 不同物种类鱼可视化结果

Fig.11 Visualization results for different fish species

图12 单物种鱼群可视化结果

Fig.12 Visualization results for a single species fish school

从图11可见,YOLOv8与DFFE-Net都能够识别出4种鱼类,但由于左下角的黑鳃刺尾鱼和多鳞霞鲽鱼具有较为相似的特征且二者相互遮挡,YOLOv8在定位和边界判定上出现了较大的偏差。此外,DFFE-Net在种类判别的概率值方面也表现出更优的结果,反映出DFFE-Net在处理复杂场景时,对鱼类遮挡和低对比度鱼类的识别效果更佳。同理,在图12中,YOLOv8与DFFE-Net都能够识别出大部分水下鱼类目标,但由于背景颜色与鱼群具有一定相似性,YOLOv8 未精准识别出靠近珊瑚背景的模糊鱼类小目标。此外,在处理相互遮挡的鱼时,DFFE-Net的识别矩形框能够比YOLOv8更加精准地定位到鱼类个体的边界。由此可知,本文提出的改进算法E-DCN和Shape-IoU能够有效提升深度细微特征提取能力和鱼类边界回归能力,使DFFE-Net具有更高效的识别性能,提升了对水下复杂鱼类识别的适用性。

4 讨论

4.1 构建E-DCN模块对鱼类识别性能的影响

E-DCN模块是在C2f模块的基础上增加了DCNv4结构,通过可变形卷积操作动态调整卷积核,提升了对水下不同形态鱼类的学习能力。传统卷积操作的卷积核只有固定的感受野,卷积操作严格按照预定义的网格进行。对于形状复杂或动态变化的鱼类,固定感受野导致特征提取能力受限,但是,E-DCN模块具有动态偏移量和调整卷积核位置的能力。每个卷积核的位置不再固定,而是根据输入特征学习得出动态调整的偏移量,从而实现对鱼体形变的适应。E-DCN模块将输入特征图划分为多个分组,每个分组独立处理,从而提升对特定局部区域特征的建模能力。通过对分组内特征进行卷积,有效捕捉鱼体的局部细节,同时维持整体特征的一致性。偏移共享使得同一分组内的卷积操作能够共享学习到的偏移信息,提高了卷积核对动态形状的适应性,并且减少了参数量,提升了计算效率。在现实场景中,吴兆东等[22]和朱咏梅等[23]已经将可变形卷积融入多种深度网络模型,并通过对比试验验证了可变形卷积在目标识别方面的优越性。本研究中构建了具有可变形卷积的E-DCN模块,并将其引入到YOLOv8中,不仅提升了对水下鱼类的识别准确率,还降低了参数量和计算复杂度。这不仅验证了E-DCN模块在复杂环境中完成多种鱼类识别任务的有效性,同时还为其在其他领域的潜在应用提供了一定的理论支持,随着智慧海洋相关技术的深入发展,E-DCN模块也将得到广泛的应用。

4.2 引入Shape-IoU算法对鱼类识别性能的影响

Shape-IoU针对水下不规则鱼类目标形状,不仅考虑鱼体的矩形框特性,还通过对鱼体边缘的形状特征进行建模,实现对复杂形状的精确拟合。在计算IoU时,引入鱼体实际形状的匹配度,增强了对鱼体边界信息的敏感性。Shape-IoU通过结合鱼体几何特征与形状特征,形成多维度综合评价指标,提升了对水下复杂鱼类识别的适用性,同时,Shape-IoU在评价中引入了形状一致性度量,能够针对弯曲、狭长等形态特征进行精准建模。周央等[24]在YOLOv7的基础上采用Shape-IoU对模型进行改进,用于输电线路异物检测,试验结果验证了Shape-IoU在识别能力上的有效性。在本研究中,相较于YOLOv8自身的CIoU,Shape-IoU在处理边界复杂的鱼类时更加鲁棒。CIoU是基于矩形框的重叠面积比、框中心距离和长宽比一致性进行优化,但无法直接表征目标真实边界的形状特征。Shape-IoU则是引入形状匹配算法,将检测框的形状特征与真实目标形状进行比对,量化形状差异。总之,Shape-IoU通过引入形状特征优化和动态权重机制,在不规则鱼类识别中相较于CIoU具有显著的优势,其结构特点和算法改进不仅提升了边界框的拟合精度,还增强了复杂场景下的鲁棒性。

5 结论

1)为了提升对水下鱼类的识别性能,本文选取YOLOv8作为基础模型,提出了一种基于深度细微特征提取的识别方法DFFE-Net。该模型对鱼类图像识别的mAP达到80.3%,参数量为0.9 MB,FLOPs为1.4 G。通过试验对比,验证了本改进算法的有效性,以及DFFE-Net在水下鱼类识别的优越性,为水下鱼类精准识别提供了技术支持。

2)通过采用可变形卷积DCNv4构建E-DCN模块代替传统卷积进行鱼类细微特征提取,改进后的模型与YOLOv8相比,不但识别能力提升,还将参数量和计算量分别降低了11.1%和7.1%。同时引入Shape-IoU算法,通过结合边界框的几何因子计算提高了鱼类目标的定位精度。

3)未来研究将进一步从多样化鱼类特征建模、复杂环境适应性和多任务融合等方向进行优化。计划通过引入基于先验知识的鱼类特征建模和多分支模型设计,不断优化损失函数、FPN网络等,并且利用LSTM、Transformer等架构建模降低运动模糊的影响,使模型更加适用于水下复杂环境的精准识别。此外,将继续丰富数据集中鱼群种类和数量,利用GAN网络生成各种环境条件下的鱼类图像,增加训练数据的多样性。

[1] 张琳,葛艳,杜军威,等.改进FCOS网络的海洋鱼类目标检测[J].计算机系统应用,2023,32(3):309-315.

ZHANG L,GE Y,DU J W,et al.Improved FCOS network for marine fish target detection[J].Computer Systems and Applications,2023,32(3):309-315.(in Chinese)

[2] 龚瑞昆,赵学智,赵福生.基于EfficientNetV2-HDCA模型水下鱼类图像分类算法研究[J].电子测量技术,2022,45(22):128-134.

GONG R K,ZHAO X Z,ZHAO F S.Research onunderwater fish image classification algorithm based on EfficientNetv2-HDCA modell[J].Electronic Measurement Technology,2022,45(22):128-134.(in Chinese)

[3] 吕俊霖,陈作志,李碧龙,等.基于多阶段特征提取的鱼类识别研究[J].南方水产科学,2024,20(1):99-109.

LÜ J L,CHEN Z Z,LI B L,et al.Research on fish recognition based on multi-stage feature extraction learning[J].South China Fisheries Science,2024,20(1):99-109.(in Chinese)

[4] 杨春兰,薛大为.基于卷积神经网络的淡水鱼分类识别[J].西南民族大学学报(自然科学版),2020,46(6):611-618.

YANG C L,XUE D W.Freshwaterfish classification recognition based on convolutional neural network[J].Journal of Southwest Minzu University (Natural Science Edition),2020,46(6):611-618.(in Chinese)

[5] CHAN T H,JIA K,GAO S H,et al.PCANet:a simple deep learning baseline for image classification?[J].IEEE Transactions on Image Processing,24(12):5017-5032.

[6] LIU H C,MA X,YU Y N,et al.Application of deep learning-based object detection techniques in fish aquaculture:a review[J].Journal of Marine Science and Engineering,2023,11(4):867.

[7] POUR F B,PARRA L,LLORET J,et al.Measuring and evaluating the speed and the physical characteristics of fishes based on video processing[J].Water,2023,15(11):2138.

[8] BEN TAMOU A,BENZINOU A,NASREDDINE K.Multi-stream fish detection in unconstrained underwater videos by the fusion of two convolutional neural network detectors[J].Applied Intelligence,2021,51(8):5809-5821.

[9] LI J Y,LIU C N,LU X C,et al.CME-YOLOv5:an efficient object detection network for densely spaced fish and small targets[J].Water,2022,14(15):2412.

[10] KNAUSGÅRD K M,WIKLUND A,SØRDALEN T K,et al.Temperate fish detection and classification:a deep learning based approach[J].Applied Intelligence,2022,52(6):6988-7001.

[11] 闫党康.基于改进的Mask R-CNN的鱼类识别算法研究[J].计算机与数字工程,2023,51(6):1238-1243.

YAN D K.Research onfish recognition algorithm based on improved mask R-CNN[J].Computer &Digital Engineering,2023,51(6):1238-1243.(in Chinese)

[12] YU G Y,SU J P,LUO Y T,et al.Efficient detection method of deep-sea netting breakage based on attention and focusing on receptive-field spatial feature[J].Signal,Image and Video Processing,2024,18(2):1205-1214.

[13] 王伟芳,殷健豪,高春奇,等.增强细节信息特征提取的鱼类个体识别算法[J].现代电子技术,2024,47(2):183-186.

WANG W F,YIN J H,GAO C Q,et al.Fishindividual recognition algorithm of feature extraction of enhanced detailed information[J].Modern Electronics Technique,2024,47(2):183-186.(in Chinese)

[14] 王海燕,杜菲瑀,姚海洋,等.基于联合深度统计特征对齐的鱼类目标识别方法[J].陕西科技大学学报,2024,42(3):182-187,196.

WANG H Y,DU F Y,YAO H Y,et al.Fish target recognition method based on joint deep statistical feature alignment[J].Journal of Shaanxi University of Science &Technology,2024,42(3):182-187,196.(in Chinese)

[15] SAYDIRASULOVICH S N,MUKHIDDINOV M,DJURAEV O,et al.An improved wildfire smoke detection based on YOLOv8 and UAV images[J].Sensors,2023,23(20):8374.

[16] 李鹏龙,张胜茂,沈烈,等.具有双层路由注意力机制的YOLOv8血鹦鹉目标检测与追踪方法[J].大连海洋大学学报,2024,39(2):318-326.

LI P L,ZHANG S M,SHEN L,et al.YOLOv8 blood parrot object detection and tracking method with dual-layer routing attention mechanism[J].Journal of Dalian Ocean University,2024,39(2):318-326.(in Chinese)

[17] XIONG Y W,LI Z Q,CHEN Y T,et al.Efficient deformable ConvNets:rethinking dynamic and sparse operator for vision applications[EB/OL].2024:2401.06197.https://arxiv.org/abs/2401.06197v1.

[18] ZHANG H,ZHANG S.Shape-IoU:more accurate metric considering bounding box shape and scale[J].2023:2312.17663.arXiv preprint arXiv:2312.17663.

[19] YANG J,LI C,DAI X,et al.Focal modulation networks[J].Advances in Neural Information Processing Systems,2022,35:4203-4217.

[20] LIU W Z,LU H,FU H T,et al.Learning to upsample by learning to sample[C]//2023 IEEE/CVF International Conference on Computer Vision (ICCV).October 1-6,2023,Paris,France.IEEE,2023:6004-6014.

[21] BRAMLAGE L,CORTESE A.Generalized attention-weighted reinforcement learning[J].Neural Networks,2022,145:10-21.

[22] 吴兆东,徐成,刘宏哲,等.适用于鱼眼图像的改进YOLOv7目标检测算法[J].计算机工程与应用,2024,60(14):250-256.

WU Z D,XU C,LIU H Z,et al.Improved YOLOv7object detection algorithm for fisheye images[J].Computer Engineering and Applications,2024,60(14):250-256.(in Chinese)

[23] 朱咏梅,李玉玲,奚峥皓,等.注意力可变形卷积网络的木质板材瑕疵识别[J].西南大学学报(自然科学版),2024,46(2):159-169.

ZHU Y M,LI Y L,XI Z H,et al.Attentiondeformable convolutional networks for wooden panel defect recognition[J].Journal of Southwest University (Natural Science Edition),2024,46(2):159-169.(in Chinese)

[24] 周央,廖斌.基于改进 YOLOv7 算法的输电线路异物检测[EB/OL].华北电力大学学报(自然科学版),1-9[2025-03-05].http://kns.cnki.net/kcms/detail/13.1212.TM.20240712.1820.002.html.

ZHOU Y,LIAO B.Foreignobject detection for power transmission lines based on improved YOLOv7 algorithm[EB/OL].Journal of North China Electric Power University (Natural Science Edition),1-9[2025-03-05].http://kns.cnki.net/kcms/detail/13.1212.TM.20240712.1820.002.html.(in Chinese)