中华绒螯蟹(Eriocheir sinensis)又名“河蟹”,具有较高的营养价值和经济价值[1-2],目前中国河蟹的最终去向主要分为鲜食和深加工两种。据统计,2022年全国河蟹养殖总产量高达81.5 万t[3],其中河蟹鲜食市场占比达98.89%,深加工市场仅占比1.11%[4]。相较于鲜食市场,河蟹深加工市场明显偏低,其原因之一在于河蟹深加工方式多为分部位加工,加工前要先去壳,不同部位去壳方式差异巨大,工艺繁琐[5];且目前河蟹深加工装备智能化程度较低,这些因素极大地制约了河蟹深加工产业的发展。

目前,在河蟹去壳加工过程中,多依赖人工使用手工剥壳器械(如锤、镦、铲、针、叉和剪刀等)进行部位分离、去壳和取肉[6-7],存在劳动强度大、加工效率低、加工成本高等问题。近年来,河蟹加工研究多聚焦于单一部位机械加工装置的改进。如陈超等[8]设计了一款辊筒挤压式步足壳肉分离装置,利用一对直径相同、转动方向相反、转速相同的圆柱辊筒对步足进行挤压,实现步足的壳肉分离;Tomoda等[9]设计了一种具有上下齿轮、传送带和固定装置的河蟹去壳装备,通过在传送链的上下方及末端安装刀具,完成蟹腹部及背甲和蟹身的对切。这些研究多数停留在实验室阶段,加工部位单一,且受限于准确加工位置难以获取,加工效果一般,智能化程度较低。

随着深度学习在图像识别领域的飞速发展,机器视觉已经被广泛运用到水产品加工领域,并取得了显著效果[10]。Wang等[11]通过结合图像处理技术、遗传算法和BP神经网络,提出了一种河蟹品质分级方法,准确率达到了92.7%。Thayananthan等[12]使用5种深度学习语义分割模型分别对鲶的头部、身体、鳍和尾部进行分割,明确了SegFormer-B5模型对鲶鱼的分割效果最优,但模型参数达87 M,不利于模型在边缘设备的部署。Wang等[11]率先将图像分析引入自动化蟹类加工中,提出了一种基于卷积神经网络的计算机视觉算法,可以在图像中准确检测青蟹的背鳍节,但在检测时采用模板匹配的方法,检测效率较低。这些模型的应用在一定程度上促进了水产加工领域的智能化程度,但是这些网络模型较大,检测速度较慢,不能满足水产加工的实时性需求。近年来,YOLO算法和轻量化模型的出现,进一步提高了智能化加工的效率。陈学深等[13]将YOLOv4的CSP-Darknet53网络替换为GhostNet网络,并引入SE注意力机制和CIOU,改进后模型大小为43.71 MB,FPS为25 帧/s,虽然能够有效实现虾只机械剥壳环节裸肉虾与带壳虾自动分选,但模型仍然较大,硬件部署困难,且FPS较低,实时性较差。万鹏等[14]采用YOLOv5s对鲐的头尾朝向和腹背朝向进行识别,并根据识别结果控制鱼体定向排列输送,完成鲐的头尾和腹背定向作业,然而研究者未对模型进行改进,模型大小为14.1 MB,轻量化程度较低。因此,在河蟹深加工过程中,将机器视觉技术与河蟹加工装备相结合,通过对河蟹不同部位进行检测分割,明确加工部位,对提升河蟹加工效率和促进水产加工业的可持续发展具有重要意义。

针对当前河蟹深加工过程存在的问题,本文基于河蟹分部位加工需求,构建由躯干、蟹钳和步足组成的河蟹部位分割数据集;并提出一种YOLOv5s-FDSV检测分割模型,以YOLOv5s-Seg为基础模型,通过更换轻量化的FasterNet主干、融合DCNv2卷积、使用DySample上采样和YOLOv7中的下采样模块V7DownSample等方法进行模型改进,确保检测精度的同时兼顾轻量化和检测速度,从而实现河蟹不同部位的高效检测分割。

1 数据集构建

1.1 数据获取

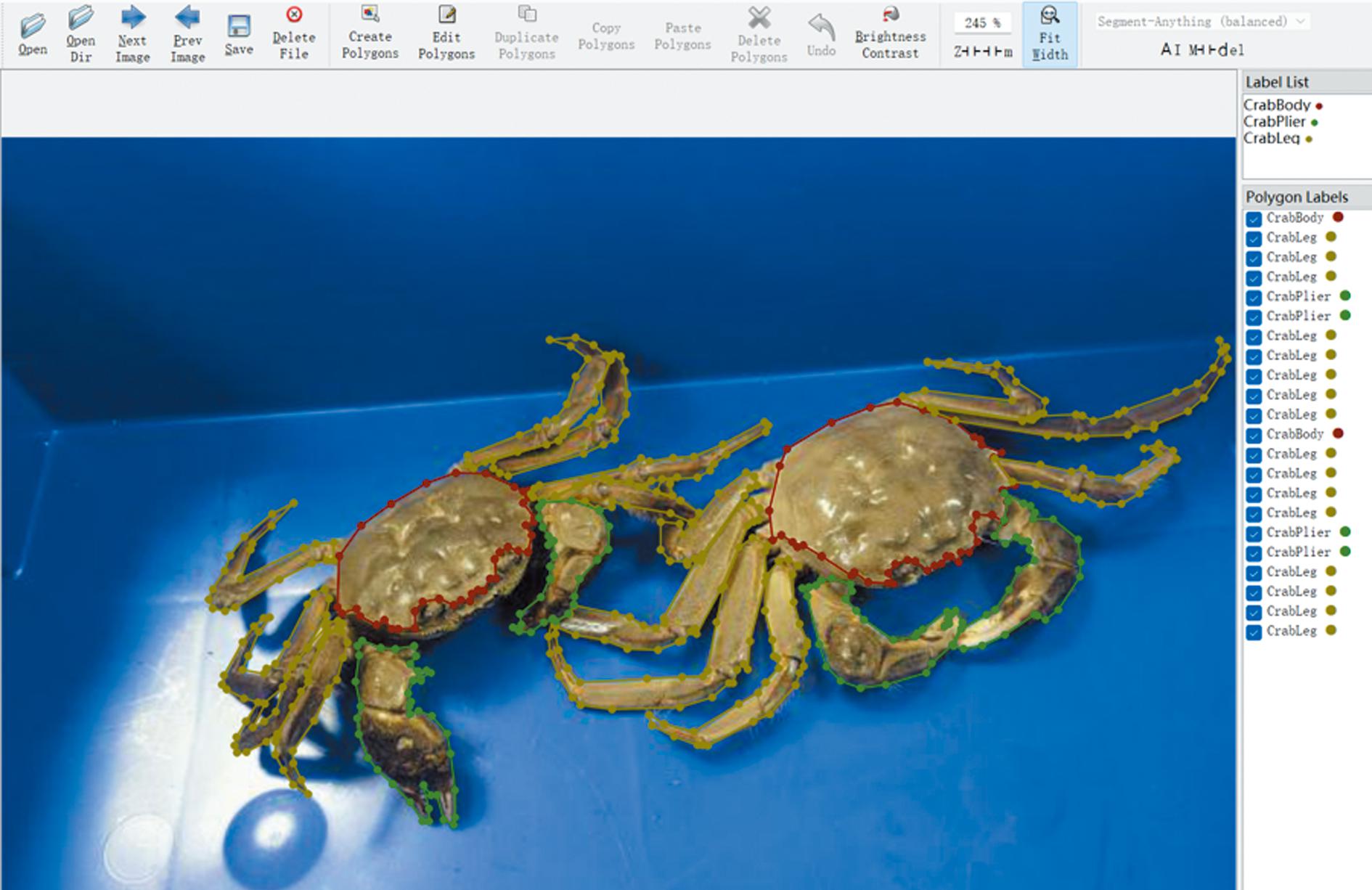

为提高数据集的代表性和模型适应性,本研究中使用拍摄和爬虫两种途径获取河蟹图像数据。首先为拍摄部分获取的图像,在水产品市场购置的50只河蟹样本,将河蟹按照单只和多只随机组合分配,并放置在不同的背景和光照条件下,使用华为Mate40 Pro手机、Iphone 14 Pro手机和IPad等多种设备进行不同角度的拍摄,在剔除重复、不清晰的图片后,共获取372张河蟹图片样本;另一部分则先编写Python脚本,以“河蟹”“大闸蟹”和“中华绒螯蟹”等关键字在百度爬虫获取相关河蟹图片,然后将其中的重复、破损严重、加工后的成品及蒸煮后变色的蟹去除,共获得382张河蟹图片样本。通过两种途径获得754张河蟹图片,样本主要由1只、多只及局部河蟹组成,部分样本图片如图1所示。

图1 两种方式获取的河蟹图像样本

Fig.1 Sample crab images obtained in by two ways

1.2 数据预处理与标注

首先,使用Labelme标注软件的多边形框对获取的754张河蟹图片进行标注,按照躯干、螯足和步足的轮廓分别进行标注,类别分别命名为:“crabbody”“pincers”和“walking legs”,使用Labelme标记完的效果如图2所示,标注后会生成带有位置坐标和类别名称的txt文件。接着,将标注后的数据按照7∶1∶2划分为训练集、验证集和测试集。然后,对图像做随机像素置零、随机旋转、颜色通道旋转、伽马对比度、添加噪声和翻转等操作进行数据增强,并且确保每张样本图片至少使用两种增强方法,以减少由于数据集过少而导致的过拟合现象,增加训练数据集的多样性,有效提高模型的性能和鲁棒性,并进一步增强模型的泛化能力,从而确保在干扰条件下的精度。最终得到3 770张样本图片构成的河蟹部位分割数据集,其中训练集2 335张图片,验证集333张图片,测试集417张图片。

图2 Lablme标注后的效果图

Fig.2 Effect of Lablme after labeling

2 河蟹不同部位检测分割方法

2.1 YOLOv5s-Seg基础模型

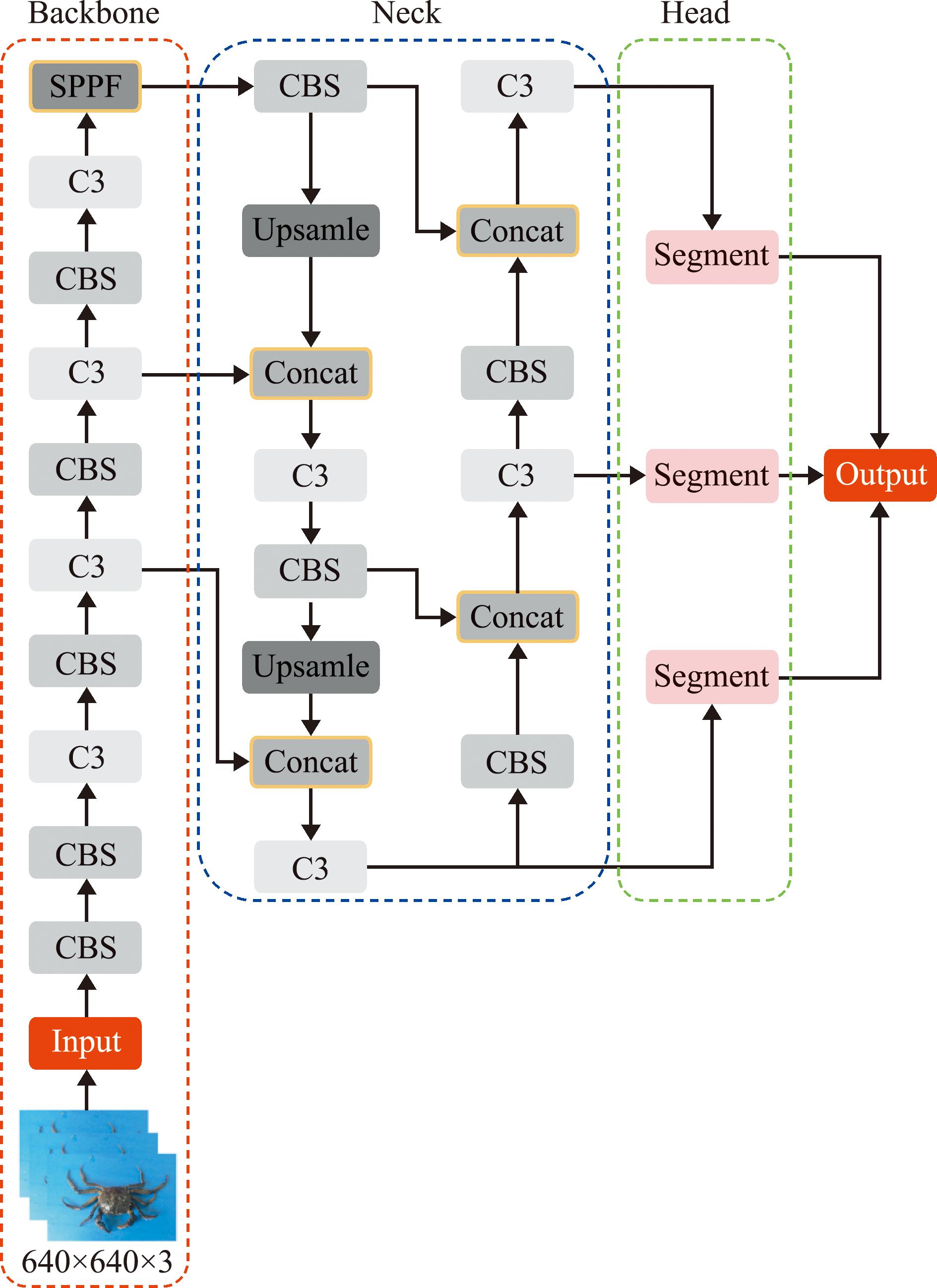

YOLOv5s-Seg是基于YOLOv5的图像分割模型,在YOLOv5网络的基础上添加了分割头部,使得模型能够同时进行目标检测和图像分割[15-16],其网络由输入、主干、颈部和头部组成,如图3所示。

图3 YOLOv5s-Seg基础模型

Fig.3 YOLOv5s-Seg basic model

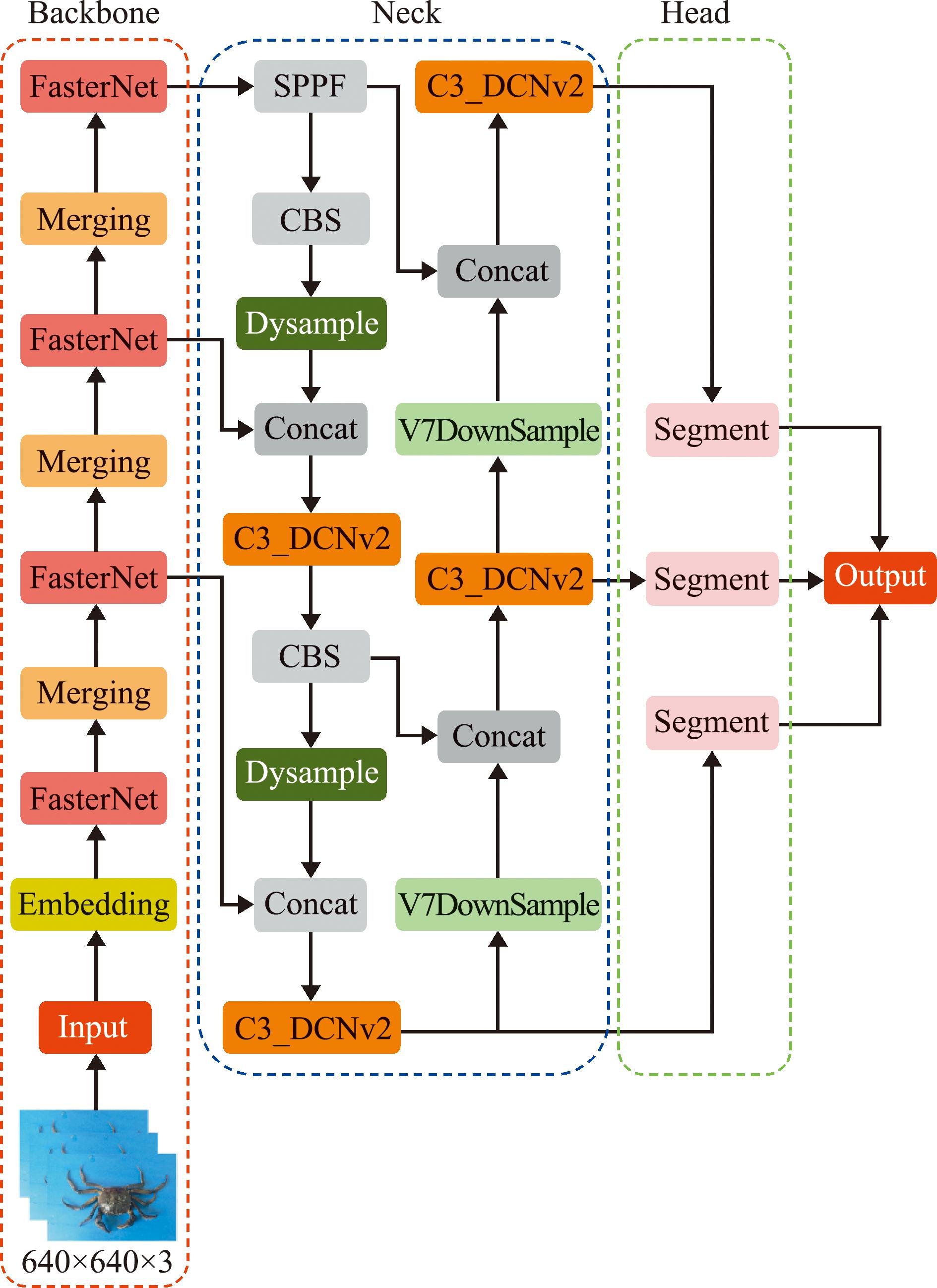

图4 YOLOv5s-FDSV模型

Fig.4 YOLOv5s-FDSV model

其中,主干部分由多个CBS、C3模块和SPPF层组成,负责对图像特征进行提取。颈部网络结合了特征金字塔网络(feature pyramid networks,FPN)和路径聚合网络[17-18](path aggregation network,PAN),对主干网络提取的特征进行多尺度特征融合,从而获得丰富的特征信息。头部则继承了普通YOLOv5检测模型的多尺度特征融合机制,从而实现了对20×20、40×40和80×80 3种特征尺度下不同大小物体的检测,其中,实例分割头通过小型全卷积神经网络[19](fully convolutional network,FCN)实现逐像素分类预测,并生成目标的二进制掩码;接着,将颈部的第17层C3模块输出作为输入,通过一个CBS模块处理输入的特征图,并输出一个大小为80×80×256的特征图;随后,再依次经过两个CBS模块后将特征图缩小为160×160×32并输出[20]。

2.2 YOLOv5s-FDSV模型

为了提高YOLOv5s-Seg模型对河蟹不同部位的检测分割效果,并为后续模型部署提供便利,本文以轻量化、高精度、快速检测为目的,对YOLOv5s-Seg模型进行改进,构建了YOLOv5s-FDSV模型。首先使用轻量化的FasterNet网络[21]对原有主干进行改进,以最大限度地减少冗余计算和内存访问;然后使用融合DCNv2卷积[22]的C3_DCNv2替换Neck部位的C3模块,以增强模型对河蟹部位特征的融合能力;接着使用DySample上采样[23]以提升模型对特征点的位置和图像信息的获取能力;最后借鉴YOLOv7的下采样模块,将原本Neck部分由CBS进行的下采样替换为V7DownSample[24],以增强模型过滤冗余特征和保留关键信息的能力。改进后YOLOv5s-FDSV的网络结构如图5所示。

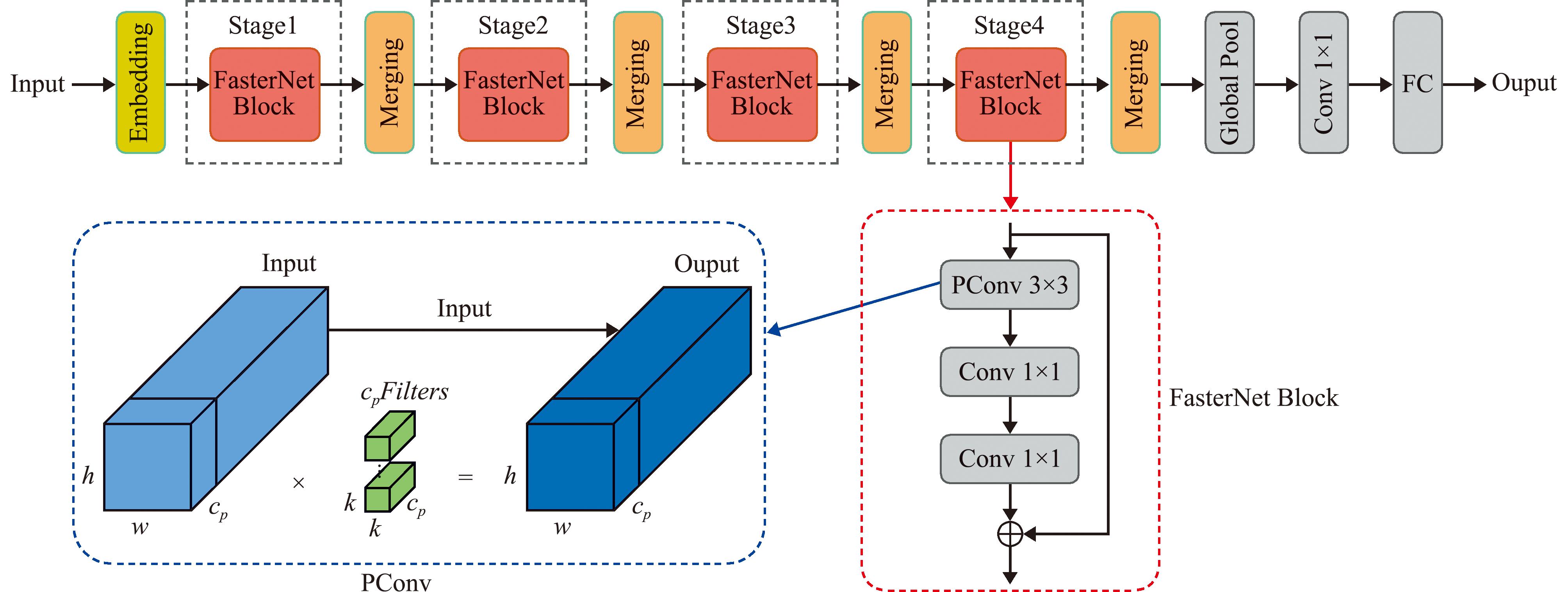

图5 PConv工作原理和FasterNet网络结构

Fig.5 Working principle of PConv and FasterNet network structure

2.2.1 FasterNet主干 模型轻量化的主要目的是减少网络模型的参数和计算,同时尽可能保持模型的准确性。随着学者们对模型轻量化的持续研究,目前已经提出了不少轻量级主干网络,包括FasterNet、MobileNet、Lcnet、GhostNet、Efficientnet和其他网络模型[25]。这些轻量化主干网络的使用使得模型在一些资源有限的移动设备和嵌入式开发系统中得到了广泛应用。

FasterNet通过引入PConv改进空间特征提取能力,能最大限度地减少冗余计算和内存访问。PConv与传统的卷积运算相比,仅对某些输入通道进行选择性特征提取,而其余通道保持不变。因此,由PConv构建的FasterNet主干能够有效增强网络对河蟹不同部位特征提取的同时,减少网络复杂程度,PConv的FLOPs可以计算如下。

(1)

式中:h为特征图的高度,w为特征图的宽度,k为卷积核大小,cp为输出通道的数量。当部分比率r=cp/c=1/4时,PConv的FLOPs仅为正常Conv的FLOPs的1/16,此外PConv的存储器访问仅为正常Conv的1/4,其存储器访问量计算公式为

(2)

图5显示了PConv工作原理和FasterNet网络的总体架构,FasterNet网络包含4个层次,其中嵌入层(embedding)或合并层(merging),其功能是执行空间下采样和通道数扩展,网络架构的每一级都有一个FasterNet模块。每个FasterNet模块都由一个Pconv层和2个逐点卷积(1×1卷积)组成。这些块一起表现为反转的残差块,其中中间层具有扩展的通道数量,并防止重复使用某些输入特征。

2.2.2 C3_DCNv2模块 在河蟹部位检测分割任务中,往往会出现多只河蟹交叠和躯干遮蔽其他部位的现象,容易导致检测分割精度下降,这给网络的特征提取带来了挑战。为了解决这个问题,本文使用可变形卷积DCNv2以增强网络的特征融合能力。

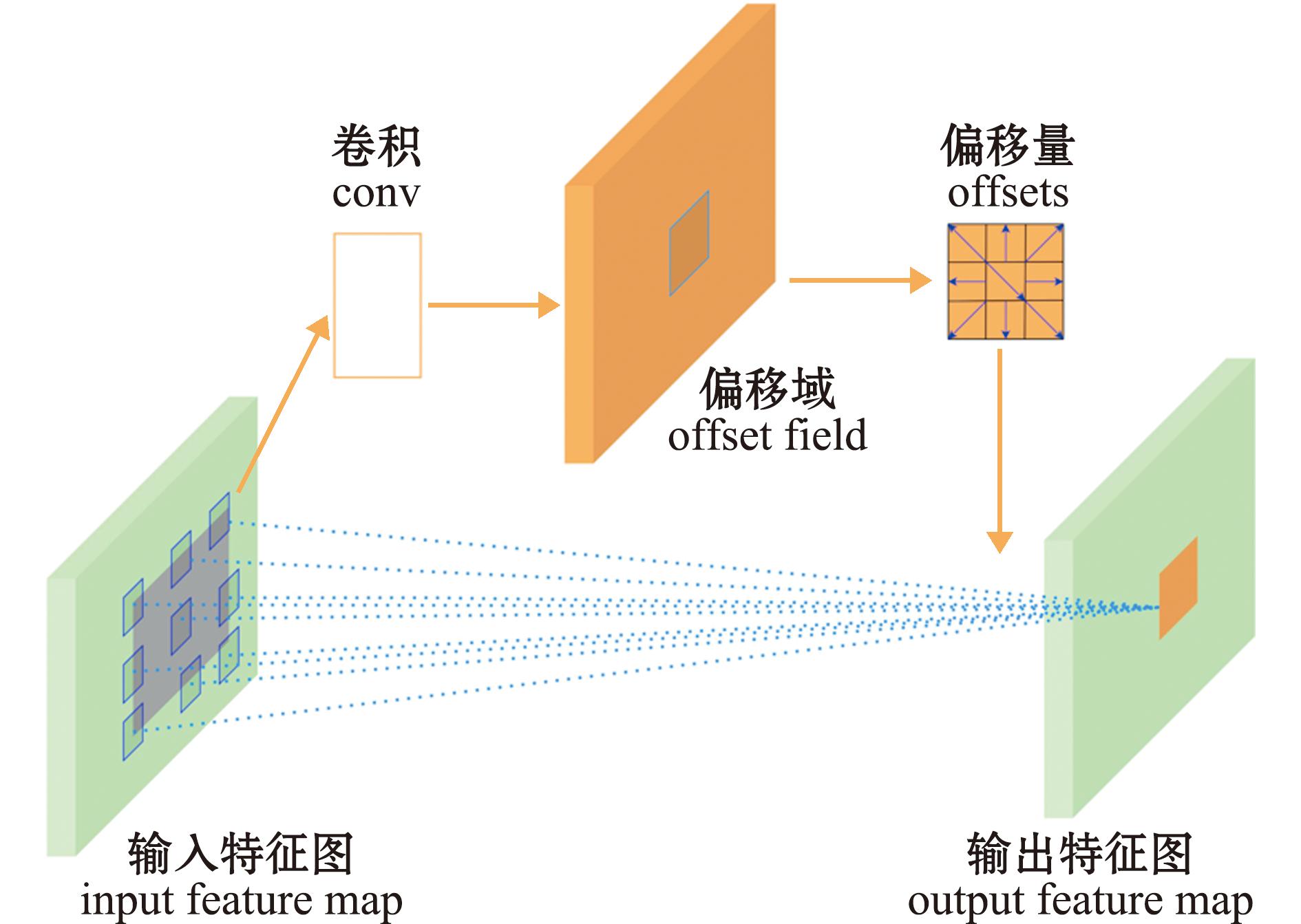

在传统的卷积神经网络中,卷积运算在输入特征图内的固定位置处执行,卷积核固定权重,导致卷积神经网络的感受野大小均匀,不能适应河蟹不同部位检测时面临的变形和旋转等问题,进而导致特征捕捉能力降低。为解决这一问题,DCNv1[26]通过引入偏移量的方式来适应卷积核。通过将偏移合并到可变形卷积中,卷积核获得了更大的灵活性,使它们能够动态调整采样位置,可变形卷积工作图如图6所示。这种灵活性使网络能够优先考虑输入中的感兴趣区域,可有效地处理几何变化和变形。DCNv1计算公式定义为

(3)

图6 可变形卷积工作原理

Fig.6 Deformable convolution working principle

式中:wk表示采样数据点的中心点,p表示采样数据点内的中心点,pk表示采样数据点内中心点的相对位置,Δpk表示位置偏移量。然而,在DCNv1在引入偏移模块时,容易使得在特征获取时得到干扰特征提取的无关区域,导致算法性能下降。为解决这一问题,DCNv2在保留了DCNv1的偏移量,以适应各种形状和大小目标分割的同时,还引入了点权重,以缓解DCNv1在进行偏移时容易在目标外采样的问题,为目标外的采样点分配较低的权重,并减少这些调查站位对输出的影响。DCNv2凭借这一机制使得网络在处理不同尺寸和形状的物体时更加灵活和精确[27]。DCNv2计算公式定义为

(4)

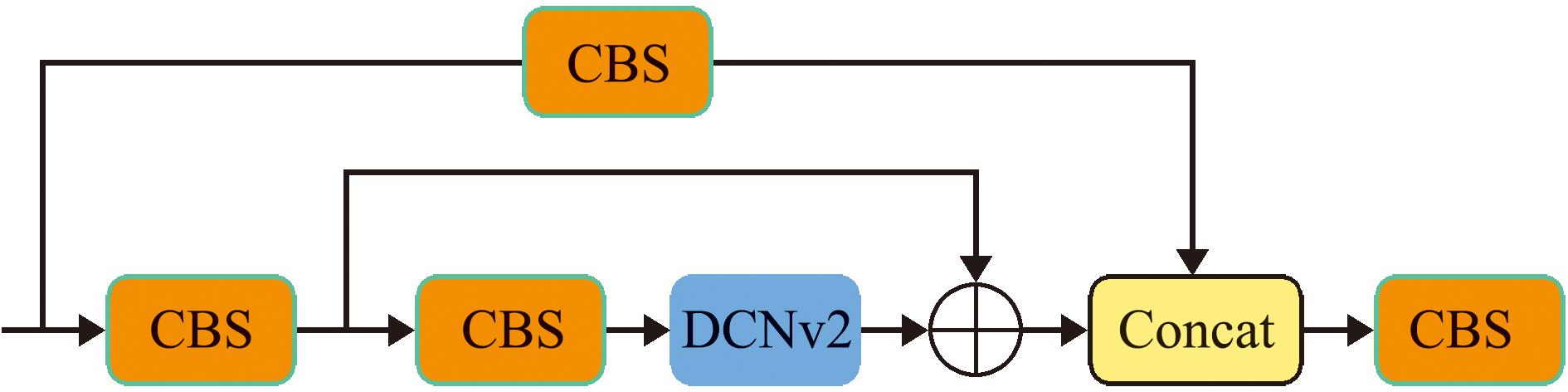

式中:Δmk表示第k个位置的权重系数,Δmk∈(0,1)。通过合并这些权重系数,DCNv2可以有效地区分相关区域和不相关区域,更好地过滤掉可能干扰特征提取的无关区域,从而提高整体算法性能。本文中,DCNv2模块被引入取代原始YOLOV5网络的C3模块中的卷积,在C3模块中嵌入DCNv2模块,增强了对河蟹各部位交叠和形状差异较大情况下的特征提取能力,从而提高模型的精度,C3模块嵌入DCNv2后的结构如图7所示。

图7 C3_DCNv2模块

Fig.7 C3_DCNv2 module

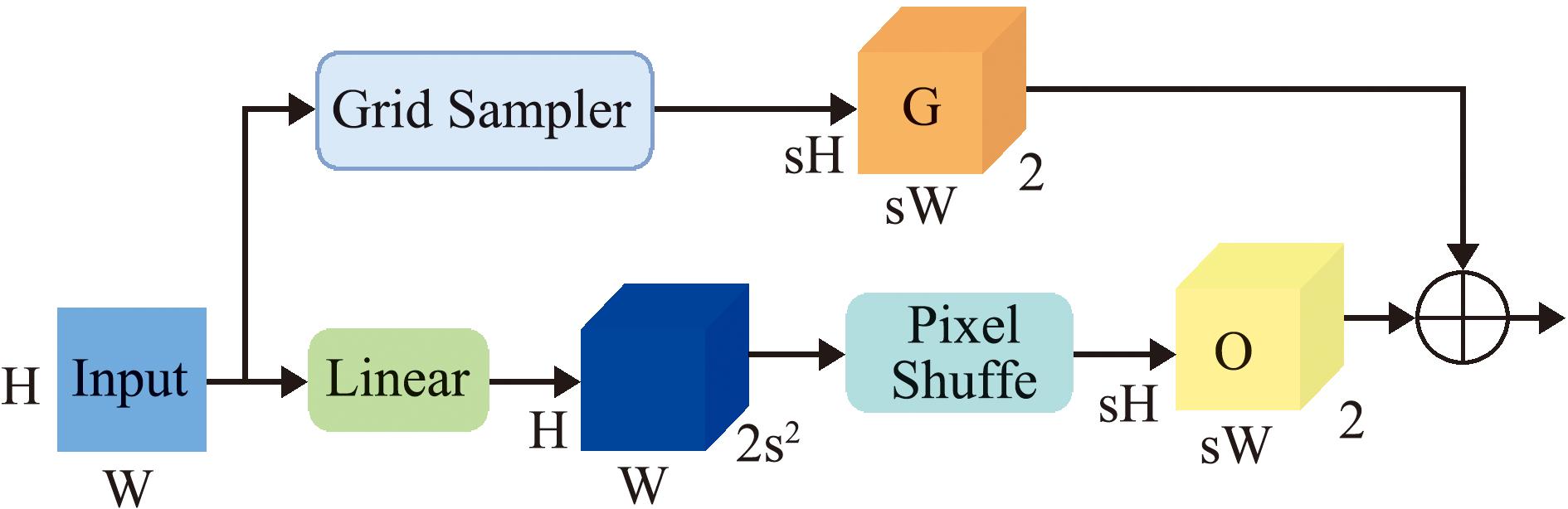

2.2.3 DySample上采样 特征上采样是恢复特征图分辨率的一个重要步骤[28]。目前基于内核的动态上采样如CARAFE、FADE和SAPA等均具有良好的性能,但往往会由于动态卷积和用于生成动态内核的额外子网络,带来大量的工作量和消耗更多的计算资源。而DySample上采样主动绕开动态卷积,通过调整采样点的位置偏移实现上采样,有效减少了计算开销[29],其工作原理如图8所示。

Grid Sampler为网格采样器;Linear表示线性投影;Pixel Shuffle表示像素洗牌;s表示上采样率;G表示网格采样点坐标;O表示动态采样点生成器生成的点位置偏移。

Grid Sampler refers to the grid sampler;linear represents linear projection;pixel Shuffle refers to pixel shuffling;s denotes the upsampling rate;G represents the grid sampling point coordinates;O denotes the point position offset generated by the dynamic sampling point generator.

图8 DySample上采样结构

Fig.8 DySample upsampling structure

在河蟹部位分割过程中,步足的数量较多,且容易交叠,使得部分步足目标较小。在使用YOLOv5s中的近邻插值法进行上采样时,容易造成特征点的位置和细节信息部分丢失;尤其在特征融合时,可能会导致高层语义特征和低层局部特征的错位,阻碍部分步足的特征表示。通过引入DySample上采样能够有效调整输入特征图的上采样参数,在保持较低计算成本的同时,有效改善河蟹不同部位的特征表示。

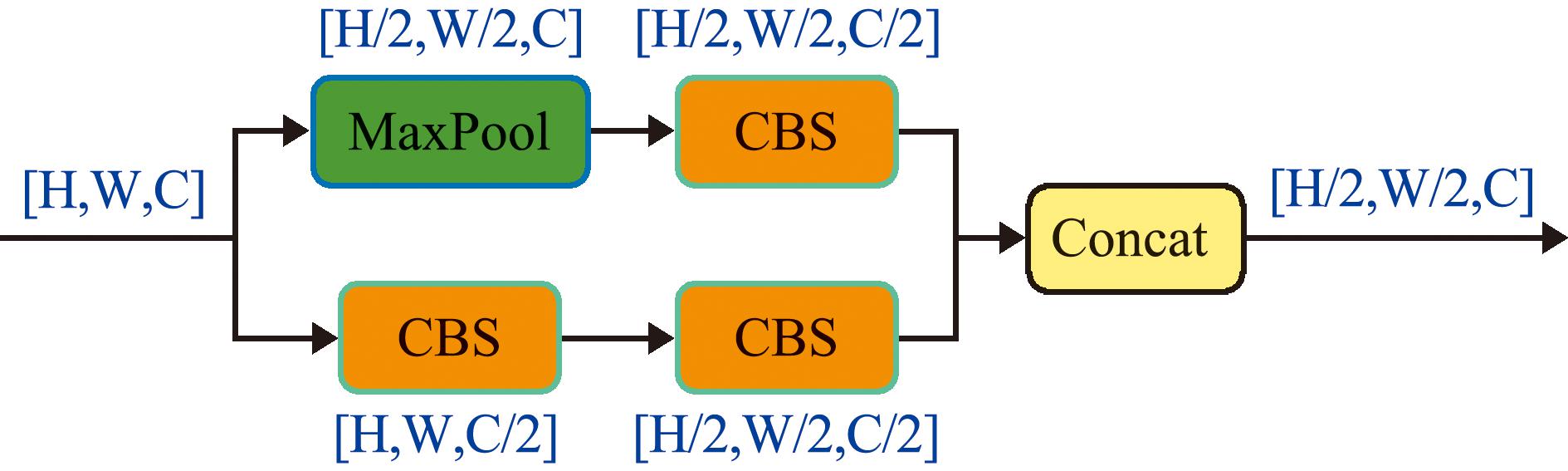

2.2.4 V7DownSample下采样 下采样常用来减小特征图的空间尺寸,通过逐步降低特征图的分辨率,聚焦于重要信息,促进目标捕获,同时减少像素数量,以降低计算成本和内存消耗,加速后续处理过程。目前常用的下采样方法包括最大池化(max pooling)、平均池化(average pooling)和卷积操作中的步长设置,它们通过在图像或特征图上滑动固定大小的窗口,并选取窗口内的最大值、平均值或按步长选取像素来实现下采样[30]。YOLOv5s-Seg采用的下采样为步长为2的卷积,虽然能够有效减小特征图的尺寸,但也可能会导致部分重要信息的丢失。

V7DownSample是YOLOv7网络中采用的下采样方法,它同时结合了最大池化和步长卷积两种方法,其结构如图9所示。从图9可见,V7DownSample模块上面分支采样最大池化实现空间降采样,并紧跟一个1×1卷积压缩通道;下面分支先用1×1卷积压缩通道,然后再用步长为2的3×3卷积完成下采样;最后,将两个分支的结果合并,在保证输入和输出通道数保持一致性的同时,将特征图压缩为原来的1/2。因此,V7DownSample通过两种下采样有效结合的方式,能够有效缓解由步长为2的卷积下采样带来的特征丢失问题,从而在河蟹检测分割任务中能够更高效地关注不同部位的特征。

图9 V7DownSample结构

Fig.9 V7DownSample structure

2.3 试验平台与评价指标

在本试验中,使用的是PyTorch2.0深度学习框架,其搭建在Windows 11操作系统下的13th Gen Intel(R) Core(TM) i5-13500HX@2.50 GHz(16 GB内存)和NVIDIA GeForce RTX4060 Laptop GPU(8 GB内存)的硬件平台上。整个训练过程设置300周期,读入数据的批量大小设置为8,输入图像大小设置为640×640,初始学习率为0.1,优化器选择SGD。

本文采用平均精度均值(mean average precision,map)、参数量(parameters)、计算量(computation)、模型大小(model size)、F1得分(F1-score,F1)和帧率(frames per second,FPS)作为评价指标,部分指标定义如下

(5)

F1=2×P×R/(P+R),

(6)

FPS=1/T。

(7)

式中:P表示准确率;R表示召回率;T表示模型检测单个图像所需的时间。mAP表示所有类别的平均精度,本文中的mAP是在0.5的IOU阈值下计算的,也称为mAP@0.5。mAP越高则说明模型在检测方面的整体性能更好。F1表示模型准确率和召回率的加权平均值,最大值为1,最小值为0。一般来说,F1分数越高,模型越稳定。FPS表示模型的处理速度,即每秒处理的图像数量。FPS值越高,表示处理速率越快。

3 结果与分析

3.1 主干轻量化结果对比

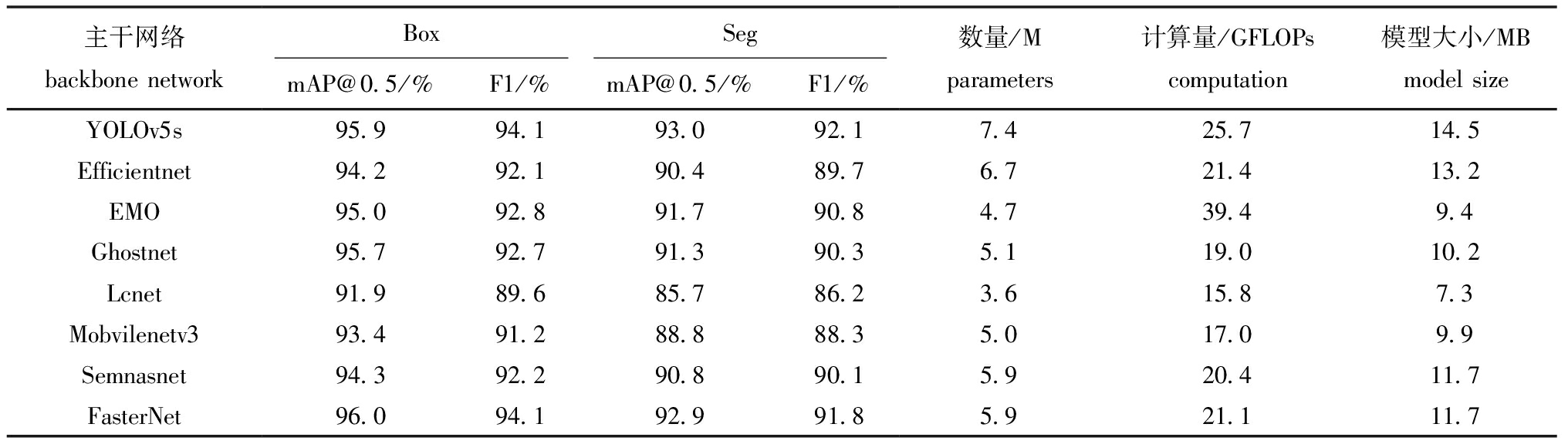

为凸显FasterNet网络在河蟹部位检测分割任务中轻量化效果和优秀性能,在相同的试验环境下,更换当前一些主流的轻量化模型进行对比试验,试验结果见表1。

表1 主干轻量化对比试验结果

Tab.1 Experimental results of trunk lightweighting comparison

主干网络backbonenetworkBoxSegmAP@0.5/%F1/%mAP@0.5/%F1/%数量/Mparameters计算量/GFLOPscomputation模型大小/MBmodelsizeYOLOv5s95.994.193.092.17.425.714.5Efficientnet94.292.190.489.76.721.413.2EMO95.092.891.790.84.739.49.4Ghostnet95.792.791.390.35.119.010.2Lcnet91.989.685.786.23.615.87.3Mobvilenetv393.491.288.888.35.017.09.9Semnasnet94.392.290.890.15.920.411.7FasterNet96.094.192.991.85.921.111.7

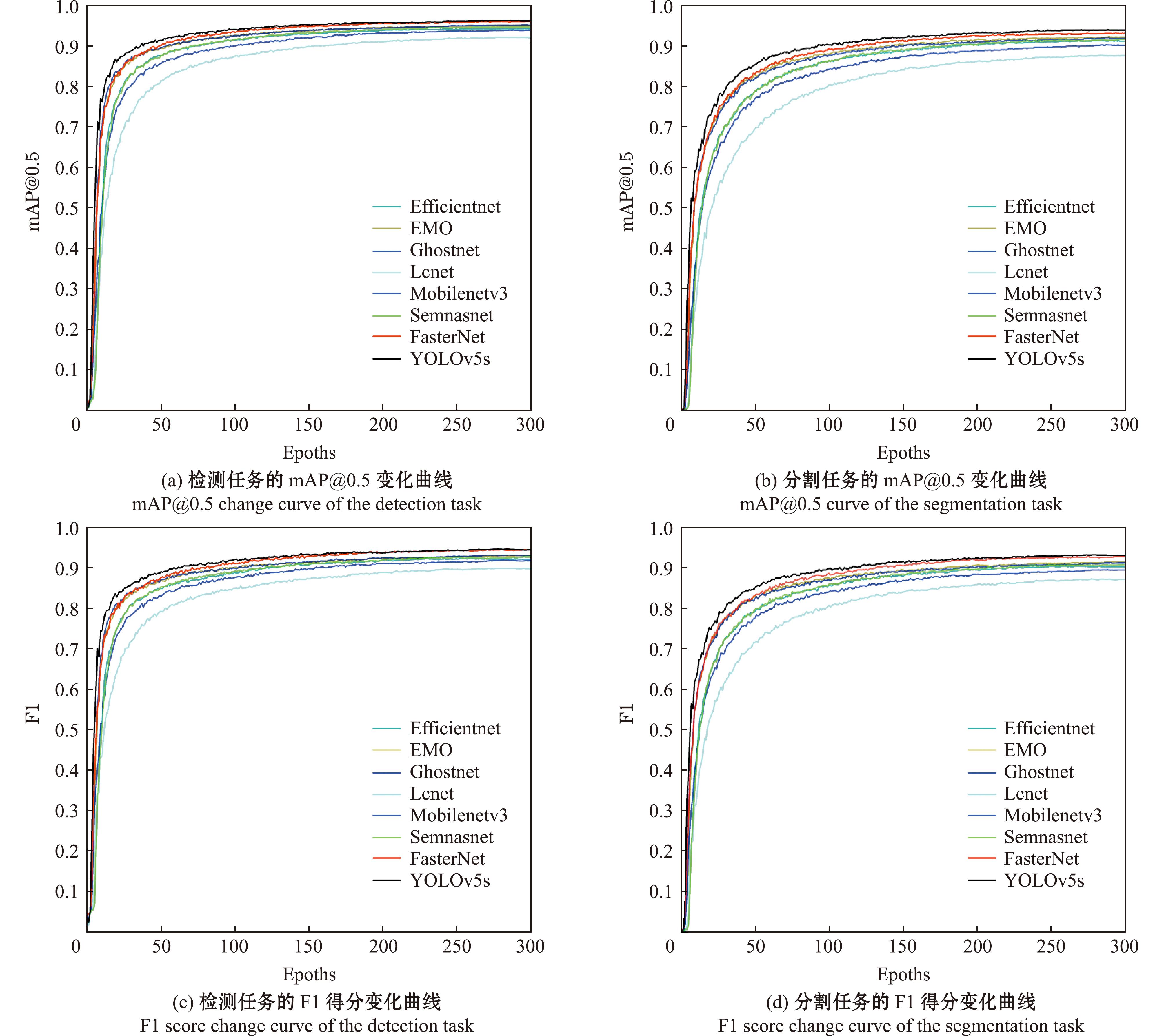

从表1可见,相较于其他轻量化网络,FasterNet主干网络在参数量改善、计算量和模型大小的下降方面表现并非最优秀,但FasterNet网络在河蟹部位检测分割任务中对其不同部位的特征提取能力较强。无论是检测还是分割任务,FasterNet主干网络的mAP@0.5和F1均优于其他轻量级主干网络,在轻量化的同时能够有效保障网络的特征提取能力。这是由于FasterNet通过引入PConv对网络进行特征提取时进行通道选取,丢弃与河蟹关键部位不相关的冗余信息,使得FasterNet在有效增强网络特征提取能力的同时提高系统和内存访问的容错能力,从而保证了更换主干网络后的模型兼具精度和轻量化。相较于YOLOv5s基础模型,其他轻量化主干网络的检测精度和分割精度均下降较多,而FasterNet网络的检测性能和YOLOv5s基础模型相当,分割任务中的mAP@0.5和F1仅比YOLOv5s模型低0.1和0.3个百分点。图10的训练过程曲线结果也显示出FasterNet网络和YOLOv5s模型的检测和分割能力相当,其mAP@0.5和F1曲线接近程度较高,而其他轻量级网络的曲线要明显低于FasterNet网络和YOLOv5s基础模型。

图10 不同主干网络的mAP@0.5和F1训练过程曲线

Fig.10 Curves of mAP@0.5 and F1 training process for different backbone networks

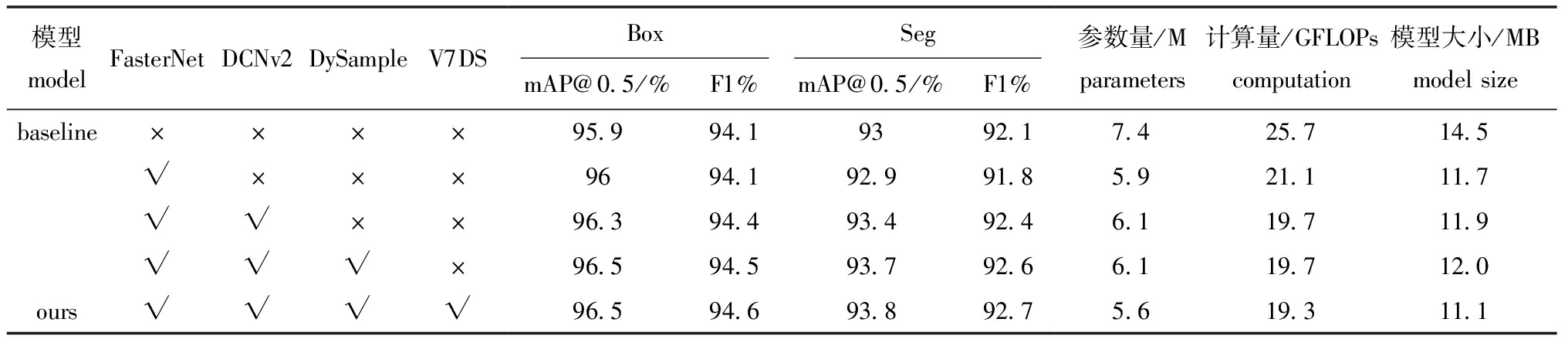

3.2 消融试验

为验证FasterNet、DCNv2、DySample和V7DownSample对模型检测和分割的效果,使用YOLOv5s-Seg模型进行消融试验,结果见表2。

表2 消融试验结果

Tab.2 Results of ablation experiments

模型modelFasterNetDCNv2DySampleV7DSBoxSegmAP@0.5/%F1%mAP@0.5/%F1%参数量/Mparameters计算量/GFLOPscomputation模型大小/MBmodelsizebaseline××××95.994.19392.17.425.714.5√×××9694.192.991.85.921.111.7√√××96.394.493.492.46.119.711.9√√√×96.594.593.792.66.119.712.0ours√√√√96.594.693.892.75.619.311.1

从表2可见,FasterNet引入的PConv具有改进空间特征提取能力和降低冗余计算的能力。首先,将YOLOv5s-Seg模型主干更换为FasterNet后,模型的检测效果和基础模型相当,分割的mAP@0.5下降0.1个百分点,F1下降0.3个百分点,但是模型的参数量、计算量和模型大小分别减少了20.3%、17.9%和19.3%,在只牺牲少量精度的情况下大幅度降低了模型的复杂程度。其次,在更换FasterNet主干后,将DCNv2融合到Neck部位的C3模块中,形成新的C3_DCNv2模块,有效增强了网络的特征融合能力。融合DCNv2后的模型检测的mAP@0.5和F1分别提升0.3个百分点,分割的mAP@0.5和F1分别提升0.5和0.6个百分点,参数量增加了0.2 M,模型大小增加了0.2 MB,C3_DCNv2模块的加入虽然增加了部分模型参数,但网络的整体性能得到了有效提升。之后采用轻量化的DySample上采样,检测的mAP@0.5和F1分别提升0.2和0.1个百分点,分割的mAP@0.5和F1分别提升0.3和0.2个百分点,参数量和计算量基本保持不变,这表明DySample上采样在未增加太多计算成本的同时,能够有效改善河蟹不同部位特征图的表示。最后,将步长为2的卷积下采样替换成结合最大池化和步长卷积的V7DownSample,以缓解下采样时的特征丢失现象。虽然模型的mAP@0.5和F1提升不明显,但V7DownSample模块具有良好的轻量化效果,参数量减少了0.5 M,计算量减少了0.4 GFLOPs,模型大小减少了0.9 MB。消融试验的4个改进层次递进,在提高网络检测和分割效果的同时也在一定程度上减少了网络的计算开销。改进后的YOLOv5s-FDSV模型检测和分割精度均有一定提升,检测的mAP@0.5提升0.6个百分点,F1提升0.5个百分点,分割的mAP@0.5提升0.8个百分点,F1提升0.6个百分点;参数量、计算量和模型大小均有显著减少:分别减少了24.3%、24.9%和23.4%。

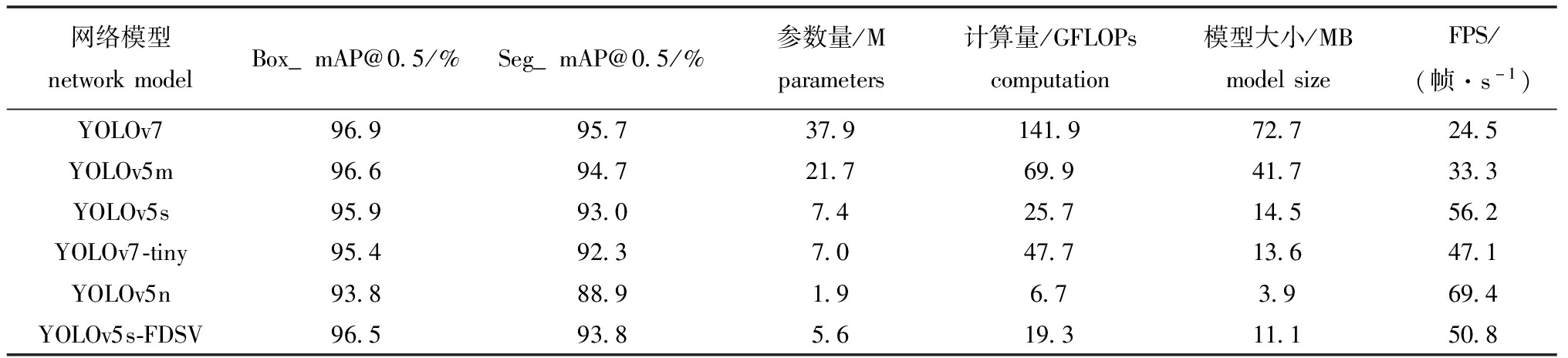

3.3 不同模型结果对比

为进一步评估YOLOv5s-FDSV模型的有效性,选择YOLOv7、YOLOv5m、YOLOv5s、YOLOv7-tiny和YOLOv5n的分割模型进行对比。为了保证试验结果的公平性,在训练过程中所有网络均使用相同的数据集,且未加载官方默认权重。训练完成后,选择精度最高的网络权重,测试环境不变。所有模型的图像输入尺寸均为640×640,使用相同的测试集,共对755张图像进行了综合评价,各目标检测模型在测试完成后的结果见表3。

表3 不同模型结果对比

Tab.3 Comparison among results of different models

网络模型networkmodelBox_mAP@0.5/%Seg_mAP@0.5/%参数量/Mparameters计算量/GFLOPscomputation模型大小/MBmodelsizeFPS/(帧·s-1)YOLOv796.995.737.9141.972.724.5YOLOv5m96.694.721.769.941.733.3YOLOv5s95.993.07.425.714.556.2YOLOv7-tiny95.492.37.047.713.647.1YOLOv5n93.888.91.96.73.969.4YOLOv5s-FDSV96.593.85.619.311.150.8

通过对比,YOLOv7和YOLOv5m检测和分割的mAP要明显高于其他网络,但是这两个模型的网络复杂度较高,参数量、计算量和模型大小要远大于其他模型,且它们的FPS仅为24.5和33.3 帧/s,检测速度较慢。YOLOv5n模型的FPS达69.4 帧/s,检测速度较快,同时网络的参数较小,轻量化效果明显,但是模型的检测分割效果较差,其分割的mAP@0.5只有88.9%,远低于其他网络,不能很好的检测分割河蟹的不同部位。YOLOv5s和YOLOv7-tiny模型的复杂程度相当,但是YOLOv5s检测和分割的mAP@0.5分别比YOLOv7-tiny高0.5和0.7个百分点,同时FPS也比YOLOv7-tiny高9.1 帧/s,因此以YOLOv5s作为基础模型可以获得更高的综合性能。虽然YOLOv5s-FDSV模型的帧率比YOLOv5s低5.4 帧/s,但是网络的检测和分割效果及模型复杂程度都要优于YOLOv5s,且50.8 帧/s的FPS依旧能够满足实时性的需求。

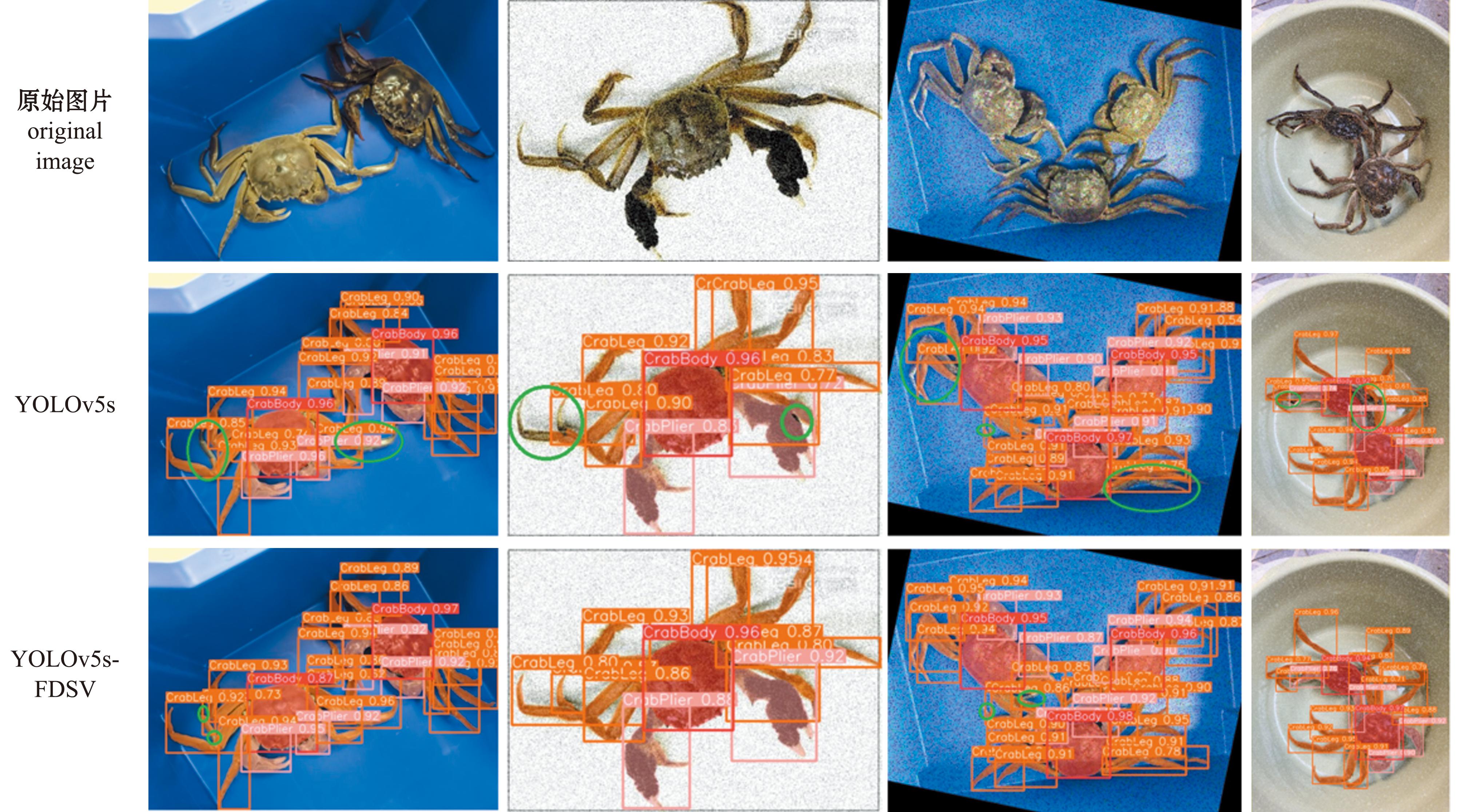

为了更加直观的显示YOLOv5s-FDSV模型的有效性,分别基于YOLOv5s基础模型和改进的YOLOv5s-FDSV模型使用测试集进行检测分割试验,具体效果如图11所示。从图11可见,改进前的YOLOv5s基础模型容易出现漏检和误检的情况,特别是当目标过多和目标较为复杂时,不能很好的获取目标特征信息,导致模型检测分割效果较差。改进后的YOLOv5s-FDSV模型虽然在步足数量较多时,也会出现对步足分割不完全的现象,但是未出现对整个目标的漏检和完全没有分割的现象,相较于改进前较大面积的分割缺失已经得到较大的改善。因此,本文建立的YOLOv5s-FDSV模型能够实现河蟹分部位检测分割的实时性和高效性的需求。

图中红色、粉色和橙色标签分别表示躯干、螯足和步足检测分割部位,绿色标记则表示模型漏检和错检部位。

Red,pink,and orange labels in the figure represent the detection and segmentation sites for the crab body,crab pincers,and crab feet,respectively,while the green markers indicate locations missed or incorrectly identified by the model.

图11 改进前后的检测分割效果图

Fig.11 Effect of detection segmentation before and after improvement

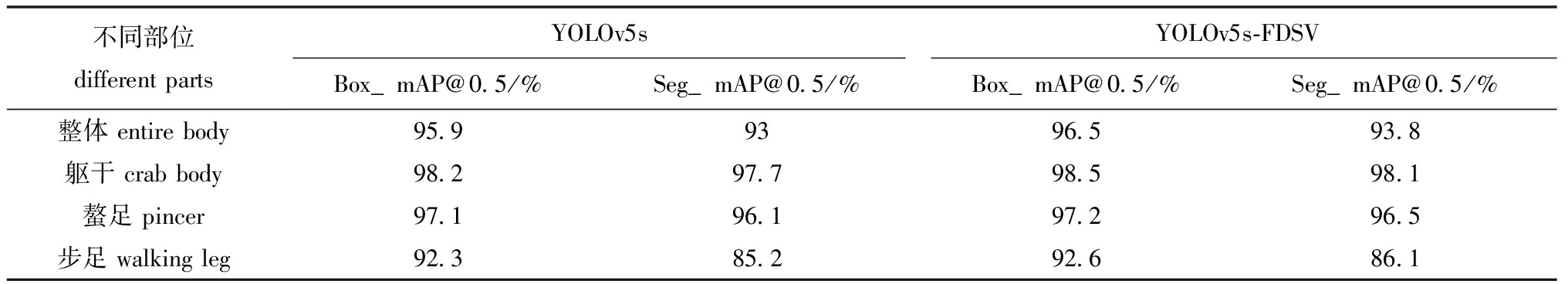

3.4 不同部位检测分割效果分析

河蟹不同部位的特征相差较大且数量存在差异。躯干和螯足数量较少,特征比较明显;步足数量较多,容易出现交叠,且目标相较于其他两类目标较小,这些特征差异会影响各部位的检测分割精度。改进前后的河蟹不同部位检测分割效果见表4。从表4可见,改进后的YOLOv5s-FDSV模型特征信息提取能力较强,躯干、螯足和步足检测分割效果明显提升,尤其是步足部位。但相较于躯干和螯足的检测分割mAP,步足的mAP要低10%左右。这一方面是因为步足轮廓细长,容易与背景中的条状障碍物目标混淆,导致误检;另一方面由于步足数量多、目标较小,容易交叠等原因,使得部分特征信息缺失,从而导致漏检,这使得步足检测精度最低。而躯干和螯足目标较大,特征明显,检测精度较高,且躯干检测精度优于螯足。因此,在实际应用时需要尽量避免多只河蟹步足重叠,并尽量减少类似步足的条状障碍物。

表4 改进前后不同部位检测分割结果

Tab.4 Segmentation results of different parts of the test before and after the improvement

不同部位differentpartsYOLOv5sYOLOv5s-FDSVBox_mAP@0.5/%Seg_mAP@0.5/%Box_mAP@0.5/%Seg_mAP@0.5/%整体entirebody95.99396.593.8躯干crabbody98.297.798.598.1螯足pincer97.196.197.296.5步足walkingleg92.385.292.686.1

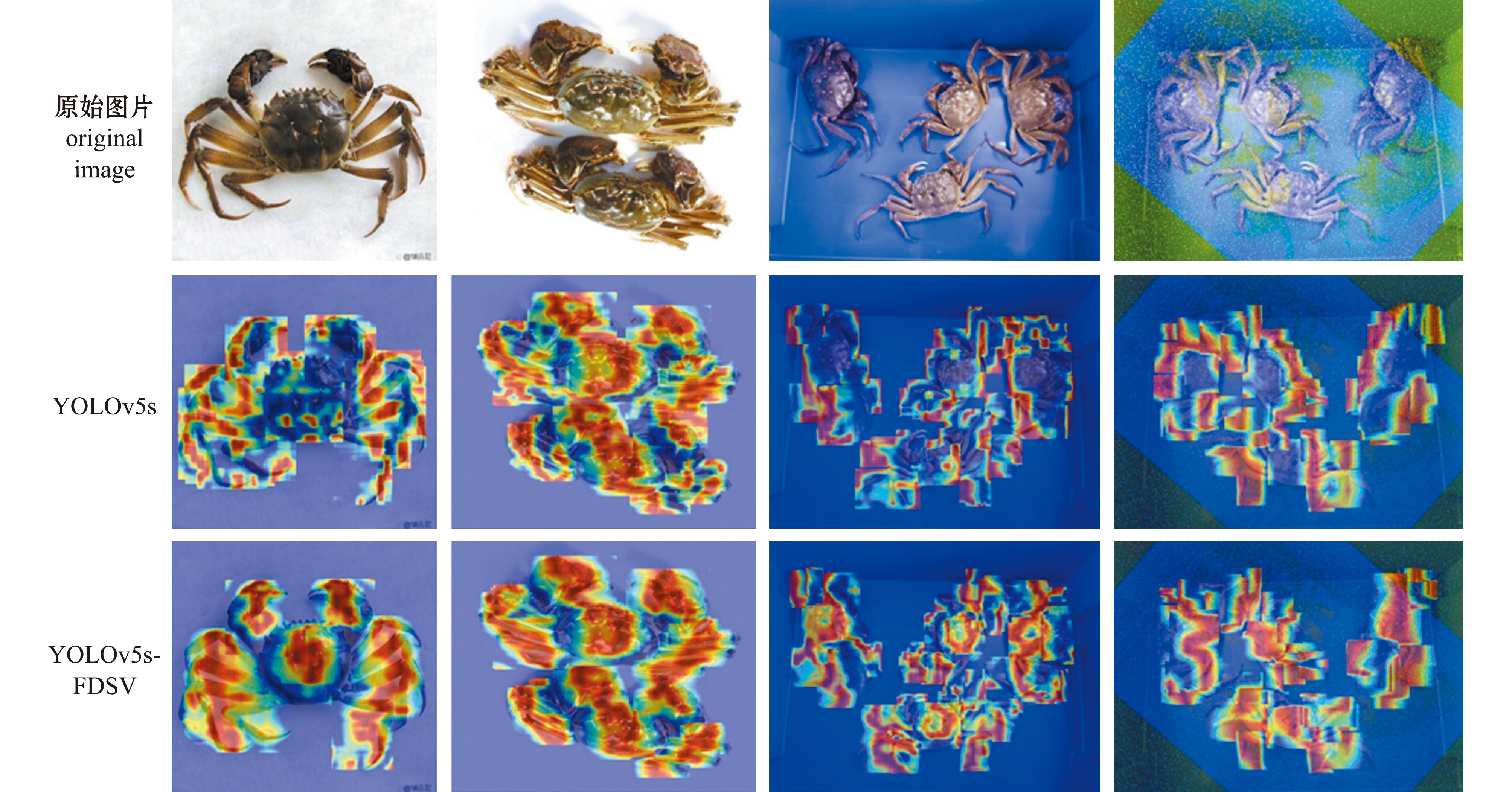

为了更加清晰地显示改进前后模型对于河蟹不同部位的特征关注程度,采用Grad-CAM技术使其特征可视化。为尽可能的展示网络对河蟹部位的特征捕获能力,选择图4中连接Head部位的三层输出层作为可视化对象,因为这三层最靠近输出层,包含了大部分的图像信息。在可视化热图中,颜色越深,对结果的贡献就越大,如图12所示。从图12可见,对于单只和数量较少时,改进前后的模型都能够有效捕获各部位的关键信息。而当数量变多或者图像变得复杂,改进前模型对特征的捕获能力明显下降,出现较大面积的信息获取不全情况。改进后的YOLOv5s-FDSV模型对特征的捕获能力下降不明显,能够提取到大部分关键部位。同时,模型对于躯干、螯足和步足不同部位间的特征获取也存在与表4同样的差异。在改进后的模型热力图中,模型对于躯干和螯足的关注度明显要高于步足,这是因为步足数量较多,且部分步足因为交叠导致目标较小,使得其特征不明显容易出现漏检;而躯干和螯足数量较少,目标较大,整体检测分割准确效果较好。因此,热力图的显示效果进一步证实了改进后YOLOv5s-FDSV模型能够有效地捕获不同部位的关键特征,具有良好的检测分割效果。

图中热点覆盖的区域为模型重点关注特征区域,其中颜色越深,特征对结果的影响越大。由红到绿的变化则表示了由高关注区域到低关注区域的变化。

Areas highlighted by hotspots in the figure represent areas where the model concentrates on features;the darker the color,the greater the influence of the feature on the results.A transition from red to green indicates a shift from a high to a low area of focus.

图12 改进前后模型的热力图比较

Fig.12 Comparison of thermograms of models before and after improvement

4 讨论

4.1 网络模型轻量化对部署的影响

目前,常见的模型轻量化方法主要包括两种。一是直接使用轻量化的主干网络;二是将通用卷积模块替换为深度可分离卷积模块。这两种方法在不同场景中均展现出显著的性能提升和计算效率优化。Lyu等[31]通过在YOLOv5s模型中引入ShuffleNetV2主干网络,提出了一种用于淡水鱼实时分类的轻量化模型。该模型通过优化主干网络架构,使得FLOPs与原模型相比减少了69%,计算速度从10.12帧/秒提升到15.23帧/秒,有效满足了实时性和资源受限环境下的需求。吴志高等[32]以YOLOv7模型为基础框架,创新性地提出了轻量化微藻实时检测模型YOLOv7-MA。通过引入GhostNet作为主干特征提取网络,并将特征融合网络中的普通卷积块替换为深度可分离卷积块,改进后模型的参数量和计算量分别降低了14.63%和66.55%,同时检测速度达到51.86帧/秒,显著提升了性能。类似地,熊俊涛等[33]提出以Mobilenetv3为YOLOv5-Lite主干特征提取网络的轻量化木瓜实时检测模型,该模型实现了92.4%的mAP,模型大小仅为11.3 MB,检测时间仅为7 ms,充分展示了在内存容量有限的嵌入式设备中部署的高适配性。在本研究中,使用FasterNet作为主干特征提取网络,同时集成了轻量化的采样模块,改进后的YOLOv5s-FDSV模型大小仅为11.1 MB,帧率达50.8帧/秒。这与上述研究结果保持一致,在保持模型精度的前提下,不仅有效压缩了模型大小,还显著提升了检测速度,意味着这种轻量化改进方法在算力受限的嵌入式设备上具有良好的适用性。值得注意的是,尽管当前方法已经取得了良好的轻量化效果,但在后续研究中还应继续以轻量化为目标,对模型鲁棒性及部署效率的影响进行深入探索,包括不同设备环境下的性能表现及轻量化策略对多目标检测任务的适应性,以进一步提升模型的通用性和实用价值。

4.2 引入可变形卷积对模型性能的影响

可变形卷积允许卷积核在卷积过程中进行形变,以更好地适应输入数据的局部变化,可比传统卷积更好地处理复杂和多样的数据分布,提高了模型的泛化性。袁红春等[34]提出一种改进YOLOv7-tiny的金枪鱼自动检测与计数算法,该算法通过引入可变性卷积DCNv2增强了对金枪鱼形状特征的捕获能力,增加DCNv2模块后模型的mAP@0.5提升4.2%,但FPS下降了8 帧/s。Ren等[27]以YOLOv5s为基础模型,提出一种用于不规则零件检测轻量化模型,该模型将网络颈部的卷积换成DCNv2卷积,以增强对精密形状零件的特征提取,改进后的模型mAP@0.5提升1.5%,但FPS下降了27 帧/s。赵祚喜等[35]在YOLOv7主干网络中添加可变性卷积DCNv2,mAP提升0.9%,同时改进后模型的检测用时仍有13.1 ms,能够满足破壳鸡蛋在线实时检测。综合上述研究及本文研究结果,引入可变形卷积能够显著提升目标检测模型的精度,但通常伴随着一定程度的检测速度下降。尽管如此,FPS的降低通常处于实际应用可接受的范围之内。在实际场景中,可以通过结合其他轻量化或高效推理模块进行优化,以在保持检测精度的同时,尽量减小速度损失。如与轻量化主干网络、动态推理技术或硬件加速策略等结合使用,以实现性能的综合优化。

4.3 采样模块对模型性能的影响

在深度学习中,上采样通常用于图像放大和特征图还原,旨在恢复细节信息;而下采样则通过缩小图像尺寸,过滤冗余信息以保留关键特征。由于采样操作会直接影响特征图的信息表达形式与分布规律,高效的采样模块对模型准确获取图像信息具有重要作用。Ma等[36]提出一种改进YOLOv5s的密集行人检测算法,并在YOLOv5s的颈部网络中替换DySample采样模块,增强了网络对行人信息的获取,改进后的mAP@0.5提升1.1%。化春键等[37]提出改进YOLOv7的食用玫瑰检测模型,在颈部网络中引入CARAFE轻量级上采样算子对常规的上采样方法进行优化,有效地聚合食用玫瑰花的上下文特征信息,CARAFE上采样模块的引入使得模型mAP@0.5提升0.6%,参数量下降0.1 M。Zheng等[38]设计了一种用于复杂温室环境中番茄检测的YOLOv8-Tomato模型,该模型以YOLOv8为框架,采用DySample模块替代传统的最近邻插值上采样方法,通过动态感知采样点位置实现更精细的上采样,最终使模型mAP@0.5提升0.3%,同时计算量和参数量基本保持不变。本研究与上述工作思路一致,在模型的颈部网络中引入了两种轻量化采样模块,以减少模型参数量,并显著优化特征提取的精确度和鲁棒性,从而在减少模型参数量的前提下,进一步提升网络对河蟹不同部位关键特征信息的捕获能力。

5 结论

1)本研究中提出一种基于改进YOLOv5s-Seg的河蟹不同部位检测分割的轻量级模型YOLOv5s-FDSV,该模型在自建的河蟹不同部位数据集上检测和分割的mAP@0.5分别达96.5%和93.8%,FPS为50.8 帧/s,同时模型整体的参数量仅为5.6 M、计算量为19.3 GFLOPs,模型大小显著减少。该模型能够满足对河蟹不同部位的准确、快速检测分割,能够大幅度提高河蟹加工装备的加工效率。

2)将主干网络更换FasterNet主干后的模型,参数量、计算量和模型相较YOLOv5s-Seg模型分别减少了20.3%、17.9%、19.3%;为弥补主干网络轻量化带来的精度提升不显著现象,通过融合DCNv2卷积、DySample上采样和YOLOv7中的下采样模块进行改进,提升了模型的精度,实现了轻量化和检测效果兼顾,同时为鱼虾等水产品加工装备中的检测分割提供了研究思路。

3)本研究中提出的YOLOv5s-FDSV模型mAP@0.5相较于YOLOv5n、YOLOv5s和YOLOv7-tiny模型,FPS和轻量化效果要优于YOLOv5m和YOLOv7,显示出YOLOv5s-FDSV模型在河蟹不同部位分割检测上的综合性优势,适宜部署在算力资源不足的设备中。

[1] 钟梅英,郭亚,胡凯,等.基于文献计量学与知识图谱的中华绒螯蟹研究进展与趋势分析[J].农业工程学报,2022,38(3):311-322.ZHONG M Y,GUO Y,HU K,et al.Advances and trends in the research of Eriocheir sinensis based on bibliometrics and knowledge graph[J].Transactions of the Chinese Society of Agricultural Engineering,2022,38(3):311-322.(in Chinese)

[2] WANG D Y,VINSON R,HOLMES M,et al.Convolutional neural network guided blue crab knuckle detection for autonomous crab meat picking machine[J].Optical Engineering,57(4):1.

[3] 农业农村部渔业渔政管理局,全国水产技术推广总站,中国水产学会.2022中国渔业统计年鉴[M].北京:中国农业出版社,2022.Bureau of Fisheries,Ministry of Agriculture and Rural Affairs,National Fisheries Technology Extension Center,China Society of Fisheries.2022 China Fishery Statistical yearbook[M].Beijing:China Agriculture Press,2022.(in Chinese)

[4] 中国大闸蟹行业发展趋势研究与未来投资预测报告(2023-2030年)[EB/OL].观研报告网 http://www.chinabaogao.com/baogao/202309/666708.html.China Hairy Crab Industry Development Trend Research and Future Investment Forecast Report (2023-2030)[EB/OL].ViewReport.com.http://www.chinabaogao.com/baogao/202309/666708.html.(in Chinese)

[5] 鄢铭亮.河蟹去壳装备的设计与研究[D].上海:上海海洋大学,2021.YAN M L.Design and research of crab shelling equipment[D].Shanghai:Shanghai Ocean University,2021.(in Chinese)

[6] 赵煜,朱旭,朱建平,等.带壳类水产品的壳肉分离技术研究进展[J].大连海洋大学学报,2023,38(6):1083-1096.ZHAO Y,ZHU X,ZHU J P,et al.Research progress on shell-meat separation technology of shelled aquatic products:a review[J].Journal of Dalian Ocean University,2023,38(6):1083-1096.(in Chinese)

[7] 欧阳杰,虞宗敢,周荣,等.机械式壳肉分离加工河蟹的研究[J].现代食品科技,2012,28(12):1730-1733.OUYANG J,YU Z G,ZHOU R,et al.Experimental study of mechanical separation of crab shell and meat[J].Modern Food Science and Technology,2012,28(12):1730-1733.(in Chinese)

[8] 陈超,李彤,张拥军,等.蟹脚壳肉分离装置的设计与试验[J].农业工程学报,2016,32(23):297-302.CHEN C,LI T,ZHANG Y J,et al.Design and experiment of crab legs' shell and meat separation mechanism[J].Transactions of the Chinese Society of Agricultural Engineering,2016,32(23):297-302.(in Chinese)

[9] TOMOD A,HIROSH I,END O,et al.Crab processing device and crab processing method[P].CA2962992C.

[10] VO T T E,KO H,HUH J H,et al.Overview of smart aquaculture system:focusing on applications of machine learning and computer vision[J].Electronics,2021,10(22):2882.

[11] WANG H,ZHU H,BI L S,et al.Quality grading of river crabs based on machine vision and GA-BPNN[J].Sensors,2023,23(11):5317.

[12] THAYANANTHAN T,ZHANG X,LIU W B,et al.Automating catfish cutting process using deep learning-based semantic segmentation[C]//Sensing for Agriculture and Food Quality and Safety XV.Orlando,USA.SPIE,2023:12345:103-116.

[13] 陈学深,吴昌鹏,党佩娜,等.基于改进轻量化YOLOv4模型的虾只肉壳辨识方法[J].农业工程学报,2023,39(9):278-286.CHEN X S,WU C P,DANG P N,et al.Improved lightweight YOLOv4 model-based method for the identification of shrimp flesh and shell[J].Transactions of the Chinese Society of Agricultural Engineering,2023,39(9):278-286.(in Chinese)

[14] 万鹏,黄毓毅,汪荣,等.基于机器视觉的鲐鱼鱼体定向排列输送装置设计与试验[J].农业工程学报,2023,39(14):271-282.WAN P,HUANG Y Y,WANG R,et al.Design and experiments of the machine vision-based body orientation arrangement convey device for the Scomber japonicus[J].Transactions of the Chinese Society of Agricultural Engineering,2023,39(14):271-282.(in Chinese)

[15] 杨珍,龚惟新,李凯,等.高架草莓的果实识别与果梗分割[J].农业工程学报,2023,39(17):172-181.YANG Z,GONG W X,LI K,et al.Fruit recognition and stem segmentation of the elevated planting of strawberries[J].Transactions of the Chinese Society of Agricultural Engineering,2023,39(17):172-181.(in Chinese)

[16] 马冬梅,郭智浩,罗晓芸.改进YOLOv5s-Seg的高效实时实例分割模型[J].计算机工程与应用,2024,60(16):258-268.MA D M,GUO Z H,LUO X Y.Improved efficient real-time instance segmentation model based on YOLOv5s-seg[J].Computer Engineering and Applications,2024,60(16):258-268.(in Chinese)

[17] LIU S,QI L,QIN H F,et al.Path aggregation network for instance segmentation[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Salt Lake City,UT,USA.IEEE,2018:8759-8768.

[18] WANG C Y,YEH I H,LIAO H M.You only learn one representation:unified network for multiple tasks[EB/OL].2021:2105.04206.https://arxiv.org/abs/2105.04206v1.

[19] LONG J,SHELHAMER E,DARRELL T.Fully convolutional networks for semantic segmentation[C]//2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Boston,MA,USA.IEEE,2015:3431-3440.

[20] LU A G,MA L Z,CUI H,et al.Instance segmentation of Lotus pods and stalks in unstructured planting environment based on improved YOLOv5[J].Agriculture,2023,13(8):1568.

[21] CHEN J R,KAO S H,HE H,et al.Run,don’t walk:chasing higher FLOPS for faster neural networks[C]//2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).Vancouver,BC,Canada.IEEE,2023:12021-12031.

[22] ZHU X Z,HU H,LIN S,et al.Deformable ConvNets V2:more deformable,better results[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).Long Beach,CA,USA.IEEE,2019:00953.

[23] LIU W Z,LU H,FU H T,et al.Learning to upsample by learning to sample[C]//2023 IEEE/CVF International Conference on Computer Vision (ICCV).Paris,France.IEEE,2023:15085.

[24] WANG C Y,BOCHKOVSKIY A,LIAO H M.YOLOv7:trainable bag-of-freebies sets new state-of-the-art for real-time object detectors[C]//2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).Vancouver,BC,Canada.IEEE,2023:7464-7475.

[25] THAKOR V A,RAZZAQUE M A,KHANDAKER M R A.Lightweight cryptography algorithms for resource-constrained IoT devices:a review,comparison and research opportunities[J].IEEE Access,2021,9:28177-28193.

[26] DAI J F,QI H Z,XIONG Y W,et al.Deformable convolutional networks[C]//2017 IEEE International Conference on Computer Vision (ICCV).Venice.IEEE,2017:89.

[27] REN H P,DONG L,JIN Y G,et al.Study on the lightweighting of YOLOv5s model for precise detection of irregular-shaped components[J].Frontiers in Computing and Intelligent Systems,2024,6(3):75-80.

[28] 田萱,王亮,丁琪.基于深度学习的图像语义分割方法综述[J].软件学报,2019,30(2):440-468.TIAN X,WANG L,DING Q.Review of image semantic segmentation based on deep learning[J].Journal of Software,2019,30(2):440-468.(in Chinese)

[29] YANG H B,QIU S.A novel dynamic contextual feature fusion model for small object detection in satellite remote-sensing images[J].Information,2024,15(4):230.

[30] GHOLAMALINEZHAD H,KHOSRAVI H.Pooling methods in deep neural networks,a review[EB/OL].2020:2009.07485.https://arxiv.org/abs/2009.07485v1.

[31] LYU C,ZHONG W C,LIU S.Improved YOLOv5s for typical carp target detection[J].Aquaculture International,2024,32(4):4869-4884.

[32] 吴志高,陈明.基于改进YOLO v7的微藻轻量级检测方法[J].大连海洋大学学报,2023,38(1):129-139.WU Z G,CHEN M.Lightweight detection method for microalgae based on improved YOLO v7[J].Journal of Dalian Ocean University,2023,38(1):129-139.(in Chinese)

[33] 熊俊涛,韩咏林,王潇,等.基于YOLO v5-Lite的自然环境木瓜成熟度检测方法[J].农业机械学报,2023,54(6):243-252.XIONG J T,HAN Y L,WANG X,et al.Method of maturity detection for Papaya fruits in natural environment based on YOLO v5-lite[J].Transactions of the Chinese Society for Agricultural Machinery,2023,54(6):243-252.(in Chinese)

[34] 袁红春,史经伟.基于改进YOLOv7-tiny和动态检测门的金枪鱼自动检测与计数研究[J].渔业现代化,2023,50(6):74-83.YUAN H C,SHI J W.A study of automatically detecting and counting tunas based on improved YOLOv7-tiny and dynamic detection gate[J].Fishery Modernization,2023,50(6):74-83.(in Chinese)

[35] 赵祚喜,魏洪飞,黄渊,等.基于改进YOLOv7的破壳鸡蛋在线实时检测系统[J].农业工程学报,2023,39(20):255-265.ZHAO Z X,WEI H F,HUANG Y,et al.Online real-time detection system for cracked eggs using improved YOLOv7[J].Transactions of the Chinese Society of Agricultural Engineering,2023,39(20):255-265.(in Chinese)

[36] MA Y X.FDV-YOLO:a target detection network for dense pedestrian detection[C]//2024 5th International Conference on Computer Engineering and Application (ICCEA).Hangzhou,China.IEEE,2024:1333-1336.

[37] 化春键,黄宇峰,蒋毅,等.基于改进YOLOv7的田间环境下食用玫瑰检测方法[J/OL].南京农业大学学报,1-13[2024-10-24].http://kns.cnki.net/kcms/detail/32.1148.s.20240531.1618.002.html.HUA C J,HUANG F Y,JIANG Y,et al.Method for detecting edible roses in field environment based on improved YOLOv7[J/OL].Journal of Nanjing Agricultural University,1-13[2024-10-24].http://kns.cnki.net/kcms/detail/32.1148.s.20240531.1618.002.html.(in Chinese)

[38] ZHENG S H,JIA X X,HE M L,et al.Tomato recognition method based on the YOLOv8-tomato model in complex greenhouse environments[J].Agronomy,2024,14(8):1764.