图1 血鹦鹉视频拍摄

Fig.1 The video shooting of blood parrot

近年来,随着经济快速增长和人们生活品质的提高,观赏鱼养殖和文化欣赏逐步进入大众视野,观赏鱼市场得到了迅速发展,2023年中国观赏鱼产业相较于2022年增长16.93%,全国观赏鱼产值突破百亿,达到110.92亿元[1]。不论是海洋水族馆还是家庭养殖,观赏鱼均深受人们喜爱。观赏鱼的行为和生长状态是影响观赏鱼养殖中的一个重要因素,通过对鱼类行为和生长状态进行长期监测,可以收集有关鱼类生活习性和其所处环境的重要数据。受水质、光线和噪声等因素的干扰,鱼类监测一直是个难点[2-3]。过去养殖人员和研究人员只能依靠人工进行观察和记录,需要耗费大量人力。现在利用机器视觉进行自动监测效率大幅提高,从而可以帮助研究者更加深入地探索观赏鱼的生态环境,提高观赏鱼的养殖效率和质量,同时也能给观赏鱼爱好者增加欣赏乐趣。

目前,国内外的观赏鱼检测追踪方法主要有两类:一是传统图像处理方法,包括背景提取、边缘检测和形态学处理等,但这些方法普遍精度较低,容易受光线和噪声等因素的干扰,对相似度较高的鱼类无法准确分辨,且在长期观测中会出现漏检和误检;二是基于深度学习的图像处理方法,即使用卷积神经网络CNN(convolutional neural networks)和循环神经网络RNN(recurrent neural network)对观赏鱼进行有效检测和跟踪,该方法相较于传统方法精度有了大幅提升,不足是需要大量标注数据训练,且需要算力较高的运算设备。

深度学习在鱼类的识别领域也已经有了广泛的应用[4-7]。深度学习主要利用CNN进行图像处理任务,可以自动从图像中提取所需要的特征。但由于视频是由连续不断的图像帧组成,这些图像帧之间存在着时间上的连续性,代表了图像在不同时间点上的动态变化过程。而CNN处理范围仅限于静态图像,缺乏对视频中随时间变化图像的处理能力,故CNN并不能直接用来处理视频。因此,可以利用基于深度学习的行为识别技术处理视频[8],通过依次对时间轴中的图像信息进行识别来实现完整的视频检测任务,如视频分类、行为识别和目标跟踪等[5,9-10]。目前,主流的目标检测算法分为两类,即单阶段目标检测算法和双阶段目标检测算法。常见的单阶段目标检测算法包括YOLO系列算法、SSD(single shot multibox detector)等,特点是速度快,可以实现实时检测。常见的双阶段目标检测算法包括基于区域的卷积神经网络R-CNN(regionbased convolutional neural networks)系列算法和Faster R-CNN[11-15]等,其主要特点是准确性高,对于小目标和密集目标的检测效果更好,模型检测精度相对较高,但由于需要多次计算候选区域,因此,检测速度较慢。

YOLOv8[16]模型采用轻量化的模型架构和多尺度训练技术,在保证高精度检测和快速检测的同时凭借其较小的体积可部署到更多的设备上。而ByteTrack则基于在线学习和轨迹预测,能够完成对运动目标的准确跟踪,解决了目标漏检和误检的问题,在保证提高精度的同时可降低设备成本,方便应用在不同条件下的场景。

本研究中,针对观赏鱼检测与追踪所面临的问题,选择血鹦鹉(Vieja synspila♀×Amphilophus citrinellus♂)的监测视频作为数据来源,使用PotPlayer将视频截图产生足够的数据集,采用YOLOv8n-BiFormer对视频进行逐帧检测和标注,最后使用ByteTrack对检测到的物体进行追踪,并将该方法用于慈鲷(Chindongo demasoni)检测与追踪以验证该方法的通用性,以期为实现对观赏鱼的准确检测和追踪提供技术参考。

使用5 000万像素的索尼IMX766摄像机拍摄视频,摄像机参数:OIS激光对焦F1.4~F4.0六挡光圈,采用RYYB感光阵列,配合OIS光学防抖,3 840×2 160像素,帧率为30 fps。摄像机放置在水族箱外正前方,拍摄血鹦鹉的位置和运动轨迹。图1展示了数据视频的拍摄场景。

图1 血鹦鹉视频拍摄

Fig.1 The video shooting of blood parrot

本研究中,选取血鹦鹉作为研究目标,原因是血鹦鹉不仅为一种色彩斑斓、动态活跃的水生宠物,其大小适中、特点明显,而且其具有较高的观赏价值和商业价值。

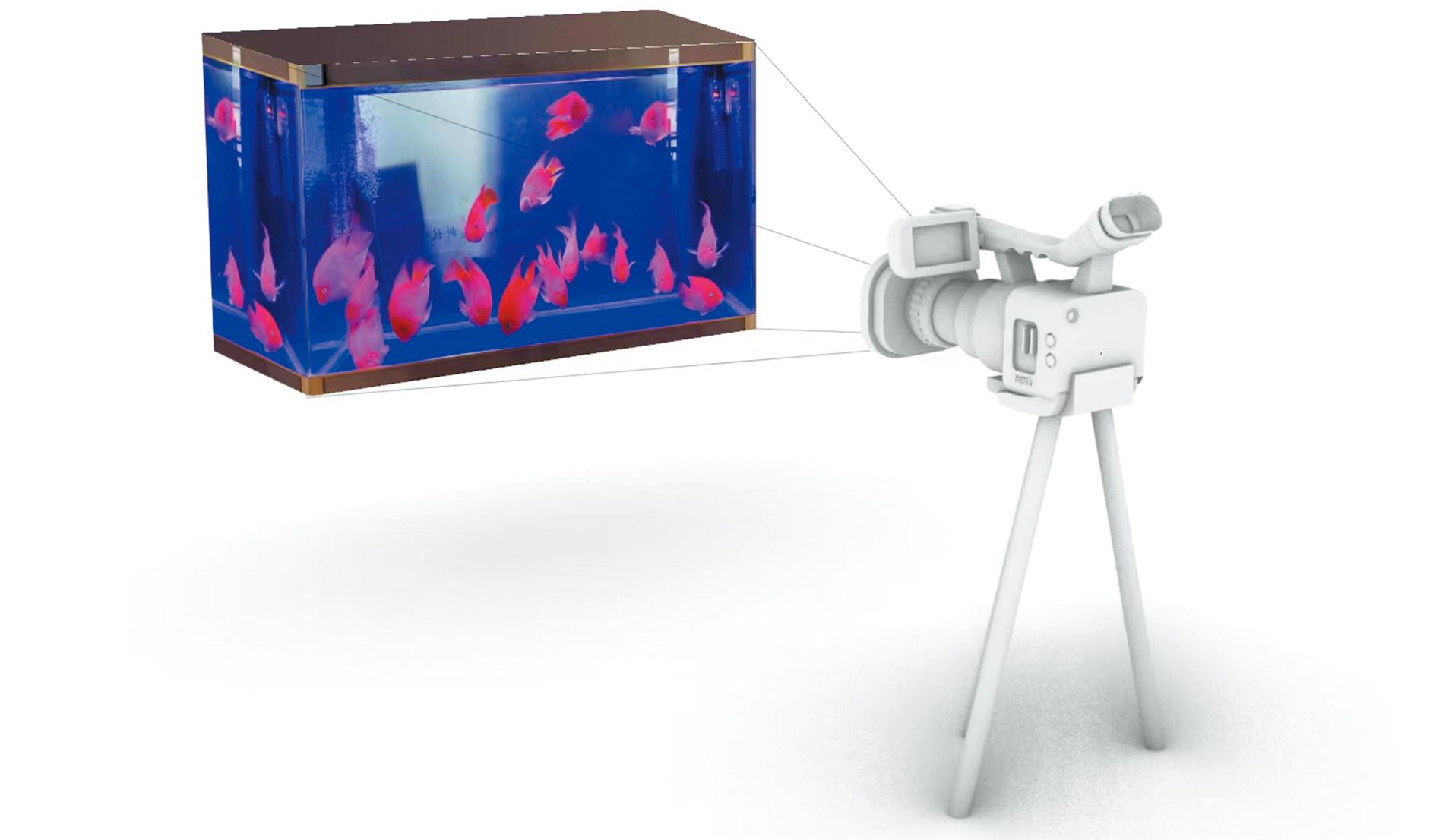

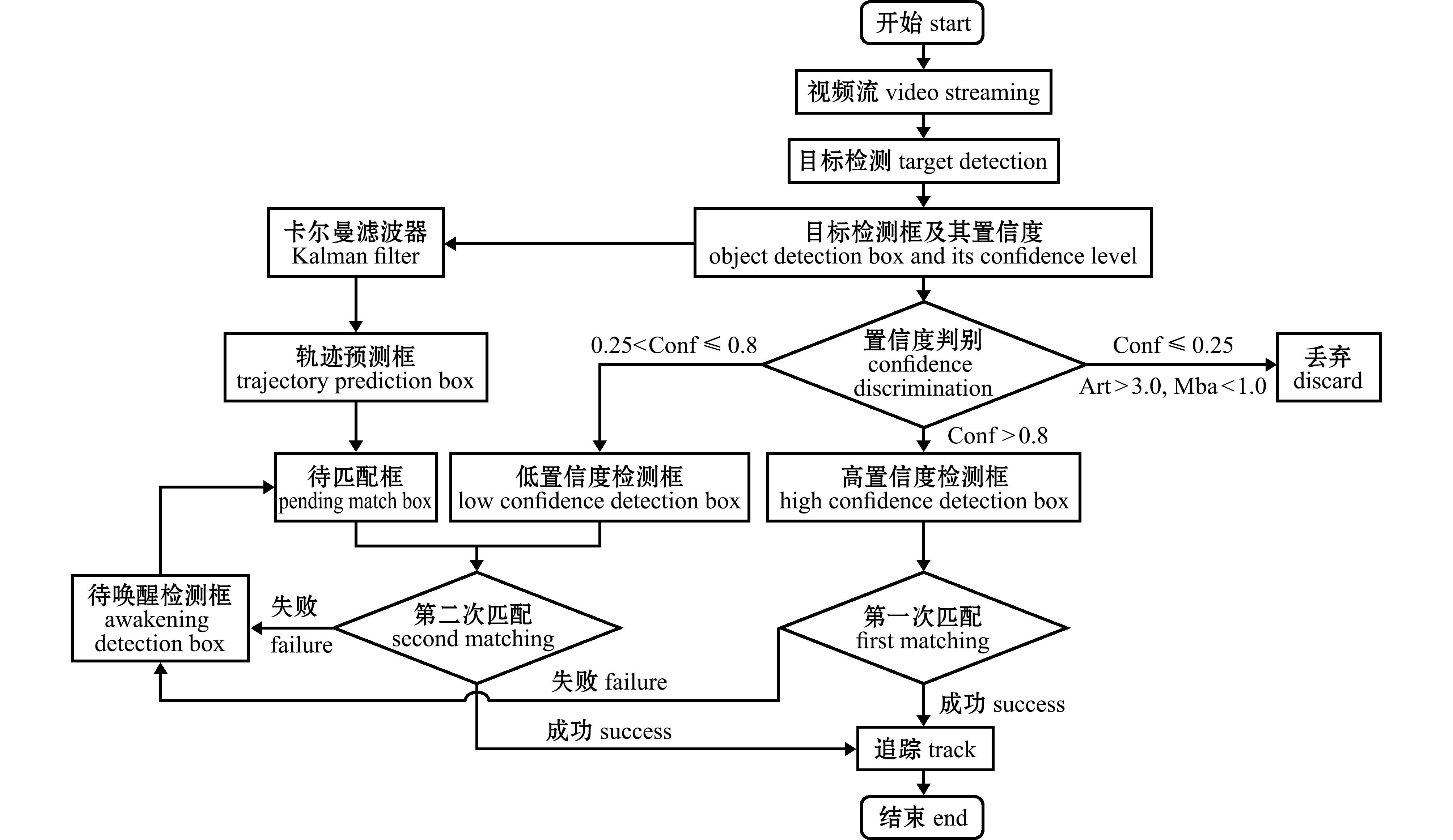

首先对拍摄到的视频进行筛选,删除模糊和血鹦鹉动作较少的视频,选取一段时长为1 min的视频。其次使用PotPlayer软件对视频进行逐帧截取,得到模型检测所需的1 500张图像数据,删除一些不符合的图片。最后使用LabelImg软件在图像上对血鹦鹉进行标注,类别命名为“鹦鹉鱼”,标注后会生成带有位置坐标和类别名称的txt文件。将标注后的数据按照7∶2∶1的比例分为训练集、测试集和验证集。在标注和划分结束后,将图像进行水平翻转90°、顺时针旋转15°,增加5%噪声、25%灰度和40%亮度等操作进行数据增强,这样可以增加训练数据集的多样性,提高模型的鲁棒性。最终得到3 900张图像66 300个血鹦鹉目标,其中,训练集2 730张图片,测试集780张图片,验证集390张图片,并形成coco格式的数据集。慈鲷数据集的制作方法与血鹦鹉数据集的制作方法相同。不同增强效果下的图像如图2所示。

图2 不同增强效果下的图像

Fig.2 Images under different augmentation effects

YOLOv8是基于Python和PyTorch构建的目标检测网络模型,其整体架构主要分为3个部分:骨干网络部分(Backbone)、颈部网络部分(Neck)和检测头网络部分(Head)。其中,Backbone为网络的主干,常用骨干网络包括VGG(visual geometry group)、ResNet(residual network)[17]、DarkNet(darknet neural network framework)[18]等。相比于YOLOv7与YOLOv5等YOLO版本,YOLOv8模型将Neck和Backbone的C3模块更换为了C2f模块,在Head部分更换为解耦头结构并加入了新的损失函数,大幅提升了模型性能。YOLOv8模型更新了检测、分类、分割和追踪4类任务,训练速度大幅增强,在检测精度方面也有提升,更加适合小目标检测。此外,YOLOv8模型提供了完整的PyTorch代码,可以直接使用并进行自定义训练,同时还提供了已经预训练好的模型权重,方便快速迁移学习或应用到实际项目中。

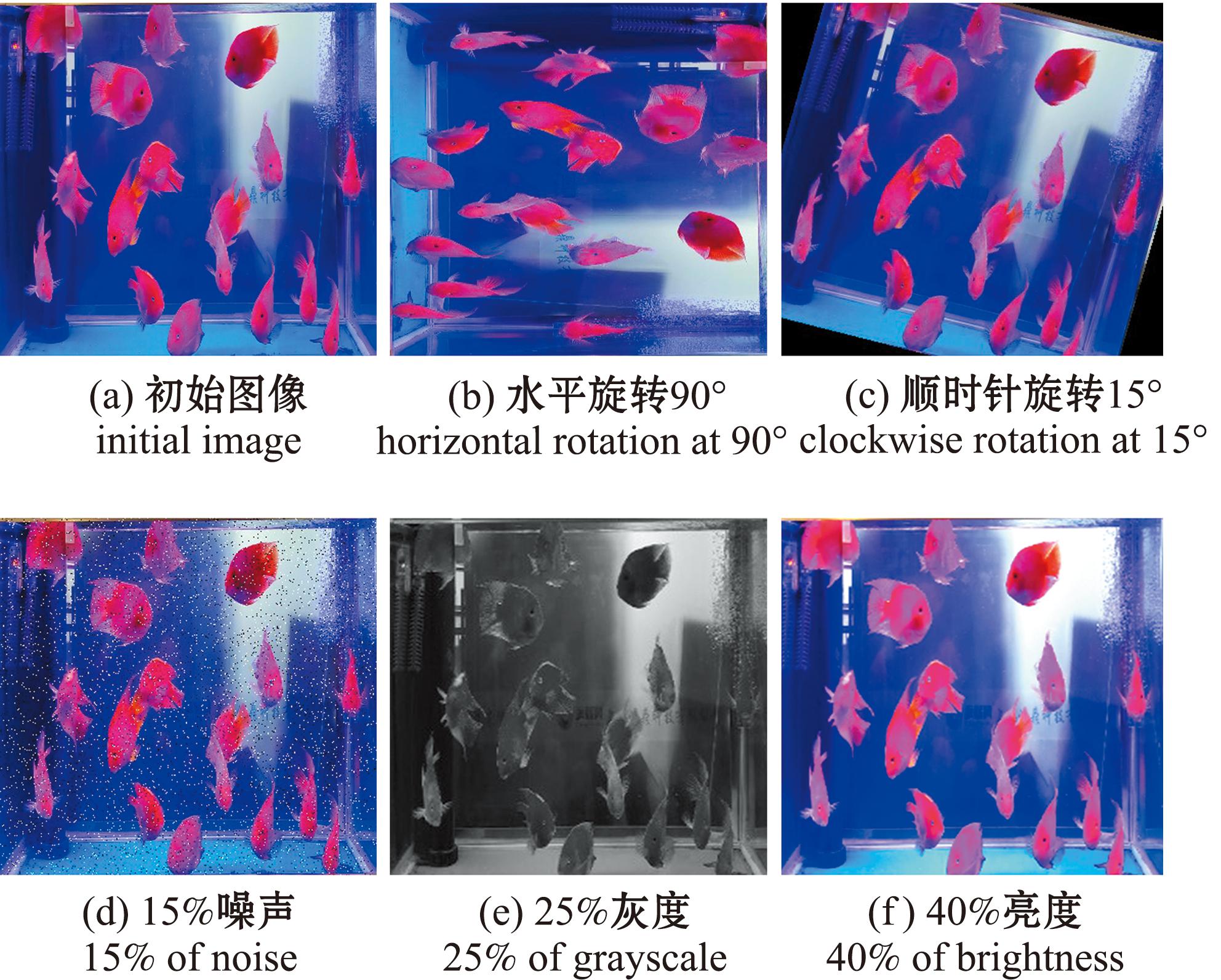

在目标检测基础上对血鹦鹉的视频信息进行统计,由于水族箱中的血鹦鹉不止一尾且一直在移动,故同一时间的视频图像中会出现不止一个目标。为此,本研究中选择使用基于目标检测的多目标跟踪算法ByteTrack[19]对血鹦鹉进行目标跟踪。ByteTrack算法利用了一种新的目标跟踪方法,即点线集成(point-line integration,PLI)跟踪。与传统的目标跟踪算法不同,PLI跟踪将目标表示为点和线的集合,并通过这些点和线之间的联系进行目标跟踪。ByteTrack目标跟踪算法整体流程图见图3。

图3 ByteTrack算法流程

Fig.3 Flowchart of the improved ByteTrack algorithm

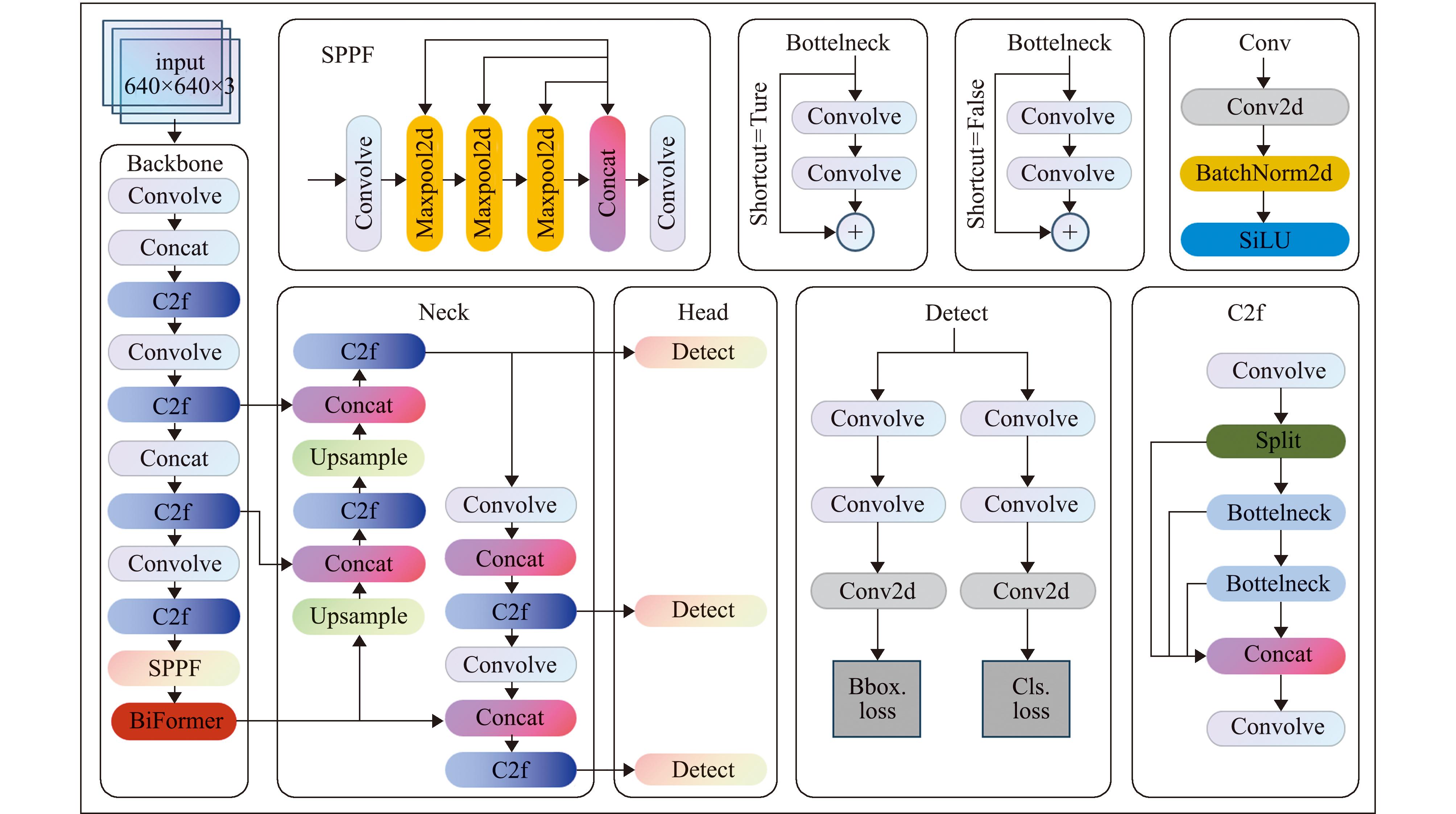

双层路由注意力机制是一种新的动态稀疏注意力机制,其通过粗区域级别筛选出不相关的键值对,只在剩下的路由区域应用令牌到令牌的注意来减少内存和计算量。BiFormer视觉变化器主干是双层路由机制的关键部分,可以帮助双层路由注意力寻找相关度最高的键令牌部分。BiFormer视觉变化器的添加位置为骨干网络和头部之间,这样有助于对骨干网络提取的特征进行更多关注。注意力机制可以促进骨干网络和头部之间的信息传递和融合,通过学习到的注意力权重,网络可以根据骨干网络提取特征的重要性,选择性地融合这些特征到头部网络中,更好地适应不同尺度的目标或场景。图4为YOLOv8n-BiFormer网络结构。

图4 YOLOv8n-BiFormer网络结构

Fig.4 The network structure of YOLOv8n-BiFormer

试验基于Ubuntu 18.04操作系统、Python 3.10.11编程语言和Pytorch 1.8.2深度学习框架。CPU配置为Intel(R) Core(TM) i5-8300H CPU @2.30 GHz,Cuda 版本为 Cuda 12.0,GPU为NVIDIA GeForce RTX 4060ti。模型训练时使用的部分超参数设置:初始学习率为 0.001,batchsize 为16,迭代次数为150,优化器为随机梯度下降算法。

在检验模型效果时,采用准确率(precision,P)、召回率(recall,R)、模型参数量(parameters)、查准率与查全率(P-R)曲线、F1曲线、平均精度均值(mAP@0.5)、置信度为95%的平均绝对误差(mAP@0.95)来评估目标检测模型的性能。P-R曲线可以直观地显示出样本的精确率和召回率在总体数据上的关系,曲线与坐标轴围成的面积为类别平均精度(AP)和各类平均精度的均值(mAP)。mAP@0.5值越高代表模型检测物体位置的能力越强,mAP@0.95值越高代表模型在不同的场景应用需求下均可以达到较好的检测准确率。

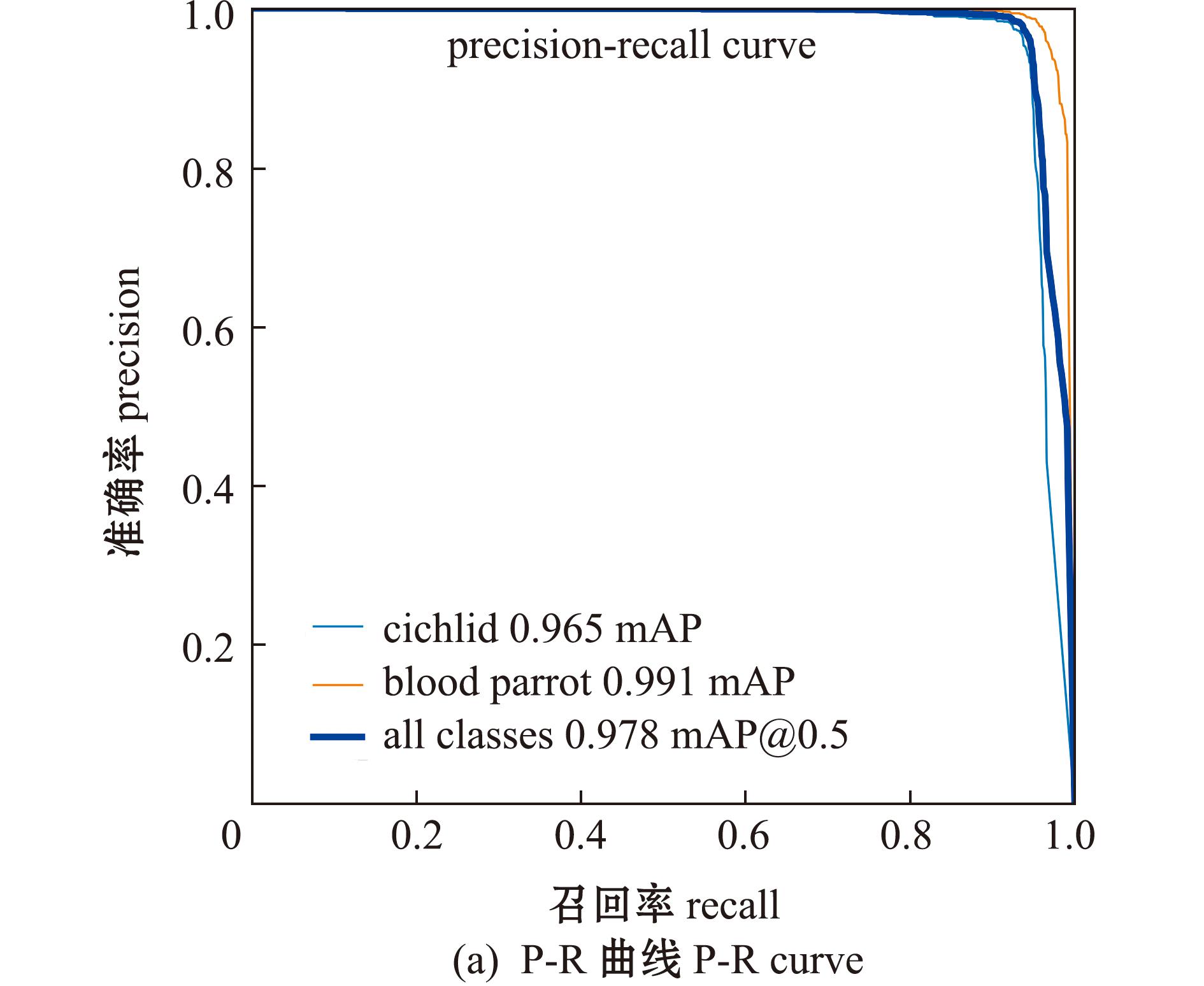

3.3.1 模型精度曲线 图5(a)为改进后模型YOLOv8n-BiFormer的总体及两类目标在测试集上的P-R曲线对比图,其中,血鹦鹉(yingwuyu)和慈鲷(cichlid)的平均精度分别为0.991和0.965,两类平均精度的均值(mAP@0.5)为0.978。

图5 YOLOv8n-BiFormer模型的P-R曲线和F1曲线

Fig.5 P-R curve and F1 curve of YOLOv8n-BiFormer model

图5(b)为YOLOv8n-BiFormer模型的总体及两类目标在测试集上的F1得分图,其中,置信度在0.4~0.8上取得了比较高的F1分值,在置信度为0.486时,两类平均F1分值取得了最大值(0.964)。

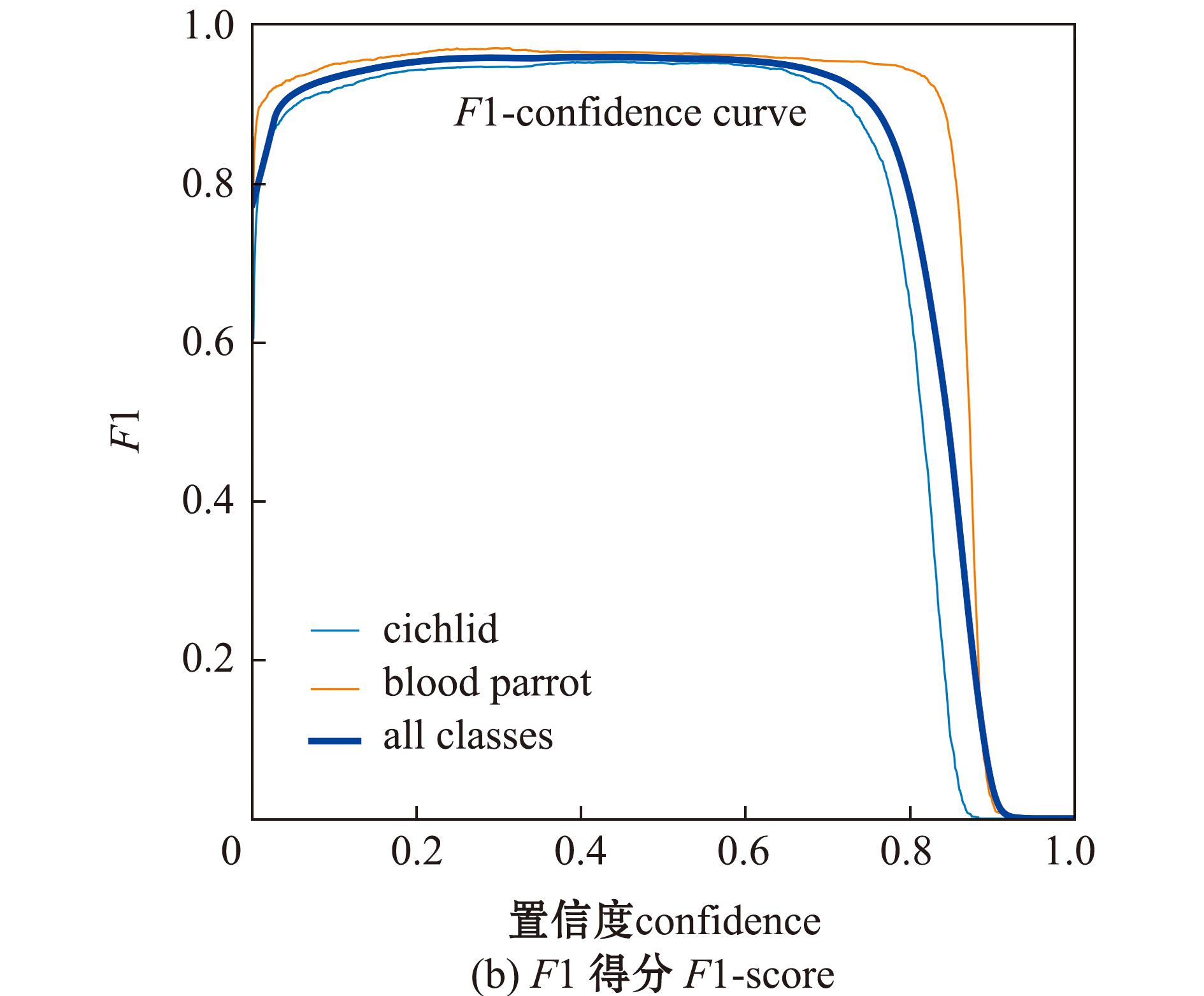

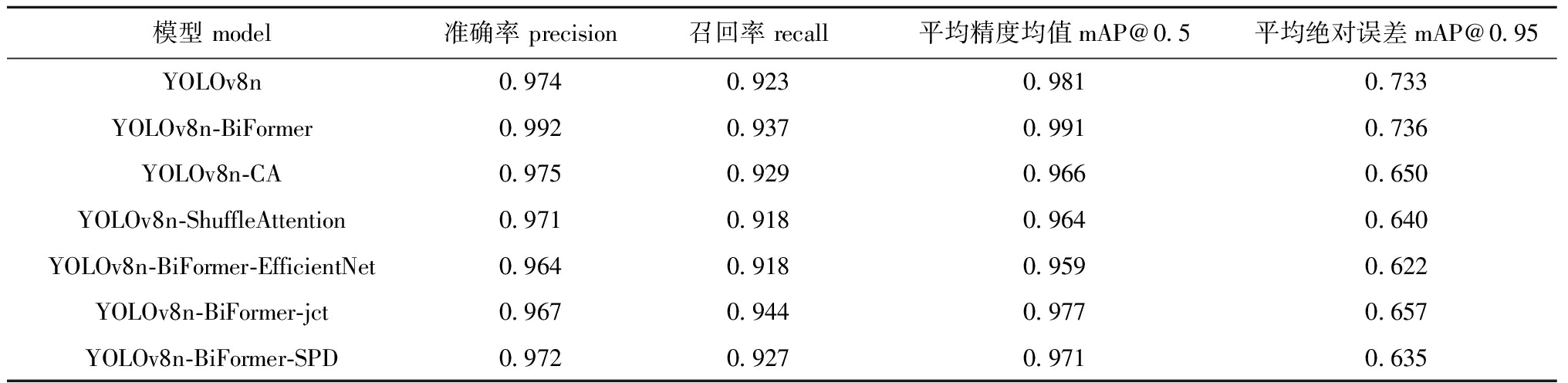

3.3.2 消融试验 为了验证模型改进的有效性,设计了YOLOv8n、YOLOv8n-BiFormer-EfficientNet、YOLOv8n-BiFormer、YOLOv8n-CA、YOLOv8n-ShuffleAttention、YOLOv8n-BiFormer-jct和YOLOv8n-BiFormer-SPD模型的消融试验。YOLOv8n-BiFormer模型是指在YOLOv8n的基础上加入双层路由注意力机制;YOLOv8n-CA模型是指在YOLOv8n模型的基础上添加CA位置注意力机制;YOLOv8n-ShuffleAttention 模型是指在YOLOv8n模型的基础上添加ShuffleAttention注意力机制,该注意力机制可以在减少计算量的同时提高模型的泛化能力;YOLOv8n-BiFormer-EfficientNet模型是指在YOLOv8n-BiFormer的基础上添加双层路由机制及更换著名的EfficientNet主干网络,该主干网络可以在保持轻量化的同时高效提取图像中的特征;YOLOv8n-BiFormer-jct是指在YOLOv8n-BiFormer的基础上添加针对小目标检测的检测头;YOLOv8n-BiFormer-SPD则是指在YOLOv8n-BiFormer的基础上更换适用于低像素图像和小目标的卷积神经网络模块SPD-CONV。

从表1可见,加入双层路由注意力机制后的YOLOv8n-BiFormer模型相较于其他模型,对血鹦鹉的检测准确率、召回率和mAP@0.5等大部分指标均为最高,其中召回率、mAP@0.5和mAP@0.95提升效果明显。

表1 消融试验结果

Tab.1 Results of ablation experiment %

模型 model准确率 precision召回率 recall平均精度均值mAP@0.5平均绝对误差mAP@0.95YOLOv8n0.9740.9230.9810.733YOLOv8n-BiFormer0.9920.9370.9910.736YOLOv8n-CA0.9750.9290.9660.650YOLOv8n-ShuffleAttention0.9710.9180.9640.640YOLOv8n-BiFormer-EfficientNet0.9640.9180.9590.622YOLOv8n-BiFormer-jct0.9670.9440.9770.657YOLOv8n-BiFormer-SPD0.9720.9270.9710.635

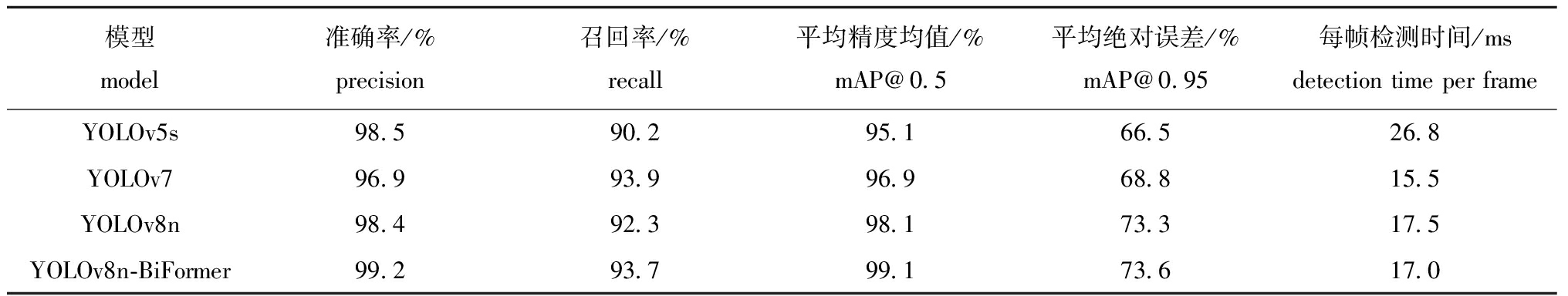

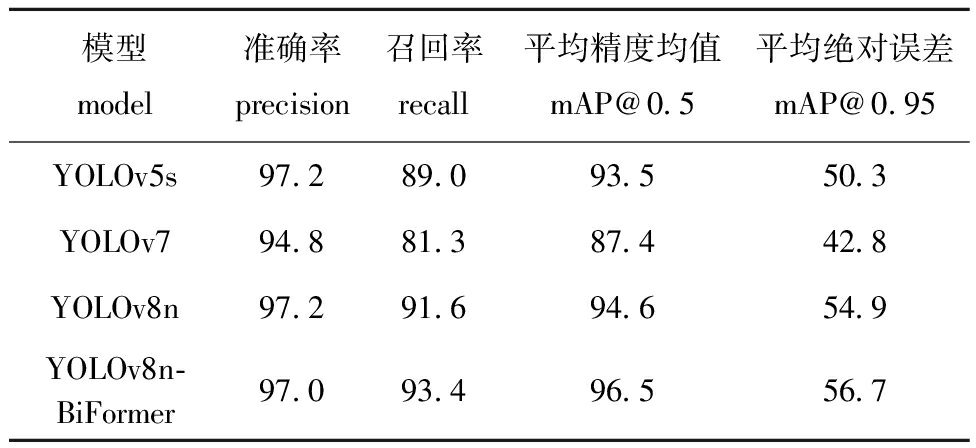

3.3.3 不同模型的检测效果 选用改进后的YOLOv8n-BiFormer模型与YOLO系列的YOLOv8n、YOLOv7和YOLOv5模型对血鹦鹉进行检测对比试验,结果发现:相较于YOLOv5模型,YOLOv8n-BiFormer模型的准确率、召回率、mAP@0.5、mAP@0.95分别提升了0.7%、3.5%、4.0%、7.1%;相较于YOLOv7模型,YOLOv8n-BiFormer模型的准确率增加了2.3%,召回率基本持平,mAP@0.5和mAP@0.95分别提升了2.2%、4.8%;相较于YOLOv8模型,YOLOv8n-BiFormer模型的准确率、召唤率、mAP@0.5分别提升了0.8%、1.4%、1.0%(表2)。这表明,YOLOv8n- BiFormer模型更加适合血鹦鹉的检测。图6展示了YOLOv8n-BiFormer模型对血鹦鹉目标的检测结果。

表2 YOLO系列模型对血鹦鹉的检测结果

Tab.2 Detection results of YOLO series models on blood parrots

模型 model准确率/% precision召回率/% recall平均精度均值/%mAP@0.5平均绝对误差/%mAP@0.95每帧检测时间/ms detection time per frameYOLOv5s98.590.295.166.526.8YOLOv796.993.996.968.815.5YOLOv8n98.492.398.173.317.5YOLOv8n-BiFormer99.293.799.173.617.0

图6 YOLOv8n-BiFormer模型对血鹦鹉的检测结果

Fig.6 Detection results of blood parrots by YOLOv8n-BiFormer model

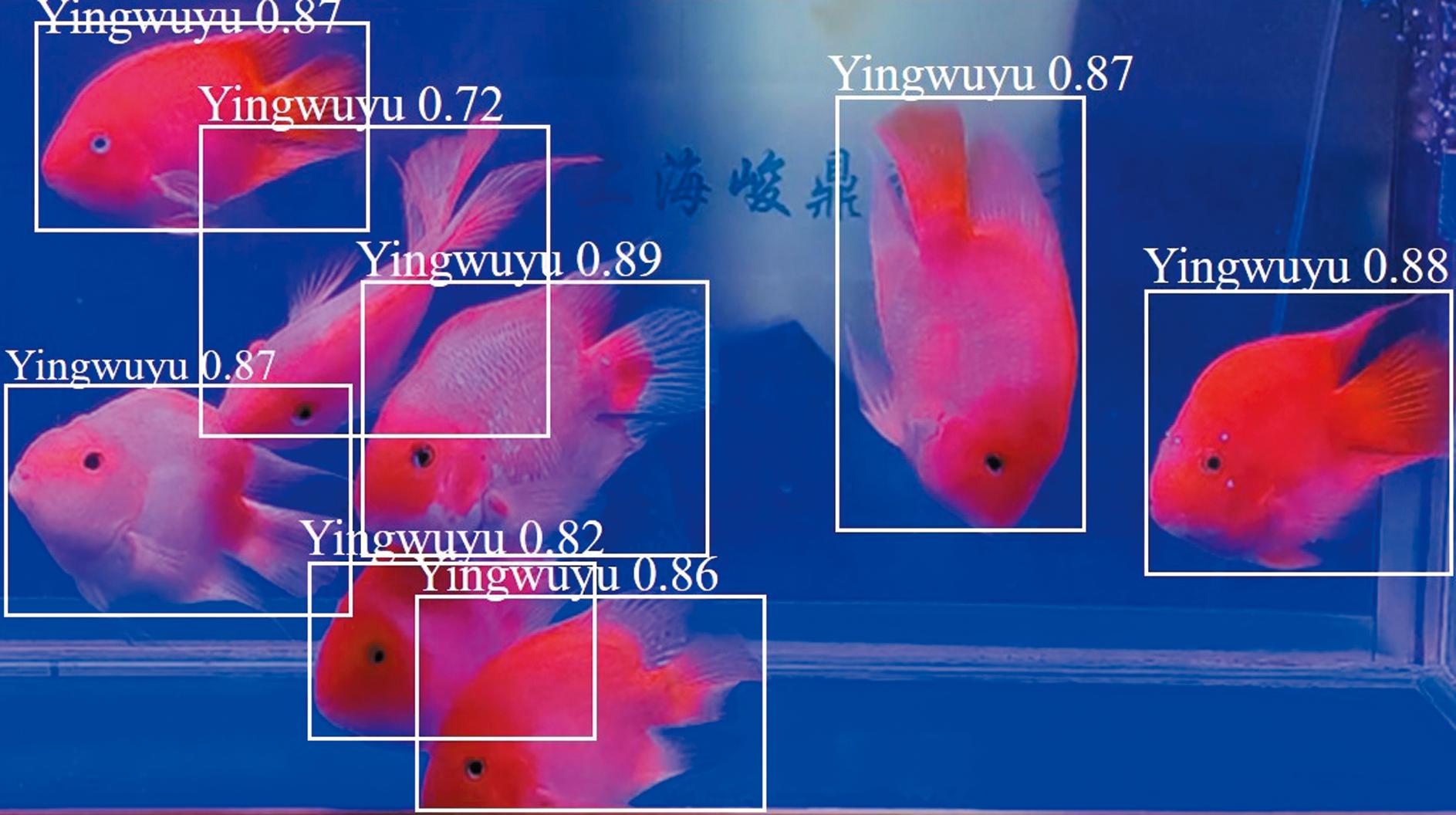

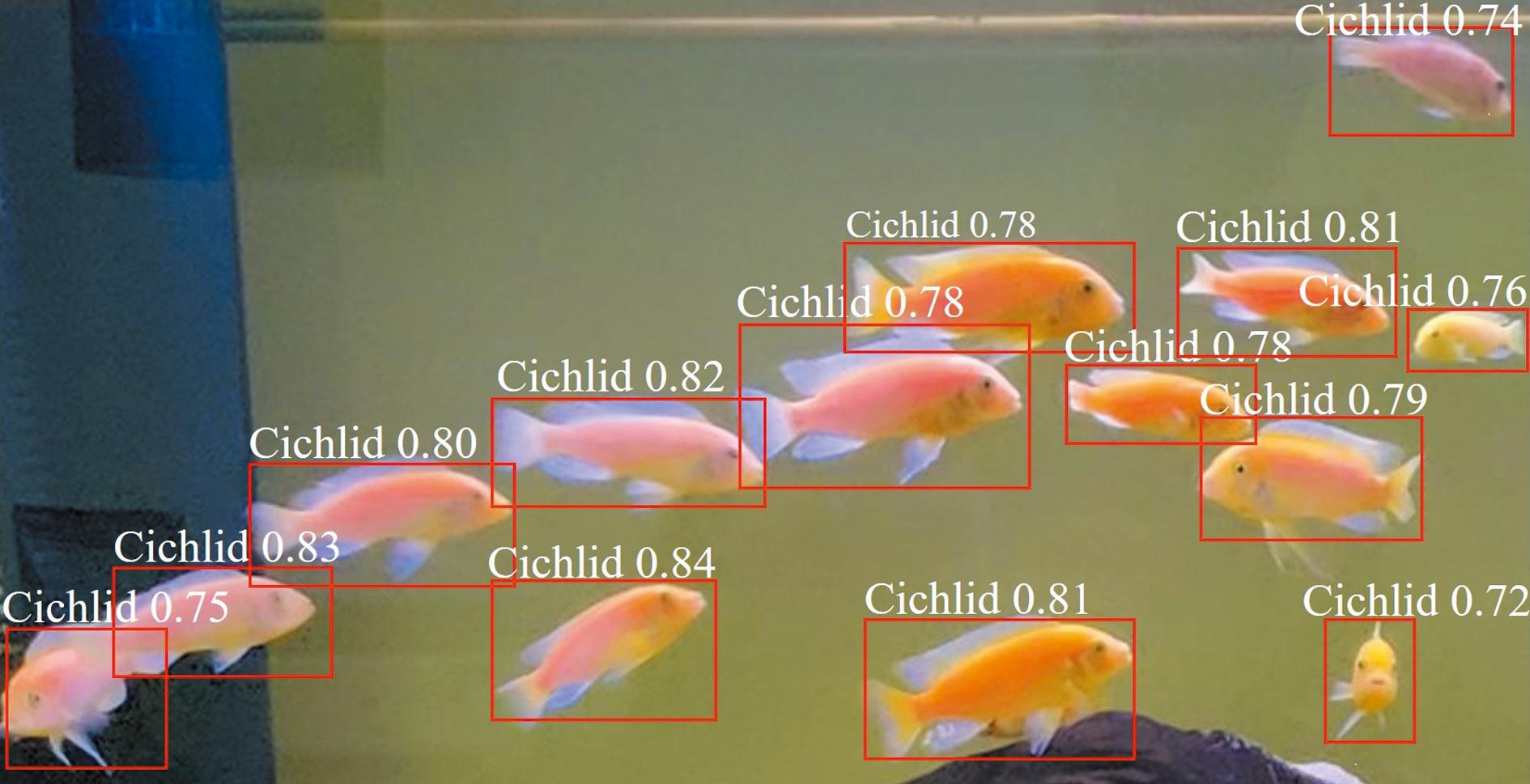

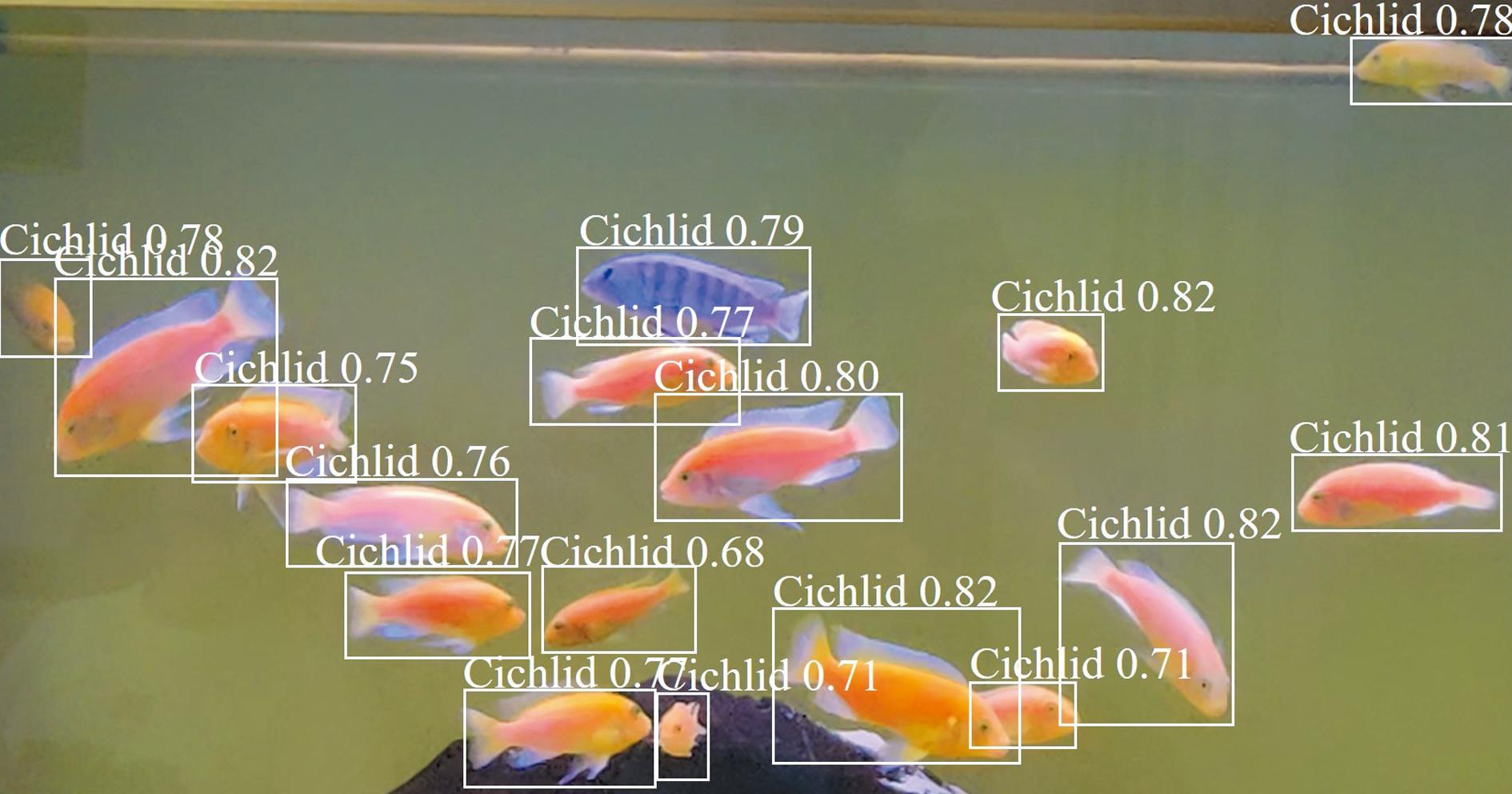

3.3.4 模型通用性验证试验 为验证本研究中方法对其他相似鱼类具有一定的通用性,以慈鲷为例进行检测与追踪。慈鲷是最受人们欢迎的观赏鱼之一,慈鲷通常具有多种颜色,包括黄、蓝、绿和红色等,且具有深色底部并带有明亮的斑点或条纹。慈鲷游动速度较缓慢,在检测追踪时,可以得到较为清晰稳定的图像,不会出现目标虚化或者快速移动导致丢失目标的情况。慈鲷相较于血鹦鹉颜色和花纹更为复杂,大小体型也不尽相同。若能使用该模型成功实现慈鲷的检测和追踪,即可证明本研究中的方法适用于现有大部分观赏鱼的检测和追踪。

选用YOLOv8n-BiFormer模型与YOLOv8n、YOLOv7和YOLOv5模型对慈鲷进行检测对比试验,结果发现:相较于YOLOv7模型,YOLOv8n-BiFormer模型的准确率提升了2.2%,召回率、mAP@0.5和mAP@0.95分别提升了12.1%、9.1%、13.9%;相较于YOLOv5s和YOLOv8n模型,YOLOv8n-BiFormer模型的准确率相差不大,但召回率、mAP@0.5和mAP@0.95相较于YOLOv5s提升了4.4%、3.0%、6.4%,相较于YOLOv8n提升了1.8%、1.9%、1.8%,在参数量上较YOLOv8n减少了128 682个(表3)。图7展示了YOLOv8-BiFormer模型对慈鲷目标的检测效果。

表3 YOLO系列模型对慈鲷的检测结果

Tab.3 Detection results of cichlids by YOLO series models %

模型model准确率precision召回率recall平均精度均值mAP@0.5平均绝对误差mAP@0.95YOLOv5s97.289.093.550.3YOLOv794.881.387.442.8YOLOv8n97.291.694.654.9YOLOv8n-BiFormer97.093.496.556.7

图7 YOLOv8n-BiFormer模型对慈鲷的检测结果

Fig.7 Detection results of cichlids by YOLOv8n-BiFormer model

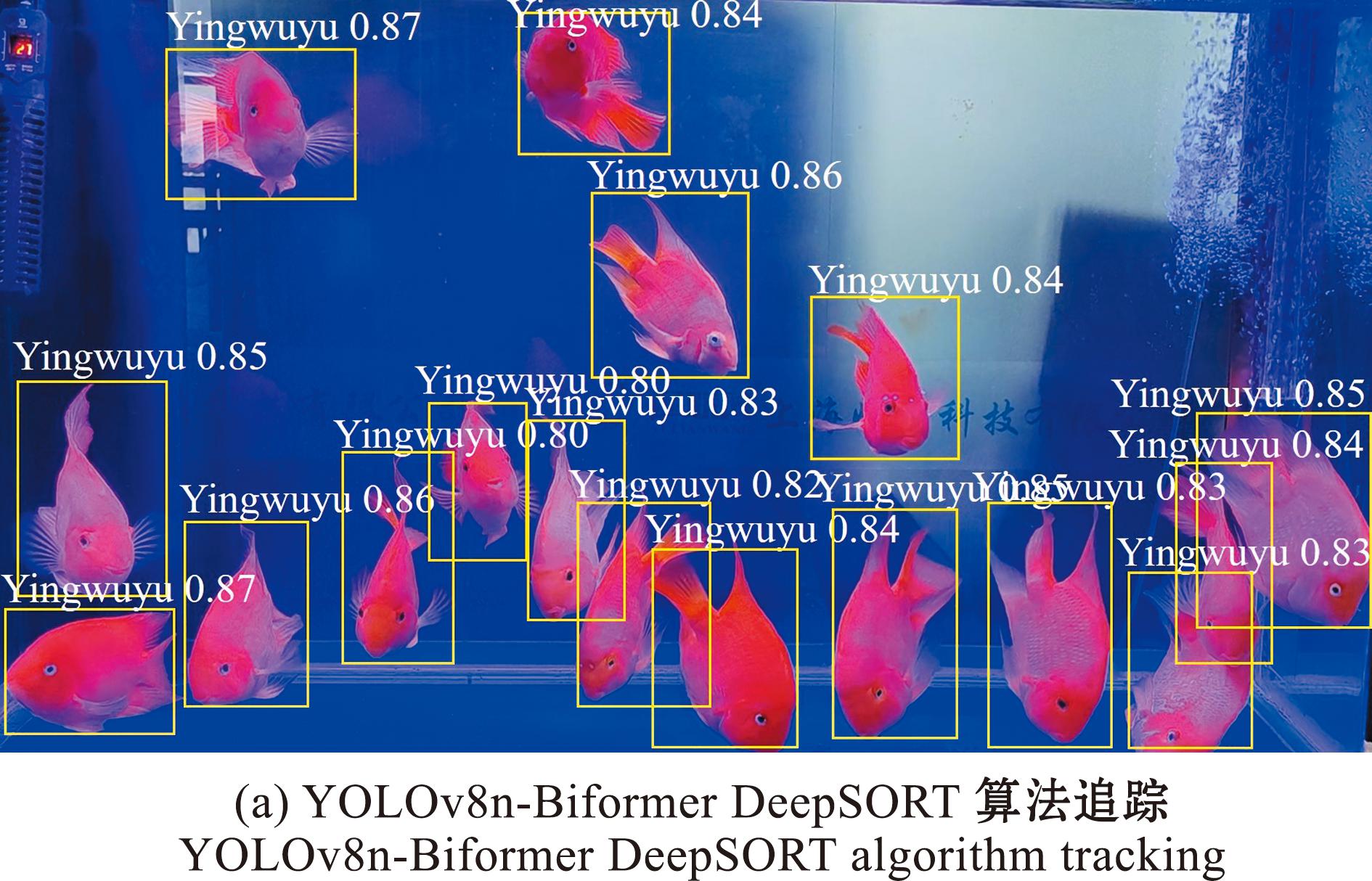

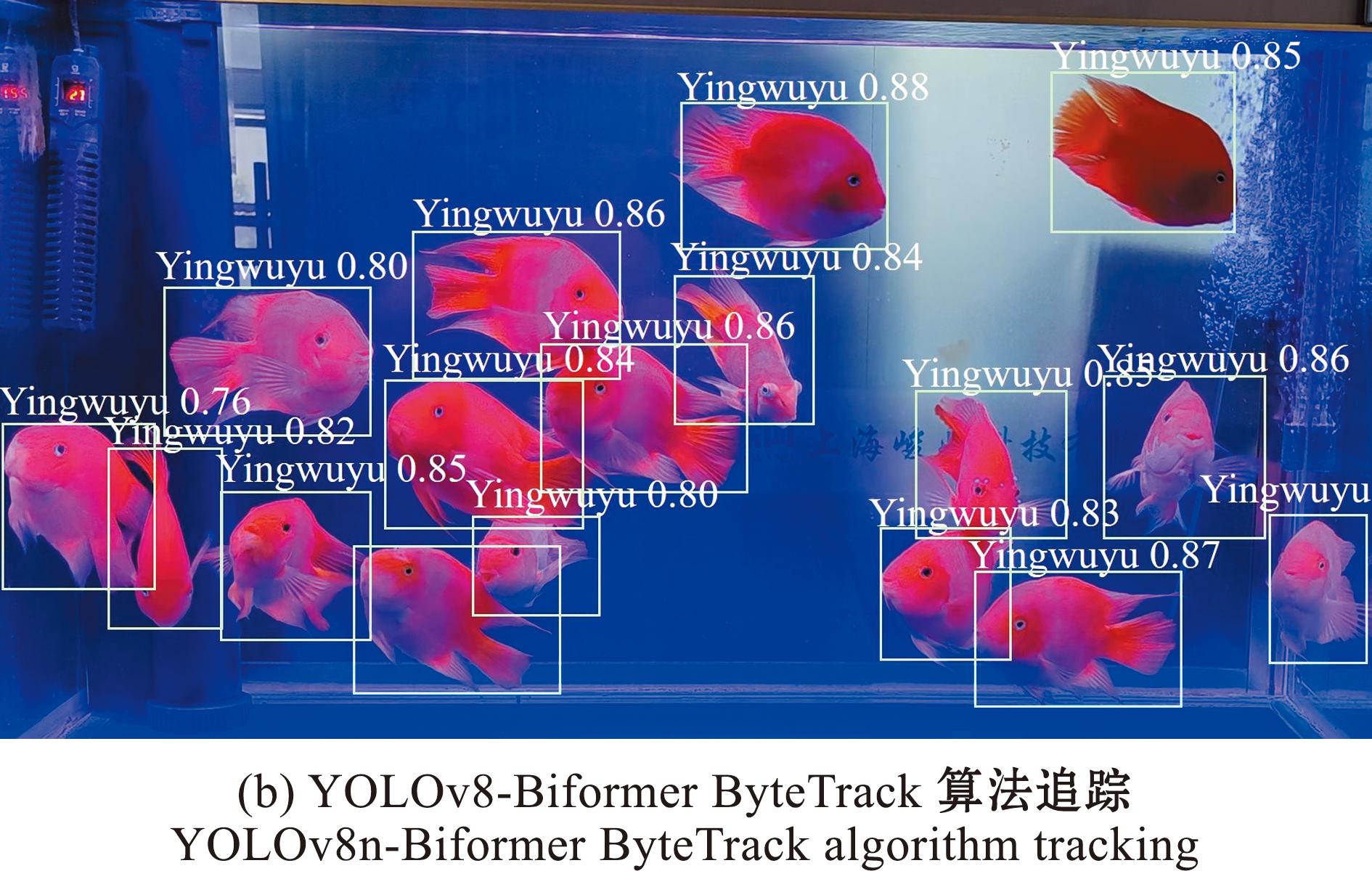

目前,传统的追踪算法有SORT(simple online and realtime tracking)、DeepSORT(deep learning-based SORT)[20]。SORT算法主要依赖于外部目标检测器的输出,在单目标或低密度场景下可能存在目标丢失的情况。DeepSORT算法是在SORT算法的基础上,采用深度学习方法提取特征,在数据关联和多目标跟踪中引入深度学习的一种算法。DeepSORT算法可以高效处理多目标、复杂运动情况下目标的跟踪任务。缺点是计算复杂度较高,对于一些质量较低的检测框,可能无法正确识别目标。相比之下,ByteTrack算法能够在目标检测的基础上实现更准确的目标跟踪,且在高密度场景中同时跟踪多个重叠的目标。ByteTrack算法在设计上针对目标遮挡、尺度变化和运动模糊等常见挑战做出了改进,相较于SORT、DeepSORT等传统的目标跟踪算法更适合本研究要求。因为其点线集成(PLI)跟踪算法能够较好地适应鱼类不同的运动状态和形态,以及较为复杂的水下环境,且具有良好的抗干扰能力。综上所述,ByteTrack算法更加适合鱼类的检测和追踪。图8为采用DeepSORT和ByteTrack算法追踪后的血鹦鹉图像,图9为采用ByteTrack算法追踪后的慈鲷图像。

图8 不同追踪算法对血鹦鹉的追踪结果

Fig.8 Tracking results of different tracking algorithms on blood parrot

图9 ByteTrack算法对慈鲷的追踪结果

Fig.9 Tracking results of ByteTrack algorithms on cichlid

ByteTrack算法需要的参数主要有track_thres(跟踪阈值)、track_buffe(缓冲区大小,即历史帧上保存的检测结果数量)、match_thresh(匹配阈值)、aspect_ratio_thresh(宽高比阈值)、min_box_area(最小Box面积)和mot20(是否使用mot20训练集进行训练),可以根据实际需要通过调整这些参数来优化算法。

本研究中,在设置参数时主要参考交并比(intersection over union,IoU)值和要追踪物体的大小、速度和数量。本次追踪的目标血鹦鹉运动速度比较慢,所以需要降低track_thres的值来增加追踪的灵敏度,以防止在追踪过程中出现卡顿。同时需要较小的缓冲区,以避免追踪器在连续多帧都未检测到目标时,将其误判为已离开画面。将track_thres设置为0.25,track_buffe设为 30,较小的缓冲区能够更快地更新历史帧上保存的检测结果,保持对血鹦鹉追踪的连续性。match_thresh用于判断一个新检测到的边界框是否与之前被追踪的目标匹配,由于本研究中的鱼类个体均偏大,将match_thresh设置为0.8可以过滤掉一些误检测的边界框。aspect_ratio_thresh用于排除不符合鱼类特征的无效边界框,故设置为3.0,这样可以提高目标检测的准确性,避免误判。min_box_area为最小边界框面积,用于排除面积过小的边界框,避免追踪错误的小目标。根据所选鱼类的特征,将最小边界框面积设置为1.0,可以过滤掉面积过小的无效边界框,提高目标追踪的准确性。由于并不需要使用mot20训练集,故mot20保持默认值False。

近年来,通过在模型中添加注意力机制成为提高目标检测准确性和抗背景干扰的重要手段之一。目前,常见的注意力机制有SE、CA、CBAM、ECA、SK、GAM和NAM等。涂万等[21]提出了一种基于通道非降维与空间协调注意力机制(ECAM)的改进 YOLOv8 养殖鱼群检测模型。ECAM注意力机制是由通道注意力模块 (efficient channel attention block,ECAB) 和协调空间注意力模块(coordinated spatial attention block,CSAB)组成,其可以减少因为鱼群运动模糊造成的特征提取能力下降问题,通过引入该注意力机制,使模型的检测准确率、召回率、平均精度均值较原模型分别提升了1.7%、1.0%、1.3%[21]。陈科等[22]在YOLOv5s模型中依次添加ShuffleNet V2、CBAM和ASPP 3种注意力机制,相较于原模型,其检测准确率分别提升了-3.2%、8.7%、11.3%,模型参数量从69 970个依次变化到9 400、9 505、14 400个,虽然在添加ShuffleNetV2后模型检测准确率出现了下降,但大幅减少了参数量,确保了后续引入CBAM、ASPP两种注意力机制后在提升模型精度的同时模型参数量变化不大。相较于陈科与涂万等的研究结果,本研究中提出的具有双层路由注意力机制的YOLOv8n-Biformer模型准确率和召回率更高,在提升召回率方面更有优势,并且在检测其他类别的观赏鱼时也具有一定效果。由此可见,在引入注意力机制时不能只考虑模型精度的提升,还需对模型参数量和检测速度等方面综合考虑。因此,对模型有选择地进行改进,可以更好地平衡检测精度和满足实际应用需求。

1)本研究中提出了一种基于改进 YOLOv8n模型的鱼类检测模型 YOLOv8n-Biformer模型,该模型在血鹦鹉数据集上的检测准确率为99.2%,平均精度均值为99.1%,召回率为93.7%,并且结合ByteTrack追踪算法实现了对血鹦鹉和慈鲷的精确追踪。使用该模型可方便地对观赏鱼的活动状态进行追踪观察,避免了传统的人工记录鱼类活动信息时的一些缺点。

2)本研究中提出的 YOLOv8n-Biformer模型,相较于其他主流模型如YOLOv5和YOLOv7,以及其他改进模型YOLOv8-CA、YOLOv8n-ShuffleAttention、YOLOv8n-BiFormer-EfficientNet、YOLOv8n-BiFormer-jct和YOLOv8n-BiFormer-SPD,在平均精度均值上均有提升,同时YOLOv8n-Biformer模型相比于YOLOv8n检测速度更快,可以为海洋水族馆珍稀鱼类精细化管理、渔业环境保护和资源管理等领域提供帮助,适合部署在算力资源缺少的生产环境中。本研究结果为后续实现更高精度、更准确的鱼类识别和追踪方法提供了有益参考。

致谢:东海水产研究所与大连海洋大学联合培养研究生王书献,在ByteTrack程序调试中给予了帮助,东海水产研究所与上海海洋大学联合培养研究生孙月莹,在本文写作方面给予了帮助,谨此致谢!

[1] 于秀娟,郝向举,冯天娇,等.中国休闲渔业发展监测报告(2023)[J].中国水产,2023(11):22-27. YU X J.HAO X J.FENG T J,et al.Monitoring report on the development of recreational fisheries in China(2023)[J].China Fisheries,2023(11):22-27.(in Chinese)

[2] 刘洋,张胜茂,王书献,等.水族馆鱼类目标检测网络优化研究[J].渔业现代化,2022,49(3):89-98. LIU Y,ZHANG S M,WANG S X,et al.Research on optimization of aquarium fish target detection network[J].Fishery Modernization,2022,49(3):89-98.(in Chinese)

[3] 张胜茂,刘洋,樊伟,等.基于TensorFlow的水族馆鱼类目标检测APP开发[J].渔业现代化,2020,47(2):60-67. ZHANG S M,LIU Y,FAN W,et al.Aquarium fish target detection APP development based on TensorFlow[J].Fishery Modernization,2020,47(2):60-67.(in Chinese)

[4] 刘洋,张胜茂,王斐,等.海洋捕捞鱼类BigH神经网络分类模型设计与实现[J].工业控制计算机,2021,34(6):18-20. LIU Y,ZHANG S M,WANG F,et al.Automatic transfer learning and manual neural network for marine fish classification[J].Industrial Control Computer,2021,34(6):18-20.(in Chinese)

[5] 张胜茂,孙永文,樊伟,等.面向海洋渔业捕捞生产的深度学习方法应用研究进展[J].大连海洋大学学报,2022,37(4):683-695. ZHANG S M,SUN Y W,FAN W,et al.Research progress in the application of deep learning methods for marine fishery production:a review[J].Journal of Dalian Ocean University,2022,37(4):683-695.(in Chinese)

[6] 王书献,张胜茂,唐峰华,等.CNN-LSTM在日本鲭捕捞渔船行为提取中的应用[J].农业工程学报,2022,38(7):200-209. WANG S X,ZHANG S M,TANG F H,et al.Extracting the behavior of Scomber japonicus fishing vessel using CNN-LSTM[J].Transactions of the Chinese Society of Agricultural Engineering,2022,38(7):200-209.(in Chinese)

[7] 张佳泽,张胜茂,樊伟,等.基于YOLOv5改进模型的日本鳀围网作业目标检测研究[J/OL].海洋渔业,2024:1-15.[2024-02-16].https://doi.org/10.13233/j.cnki.mar.fish.20230314.001. ZHANG J Z,ZHANG S M,FAN W,et al.Research on target detection of Engraulis japonicus purse seine based on improved model of YOLOv5 [J/OL].Marine Fisheries,2024:1-15.[2024-02-16].https://doi.org/10.13233/j.cnki.mar.fish.20230314.001.(in Chinese)

[8] 张佳泽,张胜茂,王书献,等.基于3-2D融和模型的毛虾捕捞渔船行为识别[J].南方水产科学,2022,18(4):126-135. ZHANG J Z,ZHANG S M,WANG S X,et al.Recognition of Acetes chinensis fishing vessel based on 3-2D integration model behavior[J].South China Fisheries Science,2022,18(4):126-135.(in Chinese)

[9] 杨东海,张胜茂,汤先峰.基于机器视觉技术的鱼类识别研究进展[J].渔业信息与战略,2019,34(2):112-120. YANG D H,ZHANG S M,TANG X F.Research and development of fish species identification based on machine vision technology[J].Fishery Information &Strategy,2019,34(2):112-120.(in Chinese)

[10] 蒋梦迪,程江华,陈明辉,等.视频和图像文本提取方法综述[J].计算机科学,2017,44(S2):8-18. JIANG M D,CHENG J H,CHEN M H,et al.Text extraction in video and images:a review[J].Computer Science,2017,44(S2):8-18.(in Chinese)

[11] 裴凯洋,张胜茂,樊伟,等.基于计算机视觉的鱼类视频跟踪技术应用研究进展[J].海洋渔业,2022,44(5):640-647. PEI K Y,ZHANG S M,FAN W,et al.Research progress of fish video tracking application based on computer vision[J].Marine Fisheries,2022,44(5):640-647.(in Chinese)

[12] GIRSHICK R.Fast R-CNN:proceedings of the IEEE international conference on computer vision[J].Santiago,2015:7-13.

[13] REN S,HE K,GIRSHICK R,et al. Faster R-CNN: towards real-time object detection with region proposal networks [J].Advances in Neural Information Processing Systems,2015,28:91-9.

[14] GIRSHICK R,DONAHUE J,DARRELL T,et al.Rich feature hierarchies for accurate object detection and semantic segmentation[C]//2014 IEEE conference on computer vision and pattern recognition.Columbus,OH,USA:IEEE,2014:580-587.

[15] 王书献,张胜茂,朱文斌,等.基于深度学习YOLOV5网络模型的金枪鱼延绳钓电子监控系统目标检测应用[J].大连海洋大学学报,2021,36(5):842-850. WANG S X,ZHANG S M,ZHU W B,et al.Application of an electronic monitoring system for video target detection in tuna longline fishing based on YOLOV5 deep learning model[J].Journal of Dalian Ocean University,2021,36(5):842-850.(in Chinese)

[16] 李家俊.基于改进YOLOX的目标检测与跟踪算法研究[D].赣州:江西理工大学,2022. LI J J.Research on target detection and tracking algorithm based on improved YOLOX[D].Ganzhou:Jiangxi University of Science and Technology,2022.(in Chinese)

[17] MISRA D.Mish:a self regularized non-monotonic activation function[EB/OL].2019:arXiv:1908.08681.http://arxiv.org/abs/1908.08681.pdf.

[18] HE K M,ZHANG X Y,REN S Q,et al.Deep residual learning for image recognition[C]//2016 IEEE conference on computer vision and pattern recognition (CVPR).Las Vegas,NV,USA:IEEE,2016:770-778.

[19] 孙月莹,陈俊霖,张胜茂,等.基于改进YOLOv7的毛虾捕捞渔船作业目标检测与计数方法[J].农业工程学报,2023,39(10):151-162. SUN Y Y,CHEN J L,ZHANG S M,et al.Target detection and counting method for Acetes chinensis fishing vessels operation based on improved YOLOv7[J].Transactions of the Chinese Society of Agricultural Engineering,2023,39(10):151-162.(in Chinese)

[20] 胡辉,司凤洋,曾琛,等.一种结合Dropblock和Dropout的正则化策略[J].河南师范大学学报(自然科学版),2019,47(6):51-56. HU H,SI F Y,ZENG C,et al.A regularization strategy combining Dropblock and Dropout[J].Journal of Henan Normal University (Natural Science Edition),2019,47(6):51-56.(in Chinese)

[21] 涂万,于红,张鹏,等.基于通道非降维与空间协调注意力的改进YOLOv8养殖鱼群检测[J].大连海洋大学学报,2023,38(4):717-725. TU W,YU H,ZHANG P,et al.Farmed fish detection by improved YOLOv8 based on channel non-degradation with spatially coordinated attention[J].Journal of Dalian Ocean University,2023,38(4):717-725.(in Chinese)

[22] 陈科,周勇,薛明洋,等.基于机器视觉和改进YOLOv5s的鲫病害轻量级无损检测模型[J/OL].水生生物学报,2023:1-8.(2023-12-20).https://kns.cnki.net/kcms/detail/42.1230.Q.20231219.2149.002.html. CHEN K,ZHOU Y,XUE M Y,et al.Lightweight nondestructive detection model of crucian carp disease based on machine vision and improved YOLOv5s[J/OL].Acta Hydrobiologica Sinica,2023:1-8.(2023-12-20).https://kns.cnki.net/kcms/detail/42.1230.Q.20231219.2149.002.html.(in Chinese)