海洋伏季休渔制度是依据《中华人民共和国渔业法》制定的一项重要渔业资源养护制度,对控制海洋捕捞强度、保护海洋渔业资源和促进渔业可持续发展起到了重要作用。现阶段渔船识别与统计方法主要是基于北斗船位数据对比、RFID (radio frequency identification)与人工操作对渔船进出港进行统计。其中,北斗船位系统在受到干扰或发生故障掉线情况下,会出现数据缺失的情况,影响统计结果;RFID会受到距离的限制;人工操作则需要专门的值班人员进行长时间值守,需要较大的人力投入。随着渔港高点监控设施的完善与目标检测模型功能的日益强大,对进出渔港的各类船舶实现自动识别和统计已成为可能。因此,建立基于改进YOLOv8的进出港渔船目标检测与统计模型,通过渔港高点监控对进出港船舶类型进行识别与数量统计,同时在渔港卡口设立电子警戒线,实时掌握渔船进出港数量变化,当发现船舶离港且未报告时可及时做出反应,这将对管理部门做好船舶进出港统计工作具有重要的作用。

基于深度学习的目标检测算法是当今计算机视觉领域的研究热点,主要包括双阶段目标检测算法和单阶段目标检测算法。其中,双阶段目标检测算法是先根据图像提取候选框,再基于候选区域做二次修正得到检测结果,其检测精度较高,但检测速度较慢。常见的双阶段目标检测算法有R-CNN系列[1]等。单阶段目标检测算法是将目标检测问题视为对目标位置和类别信息的回归分析问题,通过一个神经网络模型可直接输出检测结果。与双阶段检测算法相比,单阶段检测算法不需要生成候选区域,可以直接在网络中提取特征值进行目标分类和定位,因而具有更高的检测速度。常见的单阶段目标检测算法包括SSD[2]、YOLO系列[3]和RetinaNet[4]等。其中,YOLO系列算法具有检测速度快、准确率高的特点,目前,有许多国内外学者将基于深度学习的目标检测算法应用在船舶的识别跟踪与渔业上[5-10]。Shao等[11]对6类船舶进行了精确标注,提出了一个新的大规模数据集Seaships,并且比较了Faster R-cnn、YOLOv2和SSD算法的mAP@0.5和检测速度,但工作仅限于制作数据集与比较算法,对于模型改进并未提及。Chen等[12]提出了一种基于SSD-Kmeans FPN(feature pyramid network)模型的船舶检测方法,以解决船舶靠近港口等复杂场景下的小目标和多目标船舶检测问题。随着Tan等[13]提出的加权双向特征金字塔网络结构(Bi-directional feature pyramid network,Bi-FPN)的广泛应用,结果发现,Bi-FPN网络结构对小目标的识别能力优于FPN,更适用于小目标的检测。张晓鹏等[14]使用YOLOv5模型融合暗通道去雾算法(dark channel)、 SE注意力机制模块和改进非极大值抑制,实现了船舶雾天条件下的高效识别,提高了船舶在特殊天气下的识别能力,但模型对小目标的识别能力还有待提高。张德春等[15]通过在YOLOv5模型的骨干网络中融入卷积注意模块CBAM,并采用Bi-FPN结构,提升了模型对小型渔船的定位与识别能力。但随着对模型多尺度性能需求的增加,其模型还有改进的空间。

上述模型虽然可以实现对船舶的目标检测与跟踪,但针对船舶进出港领域的识别与检测工作较少。本研究中根据渔港执法部门的实际需要,提出了基于改进YOLOv8的渔港船舶进出港目标检测与统计模型,该模型使用了对小目标更加友好的Bi-FPN,以及对远处小目标及近处大目标均可有效应用的高效多尺度注意力模块(excitation multi-scale attention,EMA),最后结合BoT-SORT实现对渔港各类船舶的进出港统计,以期为不同类型船舶的识别和进出港统计提供参考。

1 渔港船舶进出港数据集

1.1 数据来源

数据来自国家级中心渔港-大连湾渔港高点监控视频,港内常驻省内外渔船300余艘。摄像头安装在楼顶,距地面高度为20 m,型号为海康威视星光级180度智能全景球机器iDS-2DP1618ZIXS-D/440 F0 P5,照射最远距离可达250 m。

1.2 数据集制作

本研究中主要识别的目标为渔船、执法船和拖船3种类型。为提升数据集的实际应用价值,考虑实时天气的影响,数据集选取晴天、阴天、雨天和雾天4种不同天气。

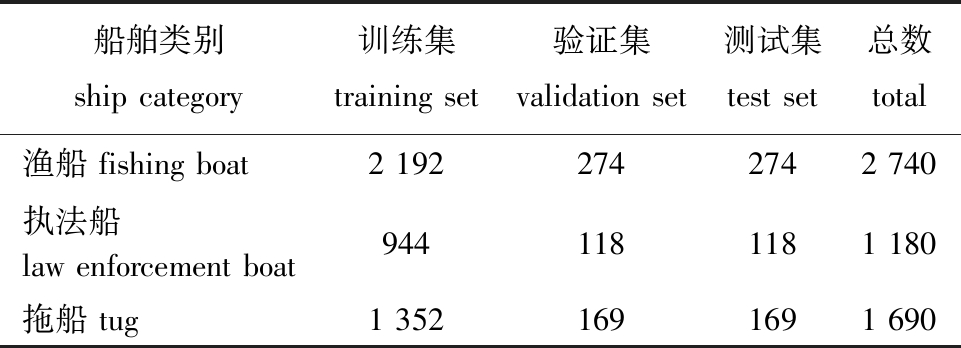

使用Pot Player播放器截取合适的视频片段,根据不同类型船舶的不同速度,选择3 s或5 s的时间间隔,连续截取出船舶的运动轨迹截图。使用Labelimg工具进行标注并制作数据集。采用平移、旋转15°、裁剪、加噪声、改变亮度、翻转和Cutout等数据增强操作,提高模型的泛化能力与鲁棒性。增强后的数据集为4 600张,按照8∶1∶1比例划分为训练集、验证集和测试集。对3个子集中各类型的船舶数量统计结果如表1所示。

表1 不同类别船舶目标数量统计

Tab.1 Statistics of ship targets in different categories

船舶类别ship category训练集training set验证集validation set测试集test set总数total渔船 fishing boat2 1922742742 740执法船law enforcement boat9441181181 180拖船 tug1 3521691691 690

1.3 技术路线

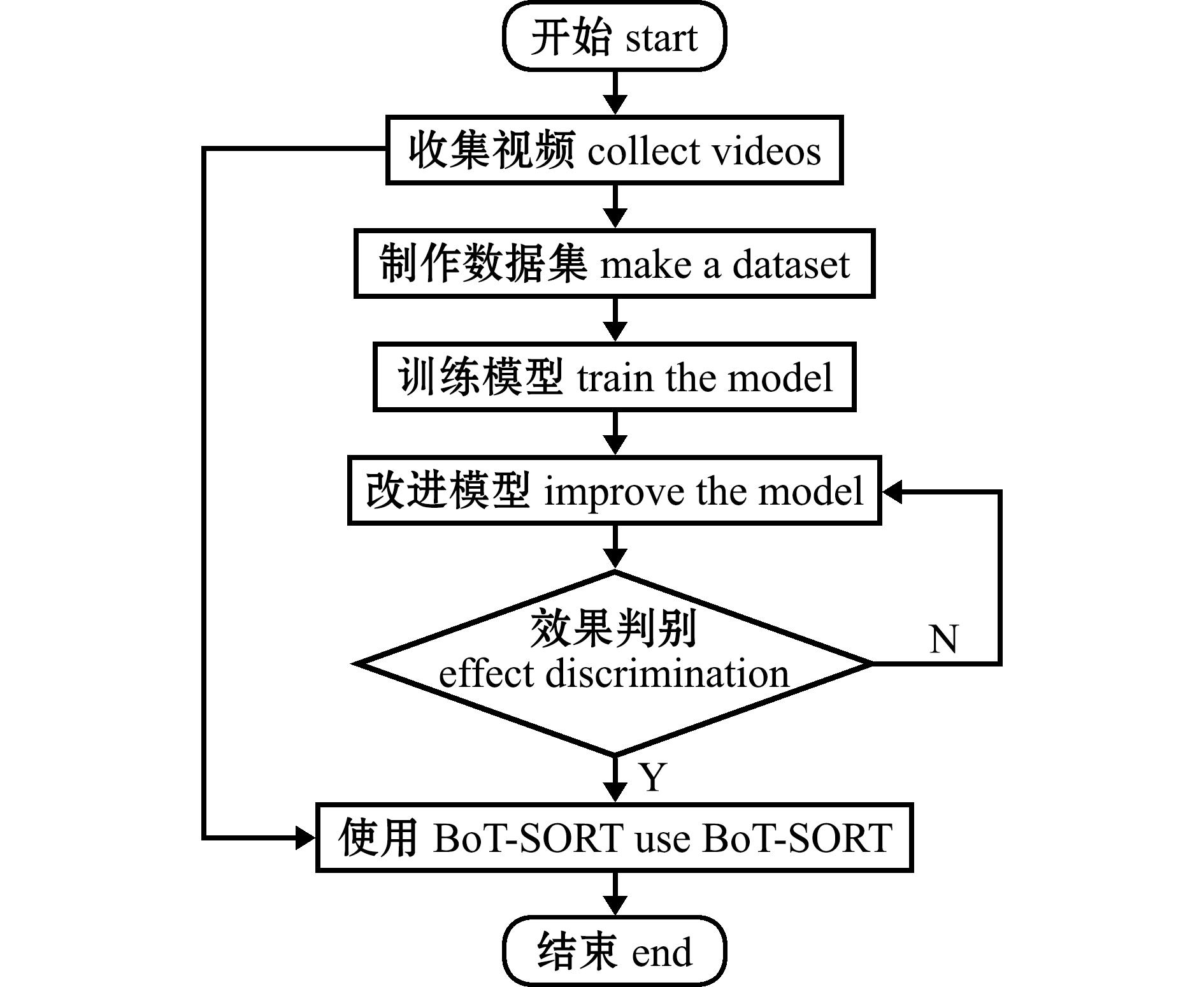

首先,筛选不同天气情况下包含多种船舶的视频片段,提取视频中船舶运动图像,经分类标注后构建数据集;其次,使用 Anaconda工具创建一个Python 3.8.18工作环境并对YOLOv8n模型进行训练,结合数据集的特征和实际需求对原始模型进行改进,以得到目标检测性能更高的模型;最后,使用改进的模型结合BoT-SORT跟踪算法进行船舶进出港统计,将模型输出结果与人工核验结果进行对比分析,以验证方法的可行性,技术路线(图1)。

图1 技术路线

Fig.1 Technical route

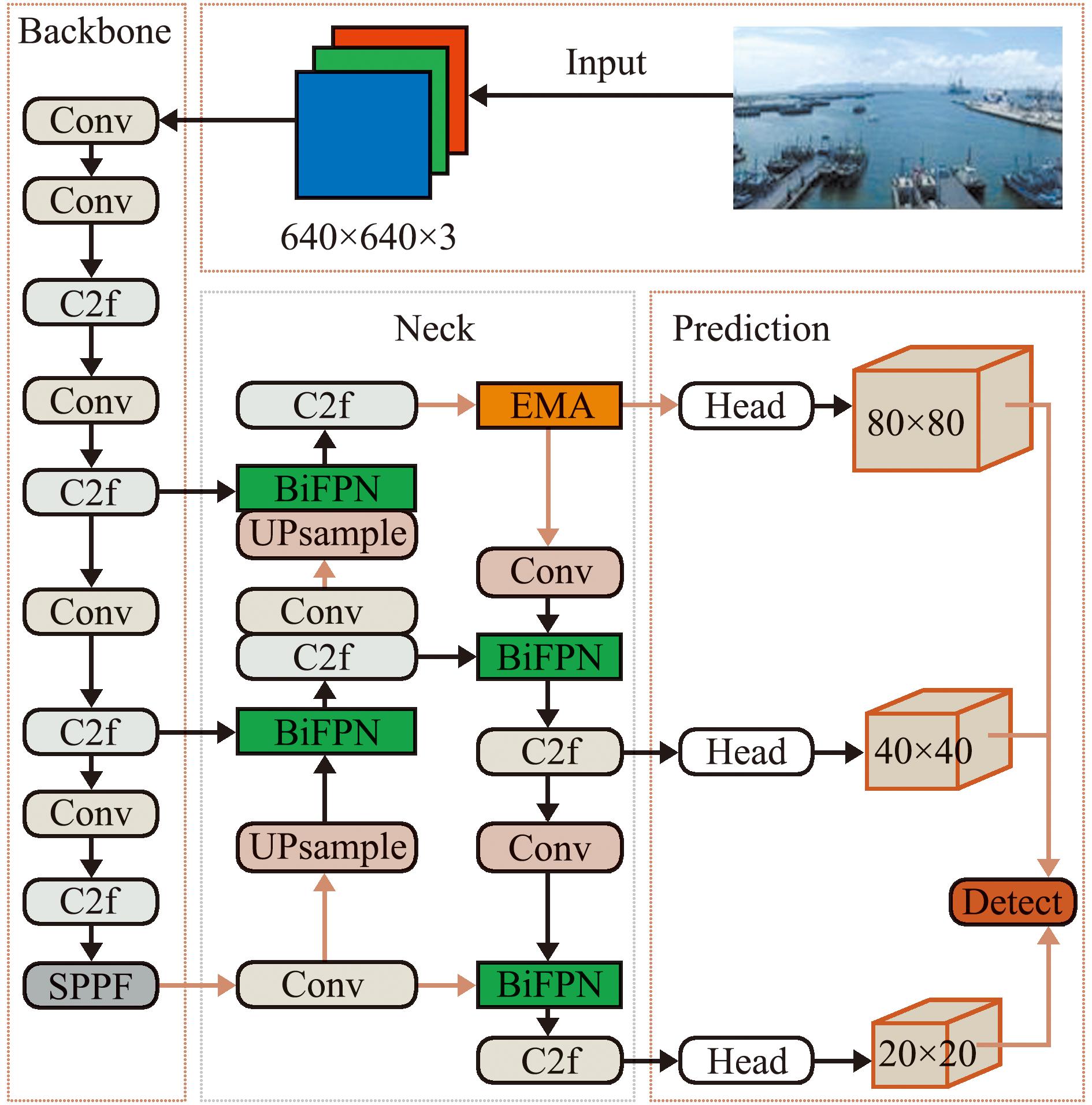

2 YOLOv8n-Bi-FPN-EMA网络结构

2.1 YOLOv8网络结构

YOLOv8网络结构主要由主干网络(backbone)、特征增强网络(neck)和检测头(head)3部分组成。其中,主干网络采用了CSP(cross stage partial)思路,将网络分为多个部分,每个部分都包含多个残差块;特征增强网络借鉴了PA-FPN(path aggregation network with feature pyramid)思路,以优化模型的特征提取能力;检测头则采用了Decoupled-Head结构,其摒弃了传统的Anchor-Based检测方式,转而采用Anchor-Free检测方式,这种方式可直接预测目标的中心点和宽高比例,从而提高了检测精度和速度。

YOLOv8模型具有高效性、实时性、高准确度和特征提取能力强等显著优点,使得其在目标检测任务中表现出色。

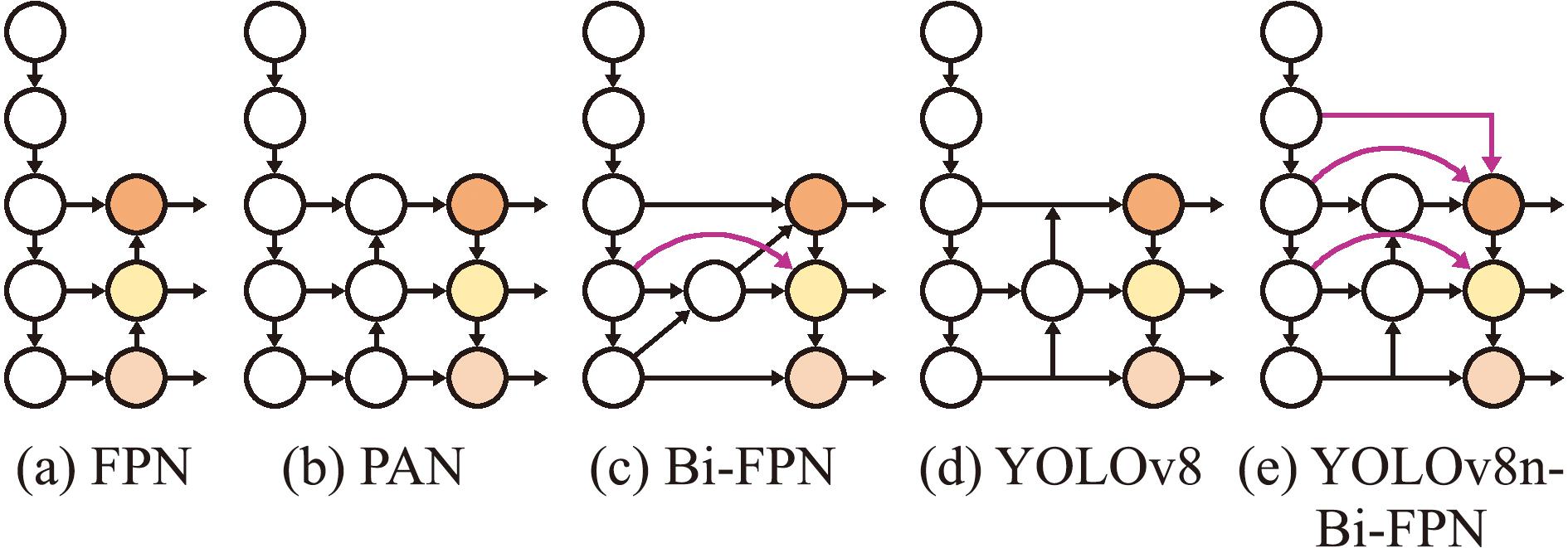

2.2 Bi-FPN网络结构

图2展示了YOLOv8n-Bi-FPN网络结构。BiFPN网络结构是在传统的特征金字塔网络(FPN)[16]基础上加以改进,通过在金字塔级别之间引入双向连接结构,使信息能够在网络中同时进行自底向上和自顶向下的流动。Bi-FPN网络结构具有强大的特征提取能力、高效的计算性能和多尺度的特征融合能力,其采用了多层级的特征金字塔网络结构,有助于从图像中提取出更丰富、更有区分度的特征,从而提高目标检测的准确性。该结构广泛地应用在对小目标的检测中[17-20]。

图2 FPN、PAN、Bi-FPN、YOLOv8、YOLOv8-Bi-FPN网络结构

Fig.2 Network structure of FPN,PAN,Bi-FPN,YOLOv8,and YOLOv8-Bi-FPN

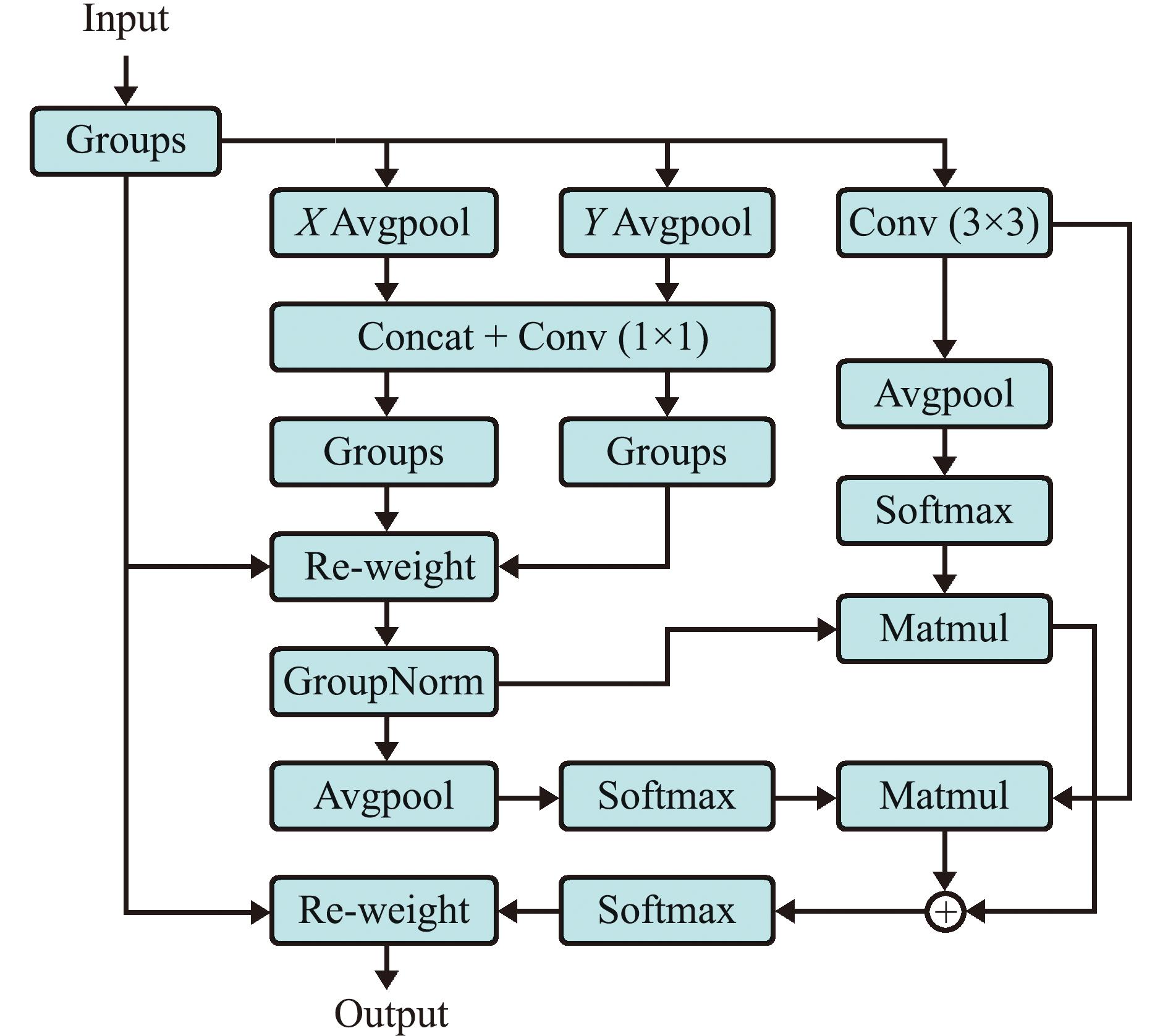

2.3 EMA注意力机制模块

高效多尺度注意力机制模块(EMA)[21]是一种用于计算机视觉领域的新型技术,能提升模型在多尺度场景下的特征提取和表征能力。EMA注意力机制模块能够有效地融合不同尺度的特征信息,使得模型在处理图像或视频时能够同时捕捉到细节信息和全局上下文,从而提高识别的准确性和鲁棒性。EMA注意力机制模块还能通过加权处理输入数据,将网络的注意力集中在高优先级任务上,从而显著提升模型的检测准确性。EMA注意力机制模块还引入了激励和调制两个概念,进一步增强了模型的表达能力。EMA注意力机制模块结构如图3所示。本研究中将EMA注意力机制模块加在YOLOv8n网络结构的头部,以提高目标检测的准确性和稳定性,增强模型的鲁棒性,降低计算复杂度。YOLOv8n-Bi-FPN-EMA网络结构如图4所示。

图3 EMA注意力机制模块结构

Fig.3 Module structure of EMA attention mechanism

图4 YOLOv8n-Bi-FPN-EMA网络结构

Fig.4 Network structure of YOLOv8n-Bi-FPN-EMA

3 渔港船舶进出港检测与统计试验

3.1 试验环境

试验基于Windows 11操作系统、 Python 3.8.18编程语言和 Pytorch 2.1.1深度学习框架。CPU配置为13th Gen Intel(R) Core(TM) i5-13450HX 2.40 GHz,Cuda 版本为Cuda 12.2,GPU为NVIDIA 4050。 模型训练时使用的部分超参数设置:初始学习率为 0.001,batch _ size 为 8,迭代次数为 100。

3.2 评价指标

采用准确率 ( precision,P)、 召回率 ( recall,R)、平均精度均值 (mAP@0.5)和置信度为 95%的平均绝对误差 (mAP@0.95)来评估目标检测模型的性能。 准确率用于衡量模型正确预测目标数量与总预测数量之间的比例,准确率越高,意味着模型在检测过程中正确识别出的目标数量越多,误检的情况越少;召回率用于衡量模型正确预测为正样本的样本数量占所有实际正样本数量的比例,高召回率意味着模型能够更全面地检测到实际存在的目标;mAP@0.5是一个特定的性能评估指标,用于衡量在交并比(IoU)阈值为0.5时模型的目标检测性能,mAP@0.5越高代表模型检测物体位置的能力越强;mAP@0.95 值越高代表模型在不同场景下均可以达到较好的检测准确率。

3.3 结果与分析

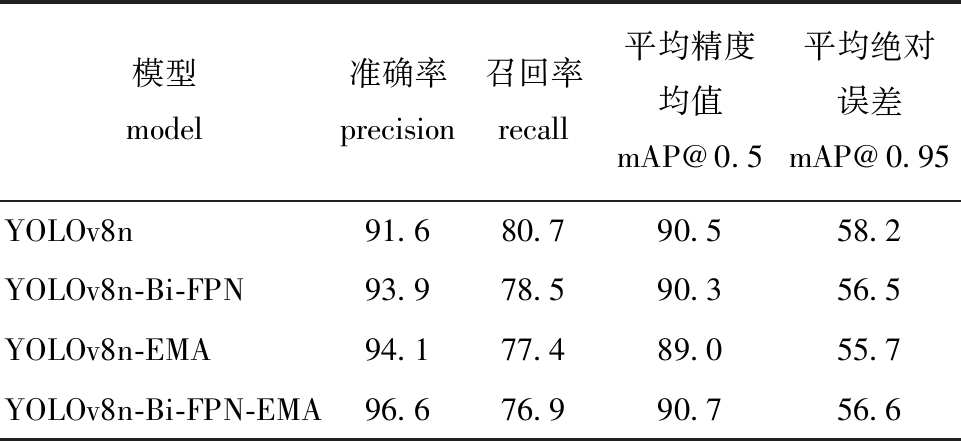

3.3.1 消融试验 为了更好地分析YOLOv8n模型改进的有效性,依次对YOLOv8n模型不同模块进行改进,设计了YOLOv8n、YOLOv8n-Bi-FPN、YOLOv8n-EMA和YOLOv8n-Bi-FPN-EMA的消融试验。该试验过程均使用相同的数据集,在相同轮次与相同批次下进行模型训练与模型测试。

从表2可见:加入Bi-FPN网络结构与EMA注意力机制模块的YOLOv8n-Bi-FPN-EMA模型,相较于其他模型在准确率和mAP@0.5上均为最高,准确率和mAP@0.5分别为96.6%、90.7%,相较于YOLOv8n模型提高了5.0%、0.2%,而召回率则下降了3.8%。准确率和召回率是两个重要的评估指标,二者之间存在一定的权衡关系。提高准确率往往意味着模型在预测时会更加谨慎。这可能导致一些实际的正样本被误判为负样本,从而降低了召回率。

表2 消融试验结果

Tab.2 Results of ablation experiment %

模型model准确率precision召回率recall平均精度均值mAP@0.5平均绝对误差mAP@0.95YOLOv8n91.680.790.558.2YOLOv8n-Bi-FPN93.978.590.356.5YOLOv8n-EMA94.177.489.055.7YOLOv8n-Bi-FPN-EMA96.676.990.756.6

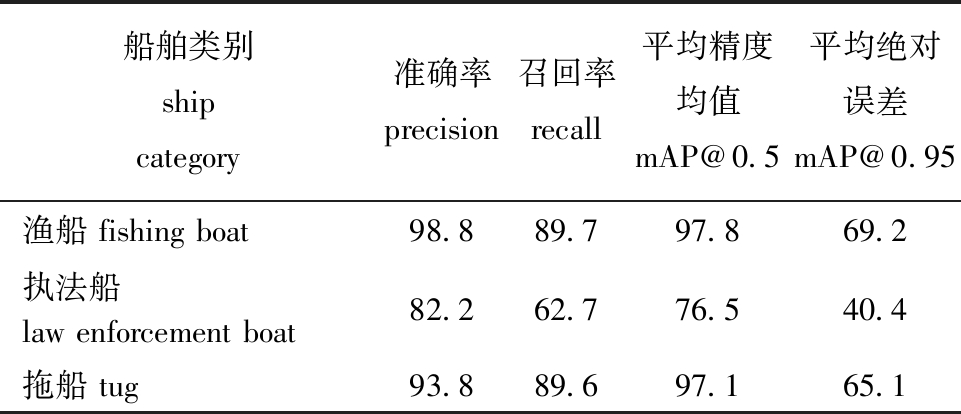

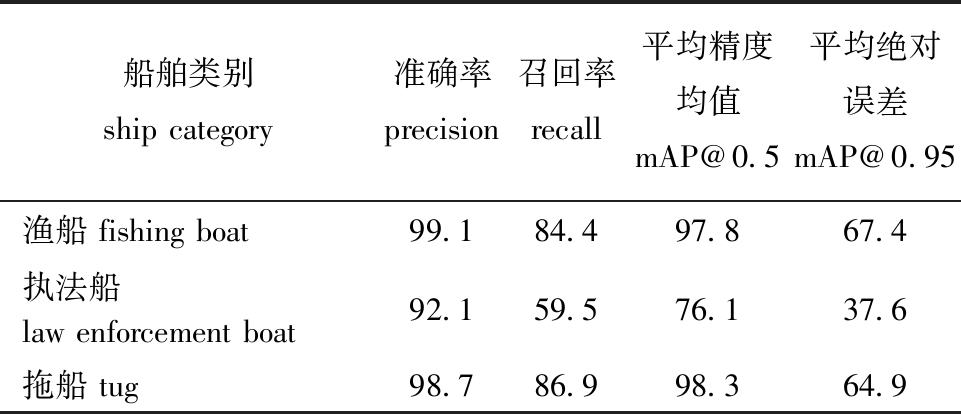

3.3.2 改进后模型检测性能对比 从表3和表4可见,改进后的YOLOv8n-Bi-FPN-EMA模型,对3种类型船舶的检测准确率较原模型YOLOv8n全面提升,对执法船、拖船和渔船的检测准确率分别提高了0.3%、9.9%、4.9%,而召回率分别下降了5.3%、3.2%、2.7%,召回率下降可能是准确率提高,模型更加谨慎的结果。其中,改进后的模型对渔船的检测准确率为99.1%,召回率为84.4%,mAP@0.5为97.8%,说明模型在渔船的识别上有较好表现。

表3 YOLOv8n模型的训练结果

Tab.3 Training results of YOLOv8n model %

船舶类别ship category准确率precision召回率recall平均精度均值mAP@0.5平均绝对误差mAP@0.95渔船 fishing boat98.889.797.869.2执法船 law enforcement boat82.262.776.540.4拖船 tug93.889.697.165.1

表4 YOLOv8n-Bi-FPN-EMA模型的训练结果

Tab.4 Training results of YOLOv8n-Bi-FPN-EMA model %

船舶类别ship category准确率precision召回率recall平均精度均值mAP@0.5平均绝对误差mAP@0.95渔船 fishing boat99.184.497.867.4执法船 law enforcement boat92.159.576.137.6拖船 tug98.786.998.364.9

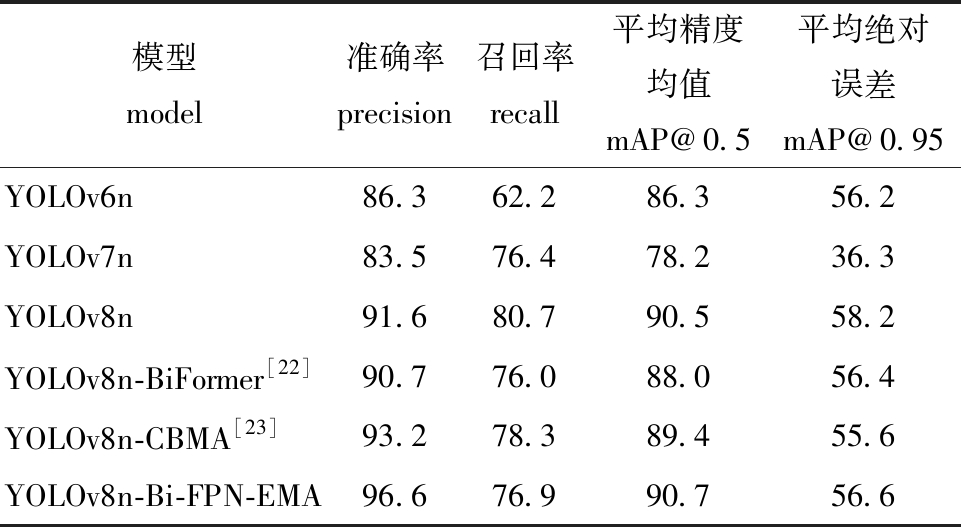

3.3.3 不同主流模型检测性能对比 从表5可见:YOLOv6n和YOLOv7n模型对本研究中数据检测的准确率较低,对小目标检测上的表现相对较差,可能是由于小目标定位不准确造成的;YOLOv6n模型对本研究中数据检测的召回率低于其他模型,这意味着该模型可能会漏检一些目标;YOLOv8n模型对本研究中数据的检测性能优于YOLOv6n和YOLOv7n模型,但是对小目标的识别能力还是有些不足;YOLOv8n-BiFormer模型相比YOLOv8n模型所有检测指标均有所下降,这可能是该注意力机制与本研究中数据不匹配造成的;YOLOv8n-CBMA模型对本研究中数据检测性能优于YOLOv8n模型,但不如YOLOv8n-Bi-FPN-EMA模型;YOLOv8n-Bi-FPN-EMA模型对本研究中数据在目标识别上有良好的效果,其中,准确率、mAP@0.5值均为最高,分别达到了96.6%、90.7%,该检测结果表明,与其他主流模型相比,YOLOv8n-Bi-FPN-EMA模型在目标识别方面具有明显的优势。

表5 各主流模型的检测性能比较

Tab.5 Comparison of detection performance among main models %

模型model准确率precision召回率recall平均精度均值mAP@0.5平均绝对误差mAP@0.95YOLOv6n86.362.286.356.2YOLOv7n83.576.478.236.3YOLOv8n91.680.790.558.2YOLOv8n-BiFormer[22]90.776.088.056.4YOLOv8n-CBMA[23]93.278.389.455.6YOLOv8n-Bi-FPN-EMA96.676.990.756.6

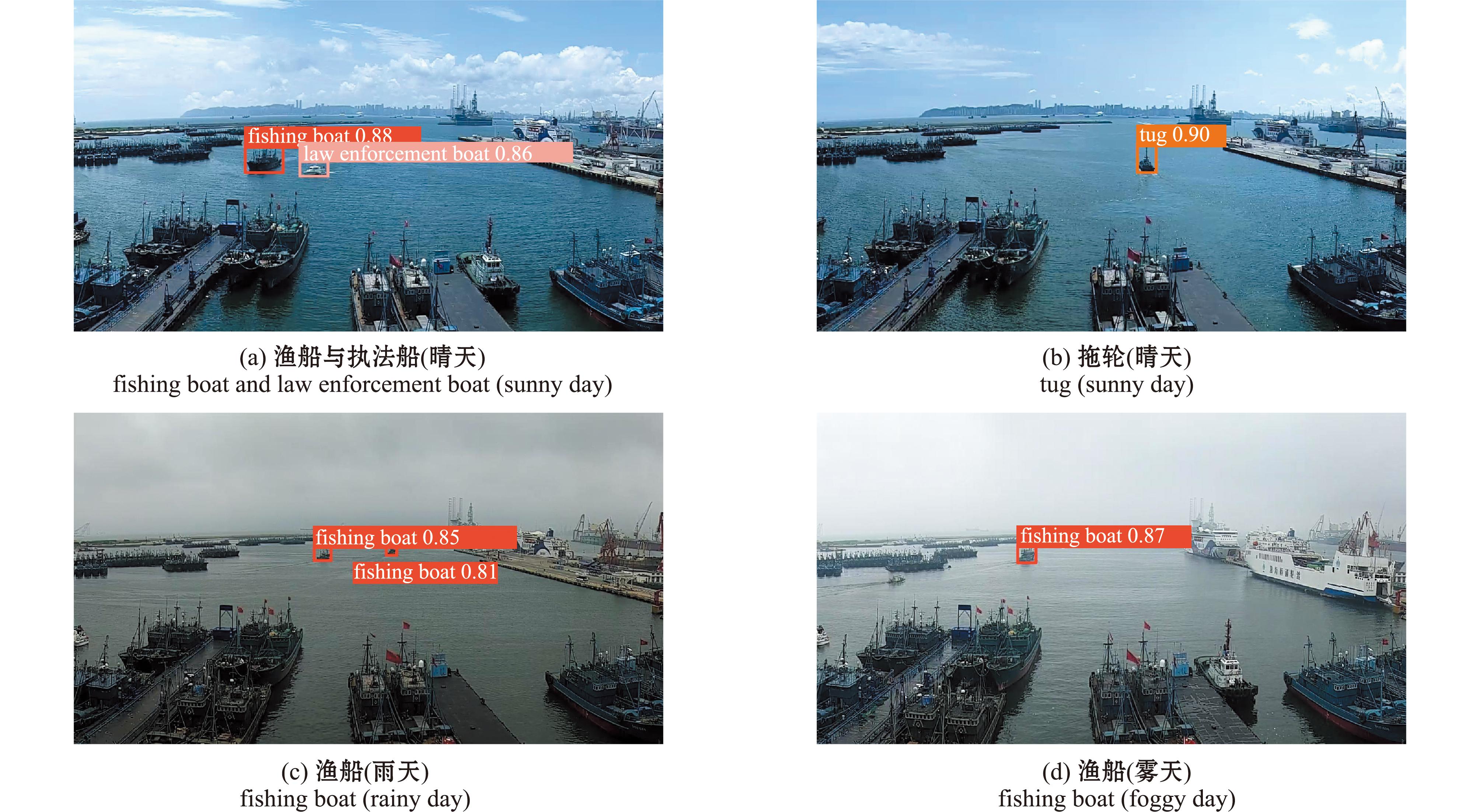

3.3.4 YOLOv8n-Bi-FPN-EMA模型检测效果 在目标检测过程中,应用该模型共检测了3种类型的船舶,选取4种有代表性的情景,分别为渔船与执法(晴天)、拖轮(晴天)、渔船(雨天)和渔船(雾天)。结果显示,与其他主流模型相比,该模型在晴天、雨天和雾天等多种天气情况下对不同类型船舶的识别效果良好(图5)。

图5 不同天气情况下YOLOv8n-Bi-FPN-EMA模型对进出渔港船舶的检测效果

Fig.5 Detection effect of YOLOv8n-Bi-FPN-EMA model on fishing port ship entry and exit under different weather conditions

3.4 船舶进出港统计

3.4.1 BoT-SORT跟踪算法 YOLOv8模型中集成了跟踪算法BoT-SORT[24]和ByteTrack以实现目标跟踪。BoT-SORT跟踪算法是Byte-Track跟踪算法的改进版本,是一种新的鲁棒性先进跟踪器,适用于相机运动的场景。BoT-SORT跟踪算法能将运动和外观信息的优势与摄像机运动补偿及更精确的卡尔曼滤波器状态向量结合起来,从而在MOTA、IDF1、HOTA性能指标上均超过了ByteTrack跟踪算法,成为最先进的跟踪器之一。目前,BoT-SORT跟踪算法广泛地应用于行人、车辆、船舶和各种鱼类等需要对其进行多目标跟踪计数与越界的识别中。

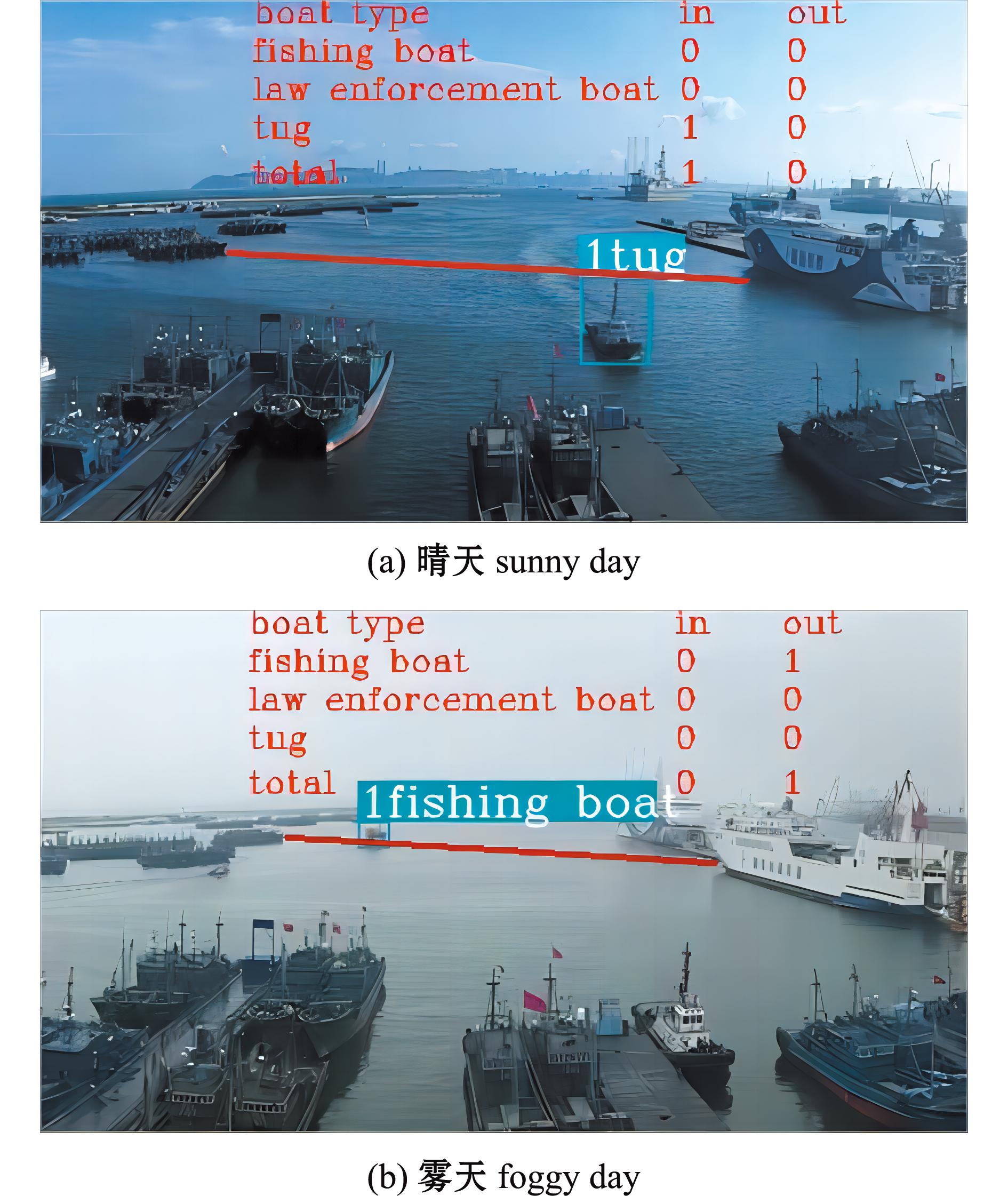

3.4.2 进出港船舶检测与统计试验及效果 使用YOLOv8n-Bi-FPN-EMA模型对进出港口的船舶进行目标检测,识别进出港动态过程中的船舶目标。同时,BoT-SORT跟踪算法接收YOLOv8模型输出的检测结果,并开始对这些船舶进行跟踪。BoT-SORT跟踪算法不仅对目标的运动轨迹进行预测,并持续更新目标的位置和状态,还可以识别目标的进出港行为,通过算法在视频中进行画线,船舶由近至远穿过标线为出港,而由远至近穿过标线为进港。最后,通过整合YOLOv8模型的目标检测结果和BoT-SORT跟踪算法获取的信息,可以得到完整的进出港统计信息,包括进出港船舶的数量与类型。

选择晴天与雾天两种天气下船舶进出港情景进行试验。从图6可见,在两种天气情况下,YOLOv8n-Bi-FPN-EMA模型均能准确识别出船舶的进出港行为,与实际情况吻合,表明该模型能准确识别出船舶类型并进行船舶进出港数量统计。

图6 不同天气情况下YOLOv8n-Bi-FPN-EMA模型对进出渔港船舶的检测与统计结果

Fig.6 Detection and statistical results of YOLOv8n-Bi-FPN-EMA model on fishing port ship entry and exit under different weather conditions

4 讨论

4.1 引入Bi-FPN网络结构对模型检测性能的影响

Bi-FPN网络结构是在PAN(path aggregation network)网络结构[25]的基础上增加了加权双向跨尺度连接和加权特征图融合,从而提高了目标检测效果。PAN可以看作是一个双向FPN,首先执行自顶向下的特征融合,随后进行自底向上的融合,从而实现了双向特征融合。与FPN相比,PAN增加了自下而上的路径,提升了性能,但也带来了较大的计算负担。Bi-FPN网络结构针对这一问题进行了优化,主要包括删除初始输入节点以减少冗余,添加融合更多特征的跳跃连接,同时不增加计算成本,以及将Bi-FPN网络结构视作基本单元进行重复堆叠以获得更多高层特征融合。这些优化使得Bi-FPN网络结构在保持高性能的同时,减少了计算量和参数量。这种优势使得Bi-FPN网络结构在复杂背景下的小目标识别任务中表现出色。在实际应用中,何旭鑫等[17]与程换新等[20]已经将Bi-FPN网络结构成功应用于多种目标检测模型,如YOLOv5模型和YOLOv8模型等。这些试验结果表明,引入Bi-FPN网络结构后,模型的识别准确率、召回率和mAP@0.5等指标均得到了提升。

本研究中,在YOLOv8n模型中引入Bi-FPN网络结构,提高了模型对小目标船舶识别的准确率与mAP@0.5。这不仅证明了Bi-FPN网络结构在小目标船舶识别领域的有效性,也为其在其他领域的应用提供了有力的支持。随着高点监控、无人机和合成孔径雷达图像(SAR)等技术的日益普及和应用,Bi-FPN网络结构展现出了广泛的应用前景。

4.2 引入EMA注意力机制模块对模型检测性能的影响

注意力机制作为一种有效的神经网络优化技术,已经在诸多任务中展示了卓越的效用。然而,对注意力机制的改进并不总是能如预期般显著提升性能,这恰好体现了机器学习模型设计的复杂性和微妙性。每一个任务的独特性、数据集的固有特征,以及模型架构的其他组成部分,都会影响到注意力机制的效果。因此,如何根据具体场景和需求来设计和调整注意力机制,是选择注意力机制中的关键问题。

本研究针对模型多尺度目标识别需求,引入了高效多尺度注意模块EMA。该模块通过更加精细和针对性的注意力分配策略,能提升模型在不同尺度目标上的检测性能。在实际场景中,目标的尺度多样性普遍存在,而传统单一或固定尺度的检测方法难以应对这种多变性。丘锐聪等[26]在YOLOv7-tiny模型基础上引入EMA注意力机制模块,提升了复杂背景下对船舶的识别能力,其准确率提升了0.4%,mAP@0.5提升了0.3%。本研究中在选择注意力机制时,借鉴了类似的思路,EMA注意力机制模块的引入,在不降低模型对近处大目标识别能力的同时,提高了模型对远处小目标的识别能力。通过这一改进,提高了模型总体的准确率和mAP@0.5,不仅展示了EMA注意力机制模块在提升模型性能方面的巨大潜力,也为多尺度目标检测任务提供了有效的解决方案。

5 结论

1)本研究中提出了一种基于改进YOLOv8模型的渔港船舶进出港目标检测与统计模型YOLOv8n-Bi-FPN-EMA,通过引入加权双向特征金字塔网络结构Bi-FPN与高效多尺度注意模块EMA,提升了模型的准确率与mAP@0.5。YOLOv8n-Bi-FPN-EMA模型对渔船的识别准确率为99.1%,召回率为84.4%,mAP@0.5为97.8%。表明该模型在渔船识别上有较好表现,可用于渔船识别与进出港统计的辅助工作。

2)YOLOv8n-Bi-FPN-EMA模型与BoT-SORT跟踪算法结合,能在多变天气下精准识别并跟踪各类船舶,实现船舶类型识别及进出港数量统计,具备实际工程应用价值。

3)YOLOv8n-Bi-FPN-EMA模型从渔港执法部门的实际需求出发,为减轻渔港执法人员对每日渔船进出港统计的人力成本、防止伏渔季非法捕捞及渔船在恶劣海况下出海作业起到了重要作用。后续需探索更好的改进方案,以实现更高精度的渔港船舶识别与统计,为中国渔业执法与智慧渔港建设提供参考。

[1] GIRSHICK R,DONAHUE J,DARRELL T,et al. Rich feature hierarchies for accurate object detection and semantic segmentation[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition(CVPR).Columbus,USA:IEEE,2014:580-587.

[2] LIU W,ANGUELOV D,ERHAN D,et al.SSD:single shot MultiBox detector[C]//European Conference on Computer Vision.Cham:Springer,2016:21-37.

[3] REDMON J,DIVVALA S,GIRSHICK R,et al.Youonly look once:unified,real-time object detection[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Las Vegas,NV,USA:IEEE,2016:779-788.

[4] LIN T Y,GOYAL P,GIRSHICK R,et al.Focal loss fordense object detection[C]//2017 IEEE International Conference on Computer Vision (ICCV).Venice,Italy:IEEE,2017:2999-3007.

[5] 张胜茂,孙永文,樊伟,等.面向海洋渔业捕捞生产的深度学习方法应用研究进展[J].大连海洋大学学报,2022,37(4):683-695.ZHANG S M,SUN Y W,FAN W,et al.Research progress in the application of deep learning methods for marine fishery production:a review[J].Journal of Dalian Ocean University,2022,37(4):683-695.(in Chinese)

[6] 王书献,张胜茂,朱文斌,等.基于深度学习YOLOV5网络模型的金枪鱼延绳钓电子监控系统目标检测应用[J].大连海洋大学学报,2021,36(5):842-850.WANG S X,ZHANG S M,ZHU W B,et al.Application of an electronic monitoring system for video target detection in tuna longline fishing based on YOLOV5 deep learning model[J].Journal of Dalian Ocean University,2021,36(5):842-850.(in Chinese)

[7] 涂万,于红,张鹏,等.基于通道非降维与空间协调注意力的改进YOLOv8养殖鱼群检测[J].大连海洋大学学报,2023,38(4):717-725.TU W,YU H,ZHANG P,et al.Farmed fish detection by improved YOLOv8 based on channel non-degradation with spatially coordinated attention[J].Journal of Dalian Ocean University,2023,38(4):717-725.(in Chinese)

[8] 袁红春,陶磊.基于改进的Yolov8商业渔船电子监控数据中鱼类的检测与识别[J].大连海洋大学学报,2023,38(3):533-542.YUAN H C,TAO L.Detection and identification of fish in electronic monitoring data of commercial fishing vessels based on improved Yolov8[J].Journal of Dalian Ocean University,2023,38(3):533-542.(in Chinese)

[9] 梅海彬,黄政,袁红春.基于YOLOv7模型改进的轻量级鱼类目标检测方法[J].大连海洋大学学报,2023,38(6):1032-1043.MEI H B,HUANG Z,YUAN H C.A lightweight fish object detection method improved based on the YOLOv7 model[J].Journal of Dalian Ocean University,2023,38(6):1032-1043.(in Chinese)

[10] 吴志高,陈明.基于改进YOLO v7的微藻轻量级检测方法[J].大连海洋大学学报,2023,38(1):129-139.WU Z G,CHEN M.Lightweight detection method for microalgae based on improved YOLO v7[J].Journal of Dalian Ocean University,2023,38(1):129-139.(in Chinese)

[11] SHAO Z F,WU W J,WANG Z Y,et al.SeaShips:a large-scale precisely annotated dataset for ship detection[J].IEEE Transactions on Multimedia,2018,20(10):2593-2604.

[12] CHEN P,LI Y,ZHOU H,et al.Detection of small ship objects using anchor boxes cluster and feature pyramid network model for SAR imagery[J].Journal of Marine Science and Engineering,2020,8(2):112.

[13] TAN M X,PANG R M,LE Q V.EfficientDet:scalable and efficient object detection[C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).Seattle,WA,USA:IEEE,2020:10778-10787.

[14] 张晓鹏,许志远,曲胜,等.基于改进YOLOv5深度学习的海上船舶识别算法[J].大连海洋大学学报,2022,37(5):866-872.ZHANG X P,XU Z Y,QU S,et al.Recognition algorithm of marine ship based on improved YOLOv5 deep learning[J].Journal of Dalian Ocean University,2022,37(5):866-872.(in Chinese)

[15] 张德春,李海涛,李勋,等.基于CBAM和BiFPN改进Yolov5的渔船目标检测[J].渔业现代化,2022,49(3):71-80.ZHANG D C,LI H T,LI X,et al.Optimization of Yolov5 fish vessel target detection based on CBAM and BiFPN[J].Fishery Modernization,2022,49(3):71-80.(in Chinese)

[16] LIN T Y,DOLL R P,GIRSHICK R,et al.Feature pyramid networks for object detection[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Honolulu,HI,USA:IEEE,2017:936-944.

R P,GIRSHICK R,et al.Feature pyramid networks for object detection[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Honolulu,HI,USA:IEEE,2017:936-944.

[17] 何旭鑫,吴建平,余咏,等.复杂背景下SAR舰船目标检测算法的改进[J].计算机技术与发展,2023,33(11):41-49.HE X X,WU J P,YU Y,et al.Improvement of SAR ship target detection algorithm in complex background[J].Computer Technology and Development,2023,33(11):41-49.(in Chinese)

[18] 刘家豪,陆玉芳.面向小目标检测的改进YOLOv5算法[J].实验室研究与探索,2023,42(8):105-110.LIU J H,LU Y F.Improved YOLOv5 algorithm for small object detection[J].Research and Exploration in Laboratory,2023,42(8):105-110.(in Chinese)

[19] 何宇豪,易明发,周先存,等.基于改进的Yolov5的无人机图像小目标检测[J/OL].智能系统学报,2023:1-12.(2023-12-04).https://kns.cnki.net/kcms/detail/23.1538.TP.20231204.1028.002.html.HE Y H,YI M F,ZHOU X C,et al.Small target detection in UAV image based on improved Yolov5[J/OL].CAAI Transactions on Intelligent Systems,2023:1-12.(2023-12-04).https://kns.cnki.net/kcms/detail/23.1538.TP.20231204.1028.002.html.(in Chinese)

[20] 程换新,乔庆元,骆晓玲,等.基于改进YOLOv8的无人机航拍图像目标检测算法[J].无线电工程,2024,54(4):871-881.CHENG H X,QIAO Q Y,LUO X L,et al.Object detection algorithm for UAV aerial image based on improved YOLOv8[J].Radio Engineering,2024,54(4):871-881.(in Chinese)

[21] OUYANG D L,HE S,ZHANG G Z,et al.Efficient multi-scale attention module with cross-spatial learning[C]//2023 IEEE International Conference on Acoustics,Speech and Signal Processing (ICASSP).Rhodes Island,Greece:IEEE,2023:1-5.

[22] ZHU L, WANG X, KE Z, et al. Biformer: vision transformer with bi-level routing attention[C]//Proceedings of the IEEE/CVF conference on computer vision and pattern recognition. 2023: 10323-10333.

[23] WOO S,PARK J,LEE J Y,et al.Cbam:convolutional block attention module[C]//Proceedings of the European conference on computer vision (ECCV).2018:3-19.https://openaccess.thecvf.com/content_ECCV_2018/html/Sanghyun_Woo_Convolutional_Block_Attention_ECCV_2018_paper.html

[24] AHARON N,ORFAIG R,BOBROVSKY B.BoT-SORT:robust associations multi-pedestrian tracking[EB/OL].2022.arXiv preprint arxiv:2206.14651.https://doi.org/10.48550/arXiv.2206.14651.

[25] LIU S,QI L,QIN H F,et al.Pathaggregation network for instance segmentation[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Salt Lake City,UT,USA:IEEE,2018:8759-8768.

[26] 丘锐聪,周海峰,陈颖,等.基于轻量化YOLOv7-tiny的船舶目标检测算法[J/OL].大连海事大学学报,2023:1-9.(2023-11-30).https://kns.cnki.net/kcms/detail/21.1360.U.20231129.1740.002.html.QIU R C,ZHOU H F,CHEN Y,et al.Ship target detection algorithm based on lightweight YOLOv7-tiny[J/OL].Journal of Dalian Maritime University,2023:1-9.(2023-11-30).https://kns.cnki.net/kcms/detail/21.1360.U.20231129.1740.002.html.(in Chinese)