渔业标准化是规范养殖生产过程和产品质量的一种技术手段,对于促进水产养殖的健康发展具有重要意义,渔业标准是渔业标准化的基础文件和关键支柱[1]。渔业健康养殖标准聚焦于渔业养殖过程,标准化养殖有助于保障水产品质量,提高养殖生产效率,降低养殖成本,从而提高养殖效益。渔业健康养殖标准中蕴含丰富的知识,其语言结构较为专业复杂,研究渔业健康养殖标准文本中抽取标准化知识对标准化养殖尤为重要。

对于渔业标准中的关系抽取,研究者目前普遍采用基于管道的抽取框架,此方法先识别文本中的所有实体,然后再进行实体配对并分配关系[2],这种方法可以充分利用实体识别的研究成果,搭配不同的关系匹配方法,具有一定的灵活性。相关研究中,程名等[3]提出了融合注意力机制(Self-Attention,SelfATT)和BiLSTM-CRF的渔业标准命名实体识别,但存在实体样本分布稀疏导致识别效果不佳的问题;杨鹤等[4]提出了多元组合数据增广方法,有效扩充了数据集,改善了实体样本分布稀疏的问题。上述针对渔业标准文本命名实体识别的研究虽取得了较好成效,但实体间关系还是采用就近原则进行匹配,仍无法有效解决重叠关系。在此基础上,杨鹤等[5]进一步提出了一种基于双重注意力机制的渔业标准实体关系抽取方法,以重叠标签的形式对实体标签进行扩充,有效解决了渔业标准文本中的一对多关系和多对一关系的实体关系抽取问题,但由于实体抽取时与标签高度绑定,重叠标签无法解决一个实体对应多个不同关系的情况,存在一定局限性,同时分段式工作也使误差传递的问题较为突出。

对于一个实体同时拥有不同关系标签的情况,研究者们将目光集中于联合抽取方法,即在一次任务中提取实体和关系[6-8]。这种方法更注重实体识别与关系预测之间的相关性,也可以缓解误差传递的问题。相关研究中,Wei等[9]提出了CasRel模型,该模型将关系抽取任务的两个子任务整合,在重叠关系抽取任务中取得了显著成效,但未解决误差传递的问题;Wang等[10]针对误差传递的问题提出了TPLinker模型,在每一个关系上均创建两个矩阵,将头实体与尾实体放入矩阵中对齐,实现了同时抽取实体和关系,有效缓解了误差传递的问题,但该方法收敛速度低并有严重的冗余问题;Su等[11]对TPLinker进行了改进,提出了GPLinker模型,该模型加入了实体类别矩阵,在关系抽取的准确率上有了较大提升,但仍未解决冗余问题;Zheng等[12]为解决冗余问题提出了PRGC模型,该模型先判断句子中含有的关系,再根据关系对原句进行实体抽取,这种方法大大减少了需要判断的关系,但该方法使误差传递的问题又变得较为严重;Shang等[13]提出了OneRel模型,将任务转化为表格填充问题,该模型使用单独的关系矩阵学习头实体、关系和尾实体的依赖关系,有效缓解了误差传播和计算冗余问题,但仍存在冗余信息;Ren等[14]提出的BiRTE模型,采用双向提取框架,其优点在于提取过程中可以通过双向互补减轻抽取误差,该模型还提出了一种共享感知学习机制以解决收敛速度不一致的情况,将工作较为明确地分为实体抽取和关系抽取两部分,但该模型并未充分利用实体与关系之间的客观联系。

与通用领域相比,渔业标准文本专业性强、逻辑复杂,基于上述的深度学习方法对渔业标准进行实体抽取存在渔业专有名词识别不好、实体对匹配错误等问题。本研究中,根据渔业健康养殖标准实际情况及特点创建了渔业健康养殖标准数据集,并提出了基于改进BiRTE的渔业健康养殖标准复杂关系抽取模型(RoBERTa-BiRTE-SelfATT),使用RoBERTa丰富词向量信息并增强其特征表示,同时在模型关联实体抽取部分融合自注意力机制,将实体特征进行强化聚焦,并引入关系信息进行指导,优化权重分配、消除噪声,提高关联实体的定位能力,以期提升模型的抽取精度。

1 渔业标准复杂关系抽取模型

1.1 数据采集与标注

1.1.1 数据采集 本文中所用试验数据来自渔业生产技术标准文本,该类标准文本大部分以书籍、PDF文件和图片等形式存在且缺少公开数据集。本研究中构建的渔业标准复杂关系数据集中涉及文件主要从国家标准全文公开系统网站(https://openstd.samr.gov.cn/bzgk/gb/)下载,共计200余篇,经过正则、筛选等预处理操作对数据进行清洗,得到格式规范的渔业健康养殖标准语料文本。

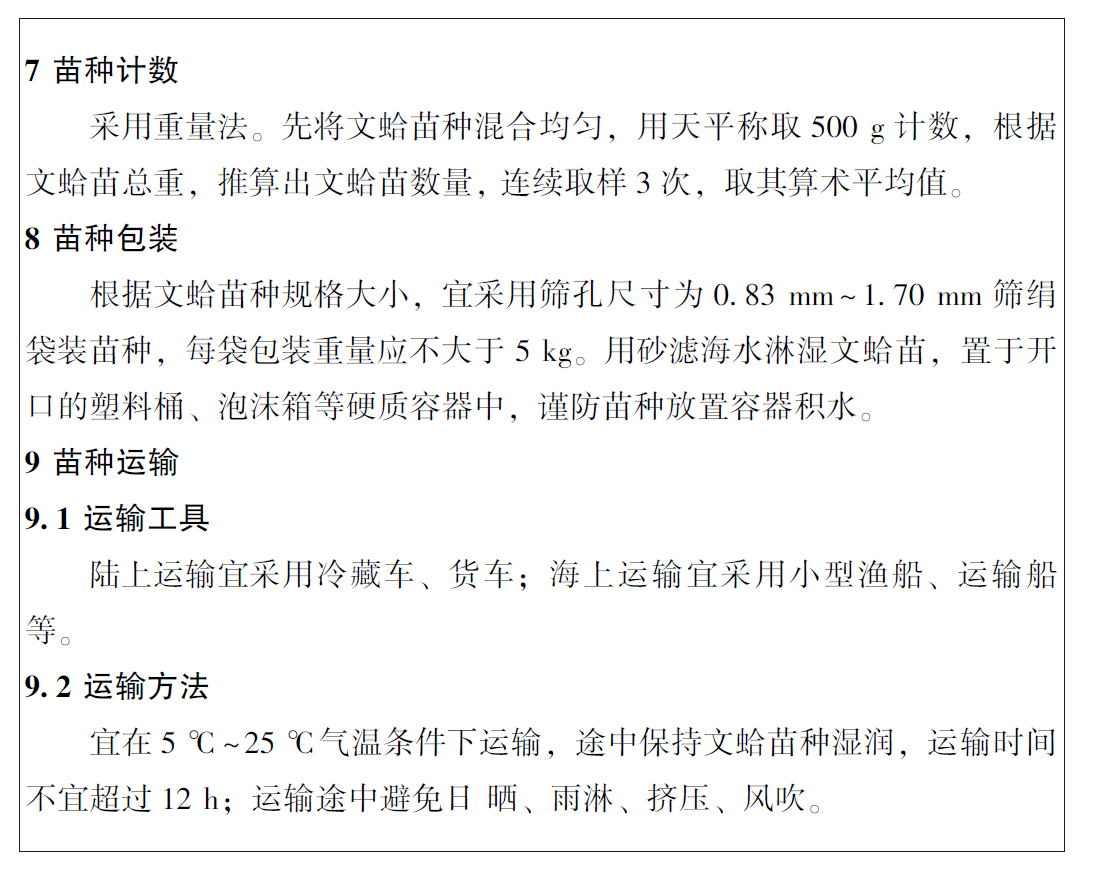

1.1.2 类别划分 为了更有效地抽取渔业健康养殖标准知识,需要根据渔业健康养殖标准特点设计渔业标准复杂关系数据集[15]。从图1可见,渔业标准文本专业性强、逻辑关系复杂,其中,复杂关系的抽取是渔业标准文本关系抽取任务中的难点。

图1 渔业标准实例

Fig.1 Examples of fisheries standards

渔业标准中的复杂关系主要是重叠关系,可以归纳为3类:

1)一个实体在多个关系不同的三元组中充当头实体,将其称为并联关系。这类情况与一对多关系类似,不同之处在于一对多问题局限于同一关系中[4],当一个实体出现多种关系时,会因实体和标签绑定导致无法抽取。

2)多个实体在多个三元组中以首尾嵌套形式存在,将其称为串联关系。这类情况的特点不是将关系三元组中的实体固定作为头实体或尾实体,而是在不同的三元组中扮演不同的角色,所以在抽取基础实体和抽取关联实体的时候都需要进行抽取。

3)多个实体是以上述两种情况的混合形式存在,将其称为混联关系。部分实体存在多种关系且扮演多个角色的情况,其三元组组合数量较上述两种类型更多,结构更复杂。

渔业标准文本中的复杂关系实例如表1所示。

表1 渔业标准文本中的复杂关系类型实例

Tab.1 Examples of complex relation types in fisheries standard texts

关系类型relation type关系示意图relation diagram文本例句example sentence关系实例图relationship instance diagram并联关系parallel Ar1B1B2r2B3〈A,r1,B1〉〈A,r1,B2〉〈A,r2,B3〉“DB21/T 2144—2013规定了毛蚶的术语和定义、质量要求、检验方法、检验规则、计数方法和运输等要求。”DB21/T 2144—2013 适用于毛蚶 规定术语和定义 规定质量要求 ............串联关系series Ar1Br2Cr3D〈A,r1,B〉→〈B,r2,C〉〈C,r3,D〉“亲鱼雌雄比为1∶1”亲鱼 包括雌雄比 取值1∶1混联关系mixture Ar(Br0D)C1C2〈A,r,B〉 〈B,r0,D〉〈A,r,C1〉〈A,r,C2〉“养殖用水温度32 ℃为宜,且不含孔雀绿、硝酸盐、次氯酸等物质。”养殖用水 包括水温 取值32 ℃ 不含孔雀绿 不含硝酸盐 不含次氯酸

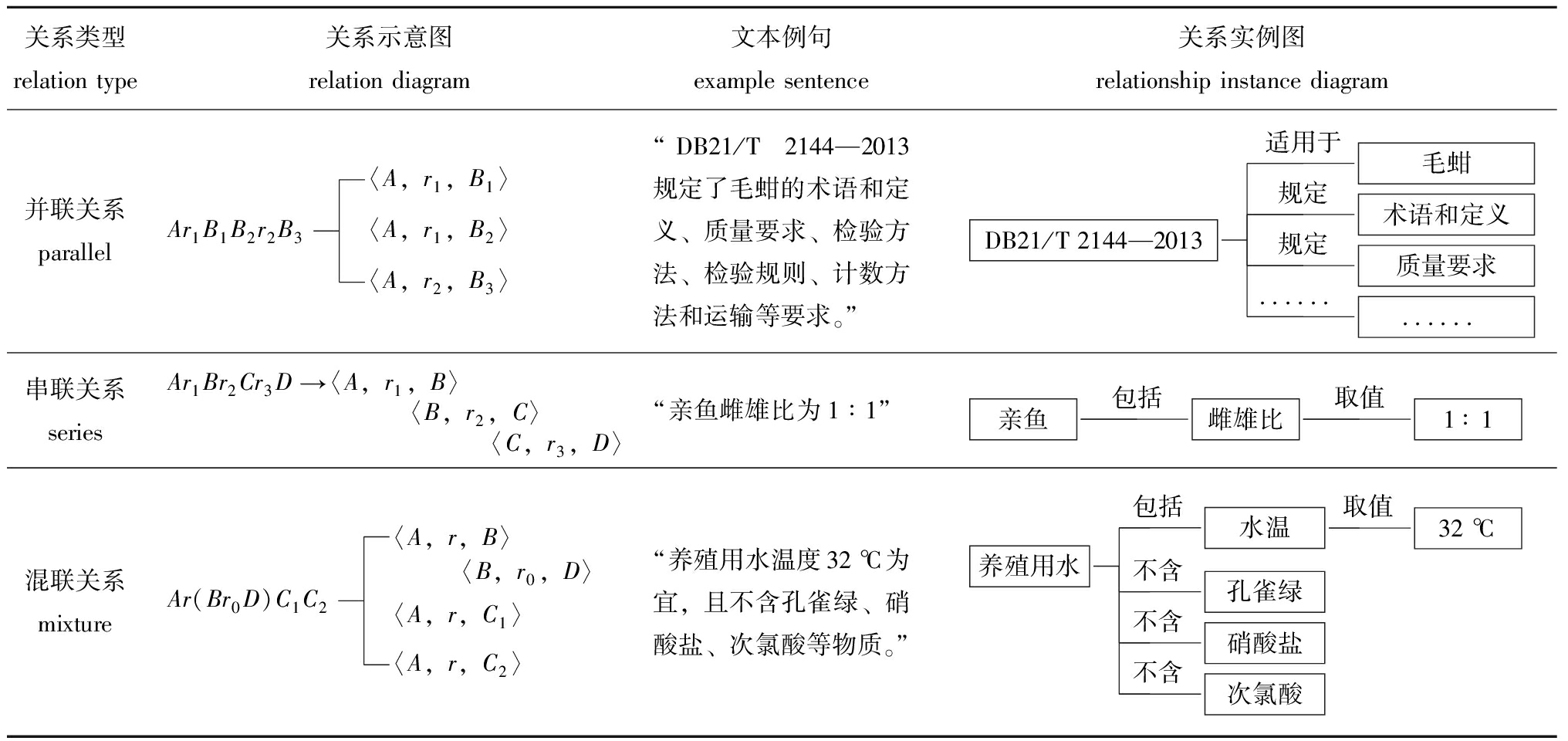

1.1.3 标注方法及规则 渔业标准文本数据中的实体可以归纳为7类,即标准号、枝指标、叶指标、指标值、人物、机构和水产生物。实体间的关系可分为9类,即取值、包括、规定、引用、适用于、起草、归口、提出和发布,标注示例见表2,其中,归口、提出类关系与起草类标注方法完全相同。数据标注形式为基于跨度的关系三元组格式,即o=<头实体,关系,尾实体>,其中“实体”表示该实体的开始位置与结束位置,在句子第n位开始,长度为len的实体表示为(n,n+len)。由于基于跨度的标注方法关系以三元组的形式表现,实体不受标签限制,可以同时存在于多个关系的三元组中,因此,存在多种关系的实体无需额外进行标识。

表2 渔业健康养殖标准数据集示例

Tab.2 Example of the fisheries healthy farming standard dataset

例句 example sentence头实体 subject关系 relation尾实体 objectDB21/T 2144—2013(标准号)适用于毛蚶(水产生物)“DB21/T 2144—2013规定了毛蚶的术语和定义、质量要求、检验方法、检验规则、计数方法和运输等要求。”DB21/T 2144—2013(标准号)规定术语和定义(枝指标)DB21/T 2144—2013(标准号)规定质量要求(枝指标)………养殖用水(枝指标)包括温度(叶指标)“养殖用水温度32 ℃为宜,且不含孔雀绿、硝酸盐、次氯酸等物质。”温度(叶指标)取值32 ℃(指标值)养殖用水(枝指标)不含孔雀绿(叶指标)………“GB 21046—2007主要起草人:许璞、朱建许璞(人物)起草GB 21046—2007(标准号)一、陆勤勤、王汉清、袁昭岚。”朱建(人物)起草GB 21046—2007(标准号)………“场地环境应符合GB/T 18407.4的规定。”场地环境(枝指标)引用GB/T 18407.4(标准号)

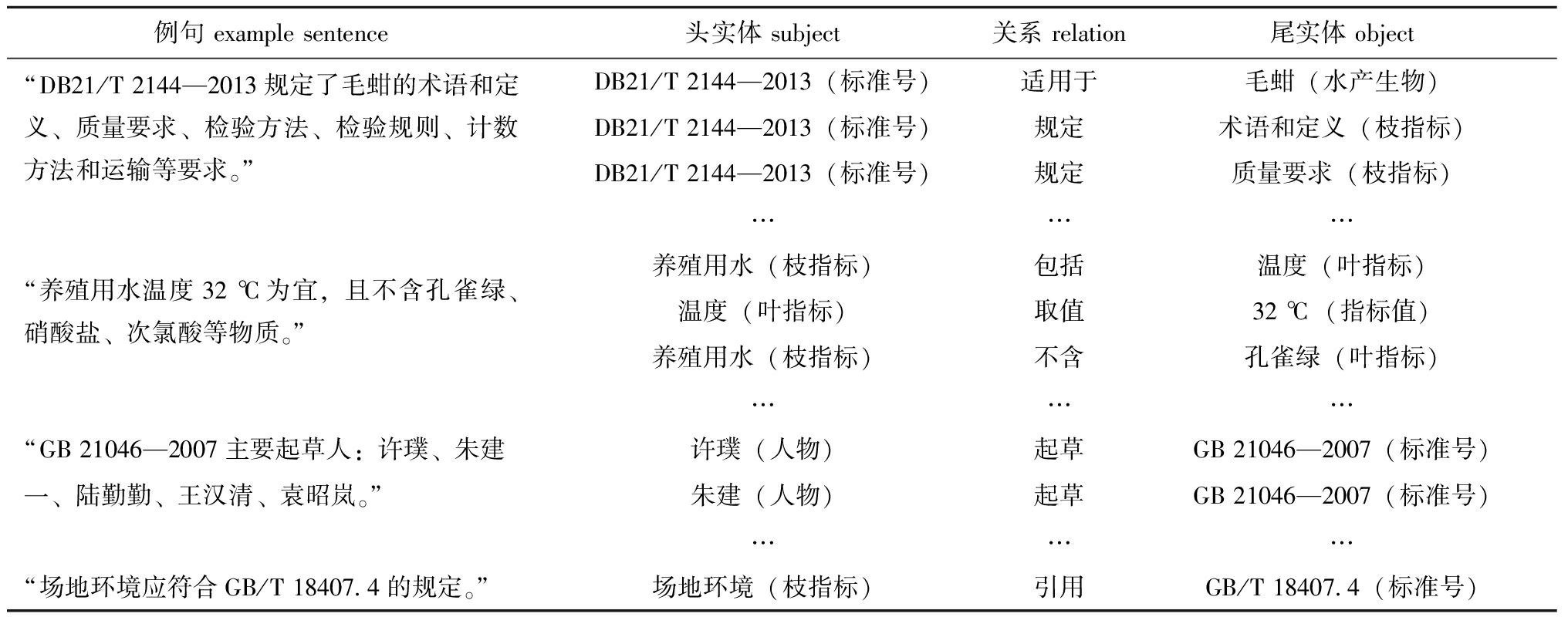

将标注好的数据根据7∶2∶1的比例随机分配为训练集、验证集和测试集,其中,训练集为1 374条数据,验证集为476条数据,测试集为227条数据。各数据集简单关系及复杂关系数量见表3。

表3 数据构成及分配

Tab.3 Data composition and distribution

数据集data set简单关系数据simple relation data复杂关系数据complex relation data总计total训练集 training set5578171 374验证集 validation set179297476测试集 test set81146227

1.2 渔业标准复杂关系抽取模型

BiRTE[14]模型将复杂关系抽取任务分为实体抽取与关系匹配两部分。首先编码器分别将头实体、尾实体和关系生成3种不同的标记序列,该序列作为一种上下文特征用于输入下游任务;实体抽取部分通过平行的双向框架抽取实体对,即分别通过头实体和尾实体抽取相应的实体对,每个方向的抽取都可以概述为先抽取一个基础实体,再根据基础实体抽取关联实体组成实体对;之后通过Biaffine模型为每个实体对分配所有可能的关系。在实际使用中,BiRTE模型会因为渔业专有名词识别不佳、实体对匹配错误等问题,导致渔业标准中的复杂关系抽取效果不好。为解决上述问题,本研究中在文本编码部分及实体识别部分进行了改进。

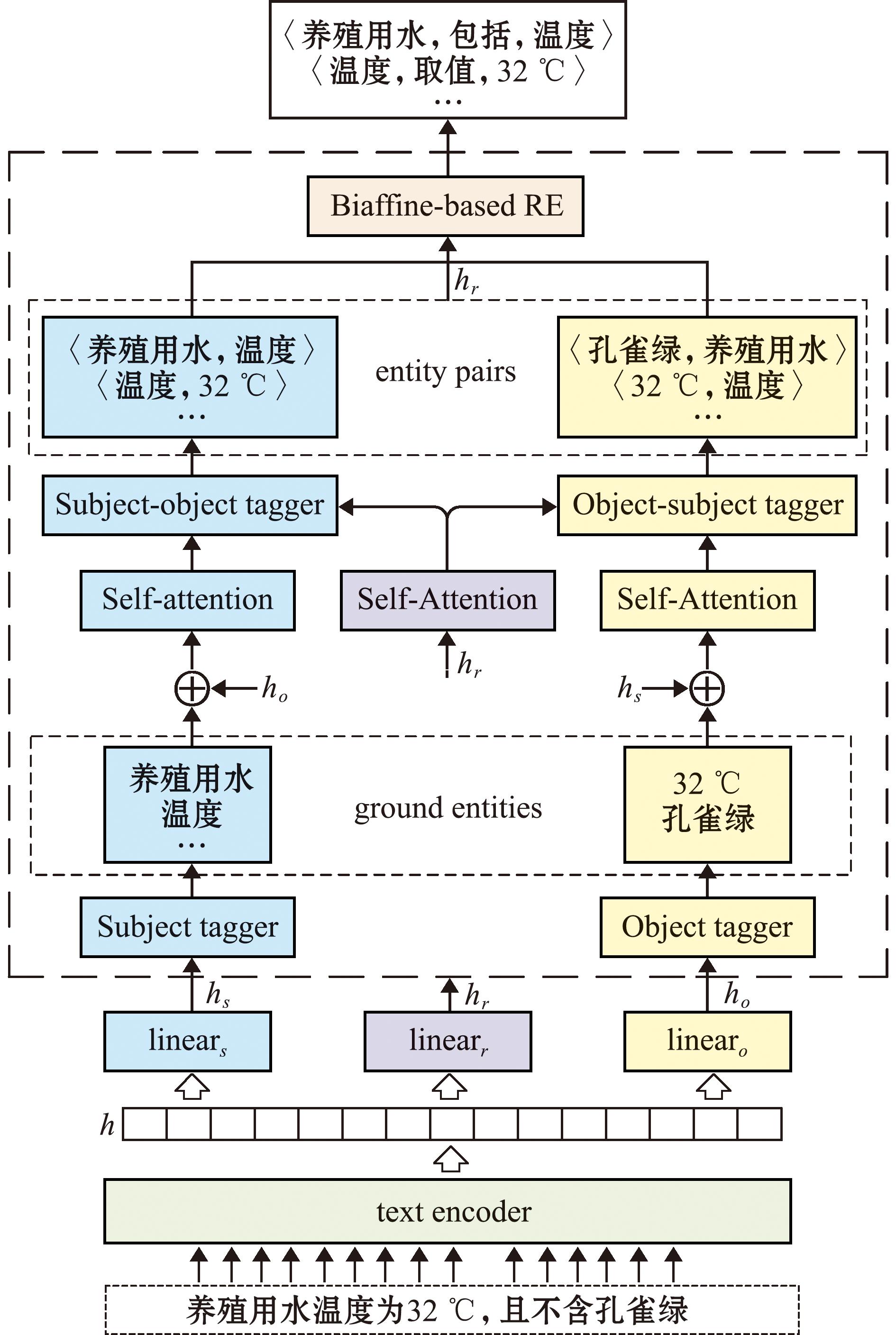

RoBERTa-BiRTE-SelfATT网络结构主要由3个部分组成,即编码器部分(RoBERTa-wwm)、双向实体对抽取部分(BiEPE)和抽取部分(图2)。

图2 RoBERTa-BiRTE-SelfATT网络结构

Fig.2 RoBERTa-BiRTE-SelfATT structure

1.2.1 编码器(RoBERTa-wwm) RoBERTa是基于BERT的优化版本,由多层双向Transformer组成,较BERT有更大的模型参数量和更多的训练数据,同时使用了动态掩码,每次向模型输入一个序列时都会生成新的掩码模式[16]。

wwm(whole word masking)指的是全词掩码,该方法以词为单位进行掩码,而非传统BERT所用的以字为单位,可以在中文语料中取得更好的效果[17-18]。

实体、尾实体和关系有各自的特征,BiRTE模型根据这3种特征分别表示为![]() 其表达式为

其表达式为

(1)

(2)

(3)

式中:下角标s、o、r分别代表头实体、尾实体和关系;h为特征向量;W为权重矩阵;b为偏置矩阵。

同时,头实体和尾实体高度相关,一个实体的特征将有助于提升另一实体的提取效果,因此,将尾实体表示序列的CLS向量![]() 加入到头实体特征中,以增强头实体特征的表示能力。在尾实体部分也做了同样的操作,即

加入到头实体特征中,以增强头实体特征的表示能力。在尾实体部分也做了同样的操作,即

(4)

(5)

1.2.2 双向实体对的抽取(BiEPE) BiEPE基于双向框架,从以下两个方向提取实体对:先提取头实体,再提取以头实体为条件的尾实体(S2O);先提取尾实体,再提取以尾实体为条件的头实体(O2S),两个方向共享编码器部分得到的特征。两个方向结构相似,本文中仅以头实体为基础实体、尾实体为配对实体(S2O)的方向为例进行介绍。

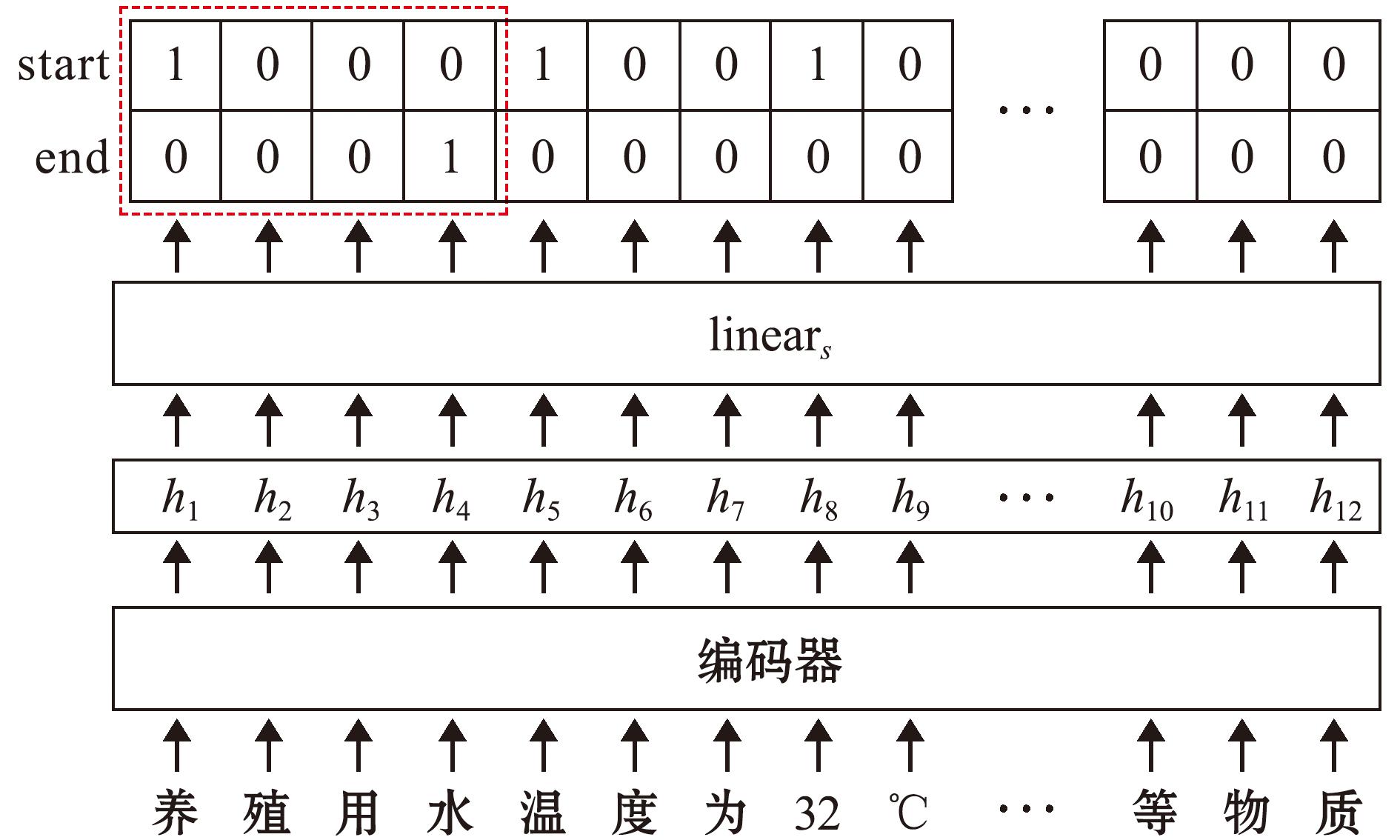

1)头实体抽取(Subject tagger)。头实体抽取模块是基于二元指针网络标记的模块,从图3可见,对于输入句子中的每个位置预测两个概率,并通过预设的阈值将结果二分,用1/0表示,若一个位置为1,则表示该位置是一个实体的开始或结尾。概率计算公式为

(6)

图3 头实体抽取流程

Fig.3 Flow chart of subject tagger

(7)

式中:![]() 和

和![]() 分别为第i个位置是头实体开始和结束位置的概率;σ(·)为sigmoid激活函数。

分别为第i个位置是头实体开始和结束位置的概率;σ(·)为sigmoid激活函数。

2)以头实体为条件的尾实体抽取(Subject-object tagger)。为了更好地利用尾实体与头实体的相关性提取尾实体,本文中引入了自注意力机制,目的是让神经网络关注力聚焦于关键实体,进而得到头实体向量的序列表示(Ae),即

(8)

式中:Q、K、V分别为同一输入经过不同线性变换得到的向量分别组成的矩阵;![]() 为保持训练过程中梯度稳定的缩放因子;softmax(·)为归一化激活函数。

为保持训练过程中梯度稳定的缩放因子;softmax(·)为归一化激活函数。

为了充分利用关系与实体的联系,减少错误的尾实体抽取,对文本中的关系向量进行相同的自注意力操作,得到关系向量的序列表示Ar。再根据Ae和Ar计算得到尾实体抽取过程,即

(9)

(10)

式中:![]() 和

和![]() 分别为第i个位置是尾实体开始位置和结束位置的概率。

分别为第i个位置是尾实体开始位置和结束位置的概率。

1.2.3 关系抽取(Biaffine) 双向框架相比于CasRel单向模型[9]能得到更多的实体对,其中噪声对数量也更多,这并不利于模型精度。Biaffine模型为每个关系创建一个矩阵,可以更准确地把控建模关系特征。对于一个实体对(sk,oi),本研究中首先获得其向量![]() 然后计算二者具有某一关系的可能性

然后计算二者具有某一关系的可能性![]() 计算公式为

计算公式为

(11)

(12)

(13)

2 渔业标准复杂关系抽取试验

2.1 试验环境及评价指标

硬件环境为Intel(R)Core(TM)i7-11700k CPU@3.60 GHz,16 GB内存,GPU为NVIDIA GeForce RTX 3090 24 GB,Windows 10操作系统,试验平台为PyCharm。

评价指标采用准确率(precision)、召回率(recall)和F1值(F score)[3],其中,F1值为模型综合评价指标。

2.2 试验参数

从表4可见,通过反复在自建渔业标准复杂关系数据集试验确定最优参数,其中,对模型效果影响较大的参数有学习率、批处理和迭代次数。学习率较高可能导致错过最优值,较小可能导致收敛缓慢及梯度损失;批处理尺寸太大容易使模型局部收敛,而尺寸太小容易使模型跳出鞍点,需要与学习率结合调整;迭代次数决定了模型效果,但是过度的训练会出现过拟合现象,导致模型效果下降。本文通过控制变量法找到最适参数。

表4 模型参数设置

Tab.4 Parameter setting

参数 parameter数值 value学习率 learning rate3×10-5批处理 batch size6迭代次数 epoch times100梯度裁剪max grades norm1.0随机失活层 dropout0.1多头注意力头数 heads of multi-head attention12

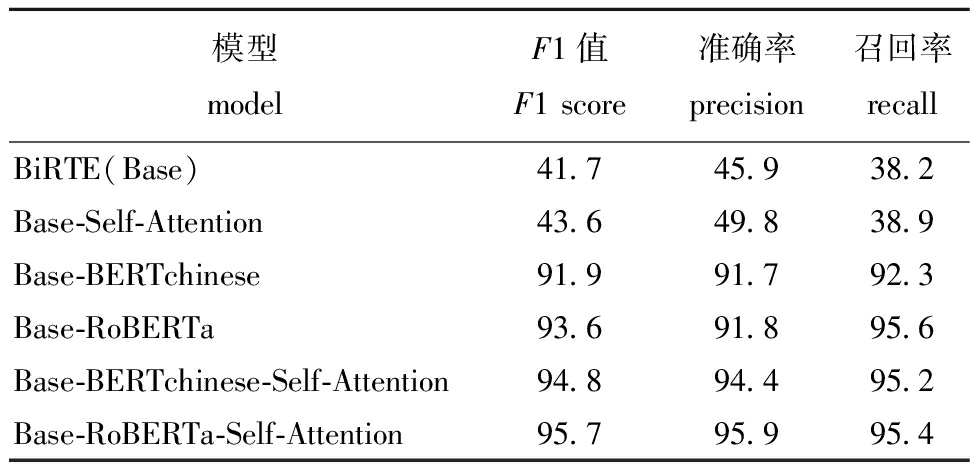

2.3 消融试验

在训练过程中,模型所有参数保持不变。试验结果如表5所示,在BiRTE模型(面向英文数据集)基础上加入自注意力机制(Self-Attention),模型的抽取准确率和召回率分别提升了3.9%和0.7%,但由于原模型使用的编码器主要用于英文数据,因此,对中文数据集处理整体效果仍较差。在BiRTE模型基础上分别加入不同种中文预训练模型,加入RoBERTa模型比加入BERTchinese模型的抽取准确率和召回率分别高出0.1%和3.3%,原因是RoBERTa学习能力更强,对专业性较强的文本有更好的识别能力。在加入RoBERTa模型的基础上再加入自注意力机制,模型的抽取准确率较只加入RoBERTa提升了4.1%,虽然召回率略有降低,但F1值提升更为明显,提升达到2.1%。因此,可以认为对模型的改进有效提高了对渔业标准中复杂关系的抽取能力。

表5 消融试验结果

Tab.5 Results of ablation experiments %

模型modelF1值F1 score准确率precision召回率recallBiRTE(Base)41.745.938.2Base-Self-Attention43.649.838.9Base-BERTchinese91.991.792.3Base-RoBERTa93.691.895.6Base-BERTchinese-Self-Attention94.894.495.2Base-RoBERTa-Self-Attention95.795.995.4

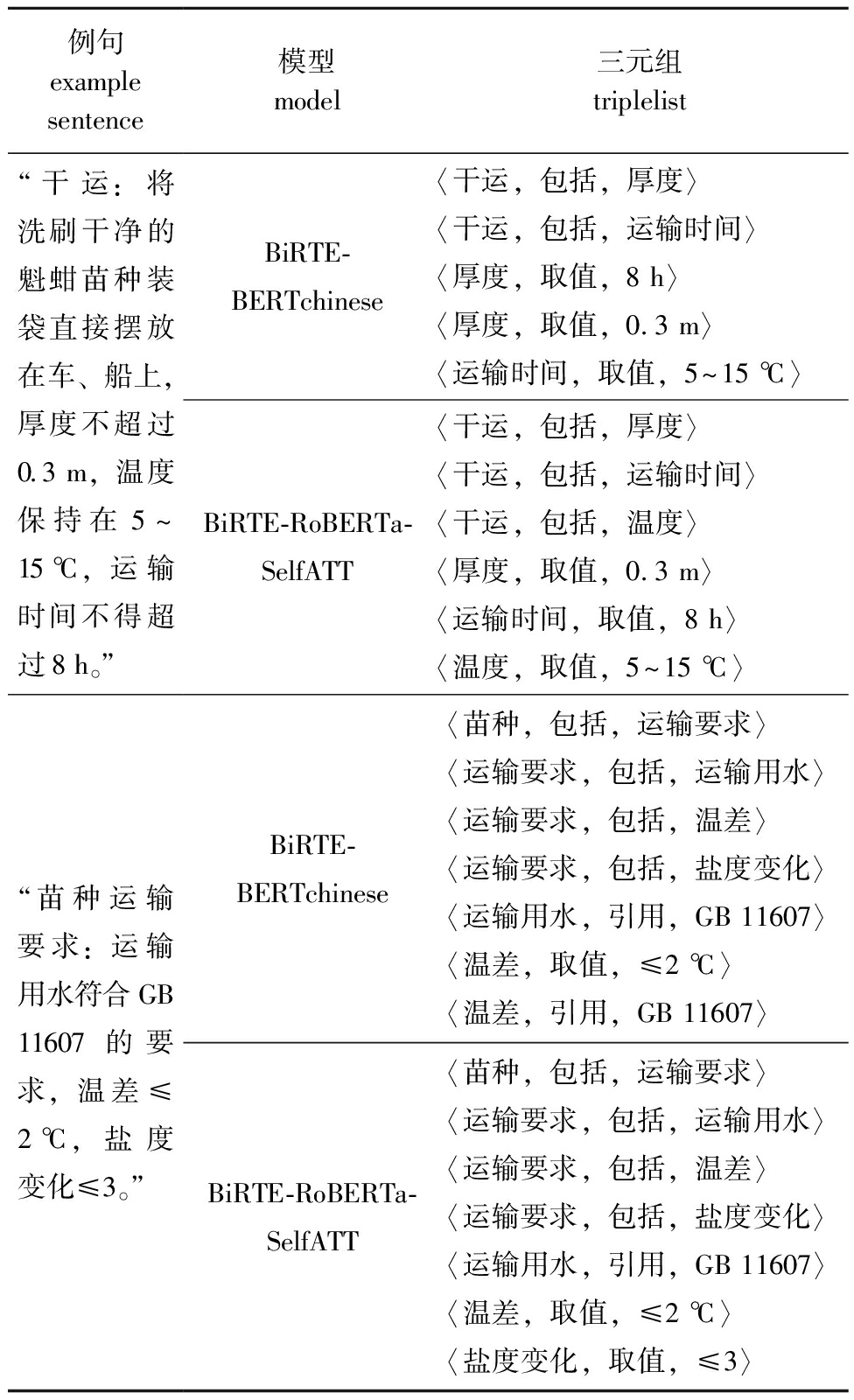

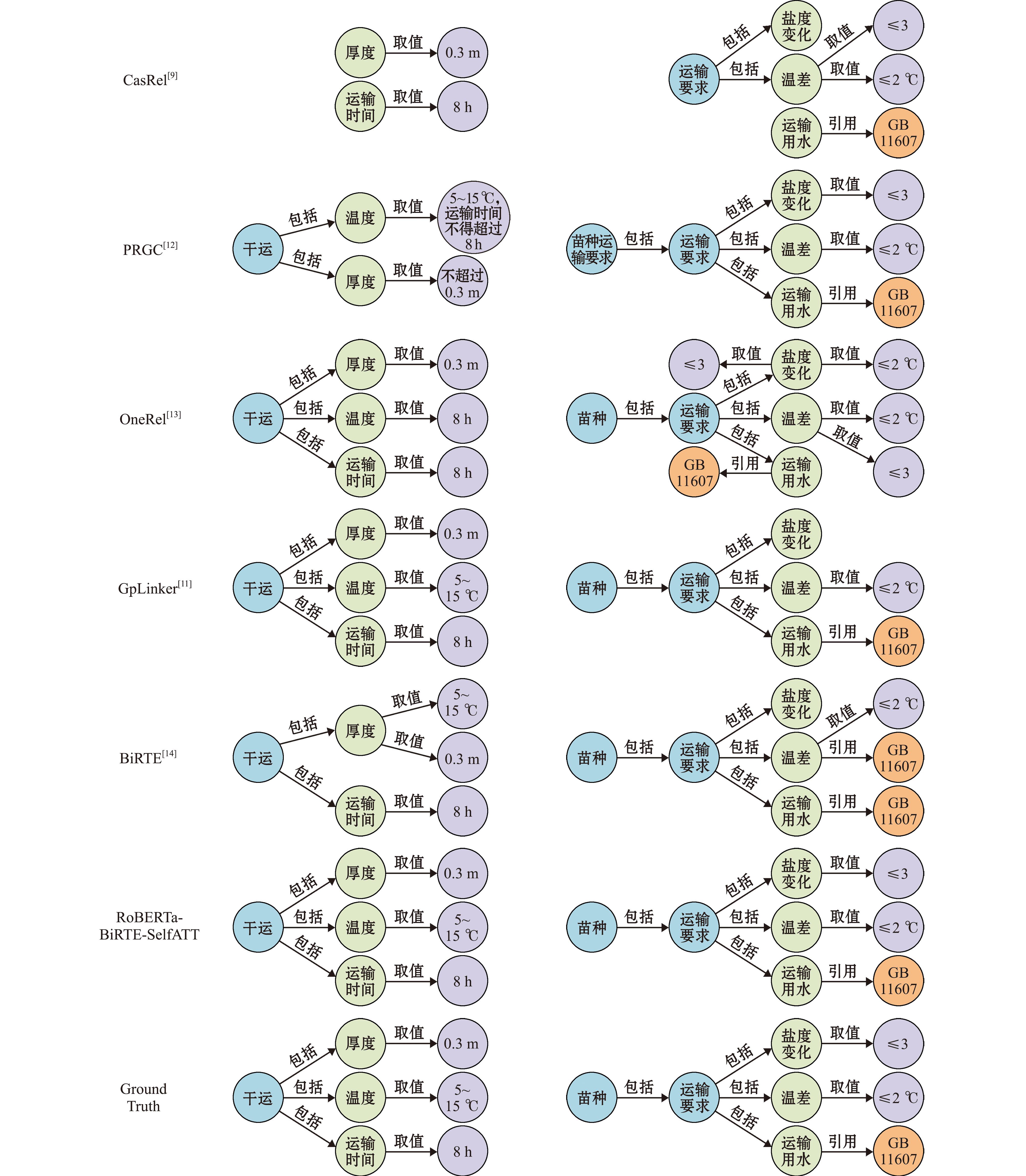

从表6可见,BiRTE-BERTchinese虽然使用了基础的中文编码器,但抽取结果存在实体配对错误、 预测结果不完全的问题,而在BiRTE-RoBERTa-SelfATT模型的抽取结果中,这类问题得到了改善。因此,可以认为该模型有效改进了BiRTE模型对渔业标准垂直领域中复杂关系的抽取效果。

表6 复杂关系抽取试验结果对比实例

Tab.6 Comparative results of complex relation extraction experiments

例句 example sentence模型 model三元组 triplelist“干运:将洗刷干净的魁蚶苗种装袋直接摆放在车、船上,厚度不超过0.3 m,温度保持在5~15 ℃,运输时间不得超过8 h。”BiRTE-BERTchinese〈干运,包括,厚度〉〈干运,包括,运输时间〉〈厚度,取值,8 h〉〈厚度,取值,0.3 m〉〈运输时间,取值,5~15 ℃〉BiRTE-RoBERTa-SelfATT〈干运,包括,厚度〉〈干运,包括,运输时间〉〈干运,包括,温度〉〈厚度,取值,0.3 m〉〈运输时间,取值,8 h〉〈温度,取值,5~15 ℃〉“苗种运输要求:运输用水符合GB 11607的要求,温差≤2 ℃,盐度变化≤3。”BiRTE-BERTchinese〈苗种,包括,运输要求〉〈运输要求,包括,运输用水〉〈运输要求,包括,温差〉〈运输要求,包括,盐度变化〉〈运输用水,引用,GB 11607〉〈温差,取值,≤2 ℃〉〈温差,引用,GB 11607〉BiRTE-RoBERTa-SelfATT〈苗种,包括,运输要求〉〈运输要求,包括,运输用水〉〈运输要求,包括,温差〉〈运输要求,包括,盐度变化〉〈运输用水,引用,GB 11607〉〈温差,取值,≤2 ℃〉〈盐度变化,取值,≤3〉

2.4 不同模型抽取对比试验

为验证RoBERTa-BiRTE-SelfATT模型对渔业标准文本中复杂关系抽取的有效性,与以下先进模型进行对比试验,包括CasRel[9]、PRGC[12]、OneRel[13]、GPLinker[11]及原模型BiRTE[14]。这些模型都是面向英文数据集的,对中文处理效果较差,为公平起见,对上述模型统一进行修改,统一使用面向中文的基础编码器BERTchinese。

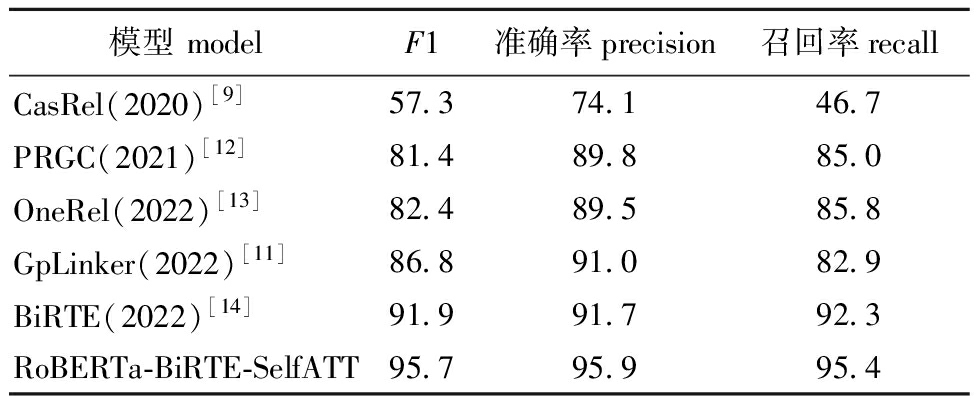

从表7可见:CasRel因为误差传递较为严重,抽取效果不佳;PRGC、OneRel和GpLinker 3个模型较CasRel模型的抽取准确率提升较大,但召回率并不高,即数据中大量信息并未被抽取到;BiRTE模型整体抽取效果较其他模型均有较大提升且较为均衡;而改进后的RoBERTa-BiRTE-SelfATT模型抽取精确率和召回率分别为95.9%和95.4%。这表明,本文中提出的模型在渔业标准文本数据集上与其他模型相比抽取效果较佳。

表7 不同模型的抽取性能对比

Tab.7 Comparison of extraction performance in different models %

模型 modelF1准确率precision召回率recallCasRel(2020)[9]57.374.146.7PRGC(2021)[12]81.489.885.0OneRel(2022)[13]82.489.585.8GpLinker(2022)[11]86.891.082.9BiRTE(2022)[14]91.991.792.3RoBERTa-BiRTE-SelfATT95.795.995.4

为直观展示各模型的抽取效果,将两段渔业标准文本的抽取结果通过图谱进行可视化分析。除RoBERTa-BiRTE-SelfATT外,其他模型均存在不同程度的遗漏抽取或错误配对的情况。这是因为RoBERTa-BiRTE-SelfATT模型将关系融入实体对抽取中,有效地加强了实体对的匹配能力(图4)。

“干运”和“苗种运输要求”实例见表6。

Examples of “air exposure transportation” and “seedling transportation requirements” are shown in Table 6.

图4 不同模型对标准中复杂关系例句的抽取效果

Fig.4 Extraction effects of different models on complex relation example sentences

3 讨论

3.1 模型的选取

深度学习模型在关系抽取方面应用广泛,目前关系抽取效果较好的模型主要基于联合抽取方法,如PRGC[12]、GPLinker[11]和BiRTE[14]等模型均在公共数据集上取得了不错的效果。与通用领域相比,渔业标准文本专业性强、逻辑复杂,上述模型在应用中存在渔业专有名词识别不佳、实体对匹配错误等问题,需要进一步改进。BiRTE模型[14]由于采用双向结构,能有效地减少由于实体抽取遗漏导致的误差传递,同时该模型在渔业标准数据集上取得的抽取效果优于其他同类模型。因此,本试验中选用该模型作为基础模型并进行改进,用于渔业标准复杂关系的抽取工作。

3.2 引入RoBERTa对抽取效果的影响

中文语言逻辑较为特殊,不同于英文的单字成义,中文语义最小单位常以词的形式出现,这导致很多先进模型在中文语料上效果不佳。为解决此问题,通常会引入更适合中文语料的编码器,帮助模型学习中文语料特征。王桂江等[19]将K-BERT模型引入了中文情感分析研究中,在验证集上的抽取准确率提升了0.79%,K-BERT模型对信息的局部特征提取能力和核心语义的掌控能力较强,但在专业领域表现欠佳。喻金平等[20]针对扶持政策中实体边界难以划分且存在一词多义的问题,引入RoBERTa,其全词掩码的编码方式更符合中文语言习惯,使模型能在中文数据集上取得更好的抽取效果,RoBERTa的引入使模型抽取精度提高了2.42%。本研究中,主要针对渔业领域内的中文渔业标准语料,按照原始方法处理会导致语义缺失、专有名词难以识别的问题,引入RoBERTa作为编码器,通过动态掩码的方式丰富词向量信息,有助于提高模型抽取的整体性能,增强词向量特征表示。

3.3 引入注意力机制对抽取效果的影响

关系三元组的抽取错误主要为实体对匹配错误及关系预测错误,其原因是模型抽取实体时边界不明确,以及抽取基础实体的配对实体时对客观关系参考较少。针对实体边界不明确的问题,常用的方法是引入自注意力机制,减少背景噪声的干扰,针对特征加权,提高实体抽取的准确率。程名等[3]针对渔业标准文本存在语义稀释导致识别效果不佳的问题,引入注意力机制后使模型对渔业标准号的识别性能提高了2.5%,对渔业指标的识别性能提高了2.37%。王奥等[21]针对农业问句在语义匹配工作中存在忽略句间交互导致交互特征信息损失的问题,利用自注意力机制、多维注意力机制对特征信息进行聚合,挖掘丰富句子的关联信息,将问句分类的准确率提高了5.2%。本研究中,选用的BiRTE模型虽然将关系向量引入到了关系抽取任务中,并取得了不错的抽取效果,但忽略了实体间关系在实体对抽取中的意义,为提高实体配对准确率,将关系向量引入到实体抽取部分作为指导,在抽取配对实体时,使用自注意力机制让模型更注意与基础实体有客观关系的实体,进一步提高了关系三元组整体抽取的准确率。

4 结论

1)在BiRTE模型基础上引入RoBERTa编码器,解决了渔业健康养殖标准专有名词识别不准确的问题;引入的自注意力机制,解决了复杂关系抽取中实体对匹配错误、关系匹配错误的问题。

2)本研究中提出的RoBERTa-BiRTE-SelfATT模型的准确率、召回率和F1值分别达到了95.9%、95.4%和95.7%。这表明,该模型有效提升了渔业标准中复杂关系抽取的准确率及鲁棒性。

本研究中提出的RoBERTa-BiRTE-SelfATT渔业健康养殖标准复杂关系抽取方法,通过串联编码器及融合自注意力机制两种方法提高准确率的同时也略微增加了处理时间,对渔业标准中更为复杂的时序问题、主宾省略问题也未做出有效解决,后续将从减少运行时间、扩展渔业健康养殖标准知识图谱等方面优化模型,以进一步增强渔业标准知识在智慧渔业中的应用。

[1] 方建光,李钟杰,蒋增杰,等.水产生态养殖与新养殖模式发展战略研究[J].中国工程科学,2016,18(3):22-28.

FANG J G,LI Z J,JIANG Z J,et al.Development strategy for ecological aquaculture and new mode of aquacultural farming[J].Engineering Sciences,2016,18(3):22-28.(in Chinese)

[2] CHAN Y S,ROTH D.Exploiting syntactico-semantic structures for relation extraction[C]//Proceedings of the 49th annual meeting of the Association for Computational Linguistics.Portland, Oregon, USA:Association for Computational Linguistics,2011:551-560.

[3] 程名,于红,冯艳红,等.融合注意力机制和BiLSTM+CRF的渔业标准命名实体识别[J].大连海洋大学学报,2020,35(2):296-301.

CHENG M,YU H,FENG Y H,et al.Fishery standard named entity recognition with integrated attention mechanism and BiLSTM+CRF[J].Journal of Dalian Ocean University,2020,35(2):296-301.(in Chinese)

[4] 杨鹤,于红,刘巨升,等.基于BERT+BiLSTM+CRF深度学习模型和多元组合数据增广的渔业标准命名实体识别[J].大连海洋大学学报,2021,36(4):661-669.

YANG H,YU H,LIU J S,et al.Fishery standard named entity recognition based on BERT+BiLSTM+CRF deep learning model and multivariate combination data augmentation[J].Journal of Dalian Ocean University,2021,36(4):661-669.(in Chinese)

[5] 杨鹤,于红,孙哲涛,等.基于双重注意力机制的渔业标准实体关系抽取[J].农业工程学报,2021,37(14):204-212.

YANG H,YU H,SUN Z T,et al.Fishery standard entity relation extraction using dual attention mechanism[J].Transactions of the Chinese Society of Agricultural Engineering,2021,37(14):204-212.(in Chinese)

[6] FU T J,LI P H,MA W Y.GraphRel:modeling text as relational graphs for joint entity and relation extraction[C]//Proceedings of the 57th annual meeting of the Association for Computational Linguistics.Florence,Italy:Association for Computational Linguistics,2019:1409-1418.

[7] NAYAK T,NG H T.Effective modeling of encoder-decoder architecture for joint entity and relation extraction[J].Proceedings of the AAAI Conference on Artificial Intelligence,2020,34(5):8528-8535.

[8] YU B W,ZHANG Z Y,SU J L,et al.Joint extraction of entities and relations based on a novel decomposition strategy[EB/OL].2019.arXiv.1909.04273.https://arxiv.org/abs/1909.04273.

[9] WEI Z P,SU J L,WANG Y,et al.A novel cascade binary tagging framework for relational triple extraction[C]//Proceedings of the 58th annual meeting of the Association for Computational Linguistics.Stroudsburg,PA,USA:Association for Computational Linguistics,2020:1476-1488.

[10] WANG Y C,YU B W,ZHANG Y Y,et al.TPLinker:single-stage joint extraction of entities and relations through token pair linking[C]//Proceedings of the 28th International Conference on Computational Linguistics.Barcelona,Spain:International Committee on Computational Linguistics,2020:1572-1582.

[11] SU J L,MURTADHA A,PAN S F,et al.Global pointer:novel efficient span-based approach for named entity recognition[EB/OL].2022.arXiv:2208.03054.https://arxiv.dosf.top/abs/2208.03054.

[12] ZHENG H,WEN R,CHEN X,et al.PRGC:potential relation and global correspondence based joint relational triple extraction[EB/OL].2021.arXiv:2106.09895.https://arxiv.dosf.top/abs/2106.09895.

[13] SHANG Y M,HUANG H Y,MAO X L.OneRel:joint entity and relation extraction with one module in one step[J].Proceedings of the AAAI Conference on Artificial Intelligence,2022,36(10):11285-11293.

[14] REN F L,ZHANG L H,ZHAO X F,et al.A simple but effective bidirectional framework for relational triple extraction[C]//Proceedings of the fifteenth ACM International Conference on Web Search and Data Mining.Virtual Event,AZ,USA:ACM,2022:824-832.

[15] 刘巨升,于红,杨惠宁,等.基于多核卷积神经网络(BERT+Multi-CNN+CRF)的水产医学嵌套命名实体识别[J].大连海洋大学学报,2022,37(3):524-530.

LIU J S,YU H,YANG H N,et al.Recognition of nested named entities in aquaculture medicine based on multi-kernel convolution (BERT+Multi-CNN+CRF)[J].Journal of Dalian Ocean University,2022,37(3):524-530.(in Chinese)

[16] LIU Y H,OTT M,GOYAL N,et al.RoBERTa:a robustly optimized BERT pretraining approach[EB/OL].2019.arXiv:1907.11692.https://arxiv.dosf.top/abs/1907.11692.

[17] CUI Y M,CHE W X,LIU T,et al.Pre-training with whole word masking for Chinese BERT[J].IEEE/ACM Transactions on Audio,Speech and Language Processing,2021,29:3504-3514.

[18] 周俊,郑彭元,袁立存,等.基于改进CASREL的水稻施肥知识图谱信息抽取研究[J].农业机械学报,2022,53(11):314-322.

ZHOU J,ZHENG P Y,YUAN L C,et al.Knowledge graph information extraction for rice fertilization based on improved CASREL[J].Transactions of the Chinese Society for Agricultural Machinery,2022,53(11):314-322.(in Chinese)

[19] 王桂江,黄润才,黄勃.基于K-BERT和残差循环单元的中文情感分析[J].数据与计算发展前沿,2023,5(4):127-138.

WANG G J,HUANG R C,HUANG B.Chinese sentiment analysis based on K-BERT and residual recurrent units[J].Frontiers of Data &Computing,2023,5(4):127-138.(in Chinese)

[20] 喻金平,朱伟锋,廖列法.基于RoBERTa-wwm-BiLSTM-CRF的扶持政策文本实体识别研究[J].计算机工程与科学,2023,45(8):1498-1507.

YU J P,ZHU W F,LIAO L F.Entity recognition of support policy text based on RoBERTa-wwm-BiLSTM-CRF[J].Computer Engineering &Science,2023,45(8):1498-1507.(in Chinese)

[21] 王奥,吴华瑞,朱华吉.基于特征增强的多方位农业问句语义匹配[J].西南大学学报(自然科学版),2023,45(6):201-210.

WANG A,WU H R,ZHU H J.Multi-level semantic matching of agricultural questions based on feature enhancement[J].Journal of Southwest University (Natural Science Edition),2023,45(6):201-210.(in Chinese)