目前,在全球商业渔船上安装了大约1 000种电子监控(electronic monitoring,EM)系统[1]。EM系统将会记录完整的捕鱼活动,产生大量的视频数据,可允许研究人员在不登船的情况下观察渔获情况。实现EM系统中鱼类的高精度检测与识别,不仅能够显著提高捕捞效率、节约人类观察员成本[2],而且在改善渔业科学管理、提高渔业监管透明度和市场问责制等方面发挥着重要作用。因此,快速准确地完成EM系统中鱼类的检测与识别具有重要意义。

对于EM系统中鱼类的检测与识别,传统方式是通过人工处理分析EM系统中的视频数据[3],而人工成本相对较高,需要更多的人力资源,阻碍了EM系统的普及[4]。近年来,随着人工智能、计算机视觉等领域技术的不断发展,部分专家学者开始将基于卷积神经网络(convolutional neural network,CNN)应用于解决海洋科学和海洋资源管理中的复杂问题[5]。目前,已有多位研究学者提出了基于CNN的商业渔船EM视频数据中鱼类的检测与识别,French等[6]使用Mask R-CNN对EM系统视频中的鱼类进行检测与识别,平均精度仅为63%,而人类观察员的平均精度为74%~86%,前者无法完成物种的细粒度分类,且出现多次错误分类结果。Mujtaba等[7]使用RegNetX-16GF为基础结构训练了TunaConvNet-4和TunaConvNet-2两个模型,其中,TunaConvNet-4模型可识别4种相似的金枪鱼,TunaConvNet-2模型可识别大眼金枪鱼、黄鳍金枪鱼,在对数据集进行数据增强,包括添加图像噪声、更改亮度等操作之后,在两个不同的数据集上分类准确率均高达90%,但是,对于图像中鱼类的定位需要通过手工标注,往往需要高昂的人工成本和较大的工作量。Van Essen等[8]模拟真实海上渔船EM系统采集的数据集,以Yolov3为基准网络模型,实现了EM视频中鱼类的检测与识别,在不同遮挡情况下可以达到80%的平均检测精度,但网络的泛化能力较弱,未能验证在真实场景下的检测与识别精度是否可以保持。Kay等[9]在真实的渔船工作环境下,以RetinaNet-ResNet101-FPN为基准网络模型,实现了EM视频中鱼类的检测与识别,将数据集的标签种类分为L1、L2、tuna/not-tuna和fish,在不同标签下的mAP@0.5分别达到25.4%、33.8%、44.5%和53.0%,但是模型检测与识别精度还有待进一步提高。

目前,基于卷积神经网络的商业渔船EM系统中鱼类的检测与识别方法存在两方面的问题:一是,在真实场景下检测与识别精度低,鱼类的细粒度分类较困难;二是,检测与识别精度高的模型,成本较高,并消耗更多的计算资源。对于在真实场景下,如何以更低成本高效完成商业渔船EM系统中鱼类检测与识别的研究较少。本研究中,对Yolov8n模型进行改进,在主干网中使用GCBlock以提高模型的特征提取能力,对模型的Neck端和目标框回归损失函数进行优化,并使用了FishNet公开数据集,以期完成真实场景下商业渔船EM系统中鱼类的检测与识别、鱼类的细粒度分类,并满足检测速度快、精度高和计算成本低的需求。

1 FishNet数据集和数据预处理

1.1 FishNet数据集

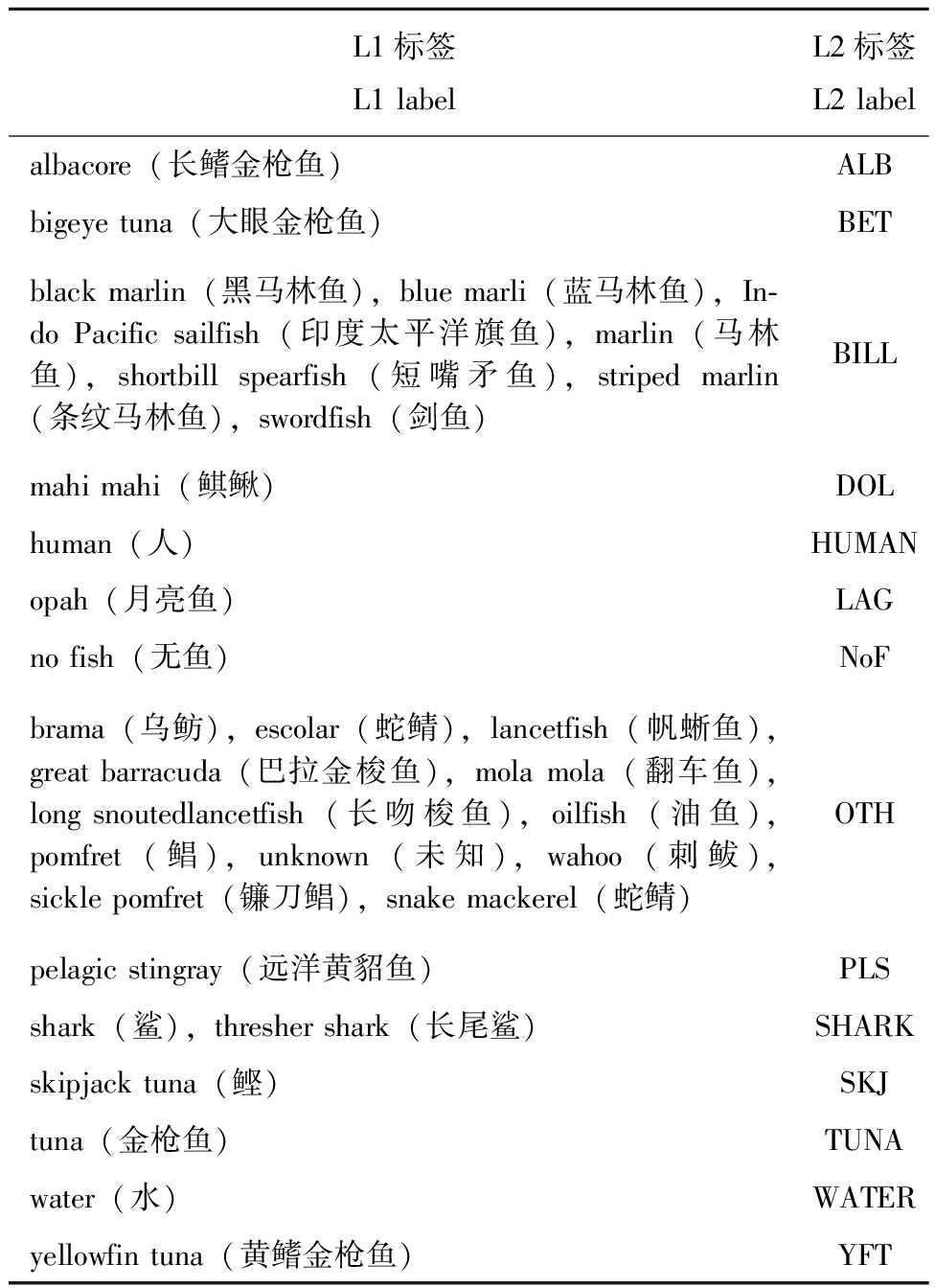

FishNet[9]是一个用于商业渔船EM系统中鱼类检测和精细视觉分类的数据集,由西太平洋和中太平洋延绳钓金枪鱼渔船上EM系统视频以每秒一帧采集的图像组成,标签标注信息由Sama数据注释公司提供,并由领域专家手动检查修改。其中,4种视觉上相似的金枪鱼物种[albacore(长鳍金枪鱼)、yellowfin tuna(黄鳍金枪鱼)、skipjack tuna(鲣)和bigeye tuna(大眼金枪鱼)]占绝大多数(超过85%),包含鱼的注释,其余的鱼类注释分为25个物种,这29个细粒度的类组成了L1标签集。部分L1标签鱼类图像如图1所示(随机选择并使用标注框裁剪)。此外,联合国粮农组织ASFIS渔业统计物种列表根据物理形态将物种分为12个较粗的类别,如比目鱼(bilfish)、马林鱼(marlin)和旗鱼(saifish)等,该列表中的部分类别组成了L2标签集,L1、L2标签集具体类别和关系如表1所示。

表1 L1、L2标签中类别的对应关系

Tab.1 Correspondence of categories in L1 and L2 Labels

L1标签L1 labelL2标签L2 labelalbacore(长鳍金枪鱼)ALBbigeye tuna(大眼金枪鱼)BETblack marlin(黑马林鱼),blue marli(蓝马林鱼),In-do Pacific sailfish(印度太平洋旗鱼),marlin(马林鱼),shortbill spearfish(短嘴矛鱼),striped marlin(条纹马林鱼),swordfish(剑鱼)BILLmahi mahi(鲯鳅)DOLhuman(人)HUMANopah(月亮鱼)LAGno fish(无鱼)NoFbrama(乌鲂),escolar(蛇鲭),lancetfish(帆蜥鱼),great barracuda(巴拉金梭鱼),mola mola(翻车鱼),long snoutedlancetfish(长吻梭鱼),oilfish(油鱼),pomfret(鲳),unknown(未知),wahoo(刺鲅),sickle pomfret(镰刀鲳),snake mackerel(蛇鲭)OTHpelagic stingray(远洋黄貂鱼)PLSshark(鲨),thresher shark(长尾鲨)SHARKskipjack tuna(鲣)SKJtuna(金枪鱼)TUNAwater(水)WATERyellowfin tuna(黄鳍金枪鱼)YFT

图1 L1标签鱼类图像示例

Fig.1 Example of L1 labeled fish images

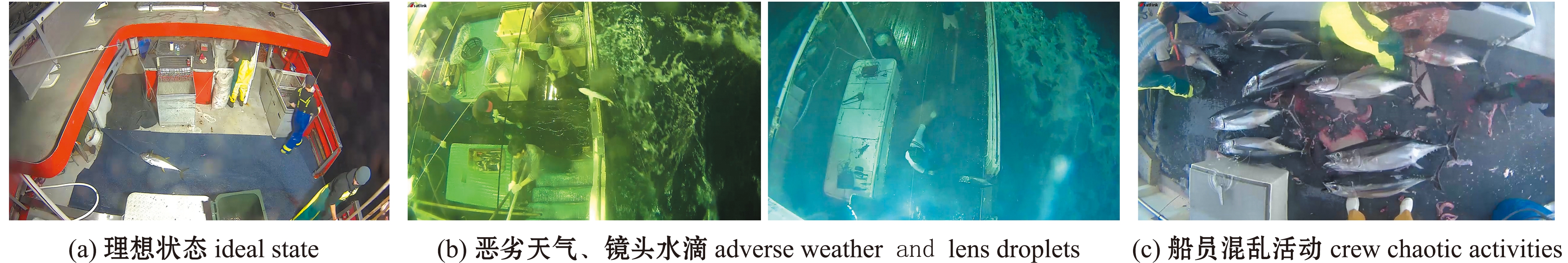

在商业渔船捕鱼作业过程中,数据集中图像状态可分为理想状态(良好的照明、高可见度和无遮挡)及挑战性状态(夜间作业、恶劣天气、镜头上的水滴和船员混乱活动造成的鱼遮挡),图像状态对比如图2所示。某些捕获鱼类在非理想状态下很难在物种级别进行分类,所以在L1和L2标签集两者都包含许多模糊标签(如L1集中的marlin、tuna和unknown,以及L2集中的TUNA和OTH)。由于本研究主要是针对鱼类进行高精度检测和识别,在计算最终的平均精度均值时,不考虑标签中的非鱼类标签(如L1中的human、no fish等和L2中的HUMAN、NoF等)及模糊标签的检测精度。

图2 不同场景下图像状态对比

Fig.2 Image state comparison in different scenarios

1.2 数据预处理

由于FishNet数据集中挑战性状态除了船员混乱活动造成的鱼遮挡问题,其余问题均为外界环境因素造成的图像不清晰。为去除环境因素的影响,采用色彩增益加权的AutoMSRCR(auto multi-scale retinex with color restoration)模型对图像进行增强,增强结果对比如图3所示。

图3 环境因素影响下的图像与增强后图像对比

Fig.3 Images under the influence of environmental factors compared to enhanced images

2 Yolov8n网络模型及其改进方法

2.1 Yolov8n网络模型

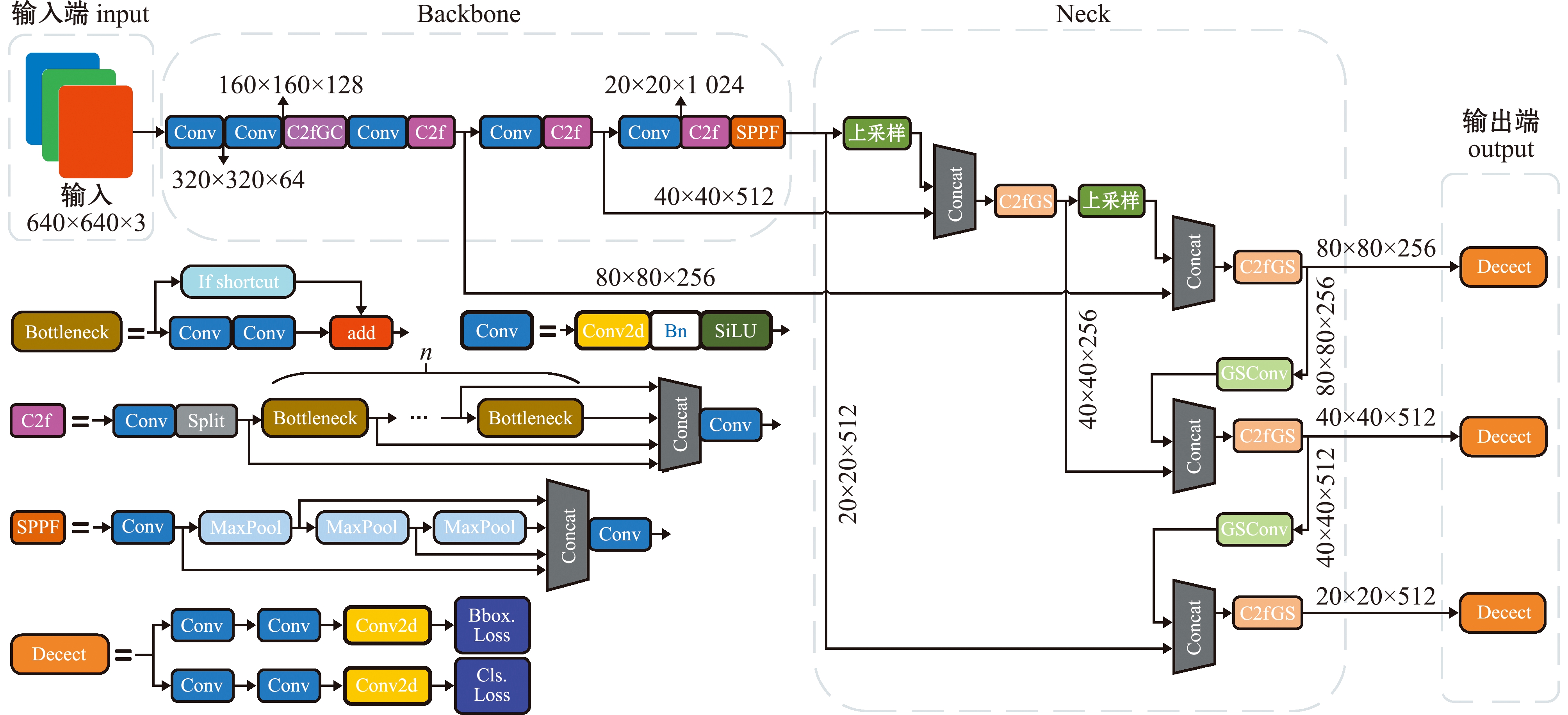

Yolov8n的网络分为输入端、主干网(Backbone)、Neck 模块和输出端4个部分(图4)。输入端主要有马赛克(Mosaic)数据增强、自适应锚框计算和自适应灰度填充。主干网有Conv、C2f和SPPF结构,其中,C2f模块是对残差特征进行学习的主要模块,该模块仿照Yolov7 的ELAN 结构,通过更多的分支跨层连接,丰富了模型的梯度流,可形成一个具有更强特征表示能力的神经网络模块。Neck模块采用PAN(path aggregation network)结构,可加强网络对不同缩放尺度对象特征融合的能力。输出端将分类和检测过程进行解耦,主要包括损失计算和目标检测框筛选,其中,损失计算过程主要包括正负样本分配策略和 Loss 计算,Yolov8n网络主要使用TaskAlignedAssigner[10]方法,即根据分类与回归的分数加权结果选择正样本;Loss计算包括分类和回归2个分支,无Objectness 分支。分类分支依然采用 BCE Loss,回归分支则使用了Distribution Focal Loss[11]和CIOU(complete intersection over union)损失函数。

图4 改进后的Yolov8n网络模型

Fig.4 Improved Yolov8n model

2.2 特征提取主干网的改进

在渔船行进过程中或者遇到风浪天气时,渔船上的电子监控摄像设备经常会粘上水滴,这将会导致拍摄图片中出现模糊区域,渔船的捕鱼作业通常在夜间执行,光线不足导致图像中鱼类目标难以分辨,同时,渔船工作人员的活动和恶劣的天气等均会导致图像不清晰、背景杂乱。这些场景下,卷积神经网络在提取图像特征时将会产生大量噪声,割裂像素间的远程依赖关系,最终导致检测与识别准确率降低。

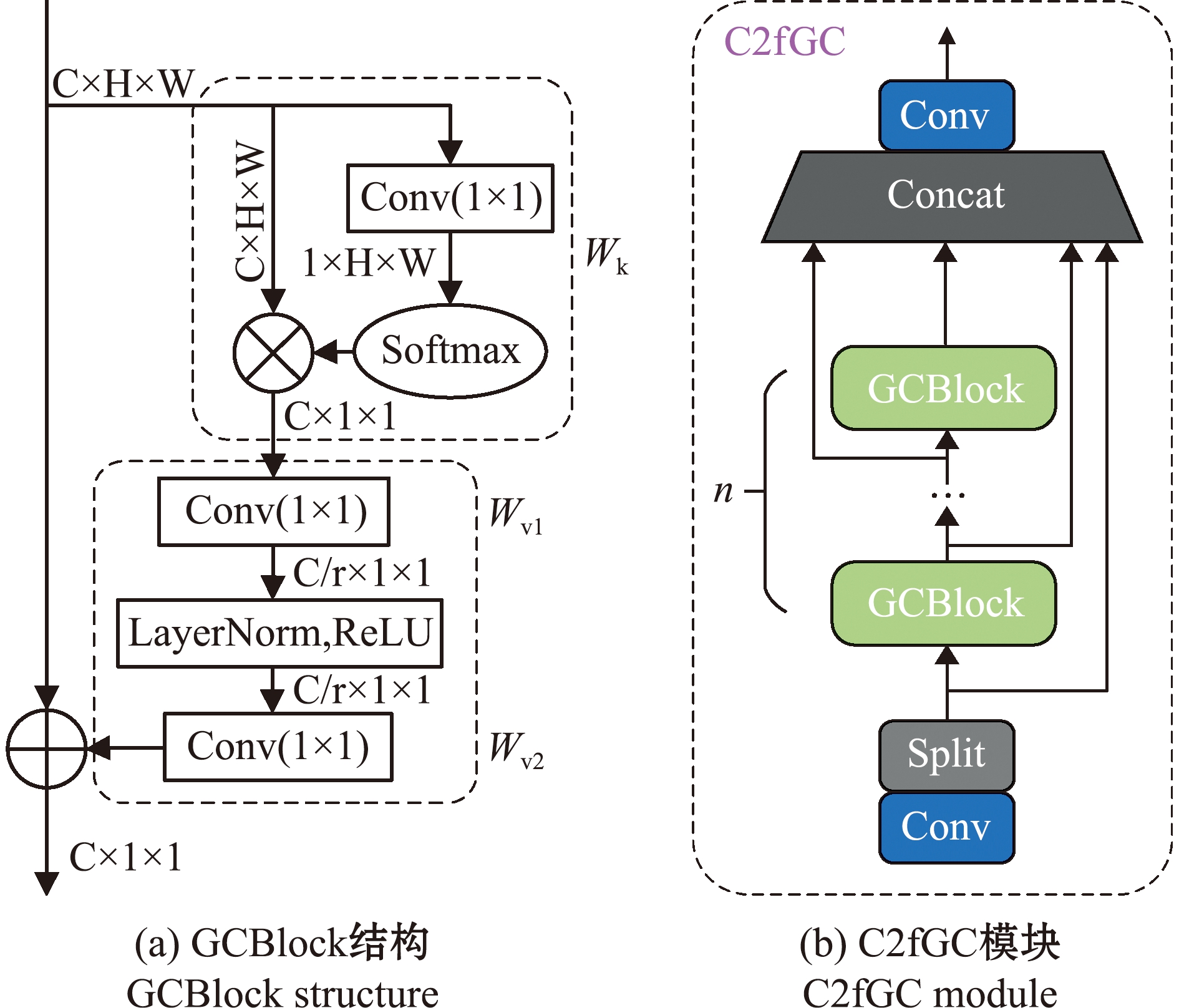

捕获远程依赖,被证明有利于计算机视觉任务,可以提高目标检测与识别效果。NLNet网络[12]是通过自注意力机制建立模像素对关系,然而NLNet对于每一个位置学习不受位置依赖的Attention Map,造成了大量的计算资源浪费[13]。SENet网络[14]用全局上下文对不同通道进行权值重标定,以调整通道依赖。然而,采用权值重标定的特征融合,不能充分利用全局上下文[15]。GCNet[16]网络既能够像NLNet网络一样有效地对全局上下文建模,又能够像SENet网络一样轻量。GCNet网络中的GCBlock模块结构如图5(a)所示,该模块主要分为3个部分:首先,全局上下文建模采用1×1卷积Wk和Softmax函数来获取Attention权值,执行Attention pooling以获得全局上下文特征;其次,捕获通道间依赖采用两层1×1卷积Wv1和Wv2降低计算量,并在ReLU前增加LayNorm结构以降低优化难度,提高泛化性;最后,特征融合步骤中使用Broadcast Element-wise Addition方法来聚合全局上下文特征到每个位置的特征上。GCNet网络充分结合了NLNet网络全局上下文建模能力强和SENet节省计算量的优点。因此,本研究中提出在Yolov8n主干网中使用GCBlock模块对原C2f结构进行改进,形成新的C2fGC结构,可以使模型完成对远程依赖关系建模(图5(b))。第一个C2f模块的特征图和将此模块替换为C2fGC模块后的特征图对比如图6所示,可以明显看出,C2fGC模块的特征图比原C2f模块的特征图更加清晰。

图5 GCBlock结构和C2fGC模块

Fig.5 GCBlock structure and C2fGC module

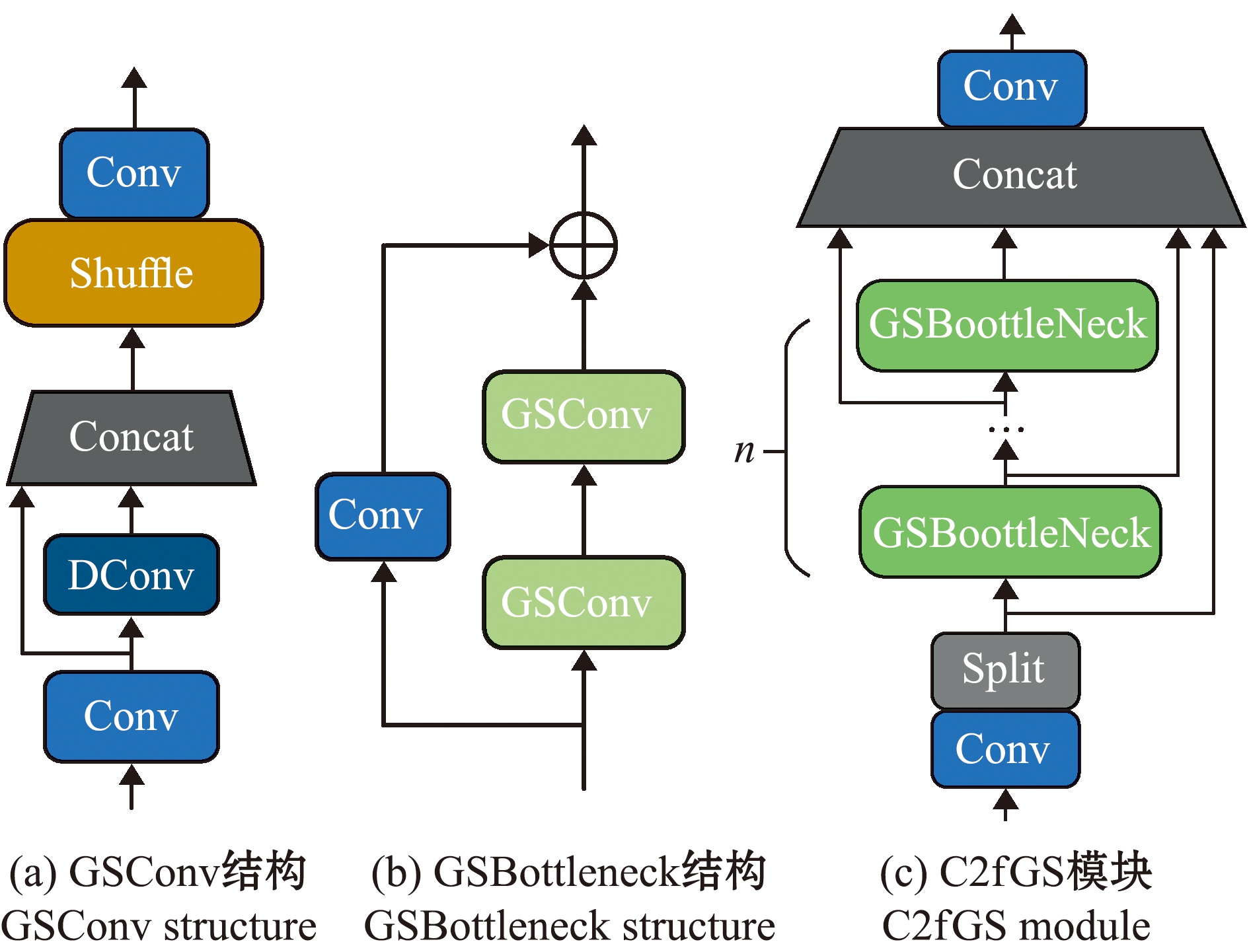

图6 GSConv、GSBottleneck结构及C2fGS模块

Fig.6 GSConv structure,GSBottleneck structure and C2fGS module

2.3 特征融合Neck端的改进

在商业渔船出海工作期间,EM系统将会产生大量的视频数据,如果使用原Yolov8n模型进行鱼类目标检测和识别,将会使用较高的计算资源成本,且检测速度也有待进一步提高。为了提高模型的检测速度,一些有效的轻量级网络模型,如Xception[17]、MobileNet[18]、ShuffleNet[19]和GhostNet[20]等可通过深度可分离卷积(depth-wise separable convolution,DConv)提高模型检测速度,但该类模型在FishNet数据集上的准确性较低,主要是由于深度可分离卷积输入特征图的通道信息在计算过程中是分离的,舍弃了通道之间的信息交互。本研究中使用GSConv[21]新型卷积方式(图6(a)),该卷积方式的主要思想是使用均匀混合(Shuffle)操作,将标准卷积生成的信息渗透到深度可分离卷积生成的信息中,使用较低的时间损耗尽可能保留通道之间的信息交互。

本研究在GSConv的基础上进一步设计了GSBottleneck和C2fGS结构,如图6(b)、(c)所示,在Neck端使用GSConv代替普通卷积操作,用C2fGS模块代替原来的C2f模块,在减少模型计算复杂度和推理时间的同时保持其准确性。

2.4 IOU损失函数的改进

在Yolov8n模型中使用CIOU[22]作为检测框回归损失函数,考虑了边界框回归中预测框和真实框的重叠面积、中心点距离和纵横比,即

{(W=kWgt,H=kHgt)|k∈R+}。

(1)

式中:W和H分别为预测框的宽和高;Wgt和Hgt分别为真实框的宽和高。式(1)中纵横比仅反映了预测框与真实框宽或高的比值关系,当不同预测框和真实框间的纵横比相同时,此时CIOU的计算结果是相同的。

针对这个问题,本研究中使用了SIOU[23]作为检测框回归损失函数。SIOU考虑到所需回归之间的向量角度,重新定义了惩罚指标,SIOU损失(USIO)包括距离损失Δ、形状损失Ω和IOU损失(UIO)3个部分,其计算公式为

USIO=UIO-(Δ+Ω)/2。

(2)

3 结果与分析

本研究试验环境如下:Linux Ubuntu 16.04.4 LTS的操作系统,AMD Ryzen 9 5950X16 CPU,24 GB显存的NVIDIA GeForce RTX 3090 GPU。使用Yolov8n为基准网络模型,超参数设置批大小(batch size)为16,训练周期(epochs)为300,初始学习率(learning rate)为0.01。

3.1 评价指标

采用计算量衡量网络模型的执行时间,使用每秒10亿次的浮点运算数(giga floating-point operations per second,GFLOPS)为单位,计算量越大意味着需要占用更多的计算资源;采用平均精度均值(mean average precision,mAP),评价模型的准确性,即对所有类别的平均精度(average precision,AP)值求平均值,其计算公式为

PmA=∑PA/N。

(3)

式中:PmA为mAP;N为类别总数;PA为以召回率为横轴、精确度为纵轴组成的曲线围成的面积。mAP@0.5为IOU阈值为0.5时的平均精度均值。

3.2 改进方法效果对比

为探究本研究中提出的改进方法的效果,对Yolov8n模型进行了网络结构改进和参数的优化调整,以FishNet数据集作为训练、验证数据集,通过试验结果对比各种改进方法的效果。

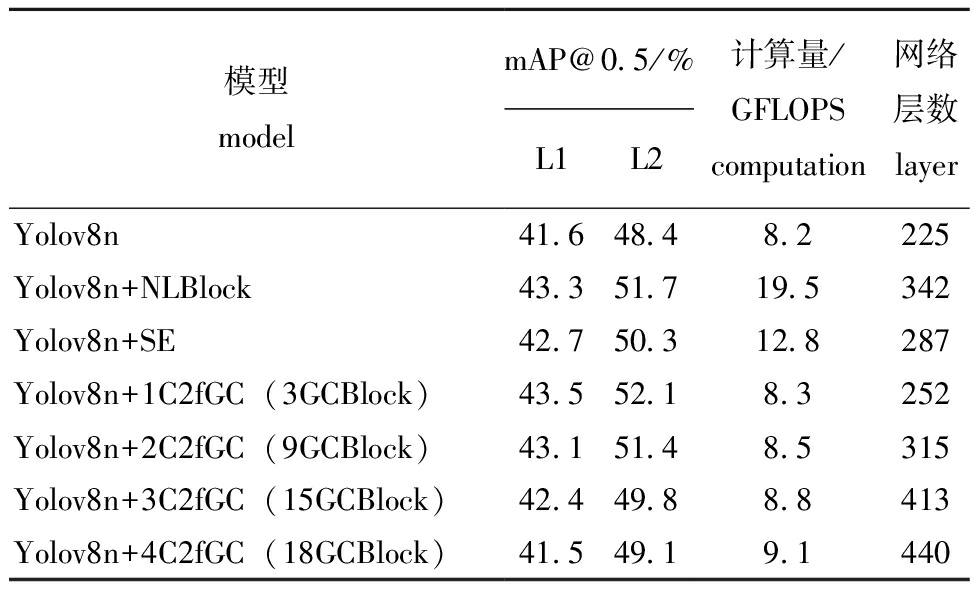

3.2.1 主干网改进试验 由于Yolov8n模型的主干网中共有4个C2f模块,将每个C2f模块替换为C2fGC模块后,4个C2fGC模块中分别有3、6、6、3个GCBlock结构。同时,使用NLNet中的NLBlock和SENet中的SE注意力机制对主干网进行修改。试验结果表明,NLNet和SENet可提高模型的准确性,但计算量分别提高了11.3 GFLOPS和4.6 GFLOPS,是原模型的2.4倍和1.6倍,而使用C2fGC模块在计算量小幅增加的同时,检测准确性mAP@0.5最高提高了4.7%(表2)。由于在主干网中,过多地使用C2fGC模块会导致网络层数增加,加剧对数据流的阻力,因此,本研究中仅将主干网中第一个C2f模块替换为C2fGC模块。

表2 主干网改进后的模型性能对比

Tab.2 Comparison of model performance after Backbone improvement

模型 model mAP@0.5/%L1L2计算量/GFLOPS computation网络层数 layerYolov8n41.648.48.2225Yolov8n+NLBlock43.351.719.5342Yolov8n+SE42.750.312.8287Yolov8n+1C2fGC(3GCBlock)43.552.18.3252Yolov8n+2C2fGC(9GCBlock)43.151.48.5315Yolov8n+3C2fGC(15GCBlock)42.449.88.8413Yolov8n+4C2fGC(18GCBlock)41.549.19.1440

3.2.2 Neck端改进试验 在Neck端使用不同的轻量化结构对Yolov8n模型进行改进,即在Neck端使用不同的卷积方式和以此卷积方式构造的C2f模块,展示不同方法对于模型准确性和计算量的影响结果。

试验结果表明,DConv、ShuffleNet和GhostConvu卷积方法均可降低模型计算量。由于DConv方法在卷积过程中无通道信息交互,而ShuffleNet中提出的分组卷积通道重排和GhostConv压缩通道信息的方法,虽然对深度可分离卷积的缺陷有所改进,但改进后的模型检测精度均有所下降。本研究中使用的GSConv方法不仅可以降低模型约10%的计算量,且改进后模型的检测精度略有上升(表3)。

表3 Neck端改进后的模型性能对比

Tab.3 Comparison of model performance after Neck terminal improvement

模型 model mAP@0.5/%L1L2计算量/GFLOPS computationYolov8n41.648.48.2Yolov8n+DConv40.246.57.3Yolov8n+ShuffleNet39.846.17.4Yolov8n+GhostConv40.446.77.9Yolov8n+GSConv41.948.67.5

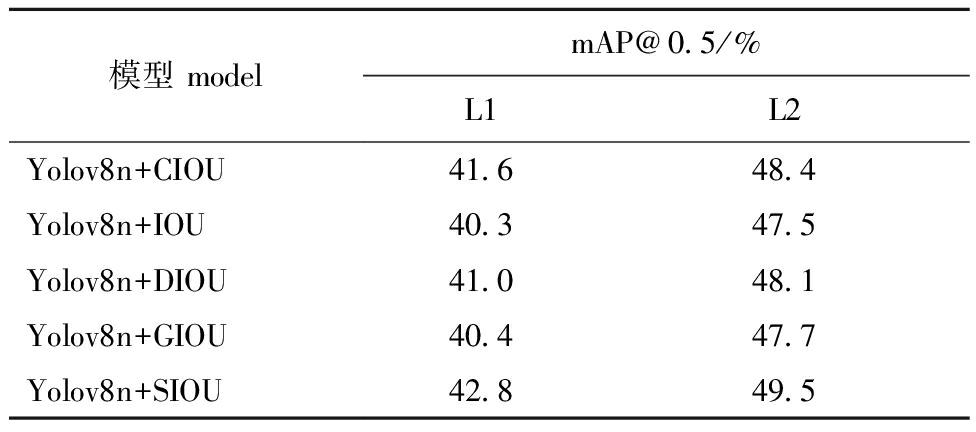

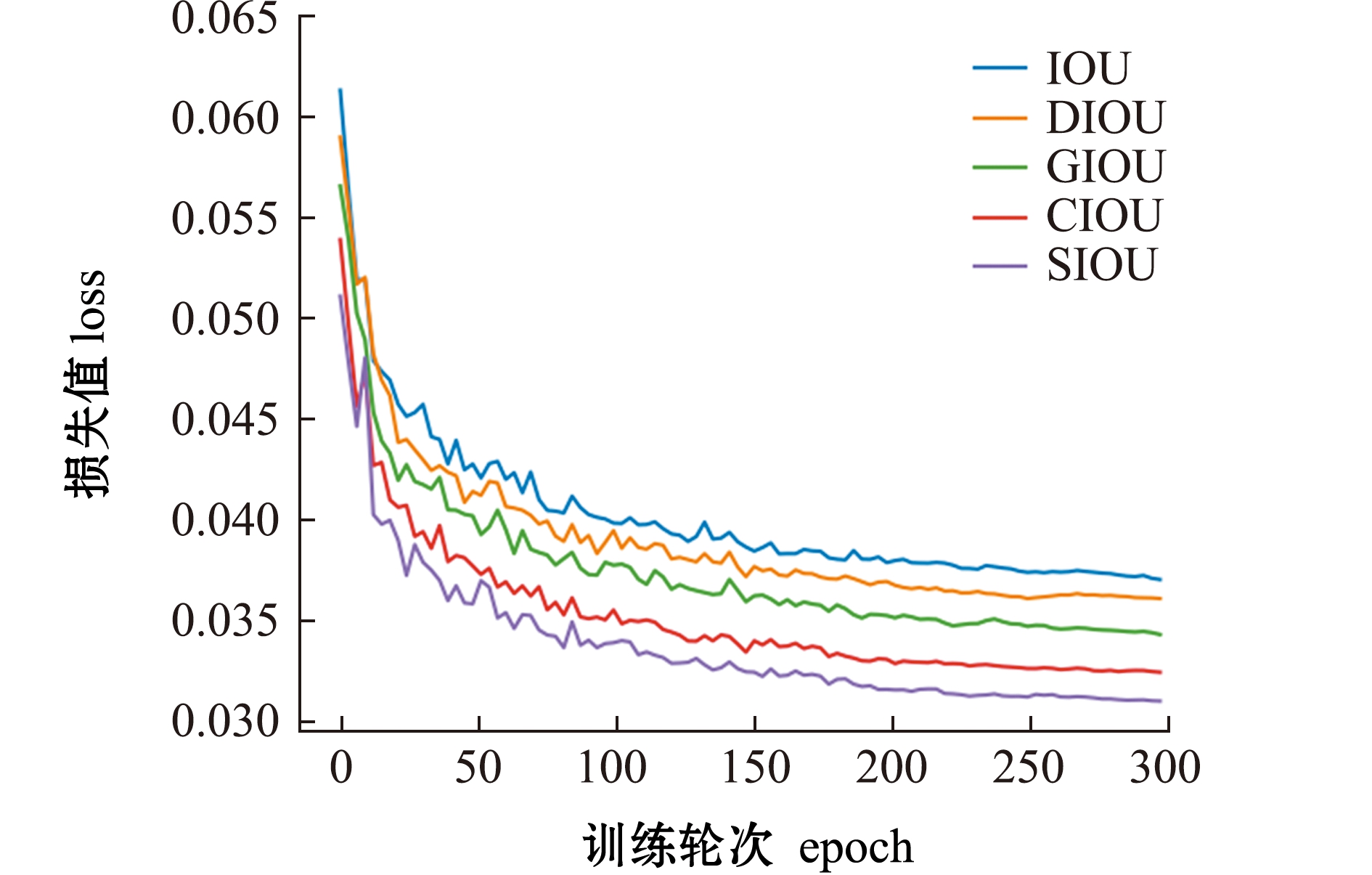

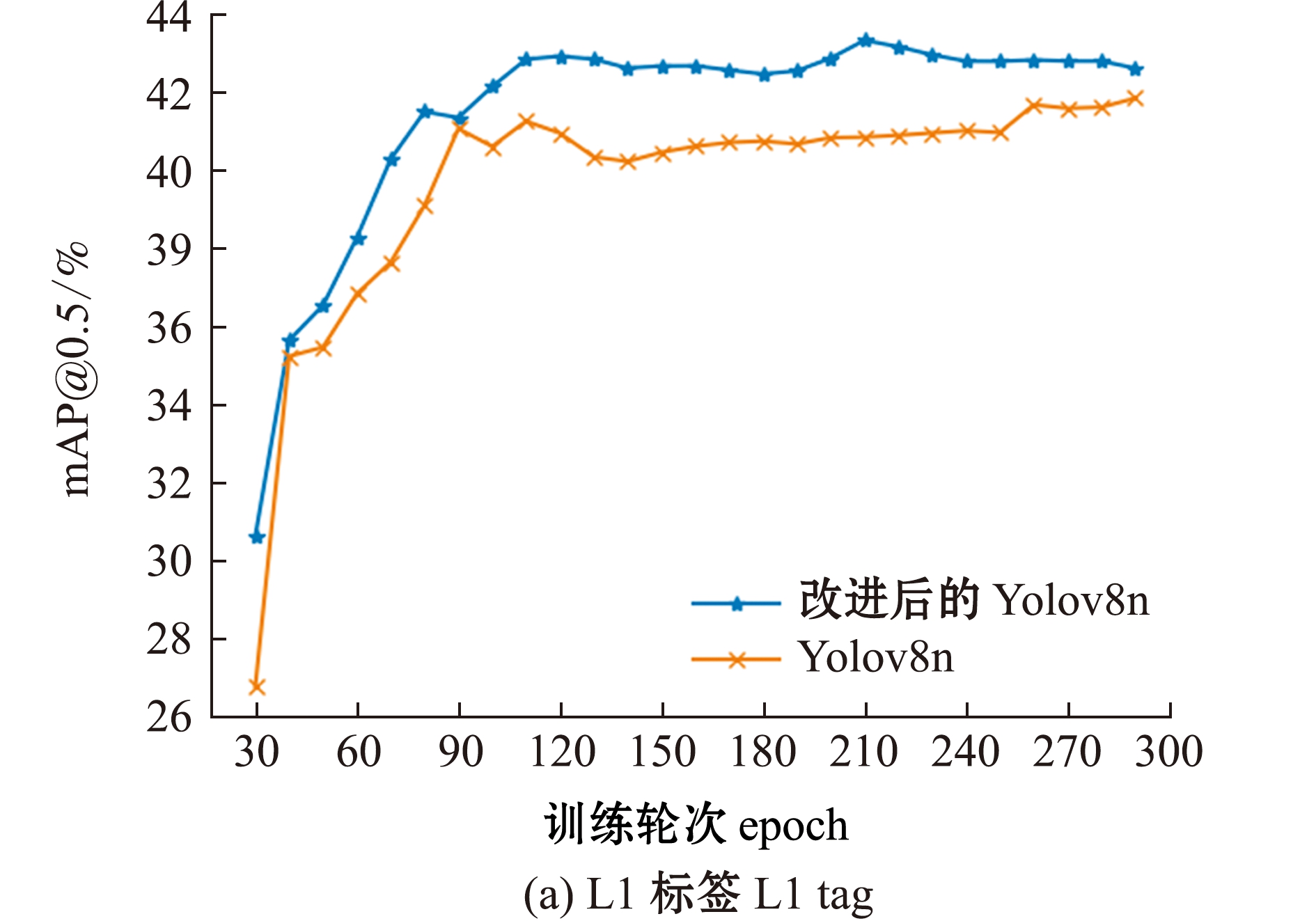

3.2.3 IOU损失函数的改进 对比常用损失函数IOU、DIOU[22]、GIOU[24]、CIOU和SIOU对模型精度的影响,结果表明,各模型均在250轮训练后收敛(图7),而SIOU损失函数有最低的边框回归误差,结合表4中的试验结果可知,使用SIOU损失函数的模型(Yolov8n+SIOU)具有更高的精度,可在原模型(Yolov8n+CIOU)基础上使mAP@0.5在L1和L2标签下分别提高1.2%和1.1%。

表4 使用不同IOU损失函数的模型性能对比

Tab.4 Comparison of model performance using different IOU loss function

模型 model mAP@0.5/%L1L2Yolov8n+CIOU41.648.4Yolov8n+IOU40.347.5Yolov8n+DIOU41.048.1Yolov8n+GIOU40.447.7Yolov8n+SIOU42.849.5

图7 不同IOU损失函数曲线

Fig.7 Loss function curves of different IOU

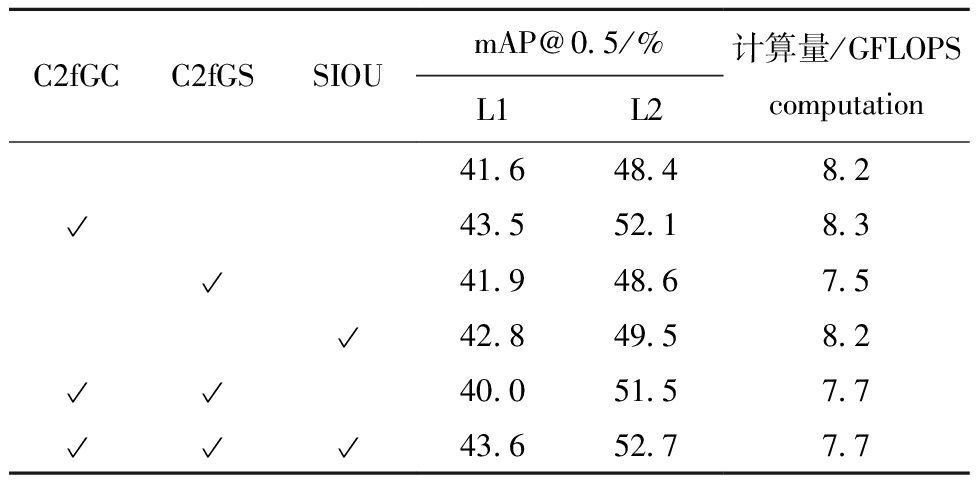

3.3 消融试验

从表5可见:在主干网使用C2fGC模块代替原有的C2f模块(仅替换第一个C2f模块),在L1、L2两种不同标签类型下,mAP@0.5分别提升了1.9%和3.7%;在特征融合Neck端使用C2fGS模块代替C2f模块,可以使计算量降低8.5%,显著减少计算资源的占用;当C2fGC和C2fGS模块配合使用时,可以做到降低计算量的同时提升mAP;使用SIOU损失函数,解决了CIOU在真实场景下的局限性,对于模型的检测效果有一定提升作用。

表5 消融试验结果

Tab.5 Ablation experiment results

C2fGCC2fGSSIOU mAP@0.5/%L1L2计算量/GFLOPScomputation41.648.48.243.552.18.341.948.67.542.849.58.240.051.57.743.652.77.7

综合试验结果,同时使用C2fGC模块、C2fGS模块和SIOU损失函数,经过300轮迭代训练,最终改进后的Yolov8n模型在准确率和计算量上均优于原Yolov8n模型,在L1、L2两种标签类别下,mAP@0.5分别提升了2.0%和4.3%,计算量减少了6.1%(图8,表5)。

图8 L1、L2标签下模型改进前后的mAP曲线对比

Fig.8 Comparison of mAP curves before and after algorithm improvement under L1 and L2 tags

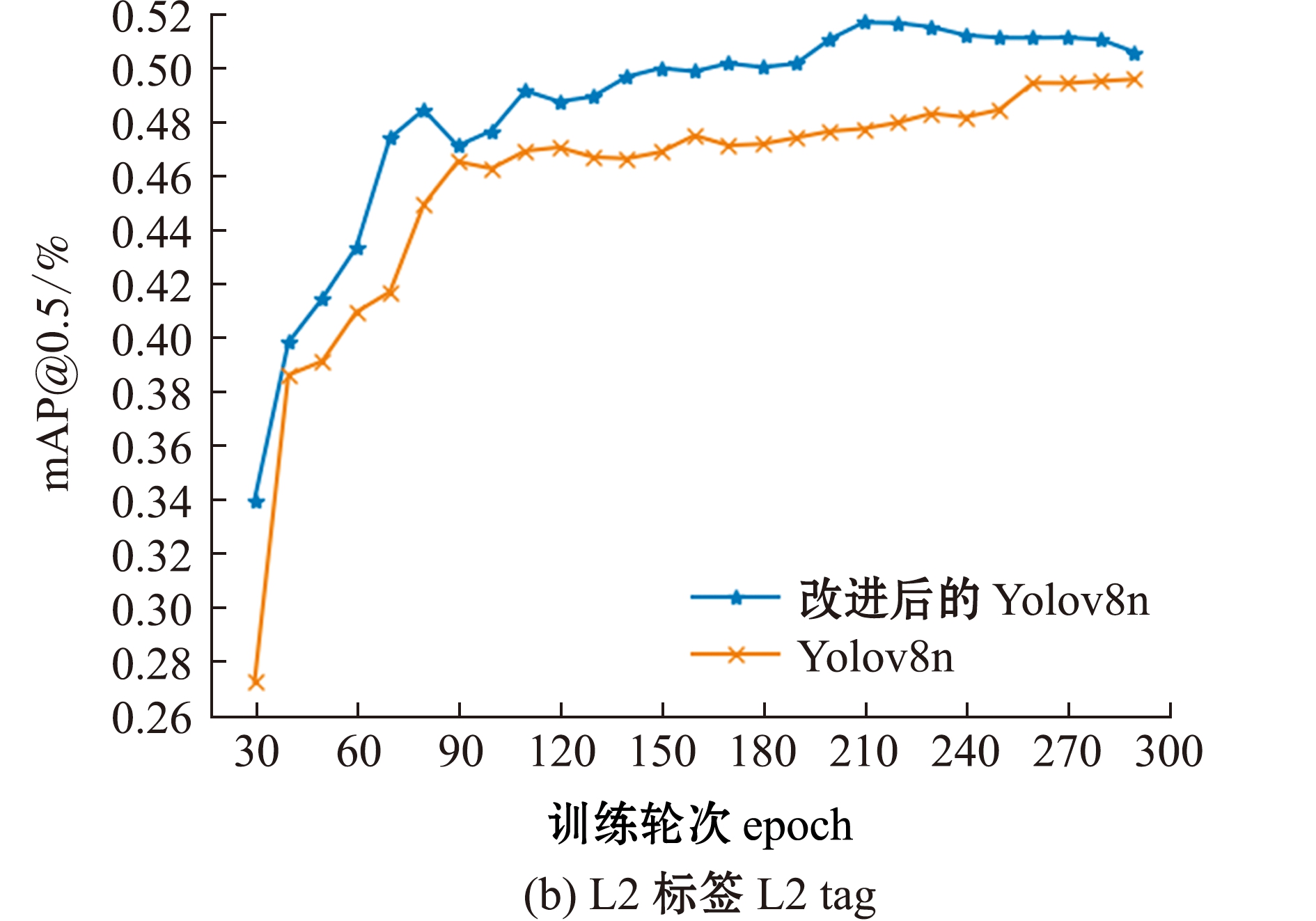

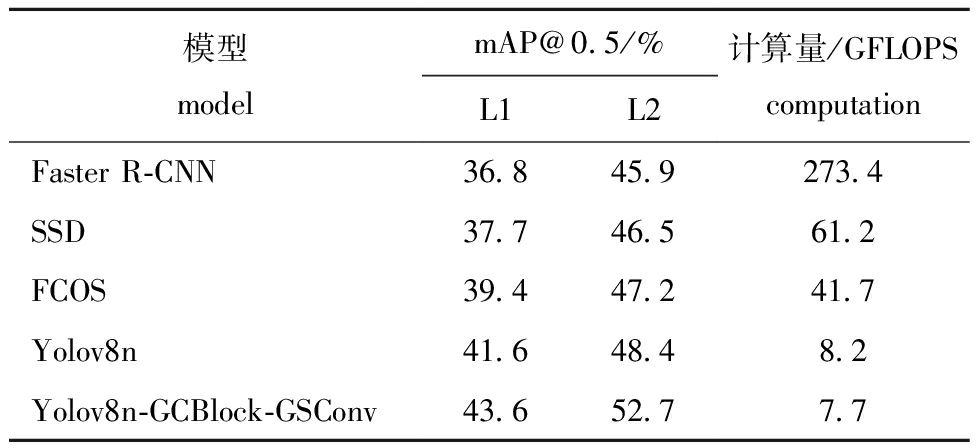

3.4 不同模型的检测与识别对比试验

将改进模型与其他主流目标检测模型包括两阶段有锚框检测模型Faster R-CNN[25]、一阶段有锚框检测模型SSD[26]和一阶段无锚框检测模型FCOS[27]等进行测试对比,采用相同的数据集、试验条件和图像增强方法,所有模型均未使用预训练模型,根据实际情况分为夜间作业、水滴遮挡摄像头和船员混乱活动3个试验。选择FishNet数据集中典型的3张图片进行检测识别,使用L1标签类别,将检测结果在未增强的原图上显示,最终结果如图9所示。

图9 不同场景下不同模型对比试验的可视化结果

Fig.9 Visual results of comparison experiment with different models in different scenarios

在试验1(夜间作业)中,Faster R-CNN模型有严重的误检和漏检现象,SSD、FCOS、Yolov8n和Yolov8n-GCBlock-GSConv模型基本无误检和漏检现象,但是前3种模型物体分类准确度较低;在试验2(水滴遮挡摄像头)中,Faster R-CNN和SSD模型检测结果完全错误,FCOS和Yolov8n模型均漏检了图像右下角的长鳍金枪鱼,Yolov8n-GCBlock-GSConv模型不仅检测到图像中的所有目标,且检测框比FCOS和Yolov8n模型更加准确;在试验3(船员混乱活动)中,前4个模型主要存在对物体的多次框定问题,Yolov8n-GCBlock-GSConv模型则可以准确地检测出所有物体。综合试验结果表明,本研究中提出的Yolov8n-GCBlock-GSConv模型具有更高的检测精度、更精确的检测框和更高的分类可信度。

从表6可见,在FishNet数据集下,本研究中提出的Yolov8n-GCBlock-GSConv模型在L1、L2两种不同的标签下,mAP@0.5分别达到了43.6%和52.7%检测精度,远高于其他4种目标检测模型,且计算量仅为7.7 GLOPS。

表6 不同模型的检测性能对比

Tab.6 Performance comparison of different models

模型model mAP@0.5/%L1L2计算量/GFLOPScomputationFaster R-CNN36.845.9273.4SSD37.746.561.2FCOS39.447.241.7Yolov8n41.648.48.2Yolov8n-GCBlock-GSConv43.652.77.7

4 讨论

4.1 远程依赖关系建模对模型性能的影响

为了提高模型的特征提取能力,充分利用像素的上下文信息,在模型中对远程依赖关系建模是相对有效的方法,可以在原模型中融合NonLocal、SE注意力和GCBlock模块等。Xue等[28]基于GCBlock模块构建了Yolo-Tea茶叶病虫害识别模型,在自然环境中如叶子阴影、照明和小尺寸问题下,该模型可以捕获像素的远程依赖关系,具有更高的特征提取能力,平均检测精度(mAP@0.5)较原模型提升了7.6%。Ye等[29]为了使高级特征充分利用其上下文信息,采用了GCBlock模块来捕获远程依赖关系,通过提高全局上下文建模和局部特征提取的能力,使低层小目标检测层能够获得更有效的特征信息。Wang等[30]使用GhostNet和GCBlock模块构建了基于Yolov4框架的轻量级高精度检测模型GG-Yolov4,用于从奶牛的热图像中自动检测奶牛的眼睛表面温度。模型中引入全局上下文网络(GCBlock)模块,可以获得完善有效的特征信息,弥补了轻量化模型因光照不足而造成的精度损失,提高了轻量化模型的检测精度。本研究中,在Yolov8n主干网中使用GCBlock模块,对远程依赖关系建模,提高了模型对于真实场景下的商业渔船EM系统中鱼类的检测识别精度。这与上述网络模型改进思想一致,在不大幅提升模型计算量和参数的同时,提升了模型的检测与识别精度。

4.2 网络模型轻量化对检测效果的影响

目前,对目标检测模型进行轻量化设计的主要方法均是从深度可分离卷积发展而来,而GSConv弥补了深度可分离卷积中舍弃了通道信息交互的缺点。梁秀满等[31]以Yolov4为基础提出的轻量级带钢缺陷实时检测模型SSD-Yolo,在Neck端采用 GSConv 卷积代替标准卷积,结果表明,该文提出的模型相较于 Yolov4,模型参数量减少 71.6%,浮点运算量降低 74.6%,检测精度提高 3.49%,在减少模型参数量和计算量的同时提升了模型的检测精度。Yu等[32]在Yolov5模型Neck层引入GSConv和Slim-Neck模块,提高了模型的精度和其他指标,实现了对机器人手臂和AGV小车等生产线设备的实时检测和定位。Yuan等[33]将Yolov5模型应用于PCB缺陷检测领域,并在Neck端采用了相应的GSConv实现网络模型的轻量化,与原Yolov5模型相比,改进后的模型参数只有原模型的64.5%,平均精度均值比原模型提高2.4%。Hu等[34]提出一种交通标志检测与识别模型PSG-Yolov5,引入GSConv后进一步降低了模型的计算复杂度,更好地满足了工业应用。与上述网络模型轻量化思路相同,本研究中在Neck端使用以GSConv为基础设计的C2fGS结构,并将Neck端使用的普通卷积方式替换为GSConv,试验结果表明,此方法不仅可以有效降低模型大小,降低模型约10%的计算量,而且改进后模型的检测精度略有上升。

5 结论

1)本研究中提出的一种改进Yolov8n的鱼类检测与识别模型Yolov8n-GCBlock-GSConv,该模型在FishNet数据集上,对于不同的标签L1、L2下mAP@0.5分别达到了43.6%、52.7%,模型最终的计算量为7.7 GFLOPS,可以更加快速准确地完成商业渔船电子监控数据中鱼类的检测与识别,且计算成本更低。

2)将Yolov8n原来主干网中的第一个C2f模块替换为以GCBlock为基础的C2fGC模块,提高了模型对远程依赖关系的建模能力,在Neck端使用GSConv和C2fGS代替原模型普通卷积的C2f模块,减少了模型计算量,使用SIOU代替CIOU损失函数计算边框损失,提高了检测精度。表明Yolov8n-GCBlock-GSConv模型在检测精度和计算量上均优于原Yolov8n模型,在L1、L2两种标签类别下mAP@0.5分别提升了2.0%和4.3%,计算量减少了6.1%,做到了模型轻量化和检测精度佳两者的兼顾。

3)本研究中提出的Yolov8n-GCBlock-GSConv模型在L1、L2两种不同的标签下的mAP相较于Faster R-CNN、SSD、FCOS和Yolov8n模型均有提高,模型计算量均有减少,适宜部署在算力资源不足的嵌入式设备上。

[1] MICHELIN M,ELLIOTT M,BUCHER M,et al.Catalyzing the growth of electronic monitoring in fisheries[J].California Environmental Associates and the Nature Conservancy,2018.

[2] 王书献,张胜茂,朱文斌,等.基于深度学习YOLOV5网络模型的金枪鱼延绳钓电子监控系统目标检测应用[J].大连海洋大学学报,2021,36(5):842-850.

WANG S X,ZHANG S M,ZHU W B,et al.Application of an electronic monitoring system for video target detection in tuna longline fishing based on YOLOV5 deep learning model[J].Journal of Dalian Fisheries University,2021,36(5):842-850.(in Chinese)

[3] HELMOND A T M,MORTENSEN L O,PLET-HANSEN K S,et al.Electronic monitoring in fisheries:lessons from global experiences and future opportunities[J].Fish and Fisheries,2020,21(1):162-189.

[4] NEEDLE C L,DINSDALE R,BUCH T B,et al.Scottish science applications of remote electronic monitoring[J].ICES Journal of Marine Science,2015,72(4):1214-1229.

[5] HUANG T W,HWANG J N,ROMAIN S,et al.Recognizing fish species captured live on wild sea surface in videos by deep metric learning with a temporal constraint[C]//2019 IEEE International Conference on Image Processing (ICIP).Taipei,China:IEEE,2019:3407-3411.

[6] FRENCH G,MACKIEWICZ M,FISHER M,et al.Deep neural networks for analysis of fisheries surveillance video and automated monitoring of fish discards[J].ICES Journal of Marine Science,2020,77(4):1340-1353.

[7] MUJTABA D F,MAHAPATRA N R.Convolutional neural networks for morphologically similar fish species identification[C]//2021 International Conference on Computational Science and Computational Intelligence (CSCI).Las Vegas,NV,USA:IEEE,2022:1553-1559.

[8] VAN ESSEN R,MENCARELLI A,VAN HELMOND A,et al.Automatic discard registration in cluttered environments using deep learning and object tracking:class imbalance,occlusion,and a comparison to human review[J].ICES Journal of Marine Science,2021,78(10):3834-3846.

[9] KAY J,MERRIFIELD M.The FishNet open images database:a dataset for fish detection and fine-grained categorization in fisheries[EB/OL].2021.arXiv:2106.09178.https://arxiv.org/abs/2106.09178.

[10] FENG C J,ZHONG Y J,GAO Y,et al.TOOD:Task-Aligned one-stage object detection[C]//2021 IEEE/CVF International Conference on Computer Vision (ICCV).Montreal,QC,Canada:IEEE,2022:3490-3499.

[11] LI X,WANG W,WU L,et al.Generalized focal loss:learning qualified and distributed bounding boxes for dense object detection[EB/OL].2020.arXiv:2006.04388.https://arxiv.org/abs/2006.04388.

[12] WANG X L,GIRSHICK R,GUPTA A,et al.Non-local neural networks[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Salt Lake City,UT,USA:IEEE,2018:7794-7803.

[13] YIN M H,YAO Z L,CAO Y,et al.Disentangled non-local neural networks[M]//Computer Vision-ECCV 2020.Cham:Springer International Publishing,2020:191-207.

[14] HU J,SHEN L,SUN G.Squeeze-and-excitation networks[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Salt Lake City,UT,USA:IEEE,2018:7132-7141.

[15] WANG Q L,WU B G,ZHU P F,et al.ECA-net:efficient channel attention for deep convolutional neural networks[C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).Seattle,WA,USA:IEEE,2020:11531-11539.

[16] CAO Y,XU J R,LIN S,et al.GCNet:non-local networks meet squeeze-excitation networks and beyond[C]//2019 IEEE/CVF International Conference on Computer Vision Workshop (ICCVW).Seoul,Republic of Korea:IEEE,2020:1971-1980.

[17] CHOLLET F.Xception:deep learning with depthwise separable convolutions[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Honolulu,HI,USA:IEEE,2017:1800-1807.

[18] HOWARD A,SANDLER M,CHEN B,et al.Searching for MobileNetV3[C]//2019 IEEE/CVF International Conference on Computer Vision (ICCV).Seoul,Republic of Korea:IEEE,2020:1314-1324.

[19] MA N N,ZHANG X Y,ZHENG H T,et al.ShuffleNet V2:practical guidelines for efficient CNN architecture design[C]//Computer Vision-ECCV 2018:15th European Conference,Munich,Germany.Proceedings,Part XIV.New York:ACM,2018:122-138.

[20] HAN K,WANG Y H,TIAN Q,et al.GhostNet:more features from cheap operations[C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition(CVPR).Seattle,WA,USA:IEEE,2020:1577-1586.

[21] LI H,LI J,WEI H,et al.Slim-neck by GSConv:a better design paradigm of detector architectures for autonomous vehicles[EB/OL].2022.arXiv:2206.02424.https://arxiv.org/abs/2206.02424.

[22] ZHENG Z H,WANG P,LIU W,et al.Distance-IoU loss:faster and better learning for bounding box regression[J].Proceedings of the AAAI Conference on Artificial Intelligence,2020,34(7):12993-13000.

[23] GEVORGYAN Z.SIoU loss:more powerful learning for bounding box regression[EB/OL].2022.arXiv:2205.12740.https://arxiv.org/abs/2205.12740.

[24] REZATOFIGHI H,TSOI N,GWAK J,et al.Generalized intersection over union:a metric and a loss for bounding box regression[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).Long Beach,CA,USA:IEEE,2020:658-666.

[25] REN S Q,HE K M,GIRSHICK R,et al.Faster R-CNN:towards real-time object detection with region proposal networks[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2017,39(6):1137-1149.

[26] LIU W,ANGUELOV D,ERHAN D,et al.SSD:single shot MultiBox detector[M]//Computer Vision-ECCV 2016.Cham:Springer International Publishing,2016:21-37.

[27] TIAN Z,SHEN C H,CHEN H,et al.FCOS:fully convolutional one-stage object detection[C]//2019 IEEE/CVF International Conference on Computer Vision (ICCV).Seoul,Republic of Korea.IEEE:2020:9626-9635.

[28] XUE Z Y,XU R J,BAI D,et al.YOLO-tea:a tea disease detection model improved by YOLOv5[J].Forests,2023,14(2):415.

[29] YE J,YUAN Z Y,QIAN C,et al.CAA-YOLO:combined-attention-augmented YOLO for infrared ocean ships detection[J].Sensors,2022,22(10):3782.

[30] WANG Y,KANG X,CHU M,et al.Deep learning-based automatic dairy cow ocular surface temperature detection from thermal images[J].Computers and Electronics in Agriculture,2022,202:107429.

[31] 梁秀满,肖寒.基于SDD-YOLO的轻量级带钢缺陷实时检测算法[J/OL].中国测试,2023.[2023-02-23].http://kns.cnki.net/kcms/detail/51.1714.TB.20230109.1648.002.html.

LIANG X M,XIAO H.Lighweight strip defect real-time detection algorithm based on SDD-YOLO[J/OL].China Measurement &Test,2023.[2023-02-23].http://kns.cnki.net/kcms/detail/51.1714.TB.20230109.1648.002.html.(in Chinese)

[32] YU M,WAN Q,TIAN S L,et al.Equipment identification and localization method based on improved YOLOv5s model for production line[J].Sensors,2022,22(24):10011.

[33] YUAN J,PENG Y.Defect detection method of PCB based on improved YOLOv5[J].International Journal of Frontiers in Engineering Technology,2022,4(10).doi: 10.25236/IJFET.2022.041005.

[34] HU J,WANG Z B,CHANG M J,et al.PSG-Yolov5:a paradigm for traffic sign detection and recognition algorithm based on deep learning[J].Symmetry,2022,14(11):2262.