鱼类行为是鱼类对环境变化的外在反应,反映鱼类的日常状态和生长情况[1],是养殖技术人员判断鱼类健康状况的重要依据。鱼类游泳和摄食等行为的自动识别是鱼类活动规律和生活习性研究的基础,也是精准投喂和智慧养殖等研究的支撑[2]。

目前,对鱼类行为识别研究大多采用基于计算机视觉的方法。张重阳等[3]利用多特征融合与机器学习相结合的方法识别鱼类摄食行为,有效增强了识别网络的鲁棒性;黄志涛等[4]利用鱼体运动和图像纹理特征识别大西洋鲑的摄食活动,有效提高了识别精确度。但在真实生产条件下,光线昏暗导致计算机视觉方法无法准确识别鱼类行为,进而影响了识别准确率和召回率[5]。考虑到声音信号不受光线的影响,研究者对基于被动水声信号的鱼类分类和行为进行了研究。黄汉英等[6]通过建立基于主成分分析的支持向量机,实现对淡水鱼混合比例识别,提升了混合比例识别准确率;Kim等[7]采用卷积神经网络(convolutional neural network,CNN)实现了胡须海豹的快速识别,将深度学习引进被动声学的检测技术中,能自动识别胡须海豹的出入。鱼类摄食和游泳行为拥有不同声音特征,但真实养殖环境下各种噪声的存在,会干扰对鱼类声音特征的提取,致使基于被动声学方法识别鱼类行为的准确率和召回率也难以满足需求[8-9]。人类在复杂条件下进行目标识别时,大脑会利用听觉和视觉的互补性,同理,综合两个模态的信息识别鱼类行为,可弥补单一模态识别的不足,提升目标识别的准确性。因此,研究基于声音与视觉融合的鱼类行为识别方法,对于解决噪声干扰等复杂条件下的鱼类行为识别具有重要意义。

在多模态融合研究中,已证明多个模态信息的共同协作可以得到关联信息,为各领域的信息服务提供支撑[10]。多模态融合是将多种模态的信息集成在一起,通过分类方法来预测一个类。范习健等[11]提出一种融合听觉模态和视觉模态信息的双模态情感识别方法,利用CNN网络和长短期记忆循环神经网络对融合后的听觉和视觉双模态特征进行情感识别。Venugopalan等[12]利用深度学习,结合成像、电子健康记录和基因组数据判断是否有潜在的阿尔兹海默病,使用不同的策略融合数据,证明深度融合策略优于浅层融合策略。Nagrani等[13]提出一种基于Transformer模型的方法,使用“融合瓶颈”进行多层模态融合,提高了视听融合性能,降低了计算成本。上述研究表明,多模态融合在各领域得到了广泛应用,并取得了丰硕研究成果。但在鱼类行为识别领域中,考虑到鱼类在摄食和游泳时声音信号特征差异小、特征难学习的特点,不能直接使用上述方法进行识别。本研究中,开展了声音与视觉融合的多模态识别方法研究,在此基础上充分挖掘模态关联信息,使各模态潜在信息交互最大化,提出多级融合的U-FusionNet-ResNet50+SENet网络,并设计了不同试验,验证该方法的有效性,从而实现复杂条件下的鱼类行为识别,为智慧渔业提供新的技术支撑。

1 声音与视觉多级融合网络

声音与视觉多级融合的鱼类行为识别模型,本质上是利用鱼类在游泳和摄食等行为时发出的声音信号和视觉信息,综合两者实现鱼类行为的分类。为精准区分鱼类摄食和游泳行为,需要对不同模态的特征提取方法进行研究,获取其在高维空间上的共性。

1.1 网络结构

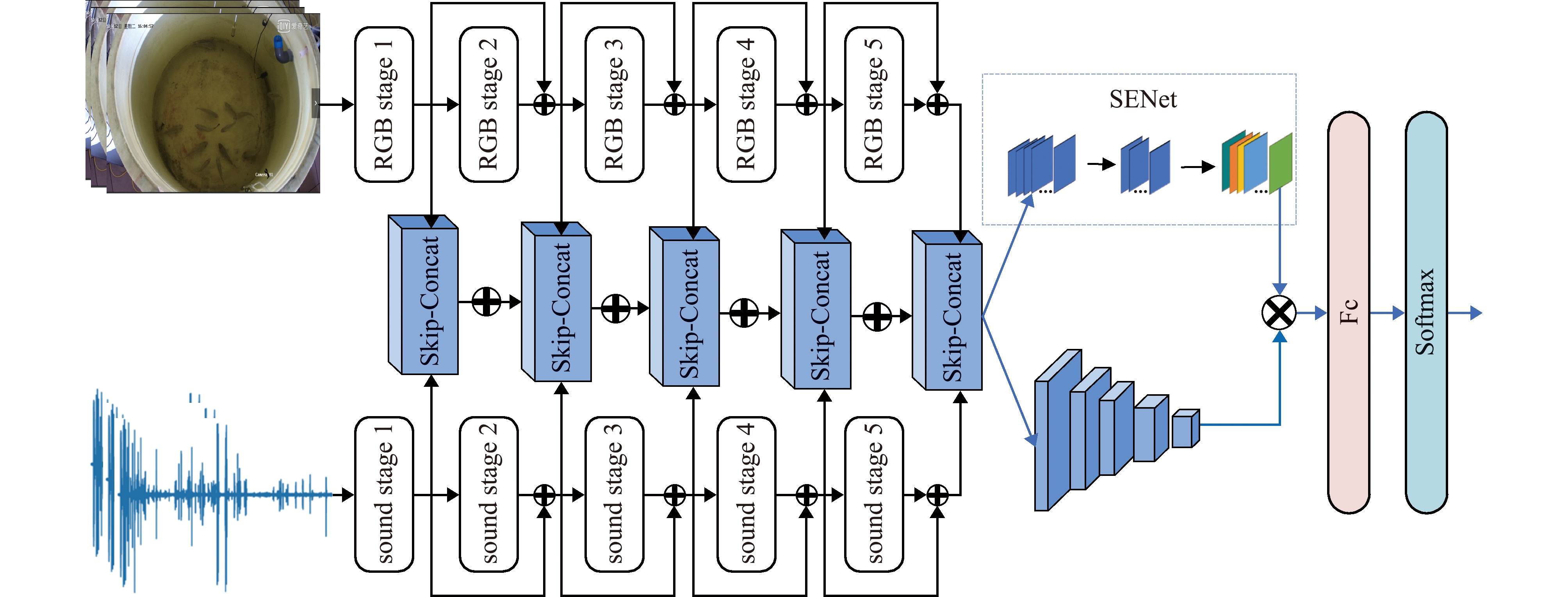

基于声音和视觉多级融合的鱼类行为识别模型U-FusionNet-ResNet50+SENet网络框架如图1所示。其中,U-FusionNet网络由特征提取模块、融合模块和通道注意力网络SENet组成,分别训练两个不同的ResNet50网络作为视觉模态与声音模态的特征提取器,提取模态全局特征。将每一个特征提取阶段的输出经过跳跃连接融合(Skip-Concat)模块进行融合,得到不同维度的融合特征;然后综合各个阶段的融合信息,将不同阶段特征进行像素级叠加,融合成一组复合特征向量;最后引入通道注意力机制SENet,通过全连接层整合特征图,用Softmax函数完成鱼类行为识别分类操作。

Stage 1~5为ResNet50的5个特征提取阶段;Skip-Concat为跳跃连接模块,实现不同阶段的模态融合;SENet为通道注意力模块;Fc为全连接层;Softmax函数为分类函数。

Stages from 1 to 5 are the five feature extraction stages of ResNet50;Skip-Concat is a skip connection module to achieve mode fusion in different stages;SENet is the channel attention module;Fc is the full connection layer;Softmax function is the classification function.

图1 多级融合的U-FusionNet-ResNet50+SENet网络

Fig.1 Multilevel Fusion U-FusionNet-ResNet50+SENet network

1.2 基于ResNet50的特征提取

采用ResNet50[14](residual neural network,残差网络)模型分别提取鱼类行为的视觉特征和声音特征,ResNet50模型的残差连接可以将原始输入信息传送到后层中,从而更好地保证特征的完整性。考虑到声音信号具有特征差异小、特征学习难等特点,先使用具有较强特征表达能力的MFCC(mel frequency cepstrum coefficient)特征系数[15]表示鱼类行为声音特征,再将其送入特征提取器中获取高维特征;然后分别固定其卷积部分作为图像与声音的特征提取器,完成特征提取。

1.3 Skip-Concat模块

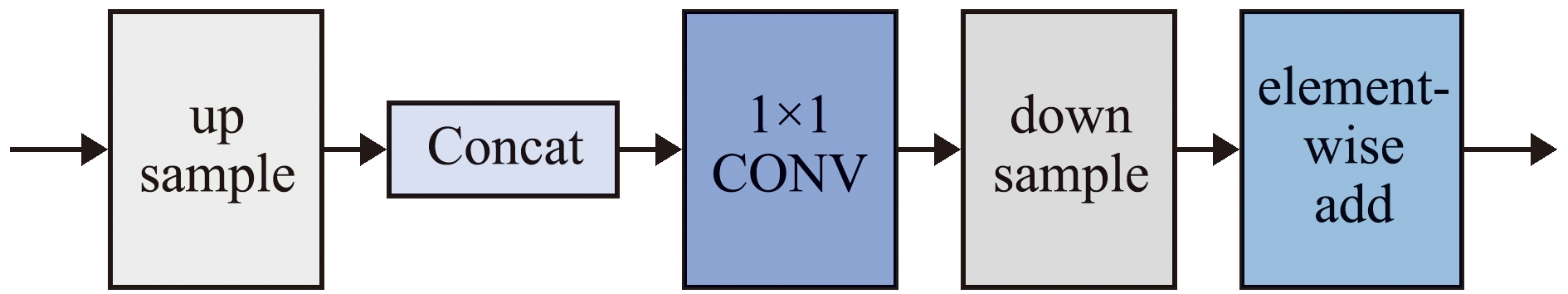

ResNet50有5个不同感受野的特征提取阶段,随着网络层数加深,其潜在基础网络的组合数目和特征组合次数增加,但在多次特征组合中,会出现信息损失,遗漏掉模态的某些潜在信息;为使模态交互充分,改进U型对称架构[16],将不同阶段的模态特征通过跳跃连接融合(Skip-Concat)模块进行融合(图2)。

up sample为上采样操作;Concat为通道融合操作;1×1 CONV为1×1卷积;down sample为下采样操作;element-wise add为元素相加操作。

up sample is an up sampling operation;Concat is a fusion operation by channel;1×1 CONV is a 1×1 convolution;down sample is a down sampling operation;element-wise add is an element addition operation.

图2 Skip-Concat模块

Fig.2 Skip-Concat module

为得到尺度相同的声音与视觉特征图,通过双线性插值法的上采样方式,统一不同模态特征图尺度。采用Concat对不同维度特征进行融合,用增加通道的方式实现融合效果,保证融合特征完整性。Concat的详细过程[17]:设有N维视觉特征,M维声音特征,将N维视觉特征与M维声音特征进行拼接操作,融合成N+M维特征。将融合得到N+M维特征进行1×1卷积,进一步实现跨通道交互和信息整合,以提升融合效率;综合各阶段融合信息,将不同阶段特征进行像素级叠加,融合成一组复合特征向量,不仅在不同维度上挖掘到更多潜在互补特征,还一定程度减少了计算量。N+M维特征表达式为

N=[x1,x2,x3,…,xn],

(1)

M=[y1,y2,y3,…,yn],

(2)

N+M=[x1,x2,x3,…,xn,y1,

y2,y3,…,yn]。

(3)

1.4 SENet注意力机制

为在凝练融合信息的同时最大程度地保留局部信息,引入通道注意力机制SENet。SENet由Hu等[18]提出,通过学习特征权重,获取到每个feature map的重要程度,根据重要程度去为每一个特征通道赋予一个权重值,增强有效信息,抑制无关信息,使模型达到更好效果。计算公式为

(4)

S=Fex(z,W)=σ[W2δ(W1,z)],

(5)

xc=Fsacle(uc,s)=siuc。

(6)

其中:H为图像特征的高度;W为宽度;zn为全局特征信息;Fsq为通道挤压操作;Fex为激励操作;S为激励操作后得到的权值;xc为每一个特征得到的通道乘积权重;Fsacle为输入通道与各自权值的乘积操作;uc代表每一个特征通道;W1和W2为全连接操作的权重;δ为激活函数ReLU;σ为归一化函数(Sigmoid)。首先,对特征图进行挤压操作,压缩特征获得全局特征信息;其次,对特征信息进行激励操作,构建特征通道间的相关性,用激活函数对权重进行非线性处理,输出的权重为每个特征通道赋予一个权值,与原始特征相乘;最后,将得到权重信息的feature map进行平均池化、送入全连接层整合特征图,通过Softmax函数进行鱼类行为的识别分类操作。损失函数(L)定义为交叉熵函数,计算公式为

(7)

其中:![]() 为融合特征预测值;y为真实值;Log为对数函数。计算出融合特征预测值与真实值的差距后,反向传播到网络中更新权重,减少差距,完成学习。

为融合特征预测值;y为真实值;Log为对数函数。计算出融合特征预测值与真实值的差距后,反向传播到网络中更新权重,减少差距,完成学习。

2 鱼类行为识别试验

2.1 数据集构建

为实现声音与视觉融合的鱼类行为分析,构建了多模态鱼类行为数据集,包括视觉数据集和声音数据集。摄食和游泳是鱼类的基础行为,也是养殖生产中重点监控的鱼类行为,养殖技术人员可以通过观察鱼类的摄食和游泳状态判断鱼类的健康水平。本试验中,数据采集以摄食和游泳行为为主,选用许氏平鲉作为试验对象。许氏平鲉习惯生活在网箱底部,因光照度弱,单一视觉方法很难采集到理想的视觉数据,用多模态融合方法可以提高行为识别的准确率。为消除不同生长阶段许氏平鲉对试验造成的误差,分别选取平均体质量为50、100、200 g 3种规格的许氏平鲉各30 尾进行试验。

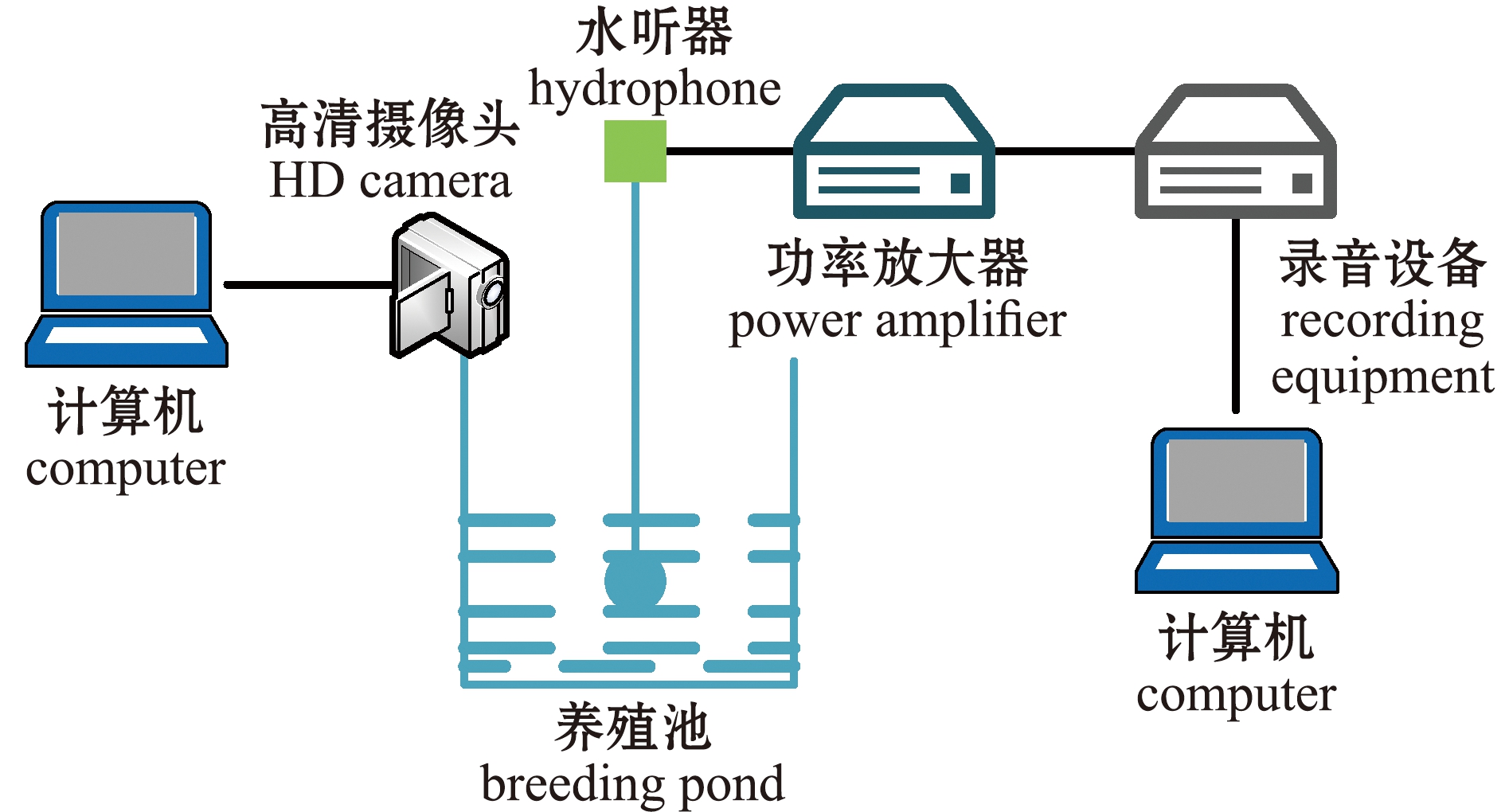

2.1.1 数据采集 试验在大连海洋大学鱼类行为学实验室进行,采集时间同步。因视觉模态和声音模态采集方式不同,故使用两套数据采集系统(水下声学测量系统和视觉行为测量系统)采集数据(图3)。使用水下声学测量系统对信号进行采集时,利用水听器(AQH20k-1062)连接功率放大器将声音信号放大并进行AD转换,通过专业数字式录音机(roland quad-capture UA-55)将信号存储为WAV声音文件;使用视觉行为测量系统对鱼类行为的视觉数据进行采集时,利用摄像头(海康威视网络摄像机)实时监控鱼类行为的视觉数据。试验中仿照养殖企业摄像头安装位置,将数据采集摄像头架设在高于水面1 m的养殖池旁,摄像头的另一端连接计算机以存储数据,数据格式为MP4视频文件。许氏平鲉养殖在直径为1 m、高为1.2 m的玻璃钢水槽中,为模拟真实环境下的养殖条件,水温保持在15~20 ℃,pH为8.0~8.5,水听器置于水面下20 cm处,此位置既不会干扰鱼类正常生活,也能采集到效果较好的声音信号,水听器采样频率设为20~20 000 Hz,覆盖鱼类发声的频率范围。

图3 鱼类行为数据采集系统

Fig.3 Fish behavior data collection system

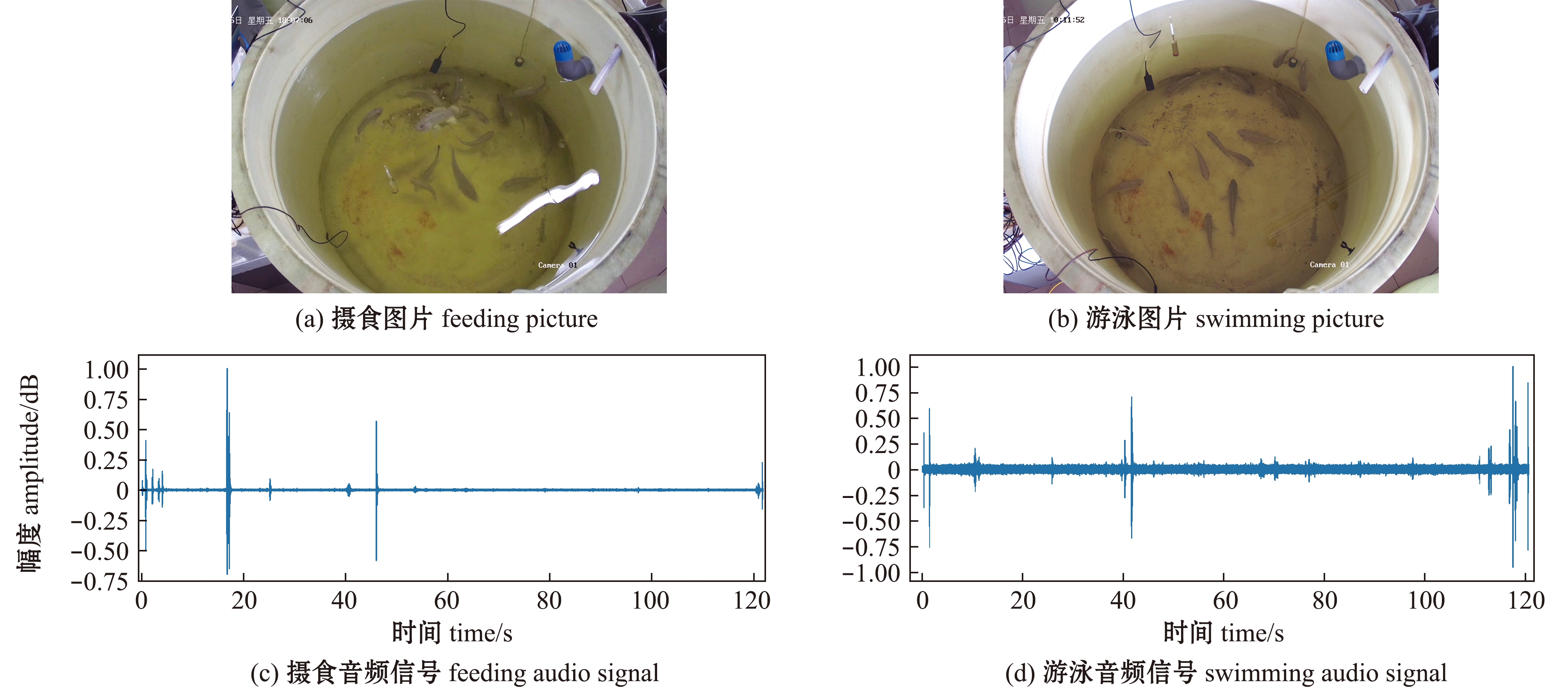

在收集摄食行为过程中发现,存在激烈摄食、平稳摄食和消极摄食3个不同阶段,为了确保收集到不同阶段下鱼类摄食行为的视觉和声音特征,在采集过程中,先将整个摄食过程全部录制,后期进行人为分割处理。采集到许氏平鲉摄食声音信号样本321 个、游泳声音信号样本491个,采集数据如图4所示,共计声音样本812个。对视频数据进行抽帧处理,抽帧的time rate设为0.4,得到许氏平鲉摄食图片4 967张,游泳图片7 317 张,共计视频样本12 284张图片,训练、验证和测试集按照正负样本比例随机划分,比例为7∶2∶1。

图4 采集的数据

Fig.4 Collected data

通过观察鱼群的摄食和游泳行为发现,许氏平鲉在摄食阶段会快速且无序地游动,在水面争抢饵料,激起水花(图4(a)),鱼群较为散乱且图像纹理也较为复杂;而在游泳阶段,许氏平鲉会群浮于水底,游动速度较慢,鱼群分散在养殖池中,纹理相对简单(图4(b))。在观察记录鱼类摄食行为的声音信号时发现,在喂食前期,鱼群无序游动寻找饵料,产生较大声音波动,其中还包括许氏平鲉为抢食跃出水面的声音;喂食中期,可以记录到鱼群咀嚼饵料的声音,但这种声音较小,声音波动不大;喂食后期,鱼群摄食逐渐结束,声音信号趋于平稳(图4(c))。在观察记录鱼类游泳行为的声音信号时发现,许氏平鲉有时会加速游动或撞击前一条鱼,造成声音的波动(图4(d))。

2.1.2 数据合成 由于多模态鱼类行为数据集是在可控实验室条件下采集得到,采集视觉数据和声音数据过程中并未受到过多噪声干扰,但在真实生产环境中,会出现光线昏暗、杂声过多的情况,为模拟真实场景下鱼类行为,对数据添加噪声。观察发现,昏暗条件下会导致亮度变暗,且拍摄数据会出现模糊不清等情况,故通过调节亮度模拟昏暗条件下采集到的图像。其次,可以采用因场景不明亮、亮度不均匀引起的传感器噪声——高斯噪声来模拟拍摄数据模糊不清的情况。鉴于以上分析,将视觉数据进行亮度调节和添加高斯噪声操作(图5)。

图5 视觉数据合成处理

Fig.5 Visual data synthesis processing

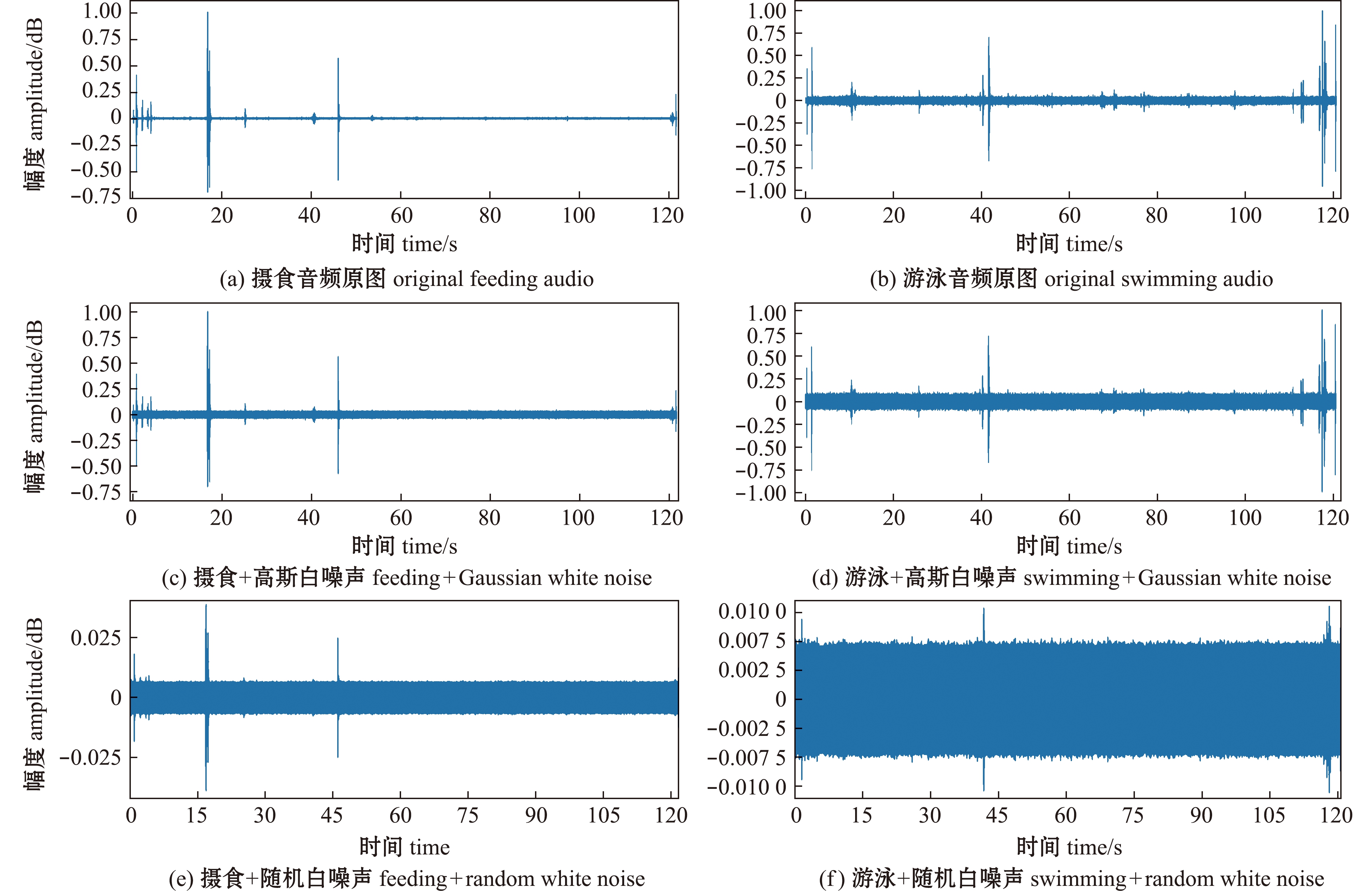

通过实地调研发现,真实生产场景下氧泵和循环水系统会有较大噪声,可以覆盖鱼类行为发出的声音,且当氧泵和循环水关闭时,也会有环境噪声与声音信号混合在一起,造成信号干扰(图6(a)、(b))。高斯白噪声是通信中的主要噪声源,将原始声音信号加上高斯白噪声,可以模拟真实场景下普遍存在的环境噪声(图6(c)、(d))。随机白噪声能覆盖鱼类摄食和游泳时发出的声音,在原始声音信号中加入随机白噪声,可以模拟真实生产环境下氧泵和循环水系统带来的噪声干扰(图6(e)、(f))。

图6 声音数据合成处理

Fig.6 Voice data synthesis processing

2.2 试验环境

试验环境为Intel Core i7-9700,CPU 3.00 GHz处理器,RTX3090显卡,32 GB内存,Windows 10 操作系统,运行环境Python 3.7,开源深度学习框架Pytorch(版本1.7.1+cu110)。训练参数设置如下:学习率为0.001,batch_size为32,epoch为50。

2.3 试验设计

为验证所提出方法对鱼类行为的识别结果,使用多模态鱼类行为的加噪合成试验数据集进行试验,并利用召回率、F1值、准确率作为试验评价指标[15]。

1)视觉方法对比试验。在图像算法中,不同特征提取网络对整体网络性能有较大影响,为验证ResNet50提取鱼类行为视觉特征的有效性,与张重阳等[3]提出的Multi-feature BP network和黄志涛等[4]提出的Motion feature-image texture的方法进行比较。

2)声音方法对比试验。不同的声音特征提取网络对后续融合网络性能有较大影响,本研究中使用基于MFCC+ResNet50的鱼类声音特征提取方法,对声音数据集进行特征提取,为验证此方法的有效性,与其他的声音特征提取网络进行比较,包括黄汉英等[6]提出的PCA-SVM方法和Kim等[7]提出的CNN的方法。

3)单模态识别与多模态识别对比试验。为验证多模态鱼类行为识别效果,设计了单模态与多模态识别效果对比试验。

4)消融试验。为验证通道注意力机制SENet在网络中的作用,分别在有注意力机制和无注意力机制下进行了多模态鱼类行为识别对比试验。

5)模型试验。为验证本研究中所提出网络模型的有效性,与其他多模态融合方法(Architecture of image-voice joint model[11]、Intermediate-feature-level deep model[12]和MBT[13]等)进行对比。

6)验证试验。为验证本研究中所提出方法在无噪声干扰条件下也能取得较好的识别效果,使用无合成噪声的数据集对模型进行验证试验,并与其他融合模型(Architecture of image-voice joint model[11]、Intermediate-feature-level deep model[12]和MBT[13]等)进行对比。

2.4 结果分析

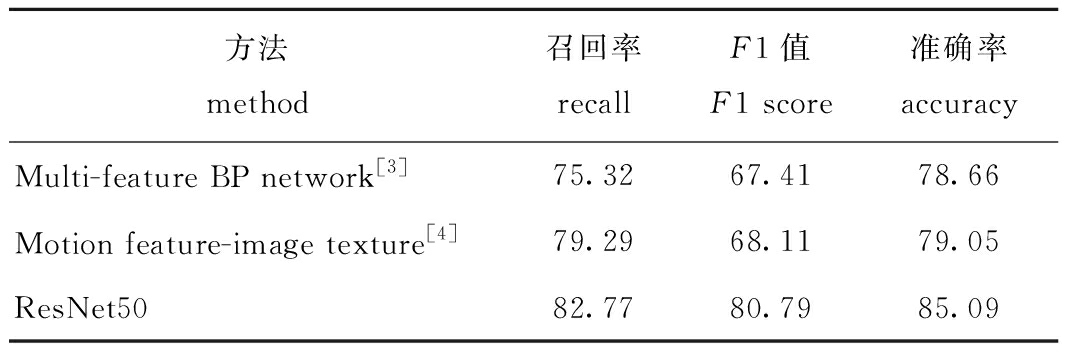

2.4.1 单模态下视觉方法的对比试验 本研究中,使用ResNet50对多模态鱼类行为数据集中的视觉数据集进行特征提取,与其他方法对比发现,ResNet50的平均准确率、F1值和召回率相较于Multi-feature BP network[3]分别提升了6.43%、13.38%、7.45%,相较于Motion feature-image texture[4]的平均准确率、F1值和召回率分别提升了6.04%、12.68%、3.48%(表1)。

表1 视觉方法的对比

Tab.1 Contrast of visual methods %

方法 method召回率 recall F1值 F1 score准确率 accuracyMulti-feature BP network[3]75.3267.4178.66Motion feature-image texture[4]79.2968.1179.05ResNet5082.7780.7985.09

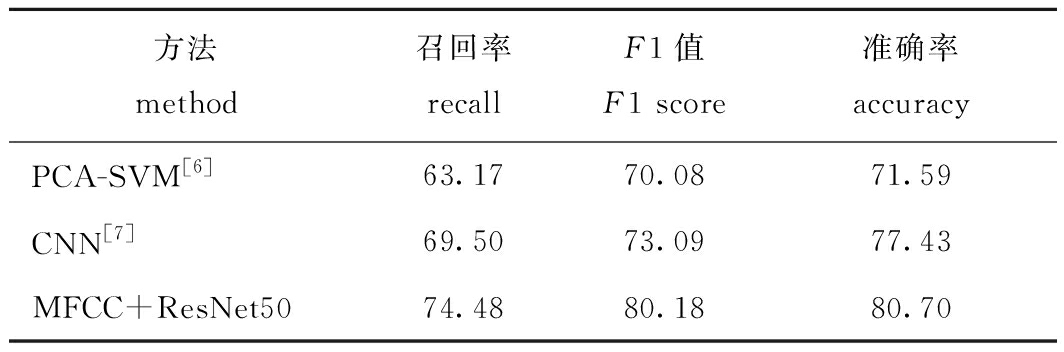

2.4.2 单模态下声音方法的对比试验 本研究中使用基于MFCC+ResNet50的鱼类声音特征提取方法对声音数据集进行特征提取,与其他方法对比发现,MFCC+ResNet50的平均准确率、F1值和召回率相较于PCA-SVM[6]方法分别提升了9.11%、10.1%、11.31%,相较于CNN[7]分别提升了3.27%、7.09%、4.98%(表2)。

表2 声音方法的对比

Tab.2 Contrast of sound methods %

方法method召回率 recallF1值 F1 score准确率 accuracyPCA-SVM[6]63.1770.0871.59CNN[7]69.5073.0977.43MFCC+ResNet5074.4880.1880.70

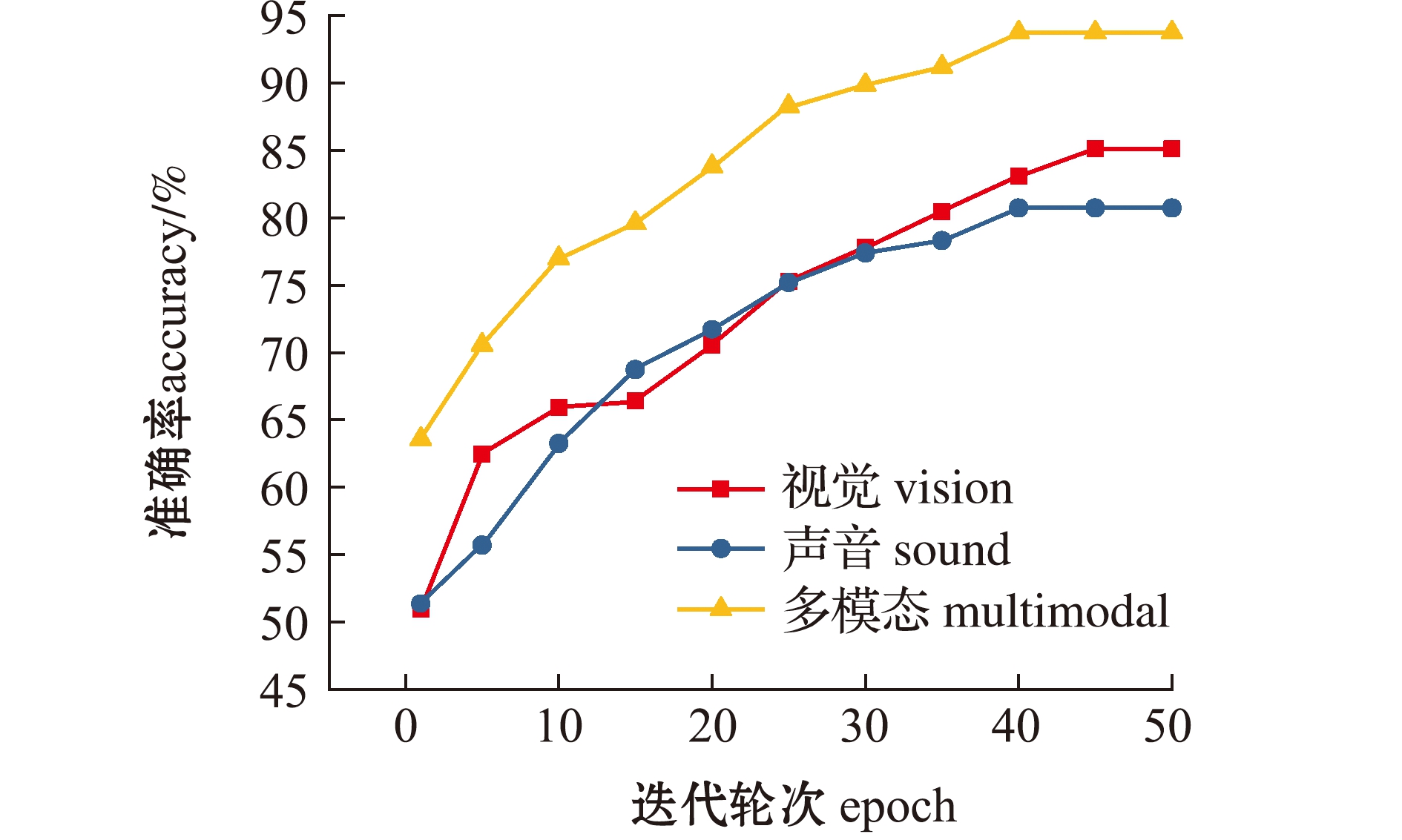

2.4.3 单模态识别与多模态识别的对比试验 将单模态下ResNet50模型和MFCC+ResNet50模型与多模态U-FusionNet-ResNet50+SENet的识别效果进行对比。由图7的准确率曲线可以看出,多模态融合的平均识别准确率相较于视觉和声音单模态识别的准确率分别提升了8.62%和13.01%。

图7 单模态识别与多模态识别的对比

Fig.7 Comparison of single mode recognition with multi-mode recognition

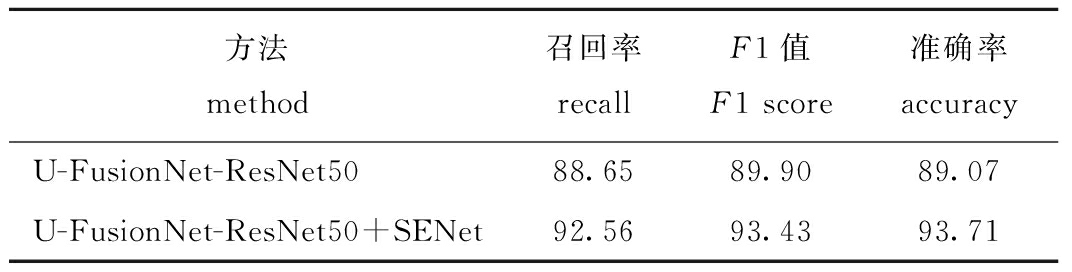

2.4.4 消融试验 本研究中,使用SENet注意力机制提升模型的准确率,对比发现,SENet的加入为网络提升了4.64%的平均准确率,3.91%的召回率,3.53%的F1值。这是因为SENet在凝练融合信息的同时保留了局部信息,增强了有效信息,并且抑制了不相关信息。说明通道注意力机制能有效地提升鱼类行为识别的整体效果(表3)。

表3 消融试验

Tab.3 Ablation experiments %

方法method召回率recallF1值F1 score准确率accuracyU-FusionNet-ResNet5088.6589.9089.07U-FusionNet-ResNet50+SENet92.5693.4393.71

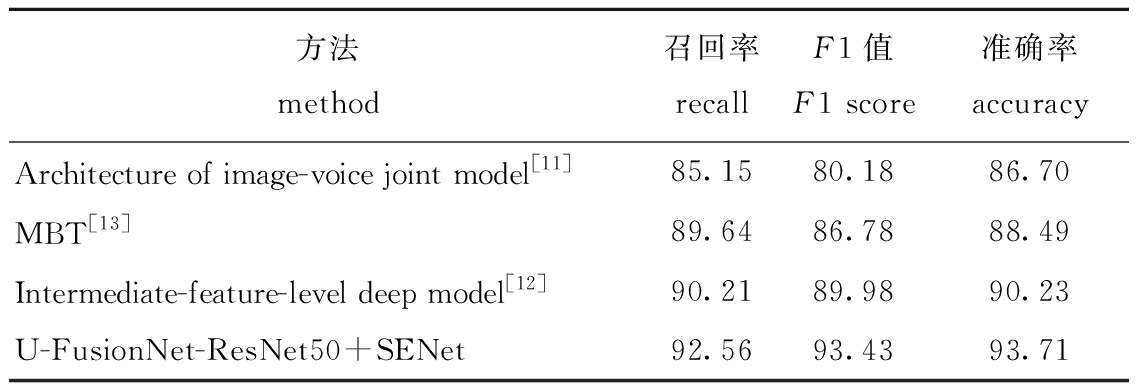

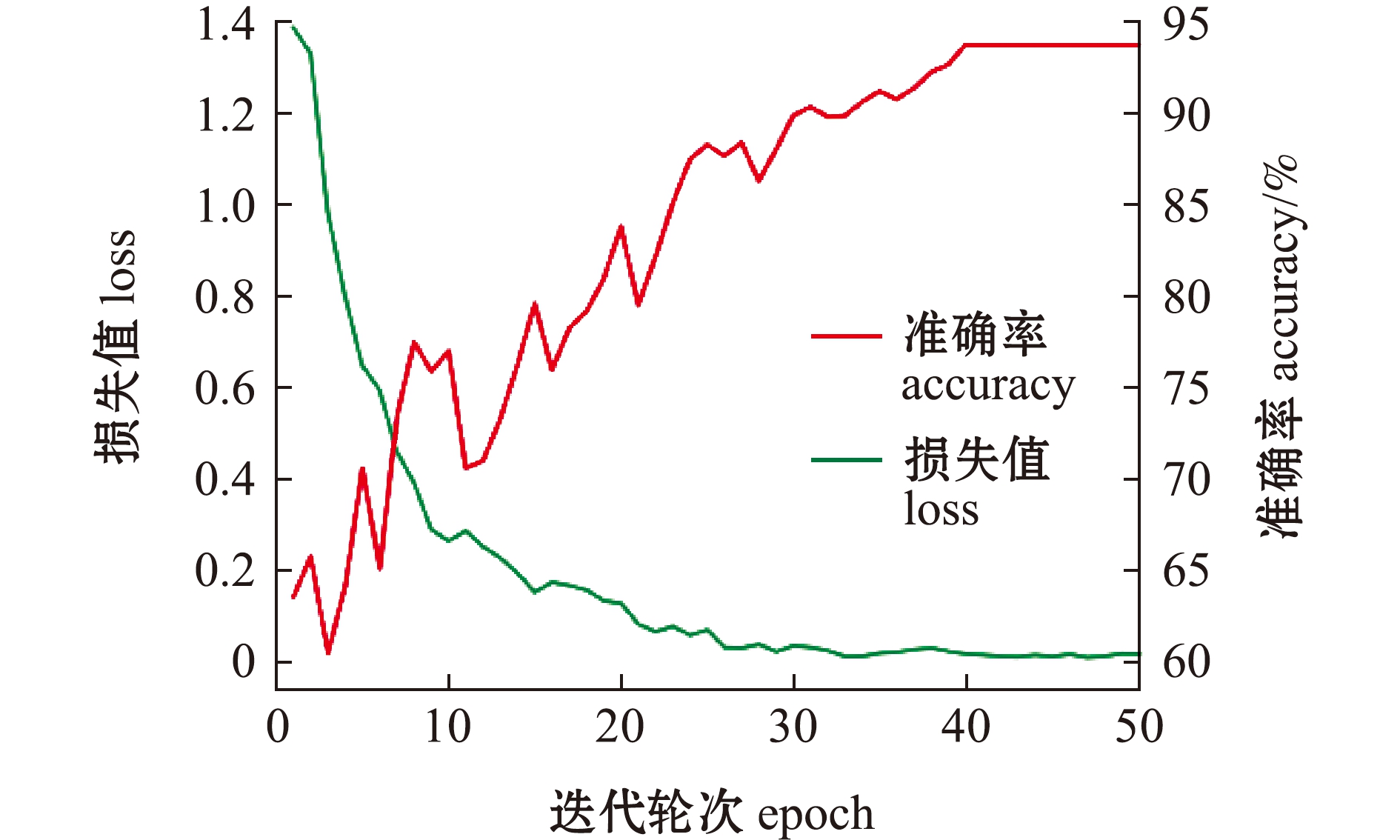

2.4.5 模型试验 针对多模态鱼类行为的加噪合成试验数据,U-FusionNet-ResNet50+SENet的准确率、F1值和召回率分别为93.71%、93.43%、92.56%,与效果较好的Intermediate-feature-level deep model[12] 相比,召回率、F1值和平均准确率分别提升了2.35%、3.45%、3.48%(表4)。由图8可见,在第40次迭代之后准确率基本保持不变,说明所提出的方法能够快速收敛(图8)。

表4 模型对比试验

Tab.4 Noise model experiment %

方法method召回率 recallF1值 F1 score准确率 accuracyArchitecture of image-voice joint model[11]85.1580.1886.70MBT[13]89.6486.7888.49Intermediate-feature-level deep model[12]90.2189.9890.23U-FusionNet-ResNet50+SENet92.5693.4393.71

图8 准确率和loss值变化曲线

Fig.8 Curve of accuracy and loss value

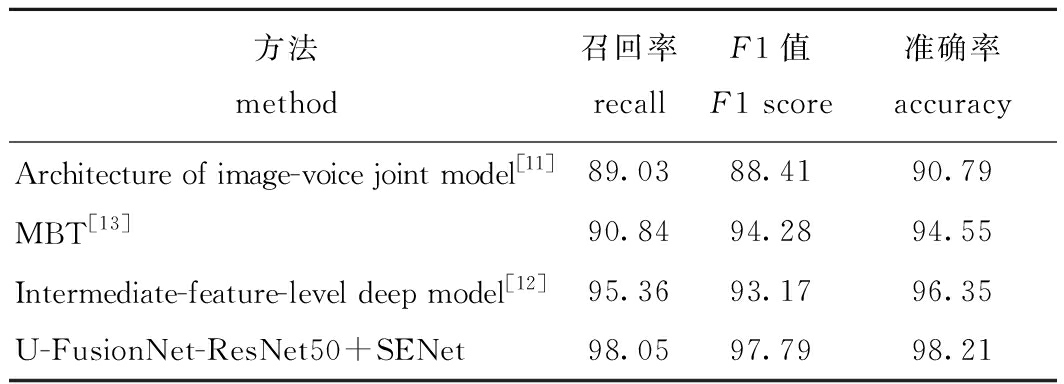

2.4.6 验证试验 针对不添加噪声的鱼类行为数据,与其他方法对比发现,U-FusionNet-ResNet50+SENet的准确率、F1值和召回率分别为98.21%、97.79%、98.05%(表5),而针对添加噪声的鱼类行为数据,U-FusionNet-ResNet50+SENet的准确率、F1值和召回率分别为93.71%、93.43%、92.56%(表4)。说明本研究中提出的模型,不仅在无噪声干扰条件下能保持较高准确率和召回率,而且也能解决噪声干扰问题。

表5 验证试验(不加噪声)

Tab.5 Confirmatory experiment(without noise) %

方法 method召回率 recallF1值 F1 score准确率 accuracyArchitecture of image-voice joint model[11]89.0388.4190.79MBT[13]90.8494.2894.55Intermediate-feature-level deep model[12]95.3693.1796.35U-FusionNet-ResNet50+SENet98.0597.7998.21

3 讨论

3.1 多模态模型的选取与优化

本研究中,为解决在光线昏暗、声音和视觉噪声干扰等复杂条件下,对单模态鱼类行为识别的准确率和召回率不高的问题,提出利用鱼类行为产生的声音特征和视觉特征的互补性,弥补单一模态预测的不足,提高鱼类行为识别的准确性和鲁棒性。

相较于单一的视觉识别模型或声音识别模型,多模态识别模型在视觉或声音数据质量不高时,能通过另一种模态特征弥补单一模态识别的误差,在模态信息交互过程中,除了能利用声音和视觉的互补性减少误差,还能强化有用的鱼类特征信息,提高鱼类行为识别的准确率。但因鱼类行为具有声音信号特征差异小、特征难学习的特点,不能直接使用现有的多模态融合模型。

本研究中,采用MFFC+ResNet50的声音信号识别网络,解决特征难学习的问题,为使各模态潜在信息交互最大化,最大程度地发挥多模态识别的优势,提出多级融合的U-FusionNet-ResNet50+SENet网络,通过U型融合架构使不同维度的鱼类视觉特征和声音特征充分交互,采用Skip-Concat模块将不同阶段的模态特征进行融合,同时引入SENet构成关注通道信息的特征融合网络。多模态融合模型U-FusionNet-ResNet50+SENet对鱼类行为的识别效果有较大的提升,较传统的单模态方法识别效果更加精准。

3.2 鱼类行为识别效果分析

鱼类行为识别可以通过识别鱼类个体或者鱼群的行为变化,帮助养殖人员判断鱼的健康状态及养殖环境的安全性。智能化识别鱼类行为是智慧渔业和精准养殖的重要内容,为养殖人员带来了极大的便利。摄食和游泳是鱼类的基础行为,通过观察鱼类摄食和游泳行为,可以直接判断养殖鱼类的活跃度和生长情况。目前,识别鱼类行为的主要方法是单模态识别,如基于计算机视觉的行为识别及基于被动声学的行为识别,这两种方法均是单纯利用成像数据和声音信号对鱼类行为进行识别。但在真实的养殖条件下,会出现很多复杂情况,如光线昏暗、模糊、噪声干扰等,这些因素会使得模型的识别效果较差。然而,随着多模态技术的发展,通过视觉和声音两个模态的融合,可以互相补充互相强化,很好地解决复杂条件下的识别问题,提高模型的鲁棒性。因此,本研究中提出了一种基于视觉特征与声音融合互补的鱼类行为识别方法,相较于单模态的视觉方法或声音方法,声音和视觉两个模态相融合较好地提高了鱼类行为的识别准确率。

目前,已有的多模态融合方法,其策略大多使用前期融合、中期融合和晚期融合,这3种融合方式均是在网络的某一阶段进行融合。但随着网络层数的增加,提取到的特征也在不断地进行组合,在多次组合中会遗漏掉模态某些潜在信息。为了获得更多的模态潜在信息,本研究中提出了多级融合的策略,在特征提取的每一阶段都进行融合,最大程度地减少遗漏的特征信息,提升识别的准确率。综上,本研究中提出的U-FusionNet-ResNet50+SENet网络,在添加噪声和不添加噪声的多模态鱼类行为数据集中,对鱼类行为的识别准确率分别可达93.71%、98.21%,与已报道的Intermediate-feature-level deep model[12] 相比,召回率、F1值和平均准确率分别提升了2.35%、3.45%、3.48%。说明本模型能有效提升鱼类行为识别的准确率,可应用于复杂条件下的鱼类行为识别。

4 结论

1)本研究中提出的基于声音和视觉特征多级融合的鱼类行为识别模型U-FusionNet-ResNet50+SENet,解决了光线昏暗、噪声干扰等复杂条件下鱼类行为识别的准确率、召回率不高的问题。

2)使用U-FusionNet-ResNet50+SENet模型对试验用许氏平鲉游泳和摄食行为的识别准确率可达93.71%,表明该识别方法是一种自动化、高准确度的鱼类行为识别方法。但由于实验室采集数据量不够大,未能包含真实水产养殖环境下所有的样本信息,故今后需进一步扩大样本数量及样本多样性,使其能在未来应用于真实水产养殖环境下的鱼类行为识别。

[1] SAOWAKOON S,SAOWAKOON K,JUTAGATE A,et al.Growth and feeding behavior of fishes in organic rice-fish systems with various species combinations[J].Aquaculture Reports,2021,20:100663.

[2] 于红.水产动物目标探测与追踪技术及应用研究进展[J].大连海洋大学学报,2020,35(6):793-804.

YU H.Research progress on object detection and tracking techniques utilization in aquaculture:a review[J].Journal of Dalian Ocean University,2020,35(6):793-804.(in Chinese)

[3] 张重阳,陈明,冯国富,等.基于多特征融合与机器学习的鱼类摄食行为的检测[J].湖南农业大学学报(自然科学版),2019,45(1):97-102.

ZHANG C Y,CHEN M,FENG G F,et al.Detection method of fish feeding behavior based on the multi-feature fusion and the machine learning[J].Journal of Hunan Agricultural University (Natural Sciences Edition),2019,45(1):97-102.(in Chinese)

[4] 黄志涛,何佳,宋协法.基于鱼体运动特征和图像纹理特征的鱼类摄食行为识别与量化[J].中国海洋大学学报(自然科学版),2022,52(1):32-41.

HUANG Z T,HE J,SONG X F.Recognition and quantification of fish feeding behavior based on motion feature of fish body and image texture[J].Periodical of Ocean University of China(Natural Sciences Edition),2022,52(1):32-41.(in Chinese)

[5] 曹晓慧,刘晃.养殖鱼类摄食行为的特征提取研究与应用进展[J].渔业现代化,2021,48(2):1-8.

CAO X H,LIU H.Advances in the study and application of feature extraction in feeding behavior of cultured fish[J].Fishery Modernization,2021,48(2):1-8.(in Chinese)

[6] 黄汉英,杨咏文,李路,等.基于被动水声信号的淡水鱼混合比例识别[J].农业机械学报,2019,50(10):215-221.

HUANG H Y,YANG Y W,LI L,et al.Mixed proportion identification of freshwater fish based on passive underwater acoustic signals[J].Transactions of the Chinese Society for Agricultural Machinery,2019,50(10):215-221.(in Chinese)

[7] KIM J S,YOON Y G,HAN D G,et al.Classification of bearded seals signal based on convolutional neural network[J].The Journal of the Acoustical Society of Korea,2022,41(2):235-241.

[8] 殷雷明,陈雪忠,张旭光,等.玻璃钢水槽内大黄鱼养殖环境噪声测量与分析[J].海洋渔业,2017,39(3):314-321.

YIN L M,CHEN X Z,ZHANG X G,et al.Measurement and analysis of the aquaculture noise for Larimichthys crocea in the fiberglass fish tank[J].Marine Fisheries,2017,39(3):314-321.(in Chinese)

[9] 曲蕊,刘晃,庄保陆,等.水产养殖中摄食声学研究进展[J].渔业现代化,2020,47(4):1-6.

QU R,LIU H,ZHUANG B L,et al.Research progress of feeding acoustics in aquaculture[J].Fishery Modernization,2020,47(4):1-6.(in Chinese)

[10] JIANG X Y,WU F,LI X,et al.Deep compositional cross-modal learning to rank via local-global alignment[C]//Proceedings of the 23rd ACM international conference on multimedia,Brisbane Australia.New York,NY,USA:ACM,2015,41(7):69-78.

[11] 范习健,杨绪兵,张礼,等.一种融合视觉和听觉信息的双模态情感识别算法[J].南京大学学报(自然科学版),2021,57(2):309-317.

FAN X J,YANG X B,ZHANG L,et al.Emotion recognition based on visual and auditory information[J].Journal of Nanjing University (Natural Science Edition),2021,57(2):309-317.(in Chinese)

[12] VENUGOPALAN J,TONG L,HASSANZADEH H R,et al.Multimodal deep learning models for early detection of Alzheimer’s disease stage[J].Scientific Reports,2021,11(1):3254.

[13] NAGRANI A,YANG S,ARNAB A,et al.Attention bottlenecks for multimodal fusion[J].Advances in Neural Information Processing Systems,2021,34:14200-14213.

[14] 张方言,赵梦,周弈志,等.基于ResNet50和迁移学习的红鳍东方鲀病鱼检测方法[J].渔业现代化,2021,48(4):51-60.

ZHANG F Y,ZHAO M,ZHOU Y Z,et al.Detection of diseased Takifugu rubripes based on ResNet50 and transfer learning[J].Fishery Modernization,2021,48(4):51-60.(in Chinese)

[15] 胥婧雯,于红,李海清,等.基于MFCC和ResNet的鱼类行为识别[J].海洋信息技术与应用,2022(1):21-27.

XU J W,YU H,LI H Q,et al.Fish behavior recognition based on MFCC and ResNet[J].Marine Information,2022(1):21-27.(in Chinese)

[16] 赵梦,于红,李海清,等.融合SKNet与YOLOv5深度学习的养殖鱼群检测[J].大连海洋大学学报,2022,37(2):312-319.

ZHAO M,YU H,LI H Q,et al.Detectionof fish stocks by fused with SKNet and YOLOv5 deep learning[J].Journal of Dalian Ocean University,2022,37(2):312-319.(in Chinese)

[17] 罗涛,李剑峰,韩家辉,等.一种基于多模态特征融合的骨质疏松评估方法[J].北京邮电大学学报,2019,42(6):84-90.

LUO T,LI J F,HAN J H,et al.Osteoporosis evaluation method based on multimodal feature fusion[J].Journal of Beijing University of Posts and Telecommunications,2019,42(6):84-90.(in Chinese)

[18] HU J,SHEN L,ALBANIE S,et al.Squeeze-and-excitation networks[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2020,42(8):2011-2023.