海洋信息的有效利用,对国民经济和社会发展有着重要的影响,而水下图像是海洋信息的一个重要组成部分。由于复杂的水下成像环境及光在水中传播的光吸收和散射效应,人们直接在海底拍摄的图像往往是退化的图像,存在色偏、对比度低、模糊和光照不均匀等问题,限制了水下图像在实际场景中的应用[1]。为了解决上述问题,在水下图像应用之前,首先要进行图像处理,其中包括图像增强、图像恢复和图像重建等方法。

水下图像增强方法主要由传统技术(如空域图像处理、频域图像处理)和数据驱动技术(如深度学习[2-3])组成。由于有监督的深度学习模型需要大量成对训练集,水下退化图像及其对应的真值图像受水下特殊成像环境的限制难以获得。许多研究者已经尝试利用非监督双鉴别器生成对抗网络(dual discriminator generative adversarial nets,D2GAN)的方法进行水下图像增强。Li等[4]第一次将非监督模型应用到水下图像增强领域,在CycleGAN的基础上增加了结构相似性(SSIM)损失函数,提出了UWGAN水下图像增强模型;Lu等[5]在UWGAN模型上融合了多尺度,提出了MCycleGAN模型。而上述两种模型的判别器为CycleGAN的马尔可夫判别器(PatchGAN),易导致图片出现棋盘格伪影,整体优化会造成生成的图片边界模糊。为减少水下图像的噪声,Fabbri等[6]提出了UGAN水下图像增强模型,判别器使用带梯度惩罚的Wasserstein GAN(WGAN-GP)损失函数,但计算过程中的梯度惩罚耗费时间长且收敛速度慢;Ye等[7]提出了一种使用堆叠条件生成对抗网络(UIE-SGAN)的水下图像增强模型,包括雾度检测子网和色彩校正子网,但试验的训练数据集均为合成水下数据集,导致训练时不可避免地引入不恰当的学习约束,不能准确反映水下图像增强的真实情况。上述UGAN和UIE-SGAN两种模型的生成器均为U-Net结构,在上采样的反卷积过程中不可避免地会造成棋盘格伪影,且图像的边缘信息易在深层网络的下采样和上采样操作中丢失。为保留更多的图像细节,Du等[8]提出了UW-CycleGAN模型以恢复退化的水下图像,在生成器中添加DenseNet块,以保留每个特征图的更多信息。Zong等[9]提出了Local-CycleGAN模型来增强水下图像,其结合了局部判别器和全局判别器来约束增强图像的全局和局部视觉效果。但UW-CycleGAN和Local-CycleGAN这两种模型对于图像清晰度的增强不够[10],无法同时实现水下图像颜色校正和图像清晰度增强的目标。

本研究中,提出了一种基于非监督超分辨重构的水下图像增强方法SR-CycleGAN,该模型不仅实现了水下图像的超分辨率重构,形成水下高分辨率的图像,还可以从陆地图像中进行水下图像的色彩学习,有效地消除了水下图像的色彩偏差问题,可实现水下图像颜色校正和清晰度增强的双重目标。

1 网络结构

1.1 SR-CycleGAN网络结构组成

现有的超分辨重构(super resolution,SR)主要集中在监督学习上,大多需要先验知识,即利用匹配的低分辨率(low resolution,LR)图像和高分辨率(high resolution,HR)图像对进行学习[10-11]。然而,由于水下摄像的独特环境,难以获得同一场景的不同分辨率图像,目前还无大量的标记数据来训练水下图像校正的深度学习模型,这些标记数据包括清晰和退化的水下场景的图像对。因此,SR数据集中的LR图像通常是通过对HR图像的预先降质处理得到的。为了学习真实场景的LR-HR映射,研究者们越来越关注非监督SR,在这种情况下,提供未配对的LR-HR图像进行训练,可以使生成的模型更有可能处理真实场景中的SR问题。

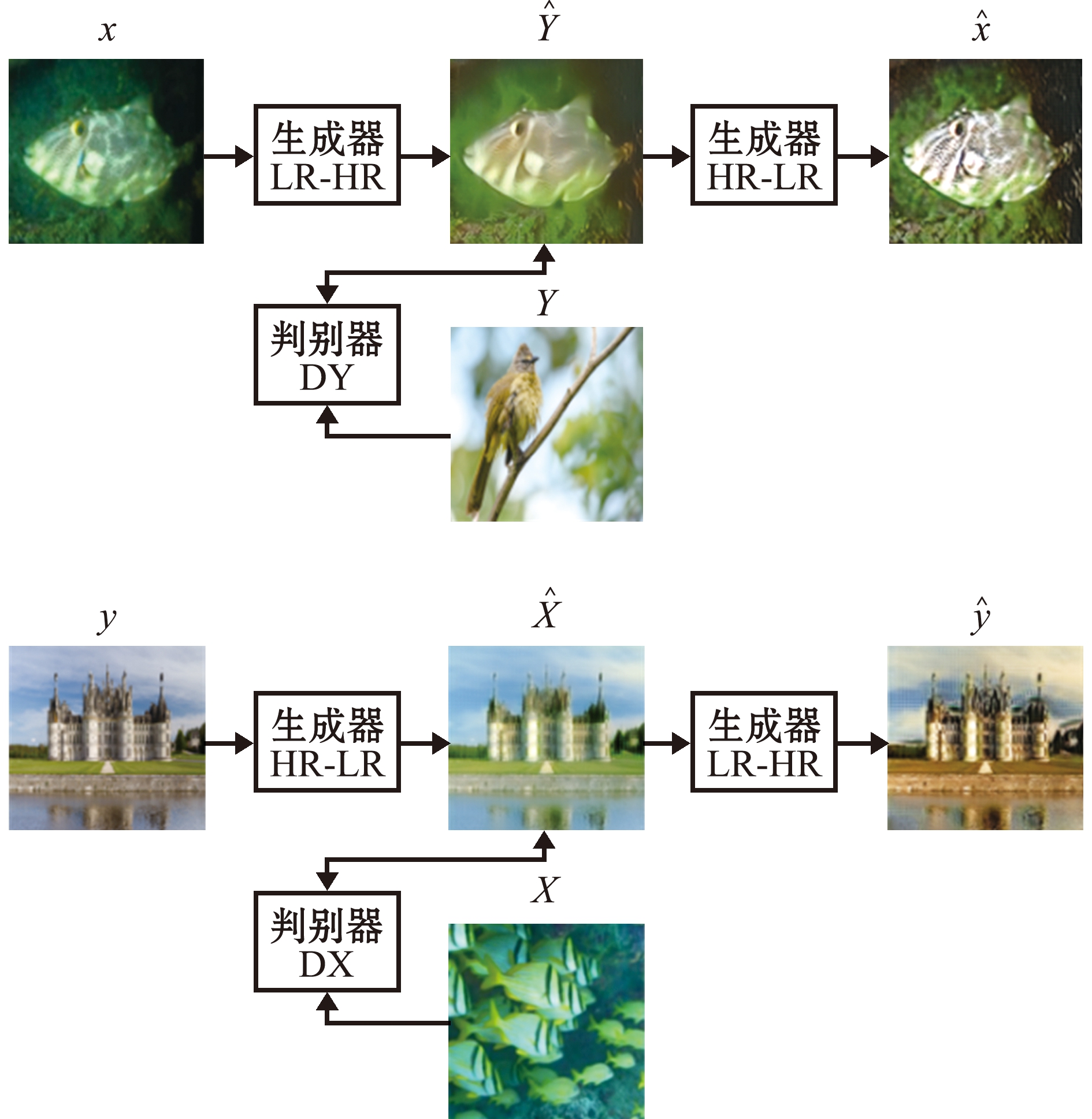

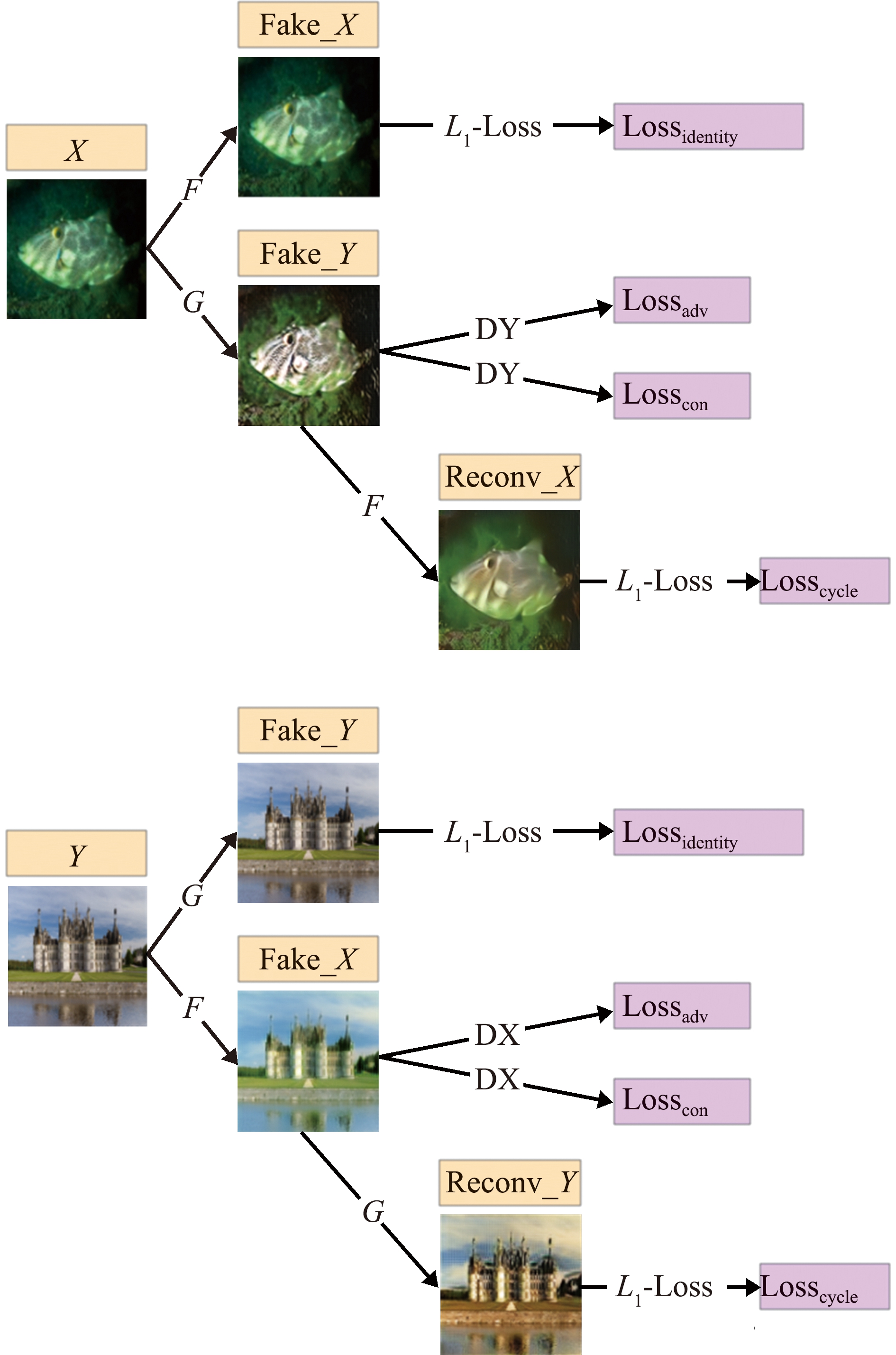

针对难以收集水下同一场景不同分辨率图像的问题,本研究中提出了一种非监督模型,只需提供不同分辨率的真实图像就能实现水下图像增强,无需使用成对的图像进行网络训练。给定具有高分辨率和低分辨率图像的未配对数据集,理论上可以使用生成对抗网络(generative adversarial network,GAN),通过对抗学习的方式将图像从低分辨率图像域映射至高分辨率图像域。然而,映射关系的解空间并不是一个有限的空间,图像从低分辨率图像域转换到高分辨率图像域,有无限多的映射关系,不能保证低分辨率和高分辨率图像间的相关性。为了实现低分辨率图像到高分辨率图像的一对一映射,本研究中基于CycleGAN[12]循环一致性的思想设计了超分辨网络架构,将LR空间和HR空间视为两个域,并使用CycleGAN学习彼此之间的映射。推送映射结果去匹配目标的域分布,并通过往返(round-trip)映射使图像恢复,有效地防止了利用标准GAN解决非监督图像超分辨重构时出现的模式坍塌问题。SR-CycleGAN网络结构见图1。

图1 SR-CycleGAN网络结构

Fig.1 SR-CycleGAN network structure

1.2 G-Up生成网络

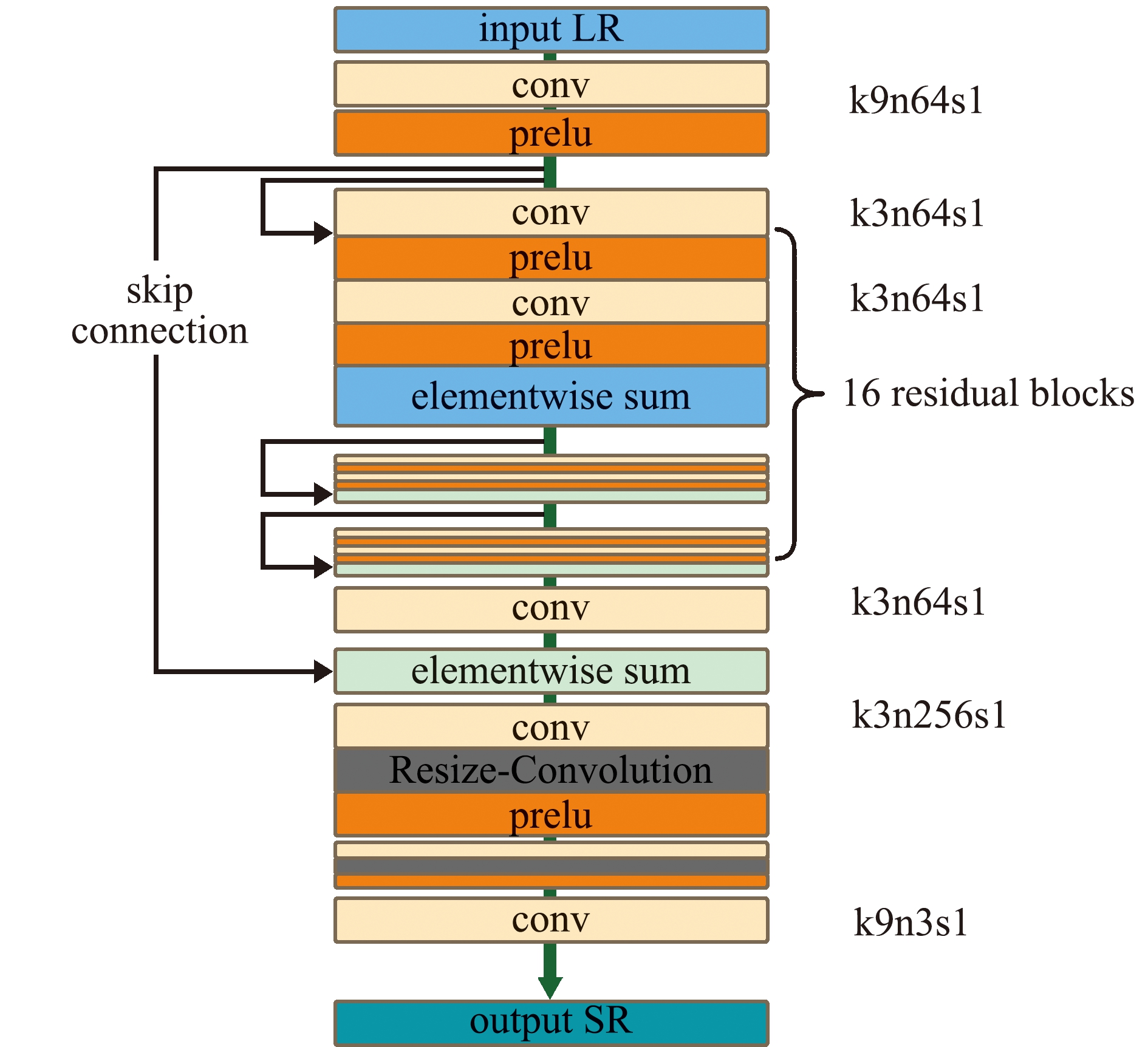

G-Up生成网络以残差网络的图像超分辨率重构(SRResNet)为基础进行优化。

1)G-Up删除了批处理规范化层(batch normalization,BN),归一化处理会破坏原始空间的特征,如图像的色彩、亮度等信息。本研究中去掉BN层的网络可以加快训练速度,减少时间复杂度。

2)使用缩放卷积进行上采样。本研究中根据Odena等[13]提出的缩放卷积(Resize-Convolution)思想,使用最近邻插值将图像放大2倍后再卷积,相较于反卷积每个输出窗口只有一个值,Resize-Convolution隐含地对图像进行加权处理[14],抑制了高频假象的产生。

G-Up生成网络结构如图2所示。

图2 G-Up生成网络结构

Fig.2 G-Up generative network structure

1.3 G-Down生成网络

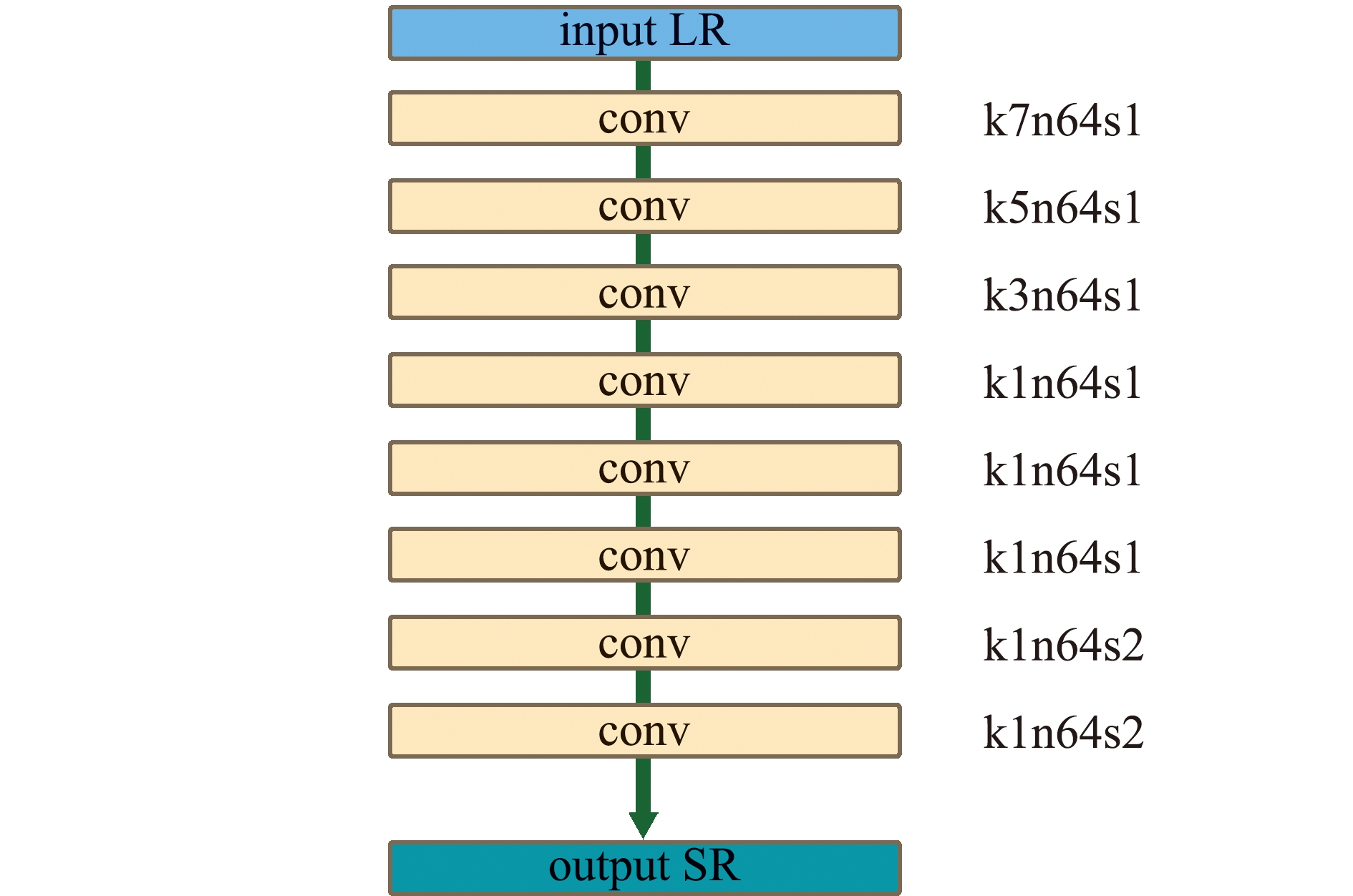

SR的退化模型一般假定LR是使用某种模糊核将HR按比例系数S缩小的结果[15-16],从HR到LR的潜在退化过程公式为

ILR=(IHR×KS)↓S。

(1)

参考公式(1),本研究中G-Down生成网络设计为无激活函数的多层线性网络作为下采样模块。G-Down生成网络结构如图3所示。

图3 G-Down生成网络结构

Fig.3 G-Down generative network structure

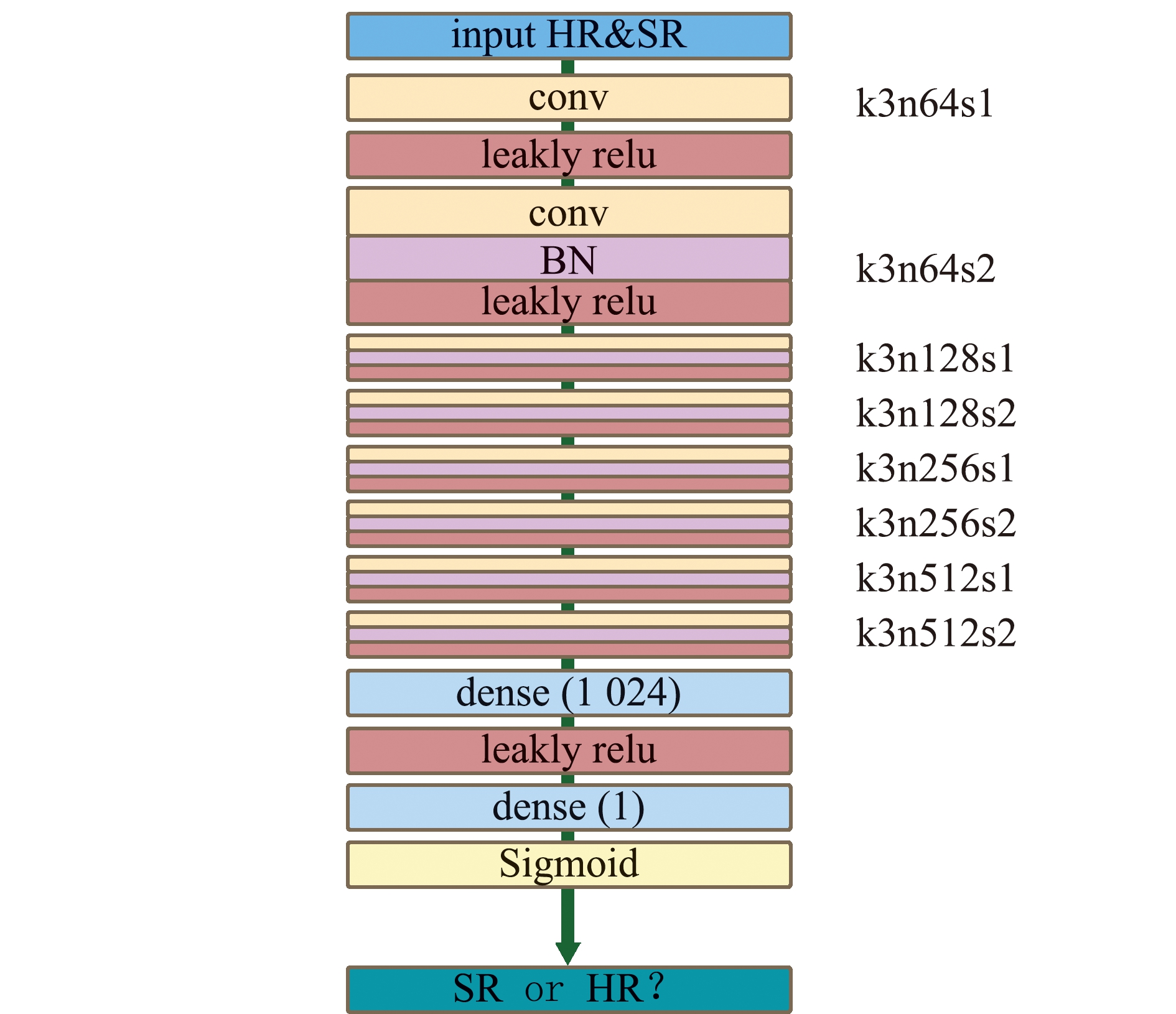

1.4 判别器

采用相对平均判别器(relativistic average dis-criminator,RaD)[17],以估计真实图像比生成图像更逼真的概率。使用RaD降低了梯度的随机性,使得判别器更稳健,提升了图像的相对真实性,从而恢复图像更多的纹理细节。判别器的网络采用与SRGAN判别器结构相同的VGG网络,通过Sigmoid激活函数得出真实图像比生成图像更逼真的概率。判别网络结构如图4所示。

图4 判别网络结构

Fig.4 Discriminative network structure

1.5 损失函数

采用对抗损失(Lossadv)、循环一致性损失(Losscycle)、内容损失(Losscon)和identity损失(Lossidentity)对超分辨网络和退化网络进行训练。网络整体损失函数公式为

Loss=Lossadv+Losscon+λLosscycle+Lossidentity。

(2)

其中,λ为加权因子,用于控制循环一致性损失在全部损失中的权重。

1)对抗损失。对于G-Up生成网络xlf=G(xlr),xlr表示LR图像,xlf表示G-Up网络生成的SR图像。G-Down网络同理。G-Up、G-Down对抗损失计算公式分别为

Ladv(lr)=-Exlr{Log[1-DRa(xlr, xlf)]}-

Exlf{Log[DRa(xlf, xlr)]},

(3)

Ladv(hr)=-Exhr{Log[1-DRa(xhr, xhf)]}-

Exhf{Log[DRa(xhf, xhr)]}。

(4)

2)内容损失。内容损失函数采用L1范数来衡量生成的图像G(x)或F(y)在视觉上是否与x或y相似。计算公式为

(5)

3)循环一致性损失。计算公式为

(6)

4)identity损失。identity损失用于保证生成图像的连续性。如果不加该损失,那么生成器可能会自主地修改图像的色调,使得整体的颜色产生变化。计算公式为

(7)

SR-CycleGAN中的总体损失构成如图5所示。

图5 SR-CycleGAN模型的总体损失构成

Fig.5 Total loss of SR-CycleGAN model

2 水下图像增强效果试验

2.1 试验数据和评估指标

水下低分辨图像来自EUVP(http://irvlab. cs.umn.edu/resources/euvp-dataset) 。陆地高分辨图像来自DIV2K(https://data.vision.ee.ethz.ch/cvl/DIV2K/)和Flickr2K(http://cv.snu.ac.kr/research/EDSR/Flickr2K.tar)。试验选择1 500张水下退化图像作为训练集trainA,选择1 500张陆地高清图像作为训练集trainB。测试集由200张退化图像testA和200张高清图像testB组成。

选取水下图像的标准遵循“真实性”原则,水下图像的清晰度在300~700 px,模拟真实的水下图像恢复情景。

对于陆地图像的选取,在对比度、色彩分布和摄影形式等方面有一定的限制。在试验过程中,若引入如太阳、白炽灯和无影灯等作为特征,会导致原本水下图像微小的亮度差别被错误的放大,产生大片白色或红色伪影;森林、水面和沙漠等图像多具有大量纯色元素,难以进行特征选取,导致某个区域进行错误的拟合,也可能导致多种颜色的伪影。另外,特殊摄影模式,包括鱼眼、长曝光、微距和移轴等,在水下使用极少,鱼眼摄影存在的高对比度圆圈,以及长曝光摄影具有的条形高对比度色带,均会对拟合产生影响,本试验中在选取数据集时,对上述情况均进行了排除。

为了与其他模型进行比较,低分辨率输入图像的大小统一调整为80×80×3,高分辨率图像的大小被调整为320×320×3。整个网络在Tensorflow框架中进行编码,并在配有8块显存为16 GB的Tesla V100 T2工作站上实现。本研究中,网络使用Adam优化模型进行训练,分别使用生成器和判别器训练200个epoch。前100个epoch学习率为0.000 2,后100个epoch学习率线性递减为0,其余超参数均为默认值。

为了从不同角度准确地评估这些图像增强模型,本研究中选择3个广泛用于图像增强和恢复问题的标准指标,即均方误差(MSE)、峰值信噪比(PSNR)和结构相似性(SSIM)。其中,MSE是计算像素真实值与预测值之差平方的期望值,MSE值越低,说明图像越相似。PSNR的计算依据的是图像信噪比,PSNR值越高,图像的质量就越高;SSIM是两个给定图像之间相似度的度量指标,SSIM值越高表示视觉效果越好。因此,PSNR、SSIM值越高,MSE值越低,代表图像质量就越好。

2.2 结果与分析

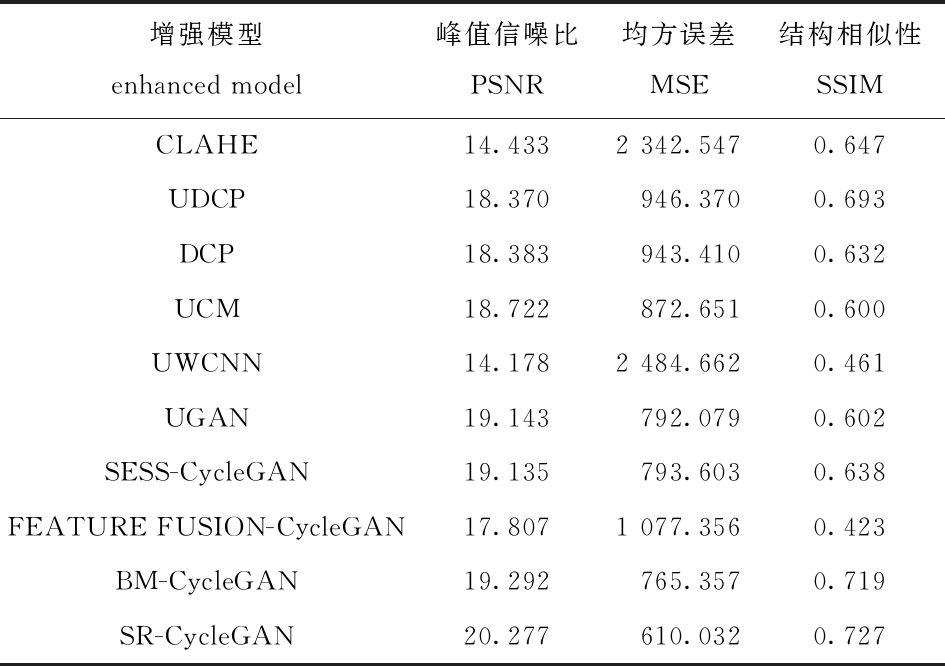

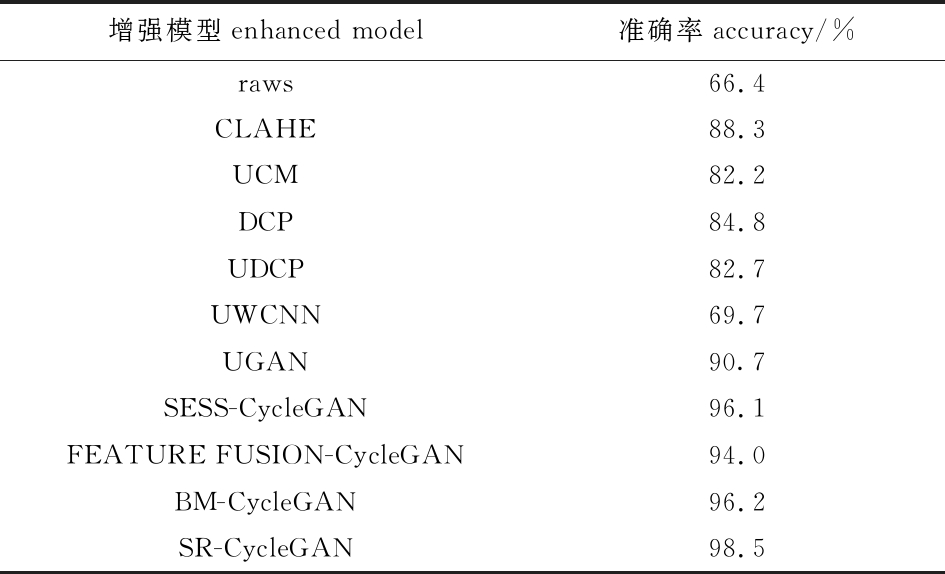

将SR-CycleGAN模型与4种传统的水下图像增强模型CLAHE[18]、UCM[19]、DCP[20]、UDCP[21],以及5种基于深度学习的模型UWCNN[22]、UGAN[4]、SESS-CycleGAN[23]、FEATURE FUSION-CycleGAN[24]、BM-CycleGAN[25]在同一数据集上进行图像增强效果的比较试验,结果显示,SR-CycleGAN模型得到了最高的PSNR值和SSIM值(表1),说明其在图像清晰度上的恢复效果较优。综合以上3个标准指标的评估结果,本研究中所提出的SR-CycleGAN模型具有良好的整体性能。

表1 不同模型的水下图像增强评估指标对比

Tab.1 Comparison of the evaluation indices of underwater image enhancement in different models

增强模型enhanced model峰值信噪比PSNR均方误差MSE结构相似性SSIMCLAHE14.4332 342.5470.647UDCP18.370946.3700.693DCP18.383943.4100.632UCM18.722872.6510.600UWCNN14.1782 484.6620.461UGAN19.143792.0790.602SESS-CycleGAN19.135793.6030.638FEATURE FUSION-CycleGAN17.8071 077.3560.423BM-CycleGAN19.292765.3570.719SR-CycleGAN20.277610.0320.727

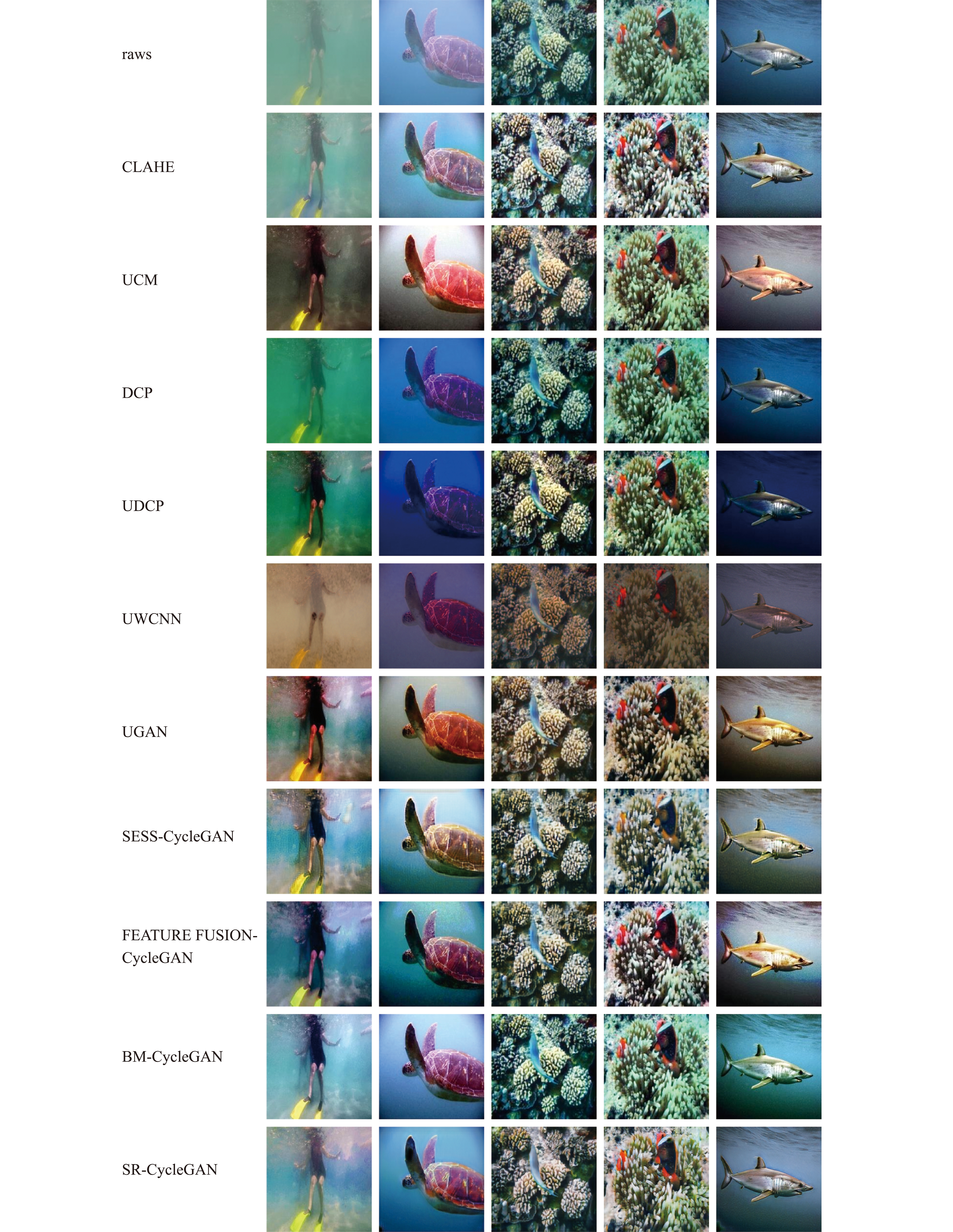

虽然基于传统方法的指标数值与深度学习的数低对比度图像的还原上更加明显,并且含有较多的噪声;UCM模型可以恢复图像的细节,但产生了颜色失真问题,而且在色彩修复方面不太统一,修复时会偏向于增加红色色域占比,导致原本在水下并不偏色的图像修复后更偏向于不真实的红色,过度增强图像的某些区域;DCP模型有一定的去雾效果,但对于蓝色或绿色风格的图像,在色彩修复方面效果欠佳,甚至会出现“逆向优化”的情况,使不该出现的蓝色或者绿色变得更蓝或者更绿;UDCP模型是将DCP模型与波长相关的补偿模型相结合以恢复水下图像,UDCP模型增强了图像的对比度,但是对于本身具有高对比度的图像并不能进行很好的修复,在修复此类图像时,会过度修复高亮区域,导致加剧蓝绿效应和色差的影响,由于其基于DCP模型的特点,也继承了DCP“逆向优化”的属性,甚至使其加剧(图6)。

值相差不大,但它们可视化性能并不令人满意。基于深度学习的模型在数值和可视化性能方面都相对稳定。图6为5个水下场景图像的增强效果。

图6 不同模型的水下图像增强效果对比

Fig.6 Comparison of underwater image enhancement results in different models

对于4种传统的水下图像增强模型分析显示:CLAHE模型在模糊的图像上表现出去雾效果,但同时产生了颜色失真和明显的色彩丢失问题,这在对于5种基于深度学习的模型分析显示:UWCNN模型的图像增强效果不明显,会错误地纠正水下的颜色,使色温高于正常的5 000 K,达到不正确的7 000 K,且观察到额外的噪声和失真,甚至在水质浑浊时,出现了曝光不够的情况,丢失了图像重要的信息;UGAN模型可以增强图像的对比度,且恢复后色温稍高于正常色温,增加了暗物体识别的难度;SESS-CycleGAN模型对于绿色背景图像恢复良好,但是对于蓝色背景图像恢复欠佳,存在红绿通道恢复过度的问题,另外也会出现有伪影的情况;FEATURE FUSION-CycleGAN模型的基本用途是恢复浑浊水体的图像,没有进行水下图像的颜色校正,甚至出现了颜色反向校正和色彩细节丢失的情况;BM-CycleGAN模型恢复后并未解决CycleGAN恢复时图像质量降低的通病,图像细节存在一定程度的丢失(图6)。

本研究中提出的SR-CycleGAN模型较好地恢复了图像颜色和细节,恢复后的图像颜色更加真实。对于大多数场景都能得到良好颜色校正结果,增强后的图像效果更符合人类的视觉感知。

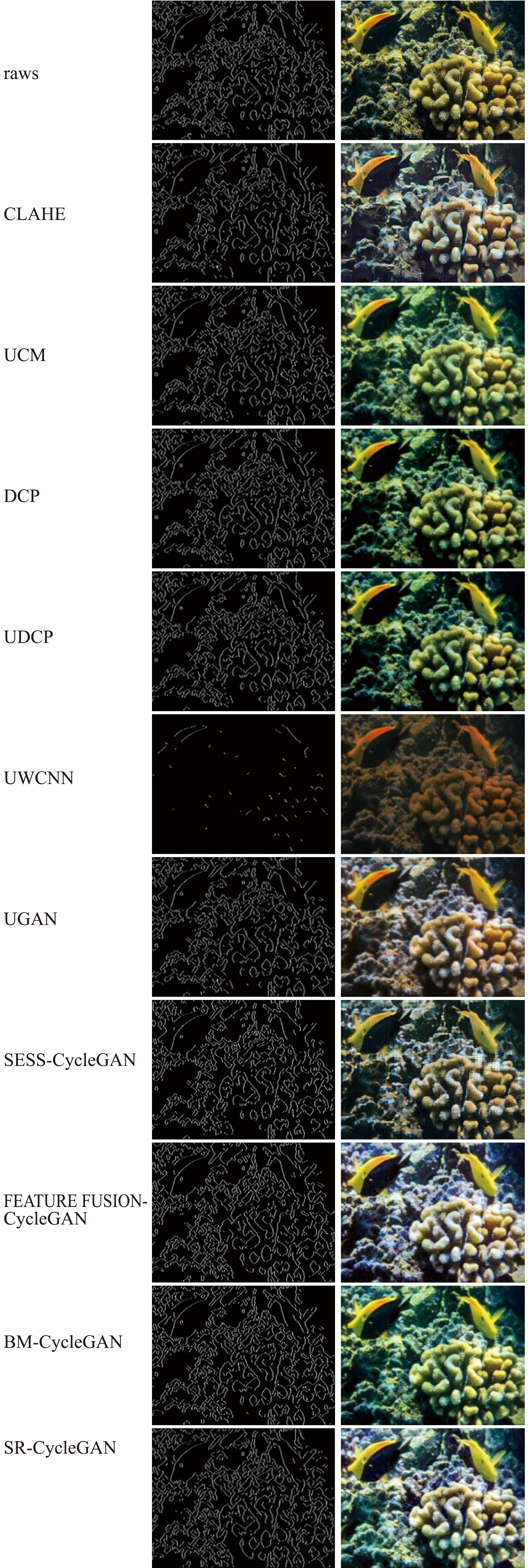

2.3 边缘检测

为了进一步验证SR-CycleGAN模型在图像细节和清晰度方面的性能,本研究中使用Canny边缘检测继续对图像进行分析。从图7可见,SR-CycleGAN增强后的图像呈现出更多的关键匹配点和更多的边缘检测特征,且噪声更少,在图像空间中更接近于原始图像。说明SR-CycleGAN在图像细节和清晰度方面也具有良好的表现。

图7 Canny边缘检测结果对比

Fig.7 Comparison of Canny edge detection results

2.4 海洋生物的识别检测

水下图像增强能够有效地提高海洋生物识别的准确率,为进一步检验本研究中模型在实际海洋生物识别中的实用性,将增强后的图像输入已训练好的海洋生物分类模型,通过比较海洋生物识别的准确率,验证本模型的性能。

在已有数据集中考虑形状、颜色的因素选取了7类海洋生物,分别为鲽、小丑鱼、鲟、镰鱼、鲨鱼、海豚和海龟。每种生物图片300余张,共计2 500余张图片,并通过程序对图像进行了标注。使用卷积神经网络模型对试验的数据集进行训练,以准确率作为图像分类试验的评价指标,使用前文提到的不同方法对增强后的图像进行测试。试验结果如表2所示。

增强后图像的识别准确率均有一定的提高,但经过SR-CycleGAN模型增强后的图像识别准确率最高,由原图(raws)的66.4%提高到98.5%(表2)。增强后的图像能准确识别出更多的目标,说明本研究中提出的SR-CycleGAN模型能够有效地对水下图像进行色彩校正和清晰度增强,进而提升海洋生物识别的准确率,证明了本方法在海洋生物水下图像识别中具有一定的实用价值。

表2 不同增强模型的海洋生物识别准确率比较

Tab.2 Comparison of the accuracy of marine biometrics in different enhanced models

增强模型enhanced model准确率accuracy/%raws66.4CLAHE88.3UCM82.2DCP84.8UDCP82.7UWCNN69.7UGAN90.7SESS-CycleGAN96.1FEATURE FUSION-CycleGAN94.0BM-CycleGAN96.2SR-CycleGAN98.5

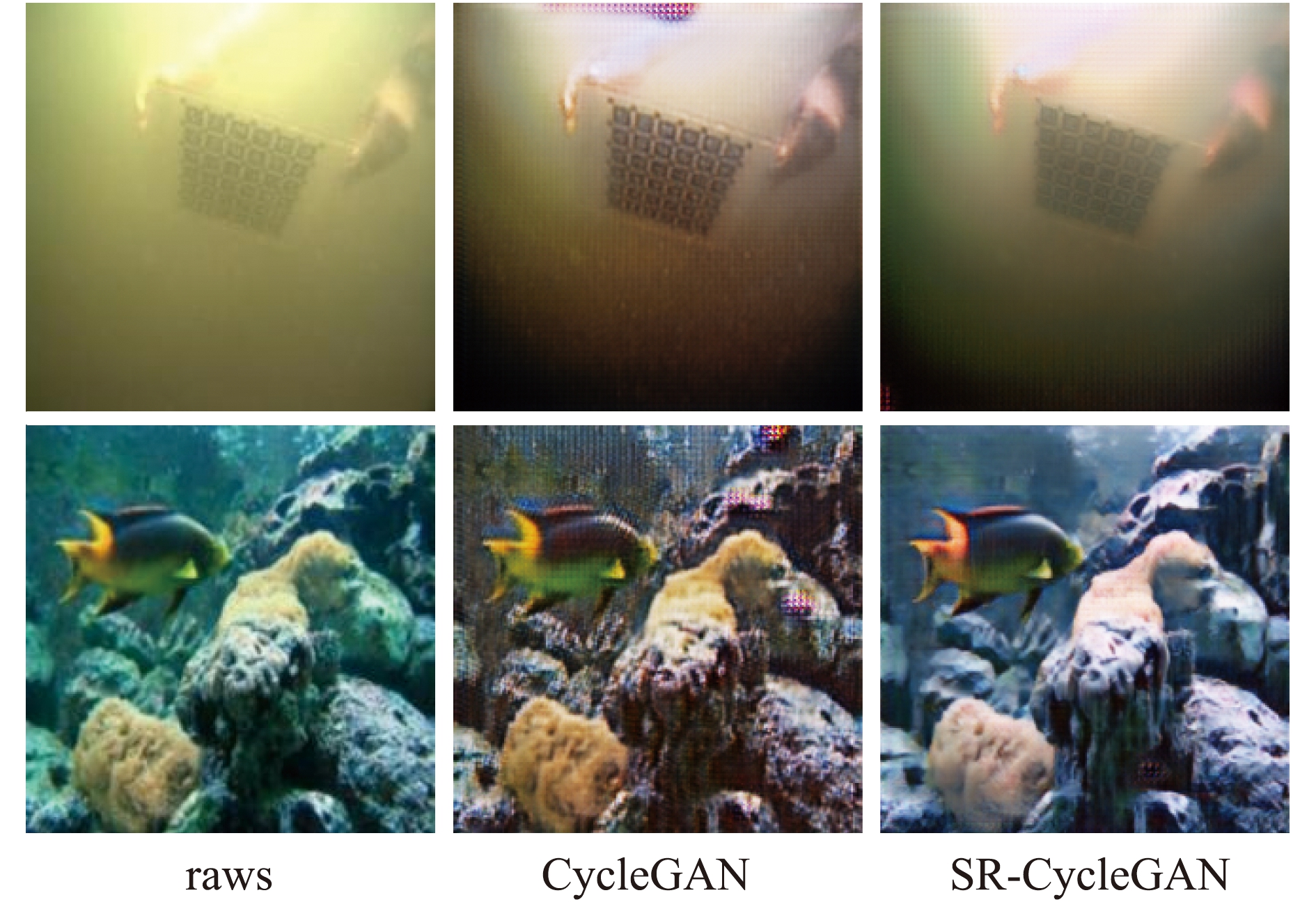

2.5 与CycleGAN模型的图像增强效果对比

由于本研究中提出的SR-CycleGAN模型是在CycleGAN模型的基础上进行优化改进的,故与CycleGAN模型单独进行图像增强效果对比试验。使用CycleGAN模型进行训练时,直接使用低分辨率水下图像进行训练,输出图像如图8所示,有显著的噪声,边界不清,曝光过度,丢失了图像的原始信息,并有明显的红色伪影和棋盘格,破坏了图像的结构信息。

图8 经CycleGAN增强的图像

Fig.8 CycleGAN enhanced image

为了解决红色伪影和棋盘格出现的问题,本研究中采用了避免棋盘格出现的Resize-Convolution上采样方法,在提升图像分辨率的同时,尽量减少棋盘格的出现。增加了内容损失函数,防止模型出现错误的拟合及颜色过度校正,减少红色伪影的出现。从图9可见,SR-CycleGAN优化后虽然仍存在一些网格,但是情况已有较大改善,红色伪影也几乎不再出现。

图9 SR-CycleGAN与CycleGAN的图像增强效果对比

Fig.9 Comparison of image enhancement effects between SR-CycleGAN and CycleGAN models

3 讨论

3.1 非监督模型构建与优化

基于深度学习的图像增强方法通常需要大量的成对数据来训练模型,但在水下环境中很难获得每幅退化图像对相应的清晰图像。针对难以收集水下同一场景不同分辨率图像的问题,本研究中提出了一种非监督的水下图像增强模型SR-CycleGAN。该模型采用超分辨网络和退化网络学习水下图像和陆地图像间的跨域映射函数。只需提供不同分辨率的真实图像以实现水下图像增强,无需使用成对的图像进行网络训练。生成器的超分辨网络以SRResNet为基础进行优化,删除了批处理规范化层,使用缩放卷积进行上采样,在抑制棋盘状伪影产生的情况下,对图像进行超分辨重构;退化网络用深度线性网络通过两次下采样操作缩小图像,模拟了图像的退化过程;判别器使用相对平均判别器提升图像的相对真实性,从而恢复更多的纹理细节;增加了内容损失,保留源图像的细节信息不变,同时校正图像颜色,提高生成图像的视觉质量。

3.2 模型效果分析

在定量比较中,将SR-CycleGAN模型与4种传统的水下图像增强模型和5种基于深度学习的模型,在同一数据集上进行图像增强结果的比较。SR-CycleGAN模型得到了最高的PSNR值(20.277)和SSIM值(0.727),与李庆忠等[23]提出的SESS-CycleGAN模型相比分别提高了5.9%、13.9%,与刘朝等[24]提出的FEATURE FUSION-CycleGAN模型相比分别提高了13.8%、71.8%,与李宝奇等[25]提出的BM-CycleGAN模型相比分别提高了5.1%、1.1%,说明SR-CycleGAN模型在图像清晰度上的恢复效果较优,增强后的图像噪声较少。在定性分析中,对于大多数场景都能得到良好的颜色校正结果,经过SR-CycleGAN模型增强后的图像效果更符合人类的视觉感知。经过SR-CycleGAN增强后图像的识别准确率方面有一定的提高,由原图(raws)的66.4%提高到98.5%,与李庆忠等[23]提出的SESS-CycleGAN模型相比提高了2.4%,与刘朝等[24]提出的FEATURE FUSION-CycleGAN模型相比提高了5.1%,与李宝奇等[25]提出的BM-CycleGAN模型相比提高了2.3%,增强后的图像能准确识别出更多目标,说明本研究中提出的SR-CycleGAN模型能够有效地对水下图像进行色彩校正和清晰度增强,从而提升海洋生物识别的准确率。

4 结论

1)针对水下同一场景不同分辨率图像难以收集的问题,本研究中提出的SR-CycleGAN模型只需提供不同分辨率的真实图像,即可实现水下图像增强,无需使用成对的图像进行网络训练。

2)将超分辨重构的思想加入到CycleGAN中,对网络进行优化改进,有效地将水下图像超分辨重构为清晰图像,同时进行颜色校正。

3)经过SR-CycleGAN模型增强后的图像能准确识别出更多的目标,证明了本方法在海洋生物水下图像识别中具有一定的实用价值。

未来的工作将在适应性方面做进一步研究,基于公开数据集(UIEB、SUID和UFO120)和非公开数据集(大连海洋大学水下机器人采集)进行测试分析,通过对比更多水中不同场景下SR-CycleGAN模型的图像增强效果,进一步改善网络的性能。

[1] ANWAR S,LI C Y.Diving deeper into underwater image enhancement:a survey[J].Signal Processing:Image Communication,2020,89:115978.

[2] LI J,SKINNER K A,EUSTICE R M,et al.WaterGAN:unsupervised generative network to enable real-time color correction of monocular underwater images[J].IEEE Robotics and Automation Letters,2018,3(1):387-394.

[3] LI C Y,ANWAR S,PORIKLI F.Underwater scene prior inspired deep underwater image and video enhancement[J].Pattern Recognition,2020,98:107038.

[4] LI C Y,GUO J C,GUO C L.Emerging from water:underwater image color correction based on weakly supervised color transfer[J].IEEE Signal Processing Letters,2018,25(3):323-327.

[5] LU J Y,LI N,ZHANG S Y,et al.Multi-scale adversarial network for underwater image restoration[J].Optics & Laser Technology,2019,110:105-113.

[6] FABBRI C,ISLAM M J,SATTAR J.Enhancing underwater imagery using generative adversarial networks[EB/OL].arXiv:1801.04011v1,2018.https://doi.org/10.48550/arXiv.1801.04011.

[7] YE X C,XU H C,JI X,et al.Underwater image enhancement using stacked generative adversarial networks[C]//Pacific rim conference on multimedia.Berlin:Springer,2018:514-524.

[8] DU R,LI W W,CHEN S D,et al.Unpaired underwater image enhancement based on CycleGAN[J].Information,2021,13(1):1.

[9] ZONG X H,CHEN Z H,WANG D D.Local-CycleGAN:a general end-to-end network for visual enhancement in complex deep-water environment[J].Applied Intelligence,2021,51(4):1947-1958.

[10] LEDIG C,THEIS L,HUSZ R F,et al.Photo-realistic single image super-resolution using a generative adversarial network[C]//Proceedings of the IEEE conference on computer vision and pattern recognition.Honolulu:IEEE,2017:105-114.

R F,et al.Photo-realistic single image super-resolution using a generative adversarial network[C]//Proceedings of the IEEE conference on computer vision and pattern recognition.Honolulu:IEEE,2017:105-114.

[11] 米恒,贾振堂.基于改进生成式对抗网络的图像超分辨率重建[J].计算机应用与软件,2020,37(9):139-145.

MI H,JIA Z T.Image super resolution reconstruction based on improved generative adversarial network[J].Computer Applications and Software,2020,37(9):139-145.(in Chinese)

[12] ZHU J Y,PARK T,ISOLA P,et al.Unpaired image-to-image translation using cycle-consistent adversarial networks[C]//Proceedings of the IEEE international conference on computer vision.Italy:IEEE,2017:2242-2251.

[13] ODENA A,DUMOULIN V,OLAH C.Deconvolution and checkerboard artifacts[J].Distill,2016,1(10).DOI:10.23915/distill.00003.

[14] 高媛,刘志,秦品乐,等.基于深度残差生成对抗网络的医学影像超分辨率算法[J].计算机应用,2018,38(9):2689-2695.

GAO Y,LIU Z,QIN P L,et al.Medical image super-resolution algorithm based on deep residual generative adversarial network[J].Journal of Computer Applications,2018,38(9):2689-2695.(in Chinese)

[15] ZHANG K,LIANG J Y,VAN GOOL L,et al.Designing a practical degradation model for deep blind image super-resolution[C]//Proceedings of the IEEE/CVF international conference on computer visio.Canada:IEEE,2021:4771-4780.

[16] YAMAC M,ATAMAN B,NAWAZ A.KernelNet:a blind super-resolution kernel estimation network[C]//Proceedings of the IEEE/CVF conference on computer vision and pattern recognition.Singapore:IEEE,2021:453-462.

[17] WANG X,YU K,WU S,et al Esrgan:enhanced super-resolution generative adversarial networks[C]//Proceedings of the European conference on computer vision (ECCV) workshops.Berlin:Springer,2018: 63-79.

[18] ZUIDERVELD K.Contrast limited adaptive histogram equalization[M]//Graphics gems.Amsterdam:Elsevier,1994:474-485.

[19] IQBAL K,ODETAYO M,JAMES A,et al.Enhancing the low quality images using Unsupervised Colour Correction Method[C]//2010 IEEE international conference on systems,man and cybernetics.Istanbul:IEEE,2010:1703-1709.

[20] HE K M,SUN J,TANG X O.Single image haze removal using Dark Channel Prior[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2011,33(12):2341-2353.

[21] DREWS JR P,DO NASCIMENTO E,MORAES F,et al.Transmission estimation in underwater single images[C]//Proceedings of the IEEE international conference on computer vision workshops.Canada:IEEE,2013:825-830.

[22] ANWAR S,LI C Y,PORIKLI F.Deep underwater image enhancement[EB/OL].arXiv preprint arXiv:1807.03528,2018.https://arxiv.org/pdf/1807.03528.pdf.

[23] 李庆忠,白文秀,牛炯.基于改进CycleGAN的水下图像颜色校正与增强[J/OL].自动化学报,2020.https://kns.cnki.net/kcms/detail/11.2109.TP.20201204.1149.001.html.

LI Q Z,BAI W X,NIU J.Underwater image color correction and enhancement based on improved cycle-consistent generative adversarial networks[J/OL].Acta Automatica Sinica,2020.https://kns.cnki.net/kcms/detail/11.2109.TP.20201204.1149.001.html.(in Chinese)

[24] 刘朝,王红茹.一种改进CycleGAN的水下彩色图像增强方法[J/OL].机械科学与技术,2022.https://doi.org/10.13433/j.cnki.1003-8728.20220162.

LIU C,WANG H R.An underwater image enhancement method of the improved CycleGAN[J/OL].Mechanical Science and Technology for Aerospace Engineering,2022.https://doi.org/10.13433/j.cnki.1003-8728.20220162.(in Chinese)

[25] 李宝奇,黄海宁,刘纪元,等.基于改进CycleGAN的浑浊水体图像增强算法研究[J].电子与信息学报,2022,44(7):2504-2511.

LI B Q,HUANG H N,LIU J Y,et al.Turbid water image enhancement algorithm based on improved CycleGAN[J].Journal of Electronics & Information Technology,2022,44(7):2504-2511.(in Chinese)